「つくるひとをつくる」AICUマガジンVol.11特集「はじめて学ぶComfyUI」がリリースされました!

📖Kindle Unlimitedで期間限定無料! https://j.aicu.ai/MagV11

美麗な ペーパーバック版 と 直販版、note版 も同時発売です!

特集「AI 映像新時代! はじめて学ぶComfyUI」

「つくる人をつくる」あなたをアップデートするクリエイティブAIエンターテイメントマガジン「AICU マガジン Vol.11」、特集は「はじめて学ぶComfyUI」です。

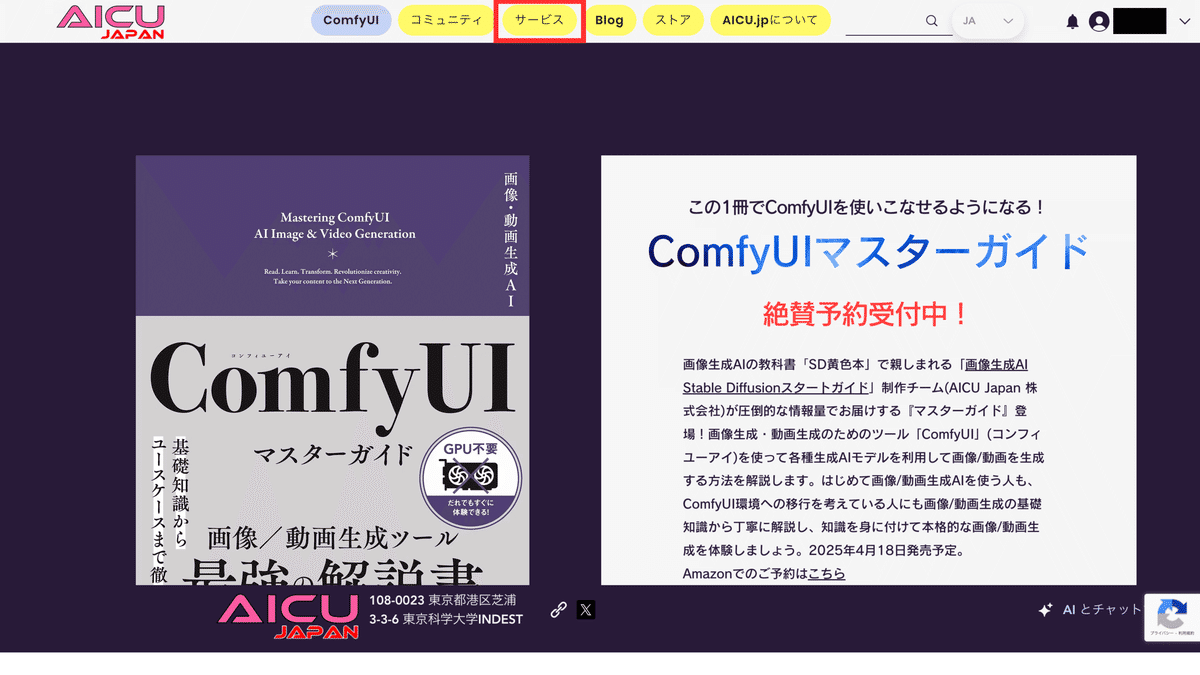

まもなく5月に「画像生成 AI ComfyUI マスターガイド」(SB クリエイティブ刊)がリリース予定です!

この書籍は、世界の画像生成 AI のスタンダードになりつつある「ComfyUI」の基本的な使い方をゼロから本格的に学べるガイドです。2022 年 8 月に世界 に公開された「Stable Diffusion」は、誰でも無償でダウンロードして自分のコンピューター 環境で利用できるため、世界中でムーブメントを巻き起こしました。ChatGPT の画像生成機能、X の Grok, Google の Gemini といった無料で利用できる画像生成サービスがネットを賑わしています。

しかし、安定して再現性がある画像生成、画像生成のみならず動画生成、商用利用、業務活用を考えている人にとっては、ワンショットで気軽に生成できる画像生成が有名になったものの、この複雑になった画像生成 AI の内部や全体像を学んだり、整理された情報にアクセスすることが難しくなったとも言えます。

そこで、今月号では、AICU の前作「画像生成 AI Stable Diffusion スタートガイド」で中心的に紹介した「AUTOMATIC1111」以降のアップデートを集約。これから ComfyUI について勉強したい人に向けて、マスターガイドのさらに導入となる「共有 ComfyUI」基礎の基礎をお届けします!

AIで動画や画像を生成したいけどどうすれば?他の生成AIとComfyUIは何が違う?導入するには?使い方は?そんな疑問をお持ちの方でも、これを読めば今からでもComfyUIで生成AIを始められます!

★アイキューマガジン読者限定!オリジナル漫画や、共有ComfyUIを無償で利用できるプロモコードを含む、計5,700円相当のオトクなおまけがついてきます!!

「AI イベレポ!」は、AI 映像の未来を開拓! OpenAI Sora による SoraJam Tokyo の模様を 写真たっぷりにお伝えします。「サクリ! AI ツール」は、株式会社 Ememe が開発する 3D チャット AI 投稿プラットフォー ム『EmemeAI』の新機能「AI キャラクターハブ」を紹介します。

【INDEX】【完全初心者のための共有 ComfyUI 入門】AI 画像を 1 枚生成してみよう!/画像生成 AI の基礎知識: ComfyUI を学ぶ前に知っておきたいこと/登録して使ってみよう! 共有 ComfyUI の基本/告知:AICU media 編集部がおくる “画像生成 AI の教科書” に新作「ComfyUI 紫本」/ここから始める動画編! SDXL + AnimateDiff でテキストから動画を生成しよう!/SDXL + AnimateDiff + IPAdapter で参照画像から動画を生成しよう! /【AI イベレポ!】SoraJam Tokyo 開催! 世界の AI 動画クリエイター熱狂の 4 時間/【サクリ!AI ツール】キャラクター AI に新風!「EmemeTown」をリリース/2025 年 3 月「桜の下で約束を」コンテスト結果発表!/連載漫画「YOUKAI」(4) by 殻尾 (からび-) + AICU/ [はるしね~しょん] 編集部だより/Cover Art by ジュニ

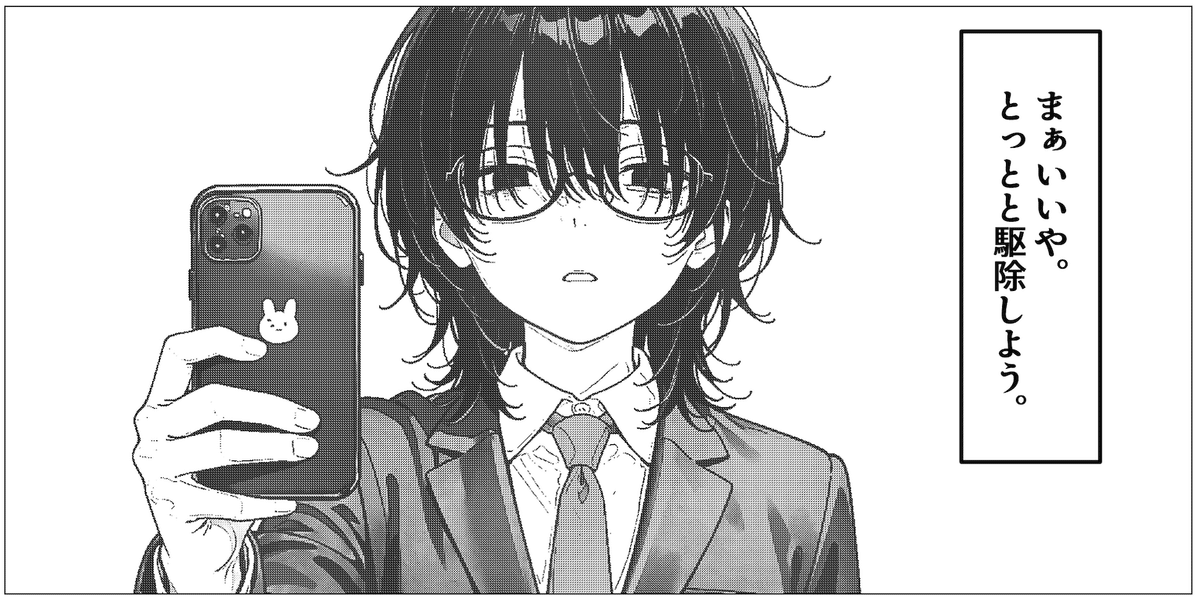

連載漫画

▶「YOUKAI」殻尾+AICU

第4話ではハルシネーション編に突入!クロブチの過去とは……

第1話はこちらから!漫画単体の販売も開始しております!

https://corp.aicu.ai/ja/youkai-20250117

そのほか、この数ヶ月のクリエイティブAIの分野を一気読み!

【AIイベレポ!】

OpenAI Soraが動画生成のハッカソンイベント「SoraJam Tokyo」を2025年3月25日に渋谷で開催!その模様をAICU編集部・しらいはかせが現地突撃速報フォトレポートでお送りいたします。

【サクリ!AIツール】

アイキューマガジン Vol.9 「AIキャラクター新世紀」で紹介した株式会社Ememeが開発する3DチャットAI投稿プラットフォーム『EmemeAI』が新機能「AIキャラクターハブ」をリリース!AICU編集部独自の視点でご紹介します。

📖Kindle Unlimitedで無料!https://j.aicu.ai/MagV11

🏠️直販ストアはこちらから http://j.aicu.ai/MagV11s

「AICU Magazine」バックナンバーのご紹介

https://corp.aicu.ai/ja/products

ご寄稿者の皆様、ご執筆ご協力、ありがとうございます!

ペーパーバック版・Kindle版・直販ストア版・note版の同時発売!

AICU編集部のおすすめはペーパーバック版ですが

それぞれのエディションで中身は異なります!

賞味期限も異なりますので

お好みでベストなメディアを入手してください。

ペーパーバック版

紙の書籍として手にとって、他の読者さんと共有したり参考文献として引用できるメディアです。

https://j.aicu.ai/MagV11

ISBN-13:9798280257078

Kindle Unlimited版(ePub形式)

Kindle Unlimited加入者は無料で購読可能です。

情報の新鮮さとePubならではの読みやすさを優先しています。

発売から1ヶ月以降は配信方針が変更される可能性がございます。

直販ストアPDF版

ダウンロードして何度でも閲覧することができるファイルへのリンクを、AICU.jpショップにてライセンス販売しております。

https://www.aicu.jp/category/all-products

ペーパーバック版と同じ、レイアウト品質の高いPDFになります。

複数人での閲覧、公衆送信等はご相談ください。

note版

速くて手軽!見やすいnote版は以下のペイウォール以降にnoteブログ形式で提供となります。

月刊「アイキューマガジン」note版にご登録いただくと、バックナンバーも含めてnote版もお読みいただけます。note版には限定PDF版へのリンクも含まれるのでオトクです!

特集「はじめて学ぶComfyUI」

「つくる人をつくる」あなたをアップデートするアイキューマガジンVol.11、特集は「はじめて学ぶComfyUI」です。

まもなく5月にAICU編集部から「画像生成AI ComfyUI マスターガイド」(SBクリエイティブ刊)がリリースされます。この書籍は、世界の画像生成AIのスタンダードになりつつある「ComfyUI」の基本的な使い方をゼロから本格的に学べるガイドです。2022年8月に世界に公開された「Stable Diffusion」は、誰でも無償でダウンロードして自分のコンピューター環境で利用できるため、世界中でムーブメントを巻き起こしました。ChatGPTの画像生成機能、XのGrok, GoogleのGeminiといった無料で利用できる画像生成サービスがネットを賑わす一方で、安定して再現性がある画像生成、画像生成のみならず動画生成、商用利用、業務活用を考えている人にとっては、ワンショットで気軽に生成できる画像生成が有名になった一方で、この複雑になった画像生成AIの内部や全体像を学んだり、整理された情報にアクセスすることが難しくなったとも言えます。

今月号では、AICUの前作「画像生成AI Stable Diffusionスタートガイド」で中心的に紹介した「AUTOMATIC1111」以降のアップデートを集約し、これからComfyUIについて勉強したい人に向けて、マスターガイドのさらに導入となる「共有ComfyUI」基礎の基礎をお届けします!

(巻末には無償で利用できるプロモコードもお送りします!)

AIイベレポは、AI映像の未来を開拓! OpenAI SoraによるSoraJam Tokyoの模様を写真たっぷりにお伝えします。

「サクリ!AIツール」は、株式会社Ememe が開発する3DチャットAI投稿プラットフォーム『EmemeAI』の新機能「AIキャラクターハブ」を紹介します。

カバーアート:ジュニ(@jAlpha_create)

ご感想はぜひ X@AICUai(https://x.com/aicuai)へのメンションや、フィードバックフォーム(https://j.aicu.ai/MagQ)からいただけましたら幸いです。

公式ハッシュタグは #AICU でお願いいたします。

【完全初心者のための共有ComfyUI入門】AI画像を1枚生成してみよう!

こんにちは、[martina.](https://x.com/martina1_111)です。普段はメタバース・3DCG関連のお仕事をしているAICUコラボクリエイターです!

本記事では、これからComfyUIを触ってみたい超初心者の方に向けて、クラウド上で使える「共有ComfyUI」を無料でお試しして、AI画像を1枚出力するまでの手順を丁寧に解説します。難しい専門用語はできるだけ噛み砕き、ステップ・バイ・ステップで進めていきますのでご安心ください。実際に手を動かしながら読み進めて、AI画像生成の第一歩を踏み出しましょう!

1. 共有ComfyUIとは?クラウドで使うメリット

まずは「共有ComfyUI」について改めて簡単に紹介します。

そもそもComfyUIとは、Stable Diffusionなどの画像生成AIモデルをノードと呼ばれるブロックを繋いで操作できるオープンソースのツールです。高度な画像生成ワークフローを視覚的に組み立てることができ、コード不要で柔軟な画像生成が可能です。

ただし、通常ComfyUIを使うには自分のPCに環境を構築し、大きなAIモデルを扱うための高性能GPUも必要になります。初心者にとってこれらの準備はハードルが高いですよね><

そこで登場するのが「共有ComfyUI」です!

共有ComfyUIは、AICU Japan株式会社が提供するクラウド上のComfyUI環境で、インターネット経由で手軽にComfyUIを利用できます。

主なメリットは、

-

インストール不要&高性能GPU不要:ブラウザからアクセスするだけでOK。自分のPCにソフトをインストールしたり、大きなモデルデータを準備したりする必要がありません。手元のPCやタブレット・スマホからでも利用でき、GPUの性能はクラウド側で賄われます。

-

すぐに使える:わずらわしい環境構築なしに、ComfyUIの機能をすぐ体験できます。難しい設定を飛ばして「触ってみたい!」をすぐ実現できます。

-

高速な生成:共有ComfyUIでは高性能なクラウドGPUが割り当てられています。自宅PCでは数十秒〜数分かかる処理も、クラウドならサクサクです!

-

最新モデルやノードが利用可能:サービス側であらかじめ人気の画像生成モデル(チェックポイント)や追加機能(カスタムノード)がインストールされています。初心者が一からモデルを探して入れる必要がなく、最初から色々試せる環境が整っています。

-

みんなで使っているので教えあえる: 分からないことがあればコミュニティで聞くことができます。共有ComfyUIの利用者はAICUの有料記事に自由にアクセスできますし、過去記事を学んだチャットボット「Will」がディープな記事を紹介してくれます。流行りのモデルに出会うことも一人で使うよりも早くアクセスできますね。

共有ComfyUIの利用開始(登録)の概要

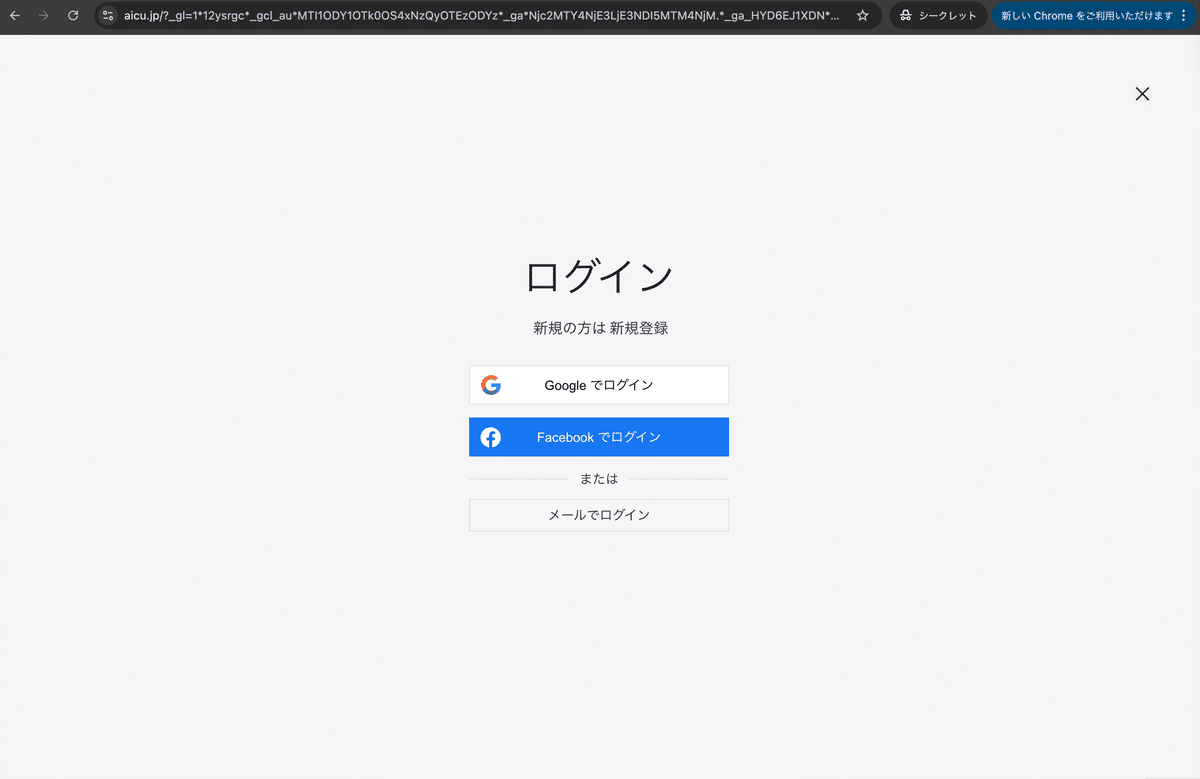

共有ComfyUIを使うには、まず提供サイトでユーザー登録(ログイン)が必要です。

といっても難しい手続きはなく、メールアドレスさえあればすぐに始められます!

①公式サイトにアクセス:ブラウザで共有ComfyUIのサイトにアクセスします。

②メールアドレスでログイン/登録:初めて利用する場合はメールアドレスを入力すると、そのアドレス宛に確認コード(ワンタイムパスワード)が届きます。そのコードをサイト上で入力すればログイン完了です。

③ComfyUIを起動:ログイン後、「サービス」タブから、1番右の「共有ComfyUI」の「無料お試し期間を始める」をクリックします。

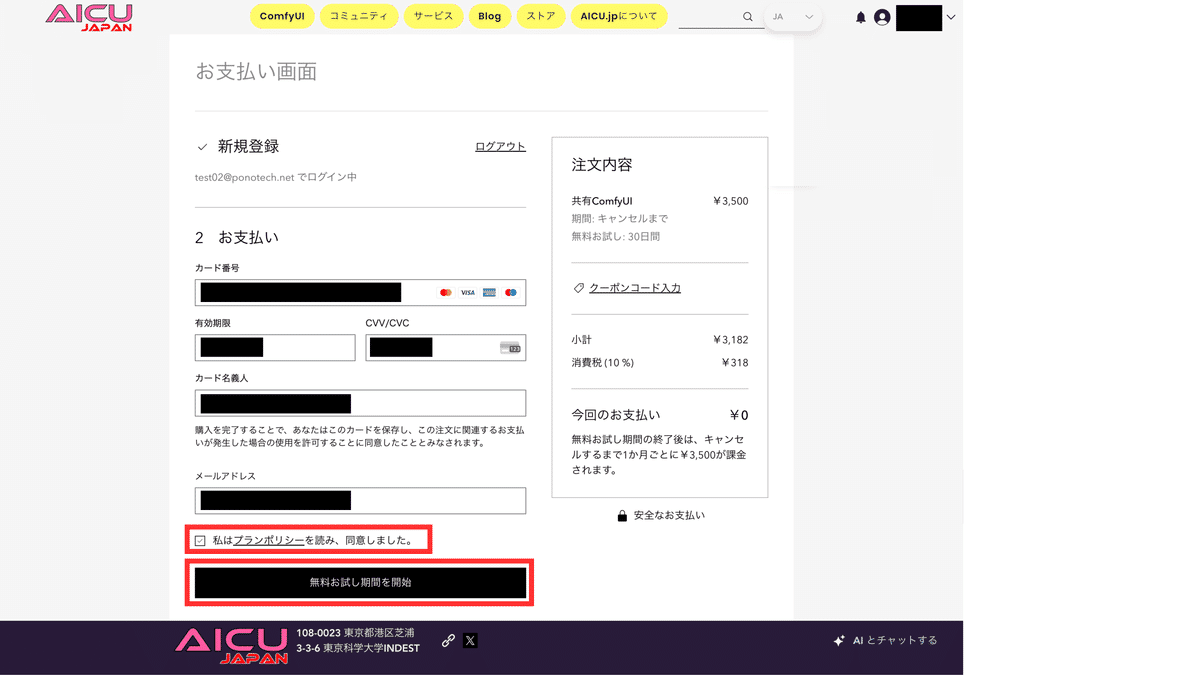

続いてお支払い画面が表示されるので、クレジットカード情報の入力、プランポリシーへの同意を行い、「無料お試し期間を開始」をクリックしてください。

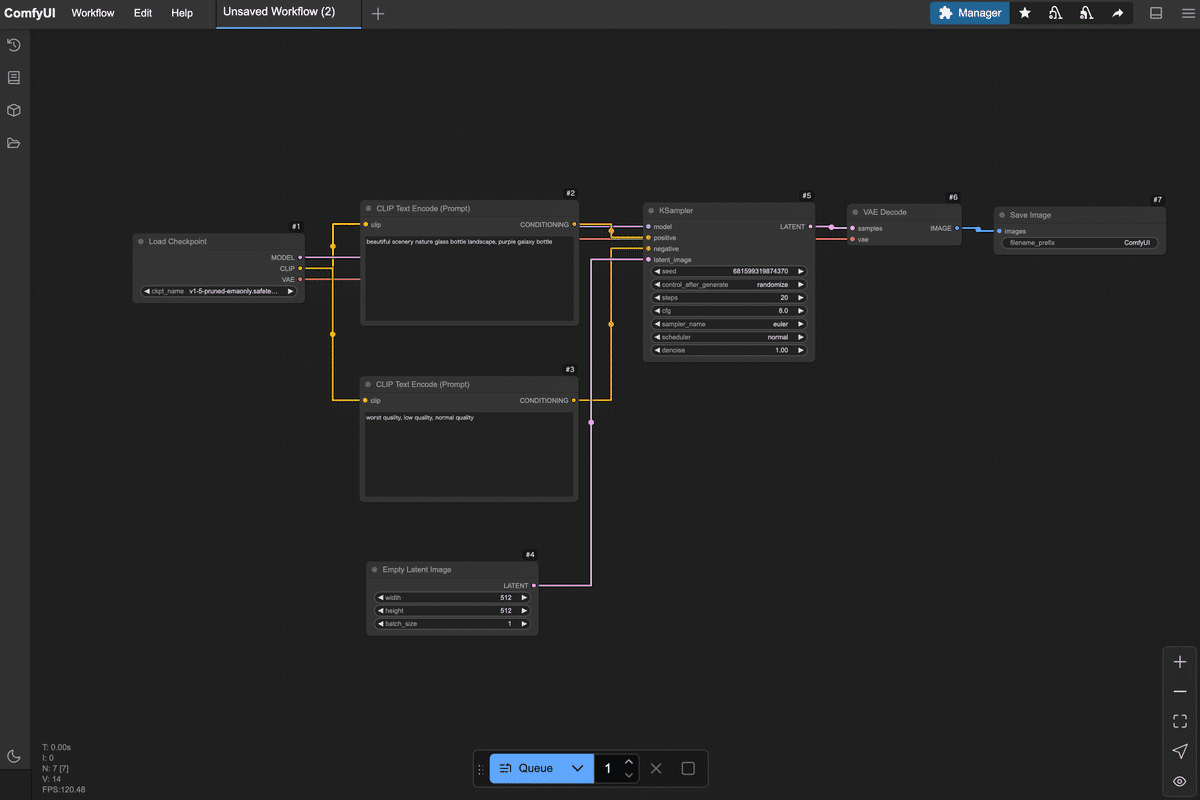

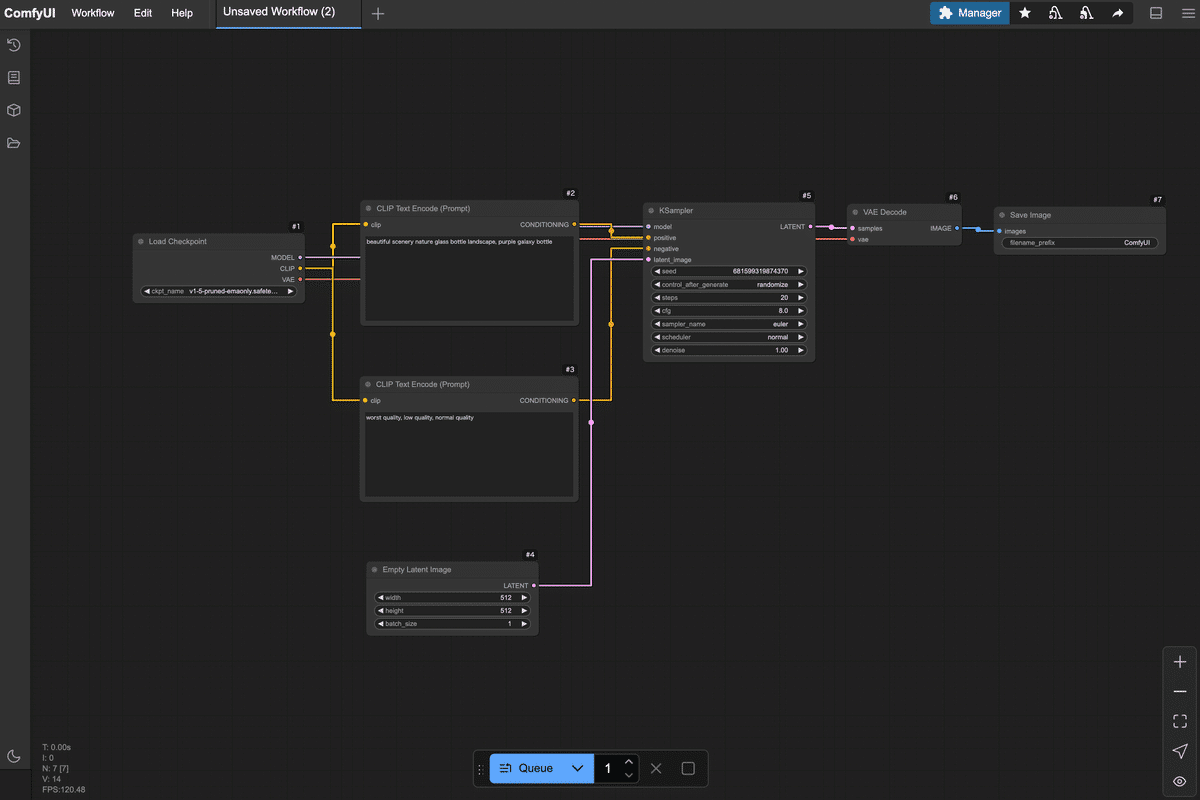

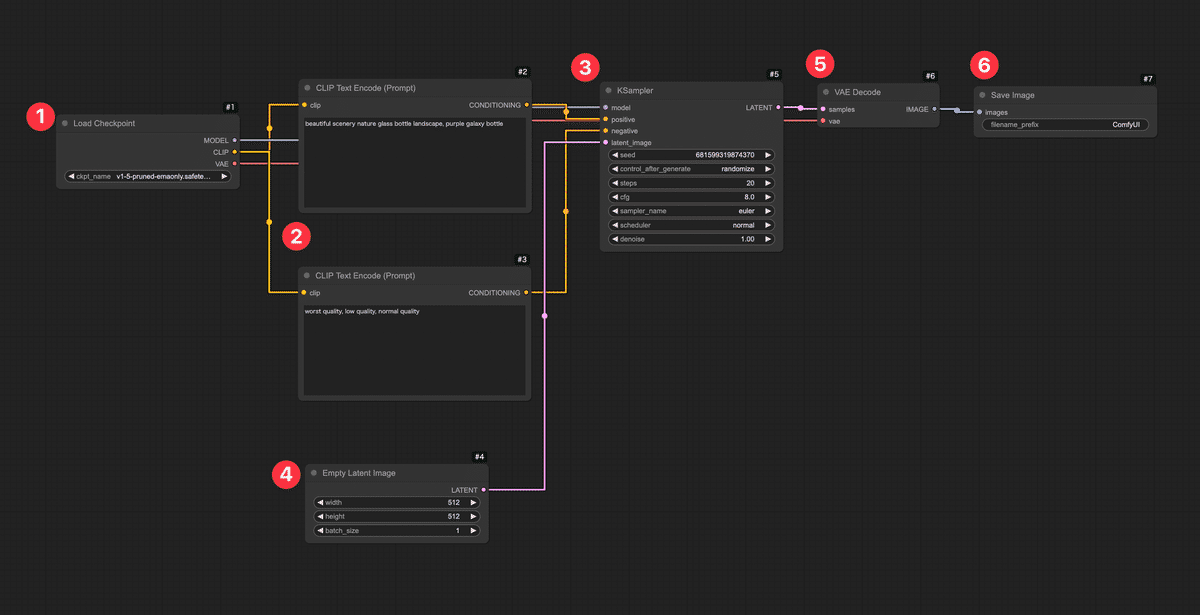

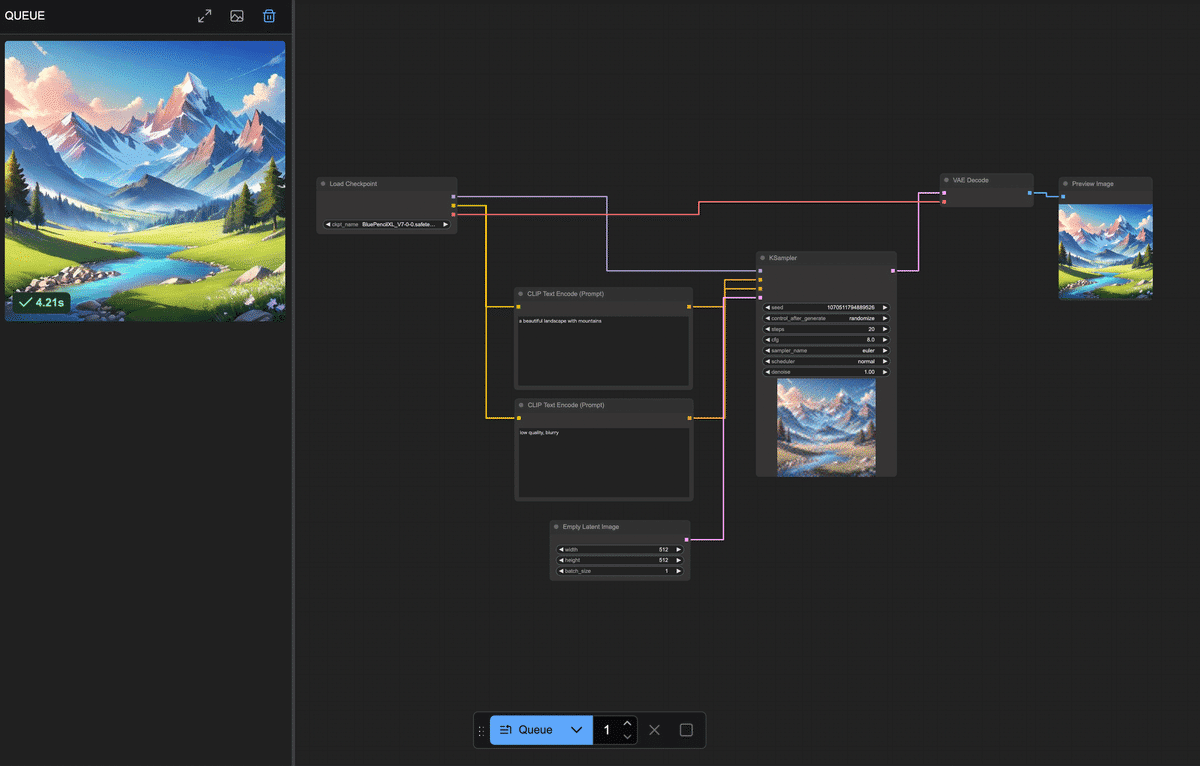

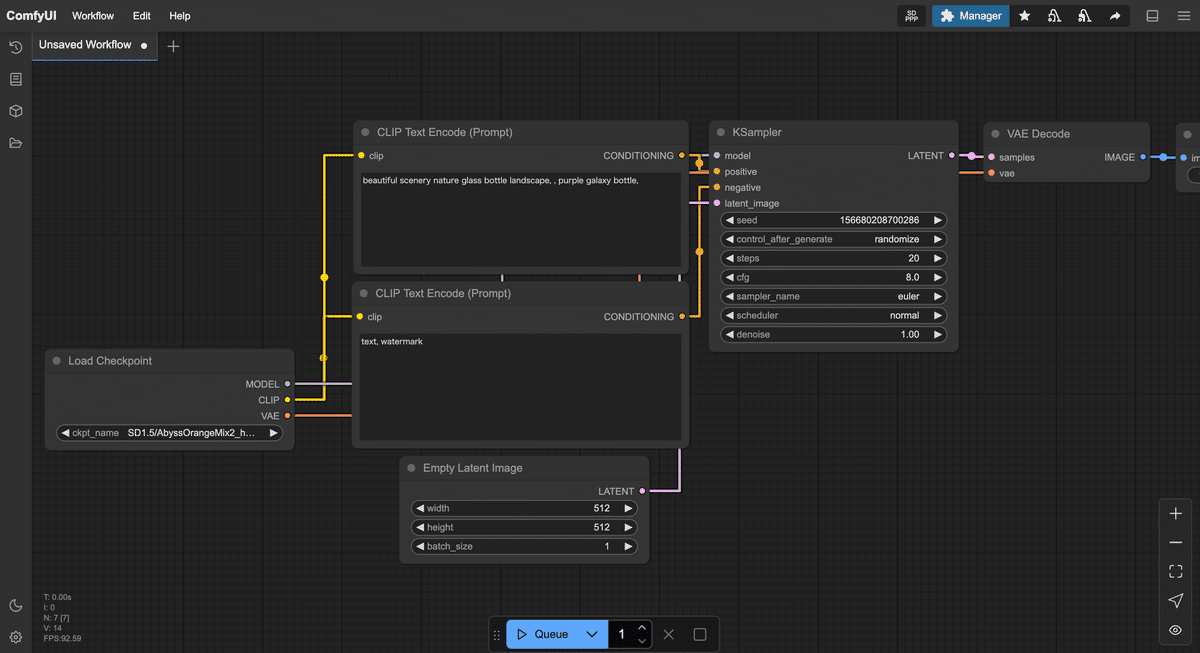

2. ComfyUIの画面構成を知ろう

ログインが完了すると、ブラウザ上にComfyUIの操作画面が現れます。

初めて見る画面は少し独特かもしれませんが、各部分の役割を押さえれば怖くありません。

ここではComfyUIの画面構成と主要な要素(ノード、キャンバス、出力エリアなど)を説明します。

-

キャンバス(ノードエディタ):画面の大部分を占める黒地の領域が「キャンバス」です。ここにノードと呼ばれるブロックを配置し、線で繋いでいくことで画像生成の処理手順(ワークフロー)を組み立てます。キャンバス上はドラッグで移動・右クリックで操作メニュー表示ができます。

-

ノード(部品):キャンバス上に配置する四角いブロックがノードです。ノードは各種処理を表しており、例えば「モデルを読み込むノード」や「テキストをAIが理解できる形にエンコードするノード」、「画像を生成するノード」などがあります。ノードには左側に入力端子(小さな丸印)、右側に出力端子が描かれており、これらを線で繋ぐことでデータの流れを表現します。線(リンク)を繋ぐには、あるノードの出力端子からドラッグして他のノードの入力端子までドロップします(ゴムひもを伸ばす感覚です)。正しく繋がると線で2つのノードが接続されます。

-

プロパティ(ノード設定):各ノードはそれぞれ設定項目(プロパティ)を持っています。ノード上部に表示される名前やボタン、テキストボックスが設定UIになっている場合もありますし、ノードをダブルクリックしたり右クリックメニューからProperties(プロパティ)を選ぶことで詳細設定パネルが開く場合もあります。例えば「テキストを入力するノード」であればプロンプト(生成したい画像の説明文)を入力するテキスト欄がプロパティです。後述する各ノード追加時に、それぞれどんな設定をするか説明します。

以上がComfyUI画面のおおまかな構成です。

最初は空っぽのキャンバスに何をしていいか戸惑うかもしれませんが、次章から実際にノードを置いていくので一緒にやってみましょう!

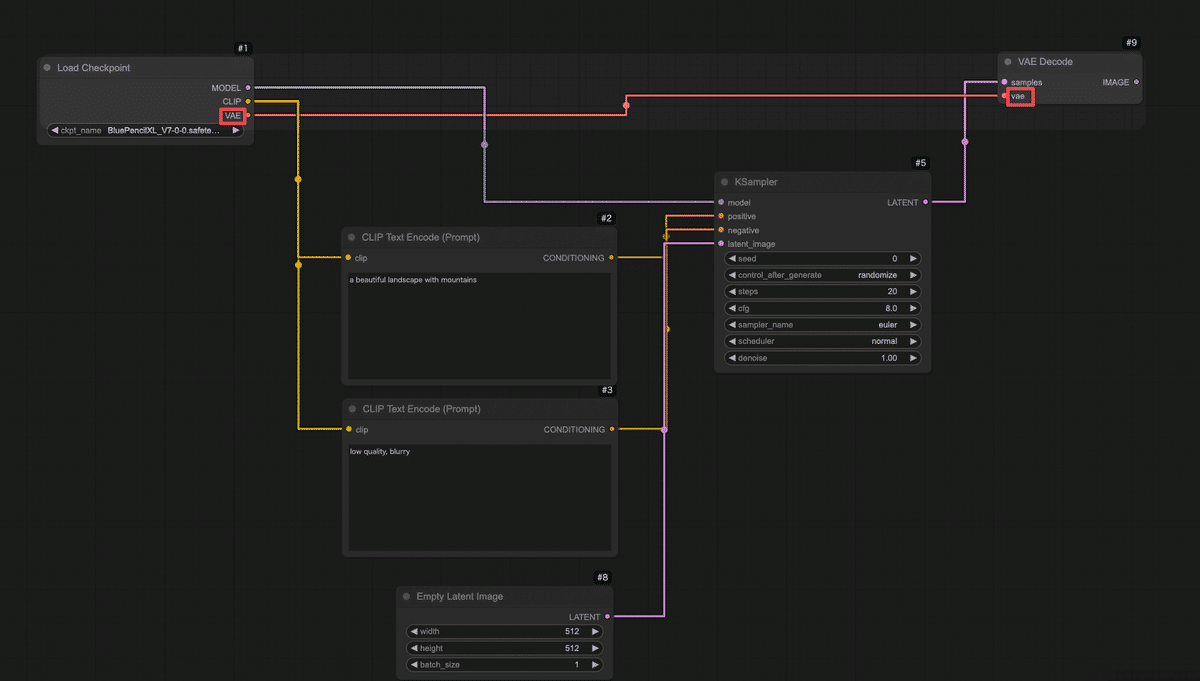

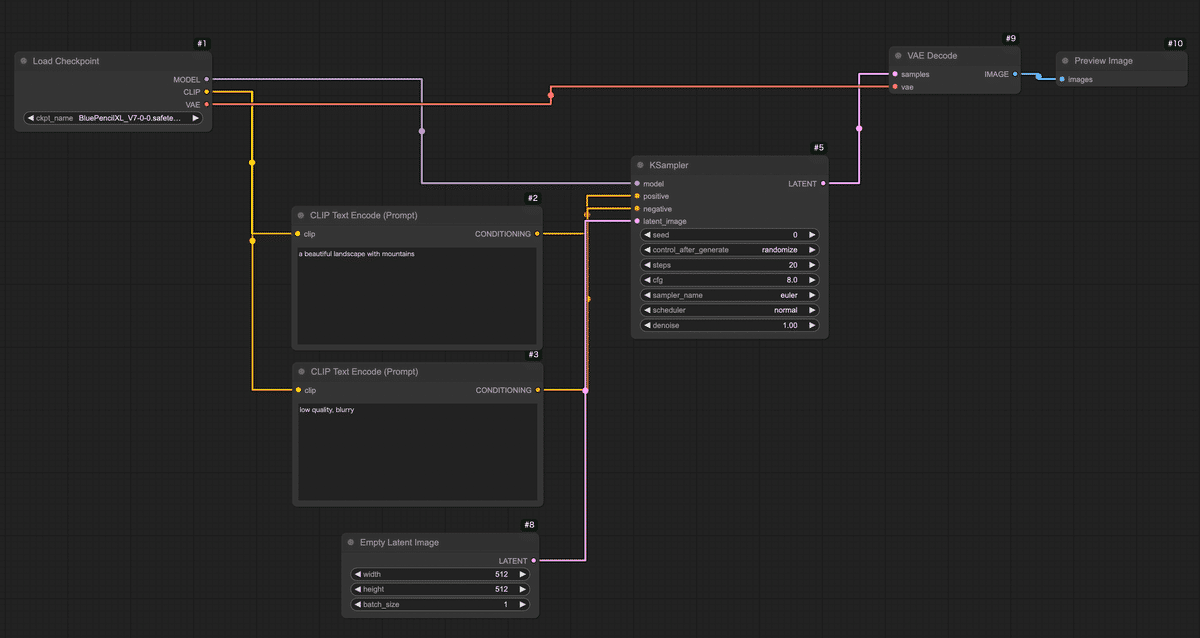

3. 最小限のノードで画像生成ワークフローを作ってみよう

それではいよいよ、画像生成のワークフローを組んでみます。

ここでは「テキスト(プロンプト)から1枚の画像を生成する」ために必要な最小限のノードを追加し、順番に繋げていきます。

難しく感じるかもしれませんが、ノードは基本的に上流から下流へ繋げていくだけです。一緒にやってみましょう!

今回は以下の6種類のノードを使います(名前は英語ですが順に説明します):

-

Load Checkpoint(モデル読み込みノード)

-

CLIP Text Encode (Prompt) ×2(テキストエンコードノード:ポジティブ用とネガティブ用)

-

KSampler(画像生成サンプラーのコアノード)

-

Empty Latent Image(空の画像キャンバスを用意するノード)

-

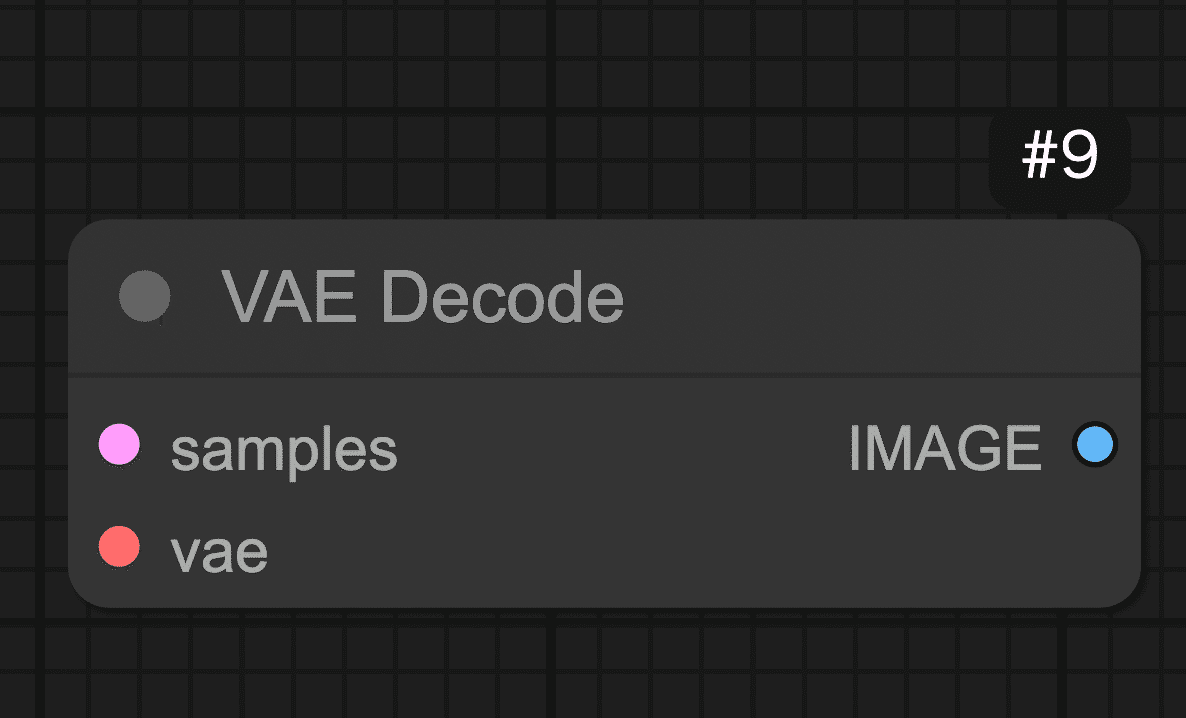

VAE Decode(潜在画像を実画像に復元するノード)

-

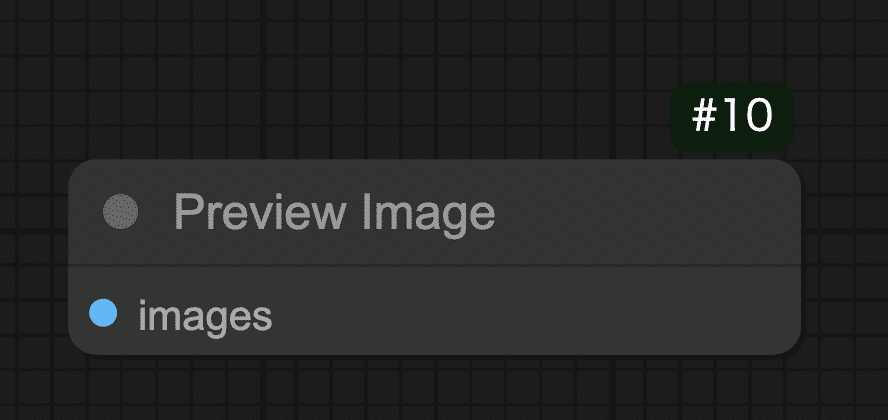

Preview Image(プレビュー表示ノード)

では、順を追ってキャンバスに配置し接続していきましょう。

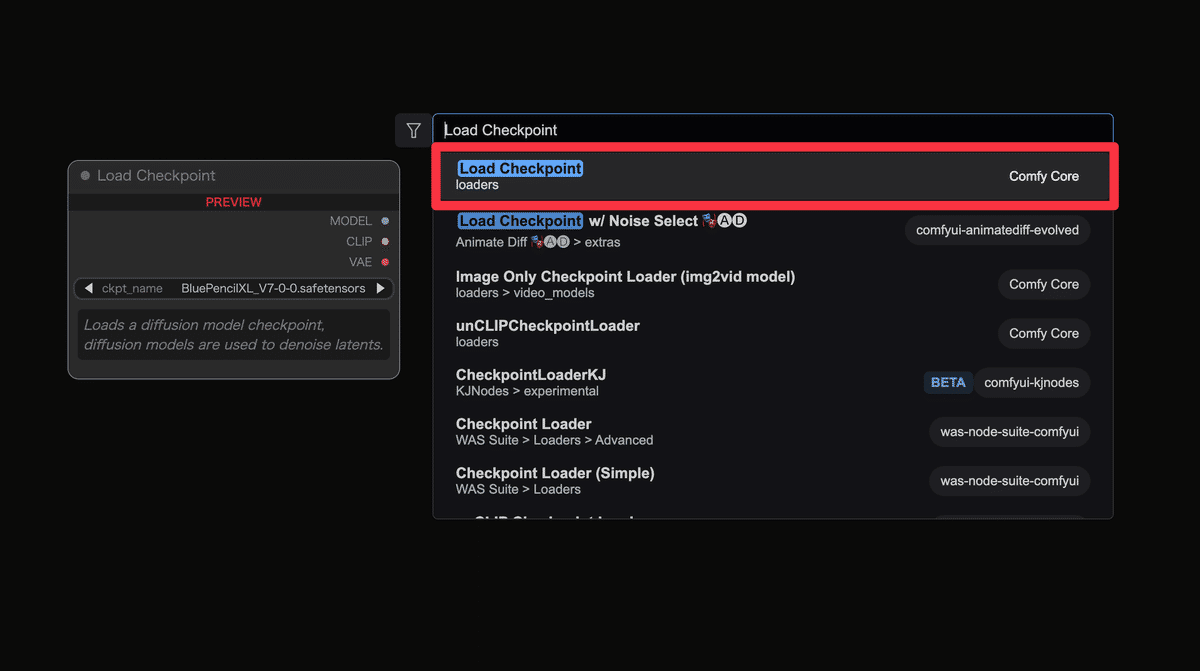

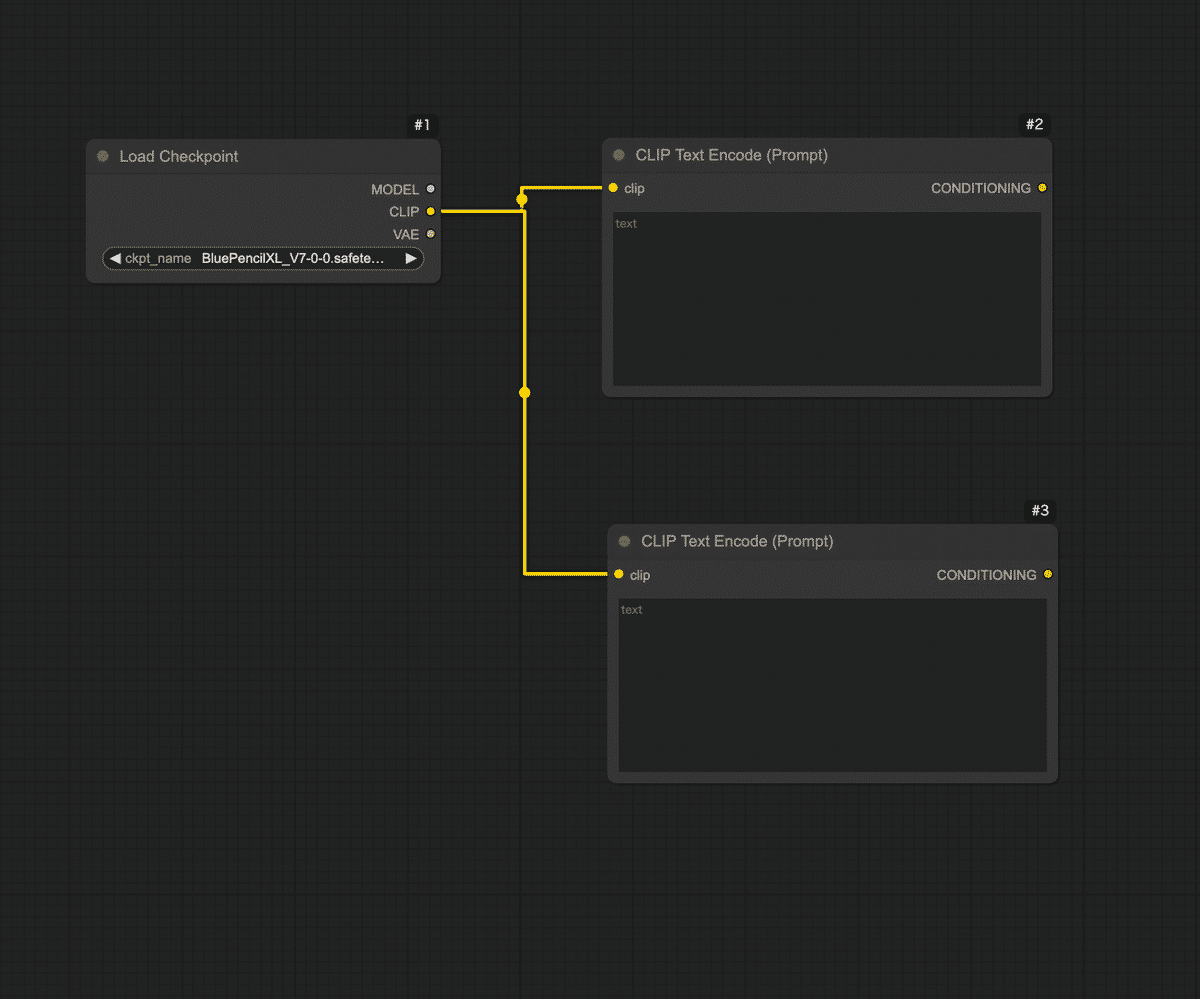

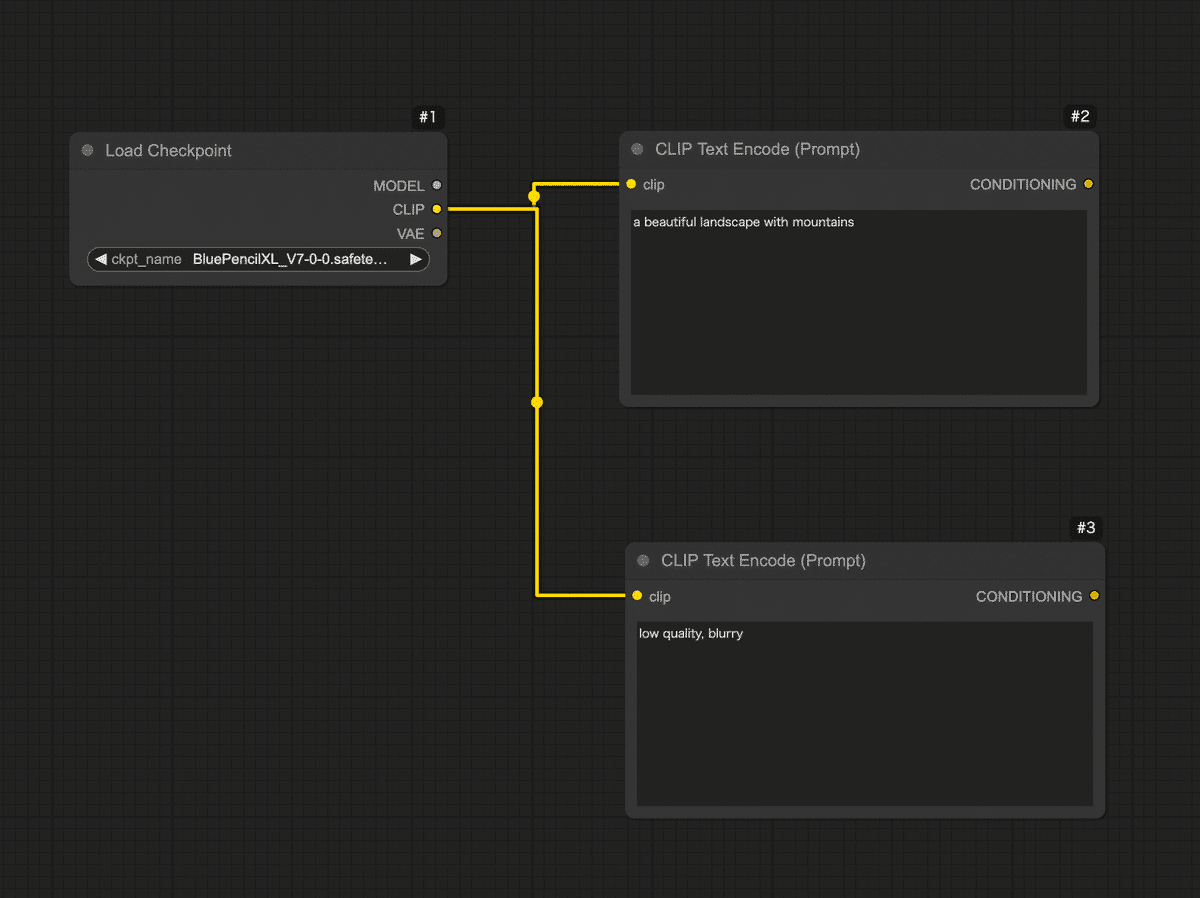

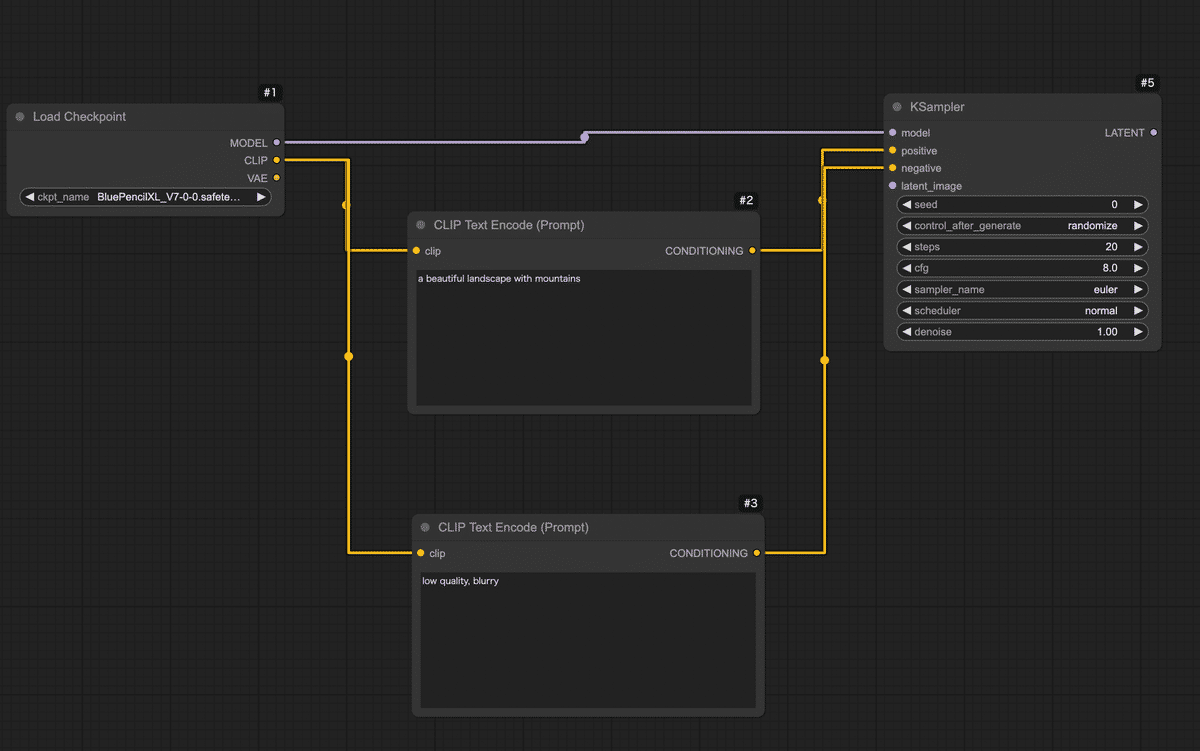

Step 1: モデルの読み込み(Load Checkpointノード)

まずはAIモデルを読み込みます。Stable Diffusion系の画像生成ではモデル(チェックポイント)を読み込まないと何も始まりません。ComfyUIではLoad Checkpointというノードを使ってモデルデータを読み込みます。

-

キャンバス上の何もない所でダブルクリックし、メニューの検索バーで「Load Checkpoint」と入力し、画像の赤枠の項目をクリックします。するとキャンバス上に「Load Checkpoint」という名前のノードが追加されます。

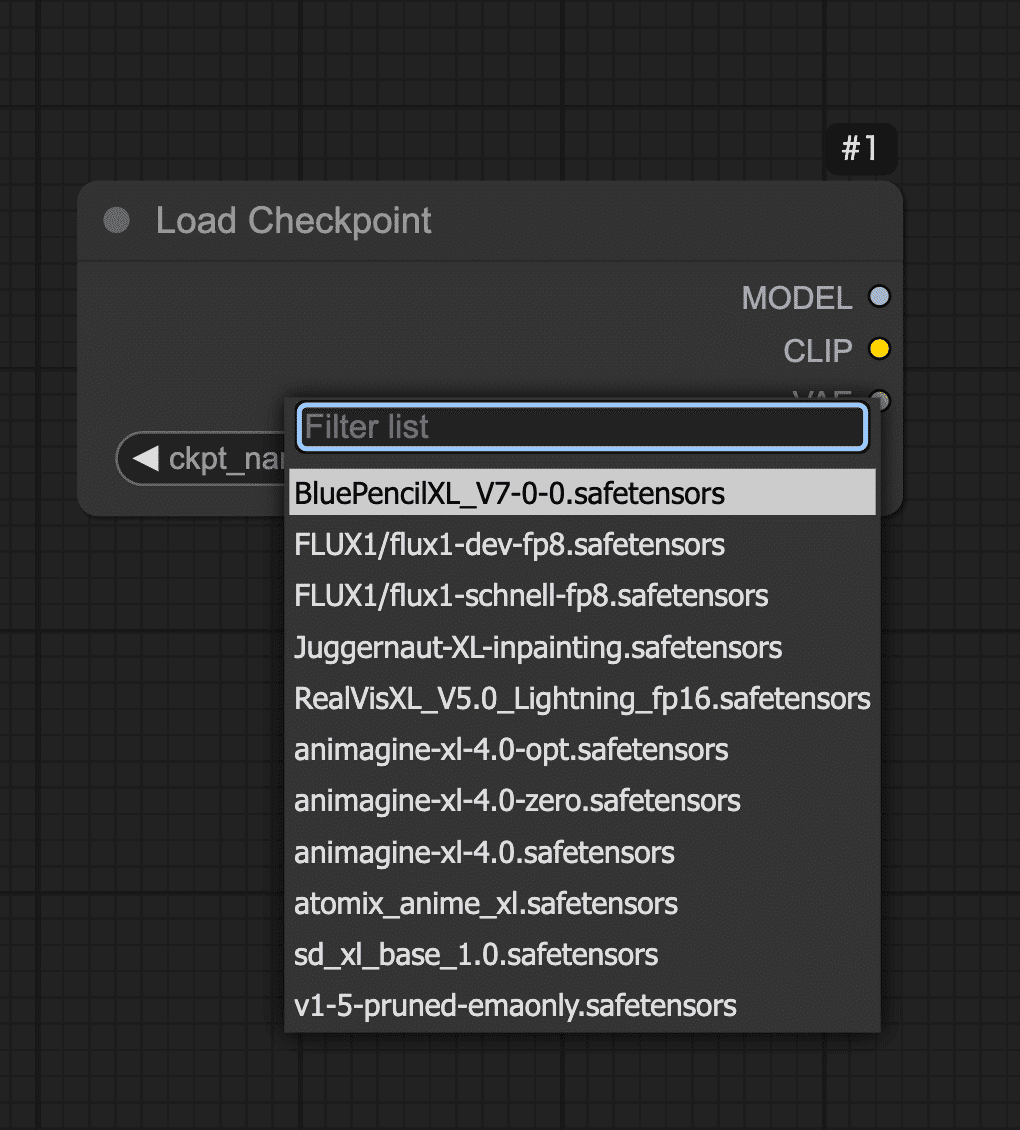

-

追加されたLoad Checkpointノードを確認しましょう。このノードにはモデルを選択するためのUIがあります。ノード内のモデル部分をクリックすると、利用可能なモデルの一覧が表示されます。共有ComfyUIではあらかじめStable Diffusion関連のモデルがいくつか用意されています。ここではお好きなモデルを1つ選択してください。

-

Load CheckpointノードからはMODEL(モデル本体)、CLIP(テキストエンコーダ)、VAE(画像復元デコーダ)といった複数の出力が提供されます(ノード上にそれぞれのラベルが付いた出力丸があるはずです)。これらを後続ノードに繋いでいくことでモデルの各機能を利用できます。

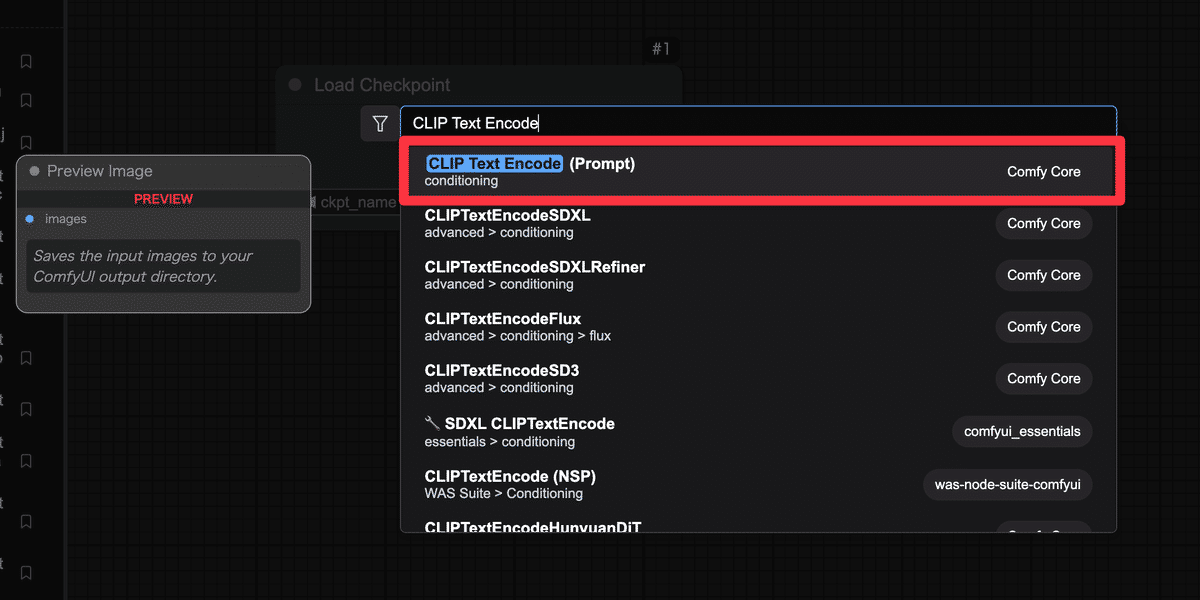

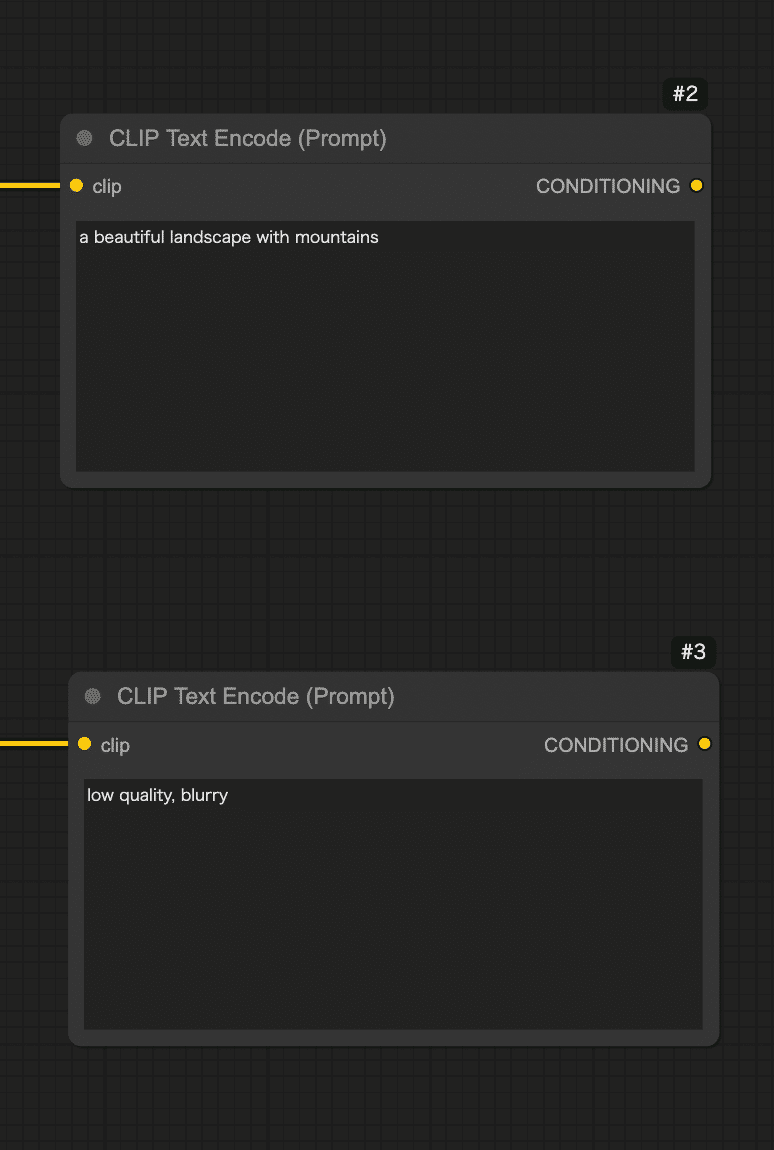

Step 2: プロンプト入力ノードを追加(CLIP Text Encode)

モデルを読み込んだだけでは何も起こりません。

次に画像の内容を指示するテキスト(プロンプト)を入力するノードを用意しましょう。Stable Diffusionでは「ポジティブプロンプト」と「ネガティブプロンプト」の2種類のテキストが指定できます。ポジティブプロンプトは「出力画像に積極的に反映したい要素」、ネガティブプロンプトは「除外したい要素(出力してほしくない特徴)」です。

ComfyUIではこれらを CLIP Text Encode (Prompt) というノードで実現します。

-

再びキャンバス上でダブルクリックし、「CLIP Text Encode (Prompt)」と検索して選択します。このノードはテキスト(文字列)をAIが扱いやすいベクトル(数値データ)にエンコードする処理を行います。

-

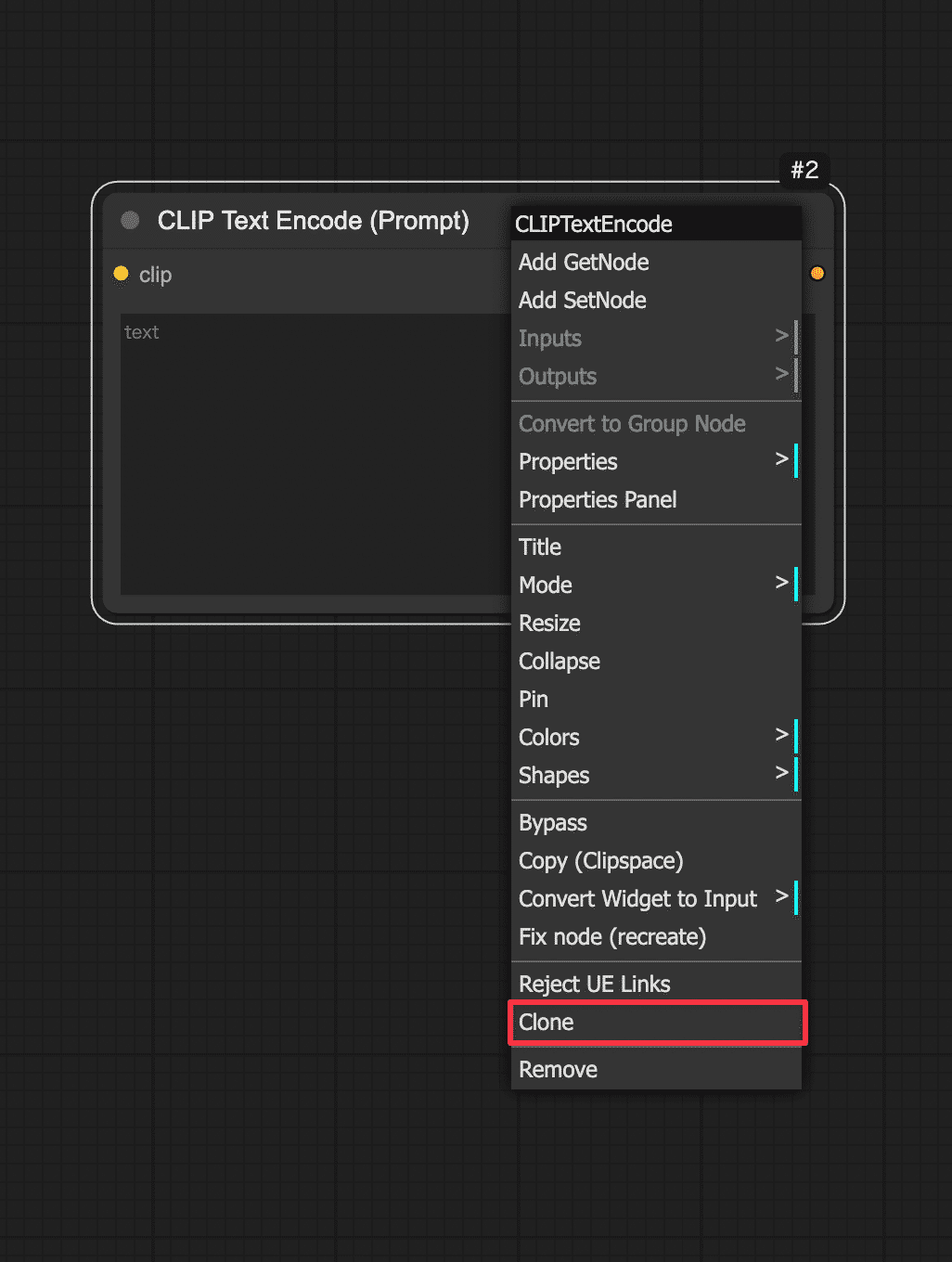

今回は2つ追加してください。同じ操作をもう一度行い、合計2つのCLIP Text Encodeノードをキャンバスに配置するか、ノードの上で右クリックをして、Cloneを選択しましょう。

-

2つのCLIPノードをそれぞれ、先ほどのLoad Checkpointノードに接続します。Load Checkpointノードの右側にある「CLIP」という出力端子からドラッグし、今追加したCLIP Text Encodeノードの左側(入力)のポートにドロップします。2つあるCLIPノードの両方に、Load CheckpointのCLIP出力から線を繋ぎましょう。これでモデルに内蔵されたテキストエンコーダ(CLIP)を使ってプロンプトを処理できるようになります。

-

次に、2つのCLIPノードを区別します。1つ目のCLIP Text Encodeノードはポジティブプロンプト用、2つ目はネガティブプロンプト用として使います。それぞれのノードに実際の文を入力しましょう。

-

ポジティブ用のCLIPノードに、例えば「a beautiful landscape with mountains」(美しい山岳風景)など、お好みのプロンプト文を入力してみてください。日本語で入力できるモデルもありますが、基本は英語が無難です。簡単な単語の並びでも大丈夫です。

-

ネガティブ用のCLIPノードには、「low quality, blurry」など出力画像で避けたい要素を入力します。

-

-

今の段階で、Load CheckpointノードからCLIPノード2つへ、それぞれ線が繋がっている状態になっているはずです。またCLIPノードには自分で入力したテキストが設定されています。このテキスト情報(プロンプト情報)が後ほど画像生成AIに渡されます。

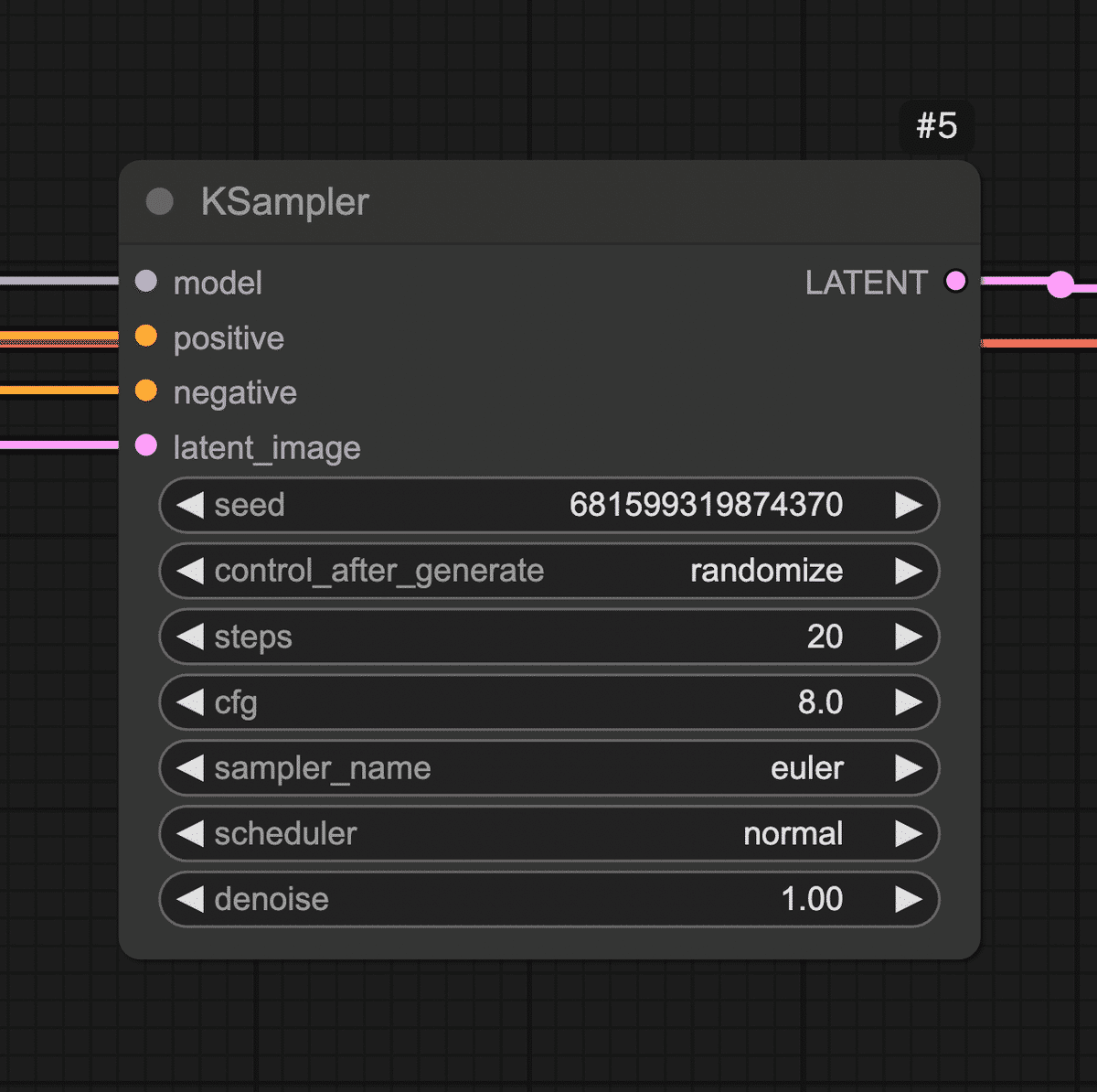

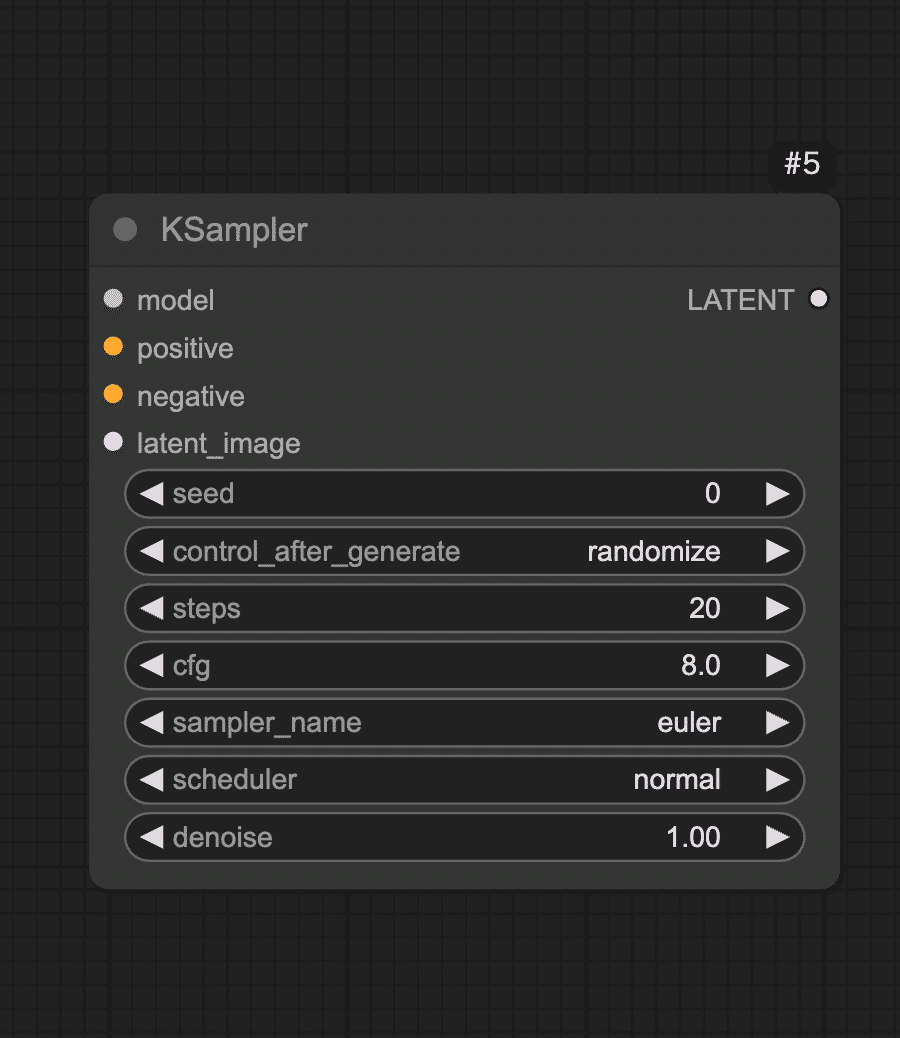

Step 3: 画像生成の核となるサンプラーノード(KSampler)を配置

続いて、実際に画像(正確には画像の元になるデータ)を生成する処理を担うノードを追加します。Stable Diffusionではサンプリングと呼ばれるプロセスでAIが徐々に画像を描き出します。そのコア部分を受け持つのがKSamplerというノードです。

-

キャンバス上でダブルクリックし、「KSampler」を検索してノードを追加します。KSamplerノードが現れたら、先ほどまでに置いたノード群と接続しましょう。

-

KSamplerノードの入力端子を確認します。「model」(モデル本体)、「positive」(ポジティブプロンプト条件)、「negative」(ネガティブプロンプト条件)、「latent_image」(潜在画像)などの入力があります。

-

まずmodel入力に、Load CheckpointノードのMODEL出力を繋ぎます。Load Checkpointノードから伸びているMODELという端子からドラッグし、KSamplerノードのmodelという入力端子にドロップしてください。これでKSamplerはStable Diffusionモデル本体(UNetなど)にアクセスできます。

-

次にpositive入力に、ポジティブ用CLIPノードの出力を繋ぎます。同様に、ポジティブCLIPノードの右側出力から線をドラッグし、KSamplerのpositive入力へ。negative入力にもネガティブ用CLIPノードから線を繋ぎます。これでテキストで与えた指示(プロンプト)がKSamplerに渡るようになります。

-

💡KSamplerノードには各種パラメータ(サンプルステップ数、CFGスケール、シード値など)の設定項目もあります。

今回はデフォルト値で問題ありませんが、興味があればノードのプロパティを確認してみましょう。「Steps」(ステップ数:生成の繰り返し回数)や「Seed」(乱数シード値:画像のランダム性を決める番号)などがあります。

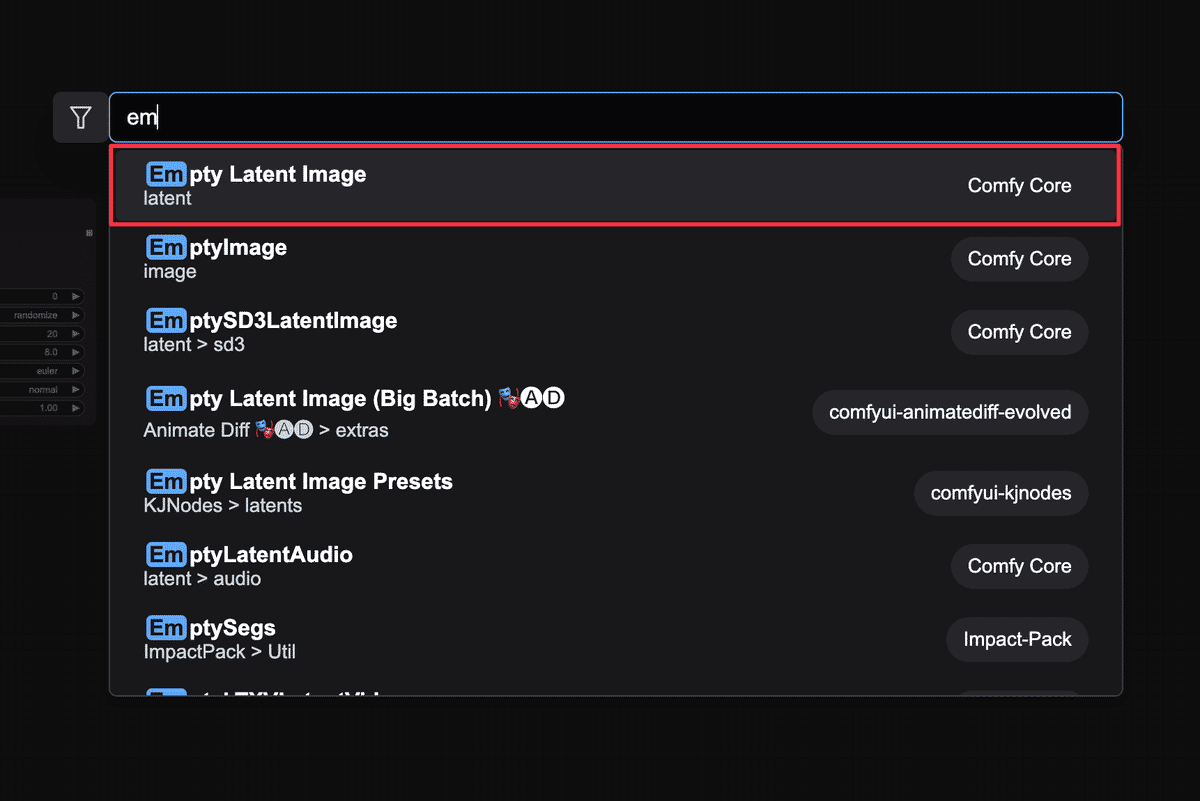

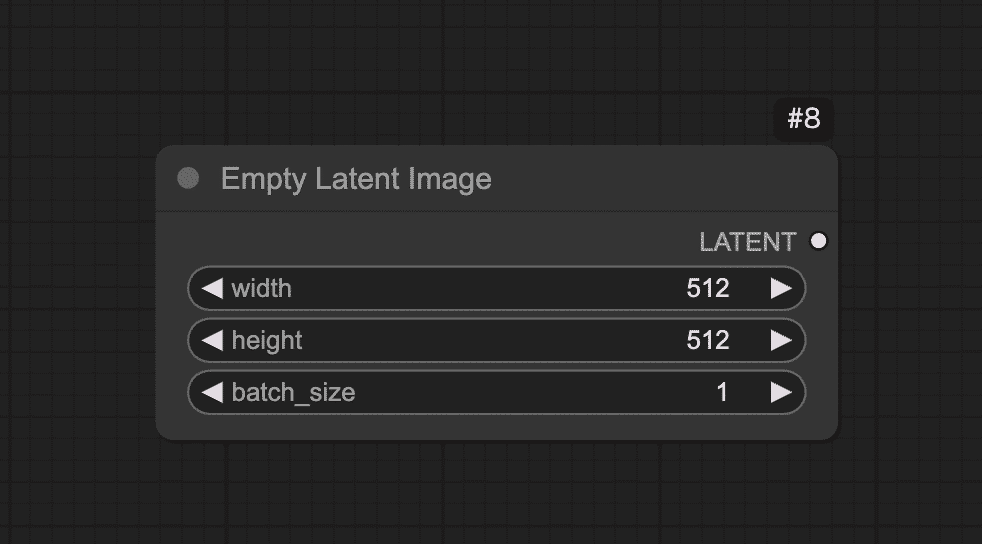

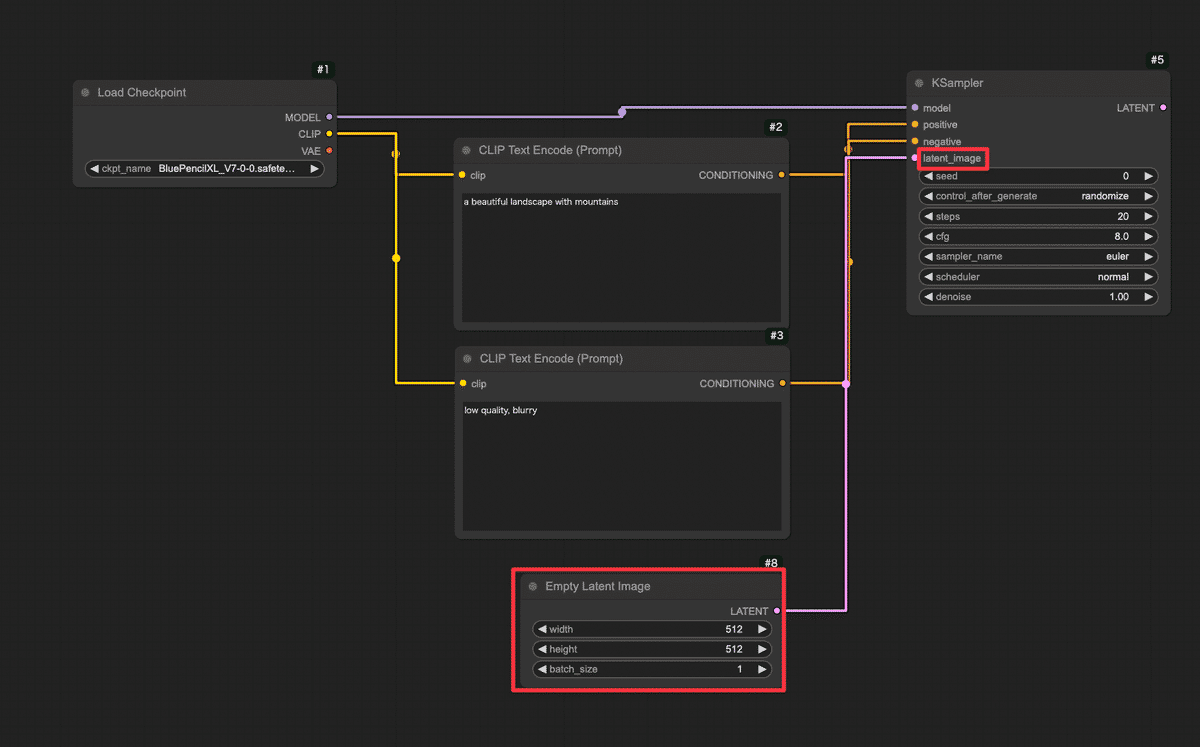

Step 4: 空の画像キャンバスを用意する(Empty Latent Imageノード)

次に、生成する画像の「下地」となるものを用意します。

AIは何もないところからいきなり絵を描くのではなく、まずランダムなノイズ画像(塗り潰しキャンバス)を用意し、そこから徐々に絵を浮かび上がらせていく仕組みになっています。

ComfyUIではこの「最初のノイズキャンバス」をEmpty Latent Imageノードで作ります。

-

ダブルクリックから「Empty Latent Image」を選択してノードを追加します。

-

このノードには画像サイズを指定するプロパティがあります。ノードを選択し、Width(幅)とHeight(高さ)を設定しましょう。初期値は512×512の標準的なサイズになっているはずです。今回は特に変更せず512×512のままとします。お好みで変更可能ですが、大きくすると処理時間が伸びます。SDXLなどのXL系のモデルは1024×1024で開始することをお勧めします。

-

Empty Latent Imageノードの出力を、KSamplerノードのlatent_image入力に繋げます。これでKSamplerは、受け取った空の潜在画像に対して絵を描き始めることになります。

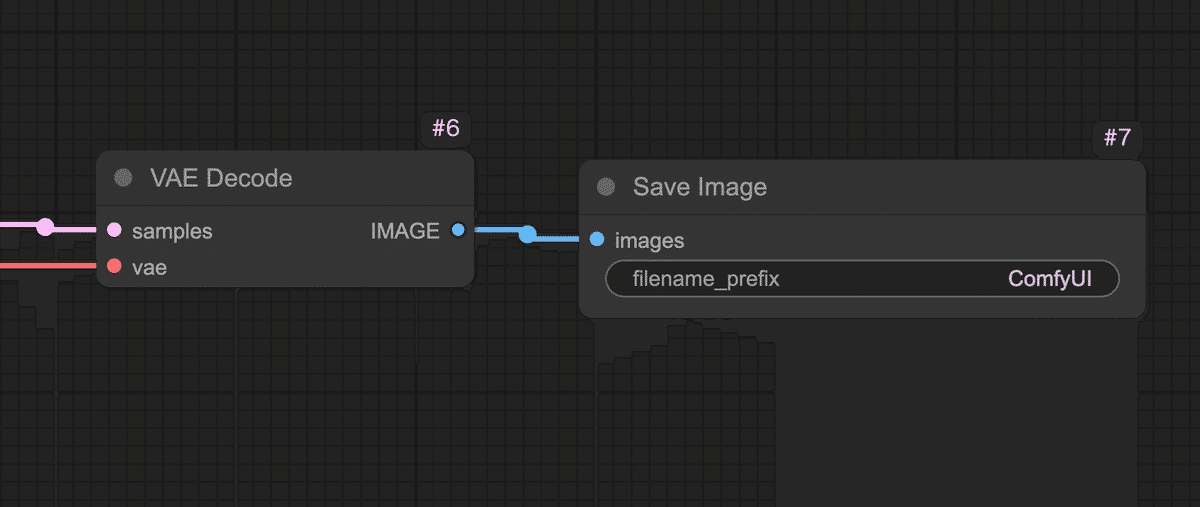

Step 5: 潜在画像を実画像に復元する(VAE Decodeノード)

ここまででKSamplerノードは潜在画像(latent image)形式で結果を出力する準備が整いました。

しかし、そのままでは人間が見てもノイズのようなデータです。

そこで、AIが内部で使う潜在表現を人間が見られる実際の画像(ピクセルデータ)に変換する必要があります。

それを行うのがVAE Decodeノードです。

-

ダブルクリックから「VAE Decode」を選び、ノードを追加します。VAEとはVariational Autoencoderの略で、Stable Diffusionモデルに組み込まれている画像エンコード・デコード用のネットワークです。ここではDecode(復号)を使って潜在→画像に変換します。

-

接続

-

samples入力に、KSamplerノードの出力(潜在画像)を繋げます。KSamplerの右側に「LATENT」と書かれた出力端子があるので、そこからVAE Decodeノードのlatent入力へドラッグしてください。これでKSamplerが生成した潜在画像データがVAE Decodeに渡ります。

-

VAE入力には、Load CheckpointノードのVAE出力を繋ぎます。実はStable DiffusionのモデルデータにはVAEが含まれていることが多く、Load Checkpointノードはそれも読み込んで提供しています。Load Checkpointノードの右側に「VAE」と書かれた出力端子があるので、そこから線を出してVAE DecodeノードのVAE入力に繋いでください。

-

-

これで、潜在画像+VAEモデルが揃い、VAE Decodeノードが人間の目に見える画像データを生成できる状態になりました。

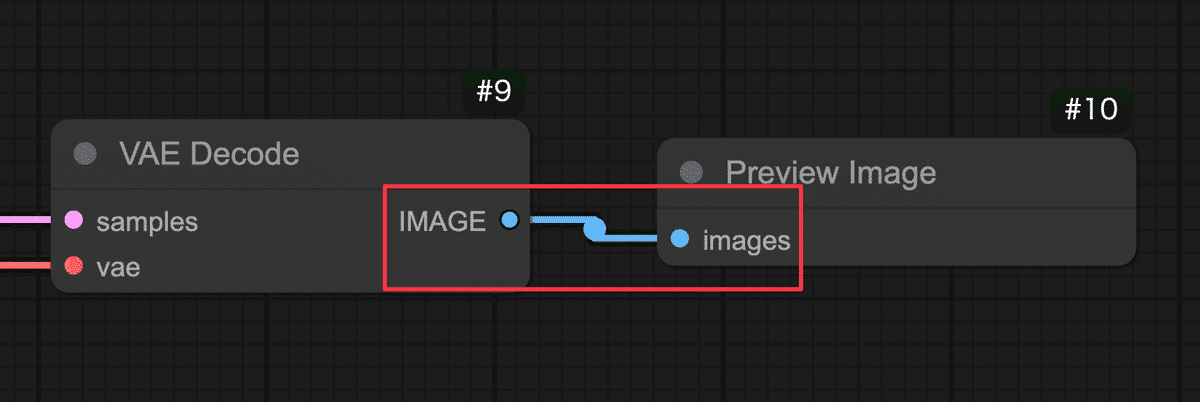

Step 6: プレビューノードを繋いで画像を表示する(Preview Imageノード)

最後に、生成された画像を実際に画面に表示して確認するためのノードを繋ぎます。

-

ダブルクリックから「Preview Image」を選択し、ノードを追加します。

-

Preview Imageノードの「images」に、VAE Decodeノードの出力を繋ぎます。VAE Decodeの右側に「IMAGE」と書かれた出力端子があるので、そこからPreview Imageノードのimages入力へドラッグしてください。これで最終的な画像データがプレビューノードに渡ります。

Preview Imageノードには特別な設定はありません。

以上で、画像生成のための基本的なノード接続は完了です!

お疲れさまでした!

今キャンバス上には、モデル読み込みからテキストエンコード、サンプリング、VAE復元、プレビューまで一直線につながった一連のノードが並んでいるはずです。

ざっとおさらいすると、「Load Checkpoint」→「CLIPエンコード(positive/negative)」→「KSampler」→「Empty Latent」→「VAE Decode」→「Preview Image」という流れです。

ノードごとの配置は、ずれていても構いませんが、必ず上記の通り全ての接続が繋がっていることを確認してください。

これで画像生成の下準備は整いました!

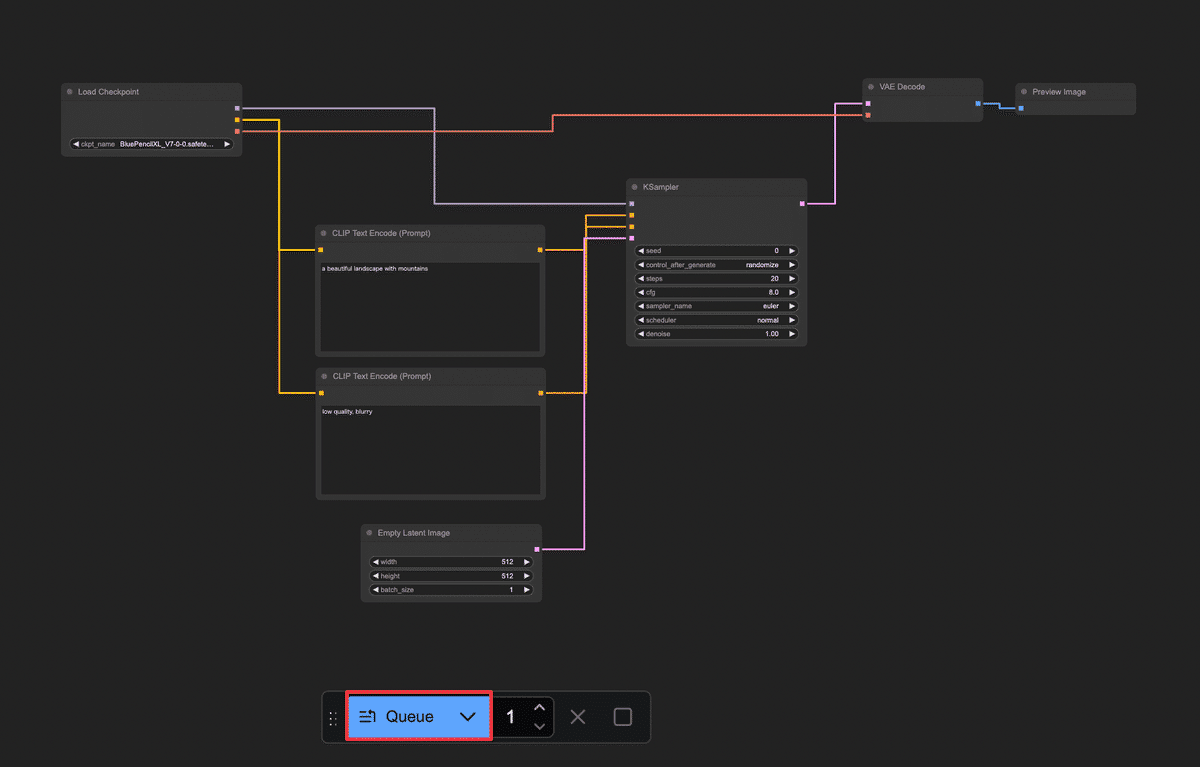

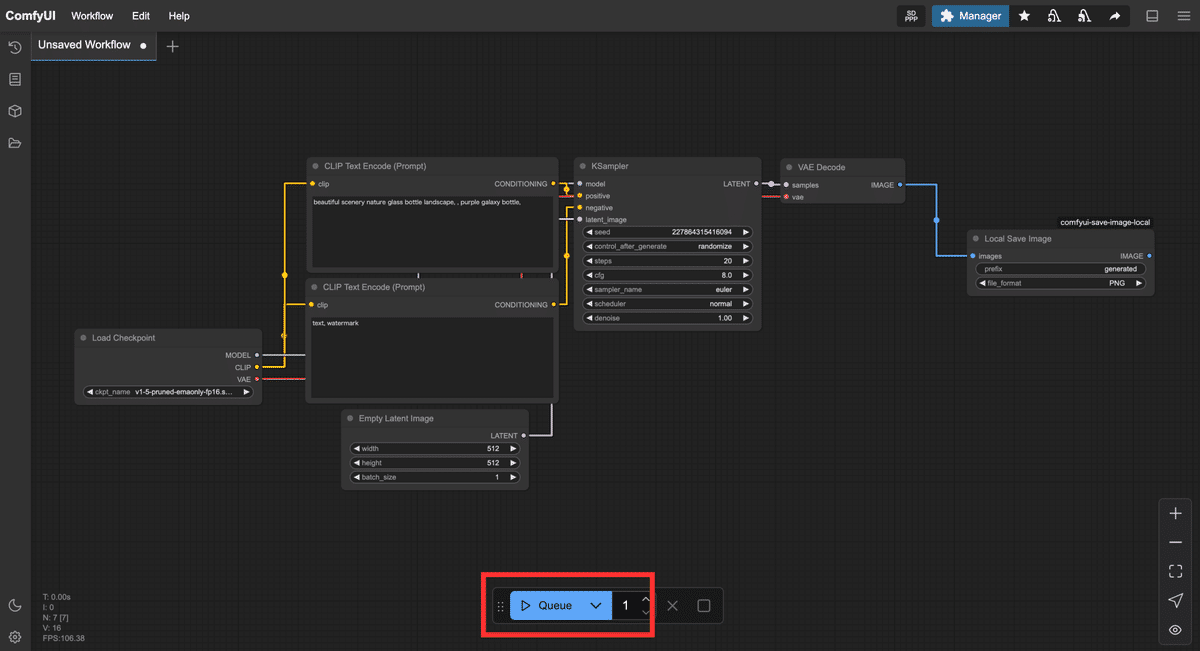

4. いざ実行!画像を生成してみよう(Queueボタンと生成の流れ)

ワークフローの構築ができたら、いよいよ実行してみましょう。

共有ComfyUIでは、準備が整ったらQueueボタンを押すことで現在のワークフローを実行し、画像生成を開始します。

生成の実行手順

あとはQueueボタンを押すのみ!

画面下の「Queue」と書かれたボタンをクリックしてください。

すると、現在キャンバス上にある一連のノードが順番に処理を開始します。

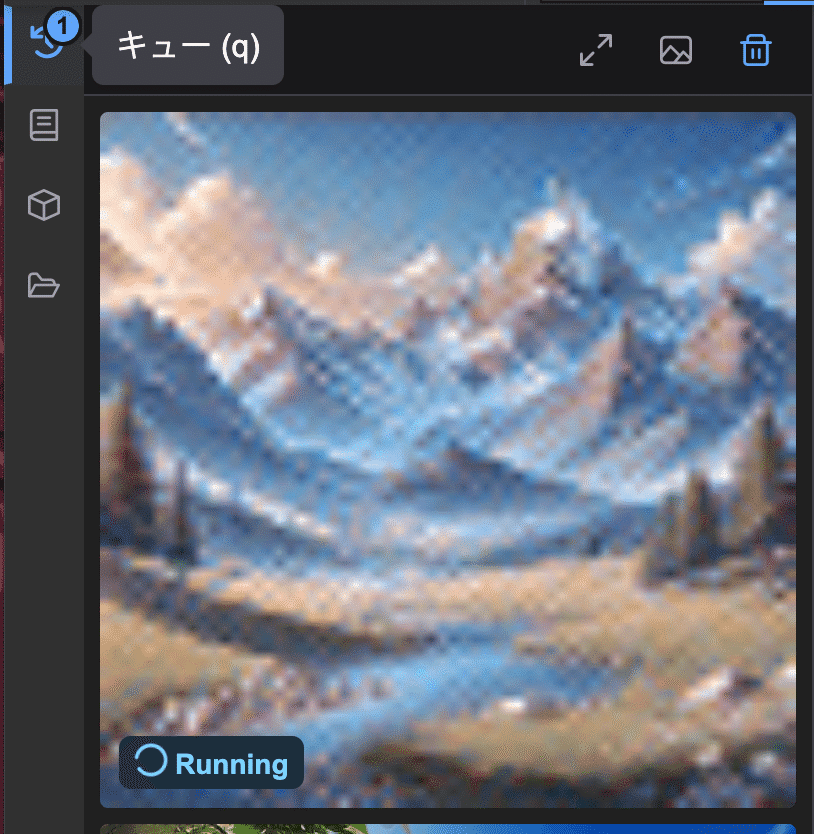

ボタンを押すと即座に画像生成がスタートします。共有ComfyUIでは進行状況のログが左側のバーにある「キュー」にて確認できます。

キューを確認すると画像が処理されて完成していく様子が確認できます。

通常数秒〜十数秒で完了します。

💡万が一、数十秒経っても変化がない場合、接続ミスなどが考えられます。エラー表示や最終的なノードワークフローがこれまでの手順とあっているかご確認ください。

処理が完了すると、キャンバス上のPreview Imageノード内でも実際に生成された画像が表示されます!おそらく小さなサムネイルとしてノード内に出るので、確認してみてください。ノードをクリックすると拡大表示されたり、詳細を確認できる場合もあります。

正常に実行できていれば、指定したプロンプトに基づく画像が1枚生成され、プレビューに表示されたはずです。

今回はポジティブプロンプトに「a beautiful landscape with mountains」を入れたので、美しい山の風景画像が得られていることでしょう!

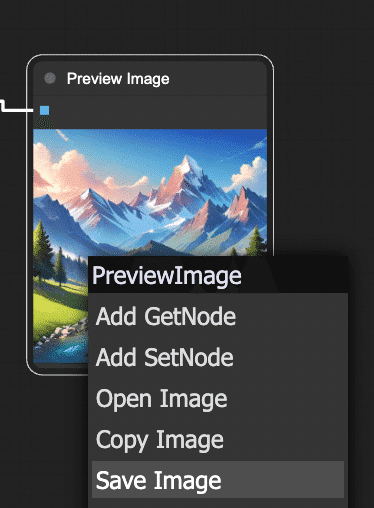

5. 出力画像を保存しよう

ComfyUIでPreview Imageノードに接続して表示された画像は、一時的にメモリ上に存在しているものです。つまり「画面に見えているだけ」の状態で、まだファイルとして保存されたわけではありません。

したがって、大事な画像はユーザーが保存操作を行う必要があります。

画像を保存する方法

プレビューに表示された画像を右クリックして「Save Image」をクリックしましょう。

これで画像ファイルとして任意の場所にダウンロードされました。

6. まとめ

ここまで、共有ComfyUIを使ってテキストから画像を1枚生成する手順を解説しました。

環境登録から始まり、ComfyUIの画面説明、ノードを組んで実行、そして出力画像の保存まで、一連の流れを体験できたと思います。

最初はノードや接続に戸惑うかもしれませんが、実際に動かしてみると「思ったより簡単かも!」と感じられたのではないでしょうか。

生成処理の流れをおさらい

最後にここまで作ったノードワークフロー内で何が行われていたのか、簡単に振り返ってみましょう。

-

Load Checkpoint:選択したStable Diffusionモデル(チェックポイント)を読み込み、そのモデルの各構成を後続ノードに提供しました。

-

CLIP Text Encode (Prompt):入力したテキスト(プロンプト)をモデル付属のCLIPエンコーダーで数値ベクトルに変換しました。ポジティブ・ネガティブ2つに分け、それぞれの条件を用意しました。

-

KSampler:読み込んだモデルに対して、ランダムなノイズ画像から徐々に絵を生成する拡散モデルの過程を実行しました。CLIPで得たテキストのベクトル情報(「山の風景を描いて!」という指示)を参照しつつ、Empty Latent Imageで渡された初期ノイズを何ステップかかけて洗練し、画像を描き出しています。

-

Empty Latent Image:指定サイズの初期画像(ノイズキャンバス)を提供しました。KSamplerはこれを出発点にして画像生成を行いました。シード値が同じなら毎回同じノイズが生成され、再現性が高くなります。一方、シードが違えば別のノイズになるため、出力画像も変化します!これはChatGPT等ではできないテクニックです。

-

VAE Decode:KSamplerが生成した画像データを、元の画像空間にデコード(復元)しました。人間には判読できなかった潜在表現が、このノードを通すことで普通の画像(ピクセルデータ)に戻ります。

-

Preview Image:得られた最終画像をキャンバス上に表示しました。

この一連の流れにより、テキストから画像が生成されます。

「プロンプトをAIに理解させて、AIモデルでノイズから画像を描き、最後に人間向けの画像に変換して見せている」と捉えていただければOKです!

初心者のうちは多少つまずくこともありますが、落ち着いて原因を切り分けていけば必ず解決できます。

それでも不明な点があれば、サービス提供元の AICU.jp コミュニティサイトの掲示板で質問してみるのが良いでしょう。

最後までお読みいただきありがとうございました。共有ComfyUIでのAI画像生成をぜひ楽しんでくださいね!

画像生成AIの基礎知識: ComfyUIを学ぶ前に知っておきたいこと

まずいったん、2025年2月時点での「画像生成AIの基礎知識」、次に「共有ComfyUI」環境における画像生成の基本をおさらいします。

参考図書「画像生成 AI Stable Diffusionスタートガイド」

AICUが2024年3月に出版したこの教科書「(通称)SD黄色本」を、ComfyUI時代の常識で引き上げていきます!できるだけ初心者から上級者まで幅広い読者にわかるように、丁寧に、優しく表現するのでついてきてくださいね!

画像生成AIの超基礎知識[2025年版]: ComfyUIを学ぶ前に知っておきたいこと

画像生成AI、最近本当によく聞くようになりましたよね!まるで魔法みたいに、言葉や簡単な指示から、想像もしていなかったような美しい画像や面白い画像がポンポン生まれてくる。

「ComfyUI」を使いこなして、そんな画像生成AIをもっと自由に操れるようになる前に、まずは画像生成AIって一体何なのか?何ができるのか?どうすれば使えるのか?といった基本的なところから、一緒に見ていきましょう!

今回は、ComfyUIの世界へ飛び込む前に知っておきたい、画像生成AIの全体像 を掴むための3つのステップをご案内します。

画像生成AIとは

画像生成AIってどんなもの?

画像生成AIって何ができるの?

画像生成AIを使うにはどうすればいい?

ComfyUIを学ぶための土台をしっかりと築いていきましょう!

画像生成AIってどんなもの? - 魔法の箱の正体

画像生成AI、マイクロソフトの「Copilot」やOpenAIの「ChatGPT」、Xの「Grok」など、まるで魔法のように美しい画像が数単語のテキストを与えるだけで生成されていきます。ここでは、画像生成AIとは一体何なのか、その正体を解き明かし、他人に説明できるレベルでマスターしていきましょう。

画像生成AIとは:言葉やイメージを画像にする技術

画像生成AIとは、テキストや他の画像などの入力情報に基づいて、新しい画像を機械が生成する技術のことです。

例えば、「猫がピアノを弾いている(a picture of a cat play the piano)」と文章で指示(プロンプト)を入力すると、そのような画像が生成されます。人間が頭の中にイメージを持っているかどうかにかかわらず、AIが魔法のカメラで写真を撮ってきてくれたようにも感じられます。この画像生成AIは、AI技術の中でも「生成AI」と呼ばれる分野に属しています。既に獲得した「モデル」をベースに「推論」によって「それらしい画像」を生成します。生成AIは、画像だけでなく、文章、音楽、動画など、様々な種類のデータを生成することができます。

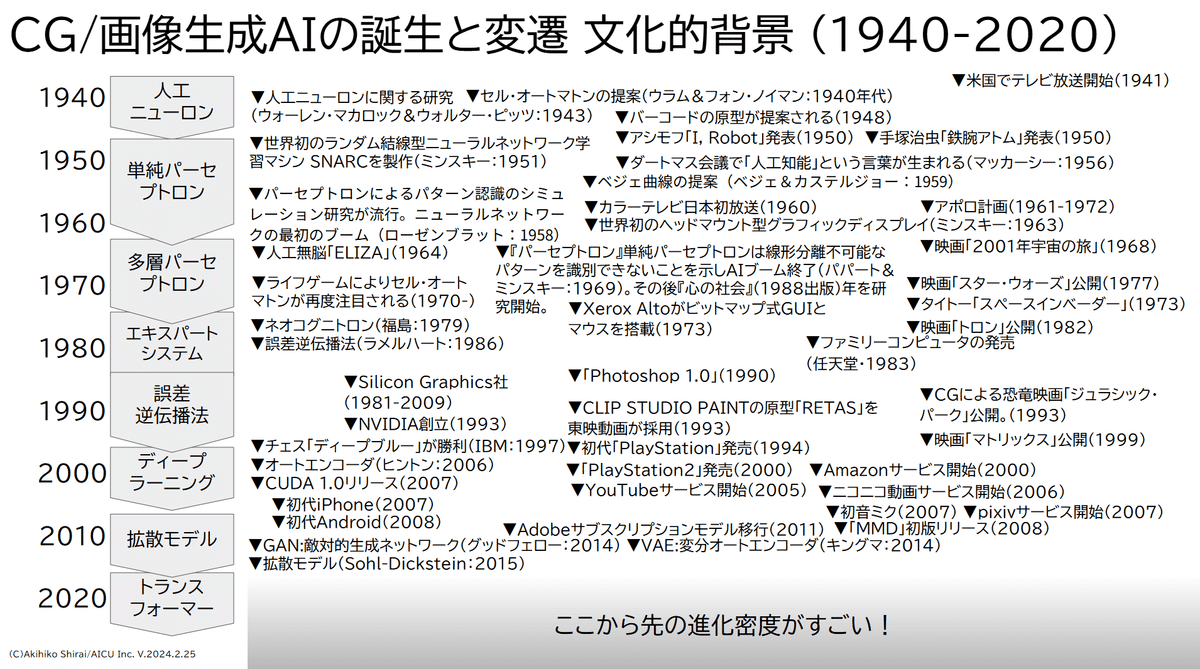

誰がどのように開発した?研究から一般利用へ

画像生成AIの歴史はコンピューターの歴史や映像の歴史、コンピューター・グラフィックス(CG)の歴史とともにあります。実は意外と古く、研究自体は1940年代から始まっていました。

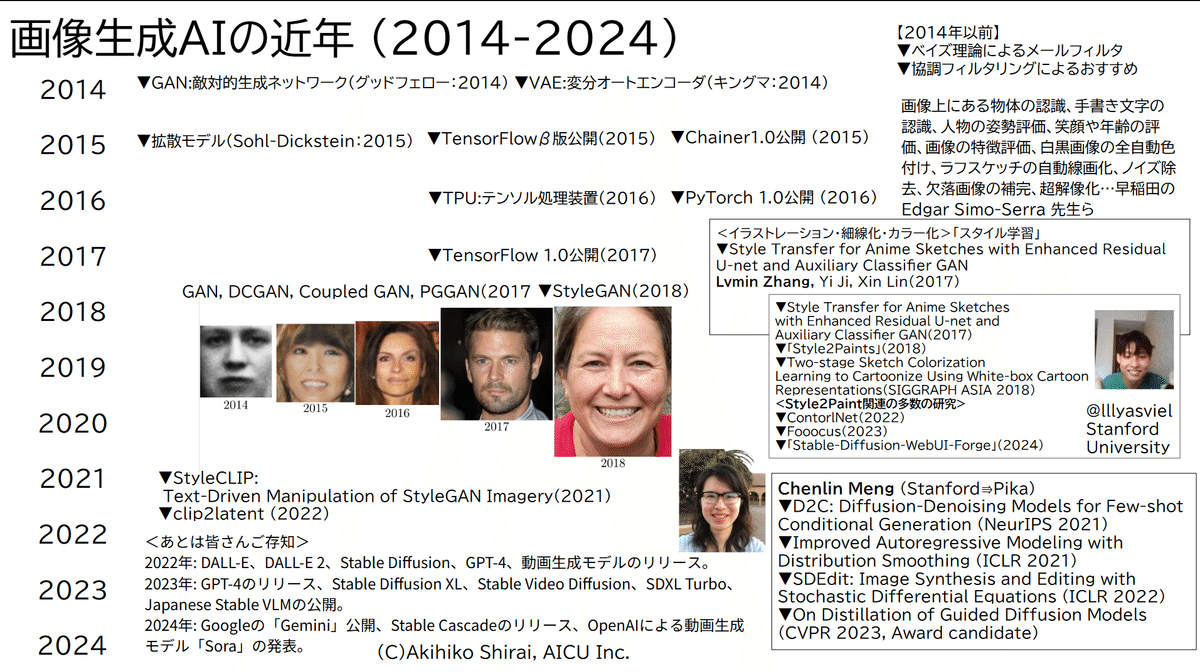

初期の頃は、テレビやブラウン管、ディスプレイ技術のような電気電子技術による映像メディアの誕生とともにあり、バーコードのような白黒の印刷パターンから文字や数字といった「コード」を認識する技術が生まれます。パーセプトロンという人間の脳神経の仕組みを模した人工ニューロンやニューラルネットワークの研究とともに、セルオートマトンという簡単なアルゴリズムにより図形や模様を生成する程度でした。当時提案されたベジェ曲線のような複雑な曲線を表現できる数学のモデルは現在もAdobe Illustratorで使われています。ニューラルネットワークの研究はコンピューターの演算処理の高速化、メモリの大容量化、そして研究者たちのオープンな研究により、多層パーセプトロン、エキスパートシステム、誤差伝搬法と進化していき、近年、ディープラーニング(深層学習)という機械学習技術として進化します。特に2010年以降GAN (Generative Adversarial Network:敵対的生成ネットワーク)や拡散モデル といった新しいモデルが登場したことで、生成される画像のクオリティが飛躍的に向上しました。

特に、2022年8月に公開されたStable Diffusion は、オープンソース (公式には「ソース」ではなくオープンモデル、もしくはオープンウェイト と呼ばれています)で、誰でも無料で利用できるという点が画期的でした。これにより、画像生成AIは研究者や専門家だけでなく、多様なアプリやサービスに組み込まれ、一般の人々にも広く利用されるようになり、爆発的に普及しました。

Stable Diffusionの開発には、Stability AIという企業を中心に、多くの研究者や開発者が貢献していました。また、Google やOpenAI、 Twitterを運営する Xといった大手IT企業も、Imagen、DALL-E、Grokといった高性能な画像生成AIを開発・公開しています。Webブラウザやスマホアプリで利用するサービスだけでなく、Stable Diffusionのようなオープンウェイトとして配布されるモデルや、さらに商用利用可能なモデルや、その追加学習をする技術、一般のクリエイターによって配布されるモデルなど多様に登場しました。

画像生成AIが一般的な認知を得るようになった経緯としては、

-

技術の進化: ディープラーニング、GAN、拡散モデルなどの技術革新により、高品質な画像生成が可能になった。

-

オープンソース化: Stable Diffusionの登場により、無料で誰でも利用できる環境が整った。

-

SNSでの拡散: 生成された画像がTwitterやInstagramなどのSNSで拡散され、多くの人々の目に触れる機会が増えた。

-

メディアの報道: テレビやニュースサイトなどのメディアで画像生成AIが取り上げられるようになり、一般層への認知度が向上した。

といった要因が挙げられます。これは旧来の研究者が、専門家向けに論文を書いて、学会で論文誌や書籍に収録されているだけのサイクルとは明らかに異なっており、さらにX(Twitter)のGrokような「日常の出来事」を画像生成させたり、公開された画像を学習したりしていくことで、さらに成長・進化していく可能性があります。

現在どのようなサービスがある?広がる利用シーン

現在、様々な画像生成AIサービスが登場しており、用途や目的に合わせて自由に選択できるようになりました。

主な画像生成AIサービス

-

Stable Diffusion: オープンソース(オープンウェイト)で、様々な派生モデルや対応できるGUIツールが存在する。「ComfyUI」もその一つです。

-

Midjourney: Discord上で利用できる画像生成AI。アーティスティックな画像生成に強み。広告業界では広く使われています。

-

DALL-E 2 & DALL-E 3: OpenAIが開発。テキスト指示への理解度が高く、高品質な画像生成が可能。OpenAIとマイクロソフト以外は中身がどうなっているか、直接触ることはできませんが、アプリ開発(Application Programming Interface: API)を経由して利用できます。

-

Bing Image Creator (DALL-E 3 搭載): Microsoft Bingの画像検索機能に統合された画像生成AI。API費用はマイクロソフトが負担しており、無料で手軽に利用可能です。

-

Adobe Firefly: アドビがAdobe Stockの画像を学習してトレーニングしたモデルで、Adobe Creative Cloudに統合された画像生成AI。Photoshopなどとの連携が強み。なおアドビには Adobe Stockに寄稿者が投稿したストック素材を生成AIモデルのトレーニングに使う許可が与えられています。

主にどのような人が使っている?

画像生成AIは、本当に幅広い層の人々に利用されています。

-

クリエイター・デザイナー: イラストレーター、グラフィックデザイナー、Webデザイナーなどが、アイデアの素早い具現化、デザインのバリエーション作成、作業効率化のために利用しています。一般のグラフィックスとして最終出力に使うだけでなく、素案やレイアウト検討、実際の俳優の演技検討や撮影計画の素材。漫画の背景といった使い方もあります。

-

マーケター・広告担当者: 広告素材、Webサイト用画像、SNS投稿用画像の作成に利用するケースが多く見られるようになってきました。画像素材として利用するだけでなく、多様な趣味嗜好に合わせた画像を人間が作り込む代わりに、多様な趣味嗜好に合いそうな画像を生成して「A/Bテスト」として市場に投入するといった例もあります。

-

教育関係者: 著作権や肖像権などを解決した教材作成、授業での利用、生徒の創造性育成、機械学習やAI利用の学習にも使われています。

-

研究者: 学術的な画像生成技術の探求、アニメやゲームの開発効率向上のためのツール開発、新たな表現能力の獲得を研究しています。

-

開発者: 例えばJR東日本グループによる研究開発では、電気設備の異常を検出する認識技術のために、ケーブルに発生した「自然な異常画像」を Stable Diffusionによって生成した例が報告されています。https://pages.awscloud.com/rs/112-TZM-766/images/20230921-railway_construction-02_jeis.pdf

-

一般ユーザー: 趣味のイラスト作成、SNSアイコン作成、ブログ用画像作成、アイデアの視覚化、家族写真のフィルタ処理、エンターテイメント目的など、幅広い用途で利用されています。

画像生成AIは、もはや特定の専門家だけのものではなく、アイデアを形にしたい全ての人 にとって、強力なツールとなりつつあります。

画像生成AIって何ができるの? - 創造力を解放する力

画像生成AIは、一体どんなことができるのでしょうか?

ここでは、画像生成AIの主要な機能と、具体的な活用例を見ていきましょう。

画像生成AIは、テキストや画像などの入力情報から、様々な種類の画像を生成・加工することができます。

画像生成AIの主な機能

-

画像生成: テキストプロンプトに基づいて、全く新しい画像を生成します。

-

例:「猫が宇宙遊泳をしているイラスト」「夕焼けのビーチでサーフィンをする犬の写真」など、想像力次第で無限のバリエーションの画像を生成可能です。実際に撮影するととても大変なシチュエーションや、その瞬間の表現などに威力を発揮します。

-

-

画像変換 (スタイル変換): 既存の画像のスタイルを別のスタイルに変換します。

-

例:写真をイラスト風、油絵風、水彩画風などに変換。

-

例:実写の風景写真をアニメ調の背景に変換。

-

-

画像拡張 (アウトペインティング/インペインティング): 既存の画像の一部を拡張したり、不要な部分を自然に消去・修正したりします。

-

例:風景写真の左右を広げて、より広大な景色を生成。

-

例:写真に写り込んだ不要な人物や物を消去。

-

-

画像高解像度化 (超解像): 低解像度の画像を、AIの力で高解像度化し、画質を向上させます。

-

例:古い写真や低画質の画像を鮮明にする。

-

例:生成した画像の解像度を上げて、より高品質な画像にする。

-

どうすれば使えるの? - ComfyUIの世界へようこそ

画像生成AI、使ってみたくなってきましたか?

ここでは、画像生成AIを使うための方法と、この教科書で学ぶComfyUIについて解説します。まず、ComfyUIに限らず画像生成AIを利用する方法は、大きく分けて3つあります。

1.生成サービスを利用する: Webブラウザやスマホアプリから、Midjourney、 NijiJourney 、DALL-E 3 、Adobe Firefly などの画像生成AIサービスを利用する方法です。

-

メリット: 手軽に始められる、特別な環境構築が不要。

-

デメリット: サービスによっては有料、生成できる画像の種類や品質、自由度に制限がある場合がある。生成された画像の権利や、参照元にする画像の権利やセキュリティが問題になる。

2. 自分で機械学習モデルを用意して利用する: Stable Diffusion などの機械学習モデルを自分で入手して、PCやクラウド環境に構築し、利用する方法です。

-

メリット: 無料で利用できる(電気代、PCやGPUの購入費用以外)、カスタマイズ性が高い、中の動作を理解できる、生成できる画像の自由度が高い。未公開画像などのセキュリティを閉じたネットワークで保護することができる。

-

デメリット: PCのスペックが必要、環境構築にある程度の知識が必要。

3. クラウド上のAPIサービスや演算基盤を利用して利用する : FalやReplicatorといった演算基盤、Stability AIのAPIなどモデルと問い合わせのためのAPIをセットにしたサービスを利用する方法です。

-

メリット: 安価で利用できる、カスタマイズ性が高い、PCやGPUのスペックに依存せず、画像の品質、アプリやサービスを開発に集中できる。

-

デメリット: 画像1枚あたり数円~数十円程度のAPI費用が必要。クラウド上のサービスを使用するためにセキュリティ面のリスクはゼロではない。未公開の画像をアップロードする可能性がある(多くの場合は学習対象にはなりません)。

「画像生成AI ComfyUI マスターガイド」では、自分で機械学習モデルを用意して利用する方法、とクラウド上のAPIサービスや演算基盤を利用して利用する方法 の両方を「ComfyUI」(コンフィ・ユー・アイ)というツールを使って、自分で画像生成AIを使いこなしていく方法を解説していきます。

ComfyUIで画像生成AIを使うために必要な要素

ComfyUIで画像生成AIを利用するためには、主に以下の要素が必要です。

-

高性能なPCまたはクラウド環境: 画像生成AIは計算負荷が高いため、ある程度のスペックのPCが必要です。Mac、とくにApple Siliconでも利用はできますが、可搬性・可用性ではGPU搭載のWindowsやLinuxが有利です。クラウド環境(Google Colabなど)やAPIサービスを利用することもできます。

-

機械学習モデル (Stable Diffusion など): 画像を生成するためのAIモデル本体です。様々なモデルが公開されており、用途や好みに合わせて選択できます。またライセンスも商用利用可能なモデルや、商用利用不可、もしくは商用利用に適さないモデルもあります。

-

ComfyUI: Stable Diffusionなどの機械学習モデルをGUI操作で簡単に扱えるようにするツールです。かつて広く使われていた「AUTOMATIC1111/Stable Diffusion WebUI」のようなボタン・パラメータ型のユーザーインターフェース(UI)ではなく、ノードベースのインターフェースで、複雑な処理も視覚的に分かりやすく構築できます。

-

基礎知識: 画像生成AIの基本的な仕組み、プロンプトの書き方、ComfyUIの操作方法など、ある程度の知識があると、よりComfyUIを (効果的に) 活用できます。これから一緒に学んでいきましょう!

なぜComfyUIを学ぶ必要があるのか?それは「再現性と制御性」

前出の「生成サービスを利用する」というレベルの用途に限定すれば「なぜComfyUIを学ぶ必要があるの?」という疑問はあって当然と思います。一般のホビーやエンタメ目的であればWebブラウザやスマホアプリから、XのGrokやMidjourneyやNijiJourney、ChatGPTのDALL-Eが使えればいいでしょうし、グラフィックスを使うクリエイティブ分野の方であればAdobe Fireflyを使えば商業的なライセンスも問題なさそうです。

しかし「再現性と制御性」という視点ではいかがでしょうか。プロフェッショナルな業務においては「ちょっとそれらしい画像が出れば良い」という用途は非常に限定的で、キャラクターや背景画像であれば「その同じキャラクターで違う表情がほしい」とか「違う服で」とか「太陽を夕日に」といった「再現性と制御性」が求められます。もちろんAdobe Fireflyでも頑張ればできるかもしれませんが、汎用的なグラフィックスやストックフォトをベースにした画像生成モデルには限界があり、相当に使いこなせばこなすほど、似たような画像を生成する結果にたどり着く可能性が多くなります。また特殊な用途への絞り込み、例えば「日本人女性に特化した画像生成」とか「新作アパレル向けのファッションカタログ」とか「クルマの内装」とか「電気設備の自然な異常」とか、「子どもの自然な画像」といった用途に対して、やはり「自分でモデルを作る」といった結論にたどり着くことは多いでしょう。アプリやサービスを開発する立場であれば、なおのこと、その可能性は高くなりますし、映像制作や漫画制作スタジオのような小規模な製作会社であっても、同様に「外部で一般に使われている画像生成AIでは無理」という使い方が多くなります。

そういった目的に対して、Stable Diffusion初期の2022年~2023年では、Pythonスクリプトによるシステム開発や、AUTOMATIC1111/Stable Diffusion WebUI(A1111)によるモデル、ControlNet、LoRA、機能拡張といった改造で対応していました。そのために機械学習をゼロからやり直す、といった途方もない方法も当たり前のように取られていました。いくらStable DiffusionやA1111がオープンに配布されていたとしても、演算コストや人件費で数千万~数億円はかかってしまいます。

しかし、現在、広く普及してきた「ComfyUI」の時代で、そのような問題は大きく解決しています。まず「ほぼひとりで開発してきたA1111」に対して、ComfyUIは「Comfy Org」というスタートアップ企業のような団体によって複数人でオープンソースで開発されています。元Google、元Stability AIといった優秀で聡明な開発者が「映像と音声メディアの新たなフロンティアを創造する」というビジョンのもと、「快適な(Comfy)」AIのインターフェースをつくるために日夜尽力しています。

ComfyUIの特徴

ComfyUIはA1111と比較して以下のような特徴があります。

-

高速

-

セットアップがシンプル

-

ノードベースで見やすい、フリースケール

-

拡張機能を開発しやすい

まず、A1111やその派生である「Forge」は非常に優れたツールで、現在も数多くのユーザーが存在しますが、内部の動作は(オープンソースとはいえ)ユーザーに公開されているわけではありません。対してComfyUIは、非常に高速で、シンプルなテキストからの画像生成でも、ControlNetを使った複雑な生成でも、自分でノードを組み合わせて画像生成の設計図(ワークフロー)を作ります。現在どこのノードでプロセスが回っているか、どこの処理が重たいか、といった工程を確認していくことができます。拡張機能の開発も、余計な要素や知らなければならない前提知識が少なくても済むのが特徴です。

ComfyUI公式「よくある質問」より(翻訳)

Q: 今後の計画について教えてください。

A:Comfyでは、常に最先端を行くために、最先端のモデルを採用し続けます。また、PRをレビューし、Githubの問題に迅速に対応することを目指しています。また、カスタムノード作成者のユーザーエクスペリエンスと開発者エクスペリエンスを向上させる必要があります。正確なモデルについてはまだ検討中ですが、将来の改良はGithubのProjectsで共有する予定です。すべての大きな変更はGithubのディスカッションとして始まり、私たちのDiscordとMatrixサーバーで共有されます。最終的なデザインに達したら、公開ロードマップに実装を追加します。私たちのTwitter、Discord、Matrixサーバーで最新情報をご確認ください。

Q: プロジェクトはどうやって維持するのですか?

A:現在、私たちはお金を稼いでいません。オープンソースのAIツールを開発するという私たちのビジョンに賛同してくださるサポーターや投資家に支えられています。そのような方は、hello@comfy.orgへどうぞ。将来的にはお金を稼ぐつもりです。

Q: どうやってお金を稼ぐのですか?

A:最近のComfyUIのセキュリティ上の懸念にはどのように対処するのですか?レジストリ上のノードは意味的にバージョン管理され、悪意のある動作についてスキャンされます。すべてをキャッチすることはできませんが、ノードがカスタムピップホイールを含むかどうか、任意のシステムコールを実行するかどうか、外部APIを呼び出すかどうかのチェックを近々追加する予定です。フラグが立てられたノードは人間がレビューします。さらに重要なことは、セキュリティ上の懸念が見つかった場合、そのノードを禁止し、そのノードをインストールしたユーザーに通知することです。このプロセスは時間をかけて改善される予定です。

Q:他に取り組んでいるプロジェクトはありますか?

A:ComfyUIはアプリケーションであり、バックエンドであり、開発者プラットフォームです。私たちはComfyUIを安全で信頼性の高いものにするためにツールに投資しています。私たちは、カスタムノードをホストするリポジトリであるComfy Registryをホストしています。レジストリ上のノードは意味的にバージョン管理され、悪意のある動作がないかスキャンされます。我々はすべてをキャッチすることはできませんが、ノードがカスタムピップホイールを含むかどうか、任意のシステムコールを実行するかどうか、または外部のAPIを呼び出すかどうかのチェックをすぐに追加する予定です。また、Comfyの新しいコミットを様々なオペレーティングシステムやGPU上のワークフローに対してテストする継続的インテグレーションテストスイートもホストしており、Comfyの信頼性を高めています。

Q:コアとなる原則は何ですか?

A:透明性とコミュニケーション。2.オープンソースとコミュニティ主導。3.AIの民主化

Q:基盤モデルについてはどうですか?

A:OSS AIコミュニティにおける最近の混乱にもかかわらず、OSS AIモデルには膨大な進歩があります。私たちはOSSモデルビルダーと密接に協力し、最高のモデルをComfyUIに導入しています。また、将来的にはAIモデルにより多くのリソースを投入する予定です。

Q:どのようにComfyUIに貢献できますか?

A:私たちのdiscord/matrixチャンネルでフィードバックをしたり、参加することができます。バグレポートや機能リクエストの提出にご協力いただける場合は、Githubに課題(Issue)を作成してください。多くの課題には#good-first-issueというタグがつけられています。それ以外の場合は、PRを投稿してください。近い将来、他のOSSプロジェクトと同様のガバナンス構造を導入する予定です。

Q:Comfyの最新情報を得るにはどうしたらいいですか?

A:Twitterでフォローしたり、DiscordやMatrixチャンネルに参加してください。

https://x.com/ComfyUI](https://x.com/ComfyUI

登録して使ってみよう!共有ComfyUIの基本

ここからはComfyUIの導入から使い方の例をご紹介していきます。本記事では、AICUが提供する共有ComfyUIの導入について説明します。

ユーザーごとの推奨環境について

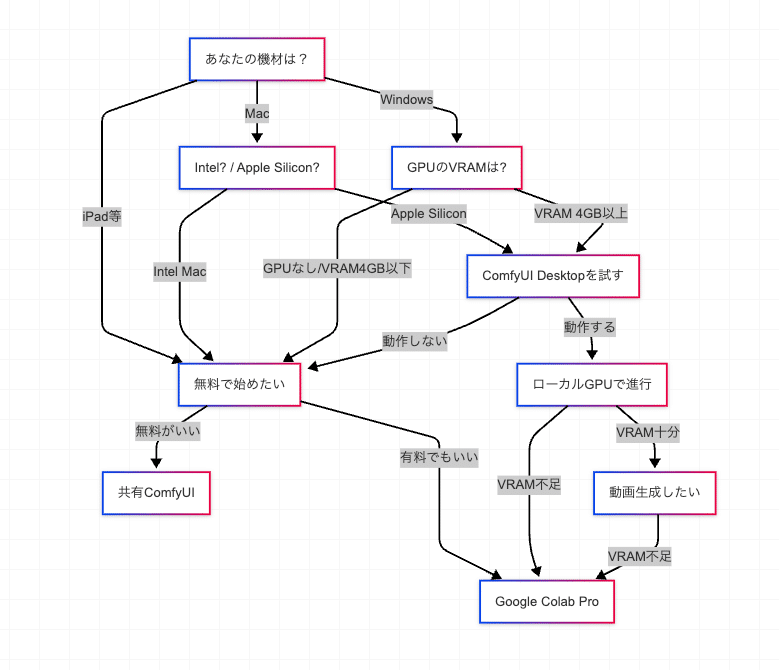

ComfyUIをどのような環境で学習すればよいか、読者の皆さんのお使いの環境や予算、やりたいことにあわせて理解できるようにフローチャートを作ってみました。

お使いの環境がWindowsかMacか、さらにWindowsの場合はGPUに搭載しているVRAM、Macの場合はApple Siliconかどうかによって分岐していきます。多岐に渡り、予算も様々ですが、まずは公式の「ComfyUI Desktop」を試すことで、学習の中心にする環境を定めることができます。

「ComfyUI Desktop」の動作を試す

まず Apple Silicon搭載Mac か Windows11で GPUを4GB以上搭載した環境であれば、ComfyUI公式の「ComfyUI Desktop」を試してみるとよいでしょう。これは、ComfyUIが公式にリリースしたComfyUIを実行するためのデスクトップアプリケーションです。お使いのコンピューター環境で起動できるかどうか、確認してみましょう。

こちらのURLからインストーラをダウンロードできます。

https://www.comfy.org/download

公式マニュアルはこちらです。

インストール方法はこちらに公式動画が用意されています。

(ユーザーインターフェイスなどは変更される可能性があります)

起動すると、環境の診断が行われます。2025年3月現在、サポートされているのはNVIDIA GPUを搭載したWindowsシステムで、AMD GPUはサポートされていません。またMacは Apple Silicon 搭載機種に限定されます。どちらもまだベータ版のため、問題が発生する可能性があります。

試行錯誤を繰り返すことを好まないユーザーの方は、「ポータブル版」を選択することをお勧めします。モデルチェックポイントをインストールする場所はここで設定されます。デフォルトの場合、Mac環境は 「書類/ComfyUI/models」フォルダにインストールされます。

なおAICU編集部では Windows環境は NVIDIA GeForce RTX™ 4050 Laptop GPUの 6GB VRAM, RAM 32GB搭載ノートPC、Mac環境は M4 Mac Book Pro 128GB搭載の環境で確認しています。Windowsの場合はメインメモリは大きい方がいいですが、VRAM容量が重要です。MシリーズのMacの場合はVRAMではなくApple Siliconに搭載されたユニファイドメモリであり、メインメモリ・ビデオメモリの境目が存在しません。またApple Silicon環境はNVIDIA CUDAによる環境と比べて未対応の不具合も多く、M2以降のM3, M4になるにつれて動作速度が劇的に速くなることもありません。初心者向けの手間やコストパフォーマンスを考えるとローカル環境(自分のパソコン)ではじめるならWindows11でNVIDIA GPUがおすすめでしょう。もちろん、Ubuntu LinuxでCUDA対応GPUを搭載した機械学習環境を占有利用できる方はそちらが理想的な環境ではあります。

ComfyUI Desktopが動作したら「Queue」ボタンを押して生成してみましょう。

うまく画像が生成されるようでしたら次の章に進むことができます。

ComfyUI Desktopが動作した場合は、ここから先の設定は続く「共有ComfyUI」や Google Colabでの環境構築と共通になります。この先のステップはスキップしても構いませんが、実用上は「デスクトップでワークフローを探求しながら保存し、大きな処理はクラウドGPU側で実行する」といった並列処理になることが多いので、一度、手を動かして学んでおくことをお勧めします。

「共有ComfyUI」

今回解説するワークフローの多くは、ブラウザのみ・GPU不要で利用できる「共有ComfyUI」にて体験していただくことが可能です。AICU.jpが提供するこのサービスは、本書のような学習目的や、研究や企業における画像生成システム構築のためのプロトタイプとして開発されました。

AICUが提供する共有ComfyUIは、クラウド上で複数ユーザーがComfyUI環境を共有して利用できるサービスです。個人でComfyUI環境を構築する手間を省き、ブラウザから手軽にアクセスできる点が最大の魅力です。2025年2月に「AICU.jp」コミュニティサービスの一部として提供を開始しています。

共有ComfyUIには、以下のような特徴があります。

高性能GPU:高性能GPU(NVIDIA L4 VRAM 24GB)で構築しており、快適な動作を実現しています。

マルチデバイス対応:ブラウザで利用可能なため、Windows、Mac、iPadなど様々なデバイスからアクセス可能です。

メール認証式セキュリティ:ワンタイムパスワード方式で安全に利用できます。

事前設定済み:ComfyUIの立ち上げ待ち時間がほぼゼロです。また、今回提供している各種ワークフローが初期設定済みで、簡単に読み出し可能です。巨大なモデルのダウンロードや、膨大なストレージ容量も必要ありません。ユーザーは、共有ComfyUIにアクセスするだけで、直ぐに快適なComfyUI環境をご利用いただけます。

商用利用可能:共有ComfyUI内で使用しているモデルやカスタムノードは、商用利用可能なものに限定しているため、ここで生成されるものは商用利用可能になります。

コミュニティ:生成している画像は MidJourney等と同じく、他のユーザーから閲覧できる状態にあります。「どんな画像を作っているか」、「どんなワークフローで構築しているか」、といったノウハウを共有できます。また AICU.jp には利用者同士が日本語で質問できるコミュニティやAIエージェント「Will」があります。AICUの共有ComfyUIの開発・運営チームとも距離が近く、クリエイティブAI時代の互助的なヒューマンネットワークが構築できます。

共有ComfyUIは、こんな方におすすめです!

-

ComfyUI初心者で、環境構築方法が分からない方

-

ハイスペックPCを持っておらず、自身のPCでComfyUIを動作させられない方

-

Google ColabなどでのComfyUIの稼働に不満がある方

-

利用料金が不安定な従量課金ではなく、規定の月額費用で使いたい方

-

モデルやカスタムノードの利用の際に、商用利用の可否を考えることが煩わしい方

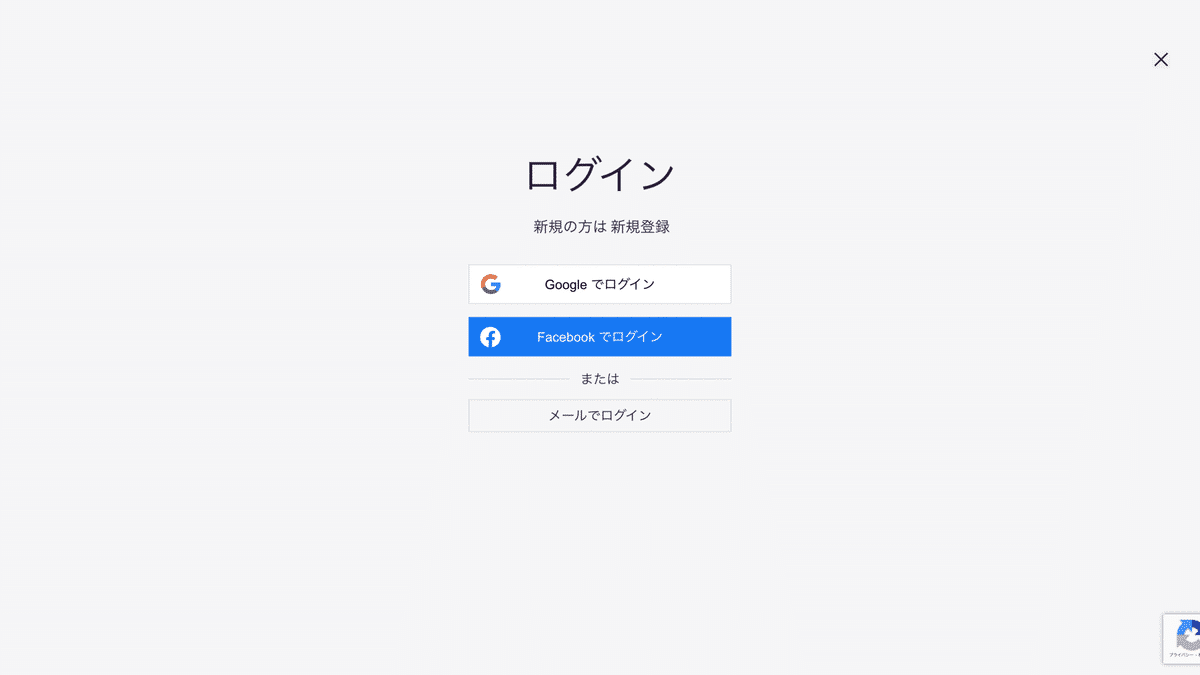

AICU.jpへの会員登録から始めよう

共有ComfyUIを使用するために、AICU.jpへの会員登録をしましょう。まずは、以下のリンクよりAICU.jpにアクセスしてください。

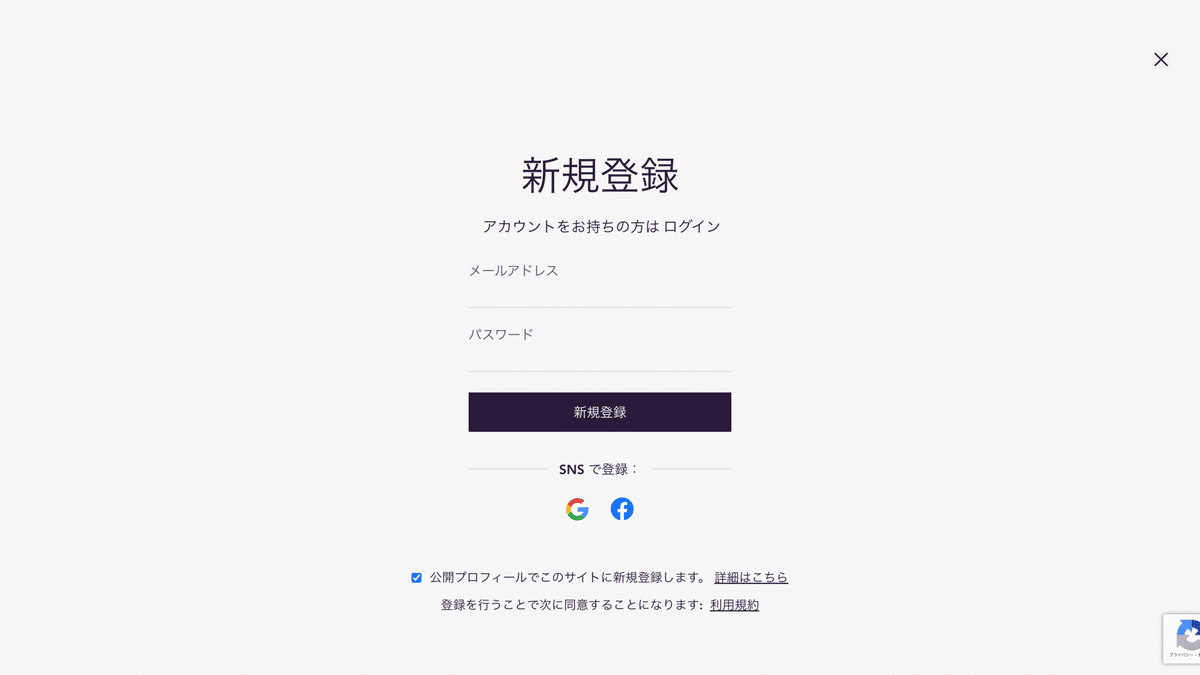

そうすると、ログイン画面が表示されます。ここで「新規登録」をクリックし、登録画面に切り替えます。

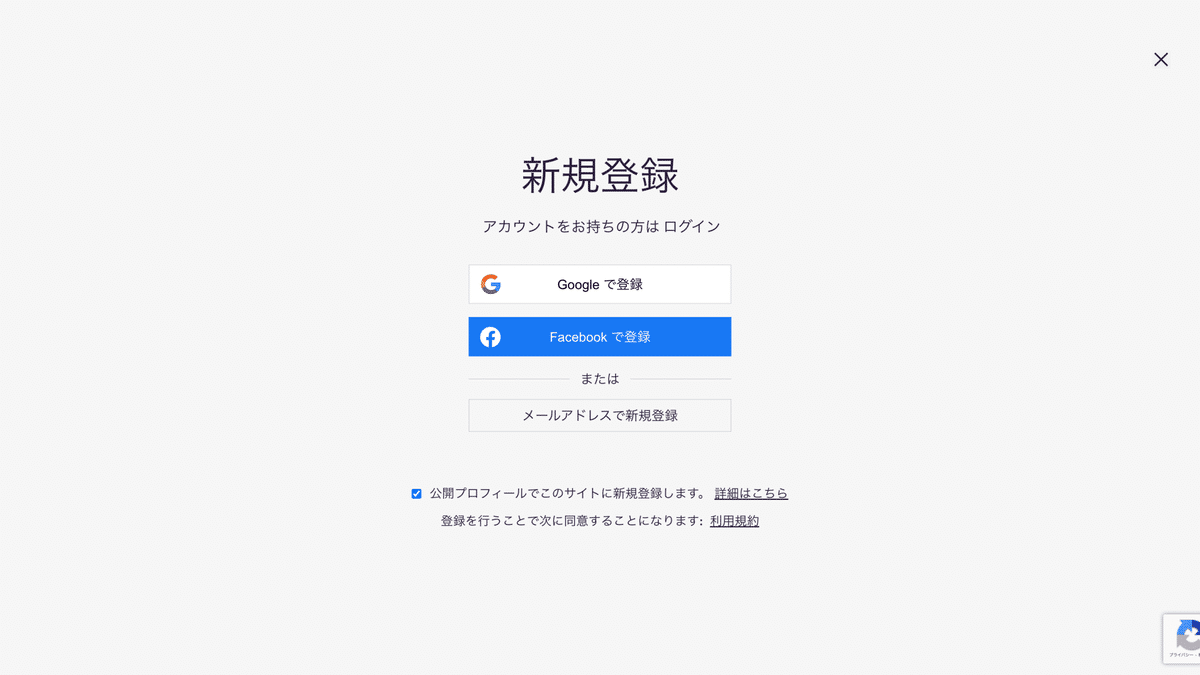

新規登録画面が表示されます。ここでは、GoogleまたはFacebookアカウントでの登録と、メールアドレスからの新規登録を選択できます。

「Googleで登録」をクリックすると、Googleのログイン画面が表示され、そこでログインおよび認証を行うと、新規登録が完了します。

「Facebookで登録」をクリックすると、Facebookのログイン画面が表示され、そこでログインおよび認証を行うと、新規登録が完了します。

「メールアドレスで新規登録」をクリックすると、メールアドレスとパスワードで新規登録可能です。

「メールアドレスで新規登録」をしてみましょう。以下のようにメールアドレスとパスワードの入力画面が表示されます。ここで、登録するメールアドレスとパスワードを入力し、「メールアドレスで新規登録」をクリックします。

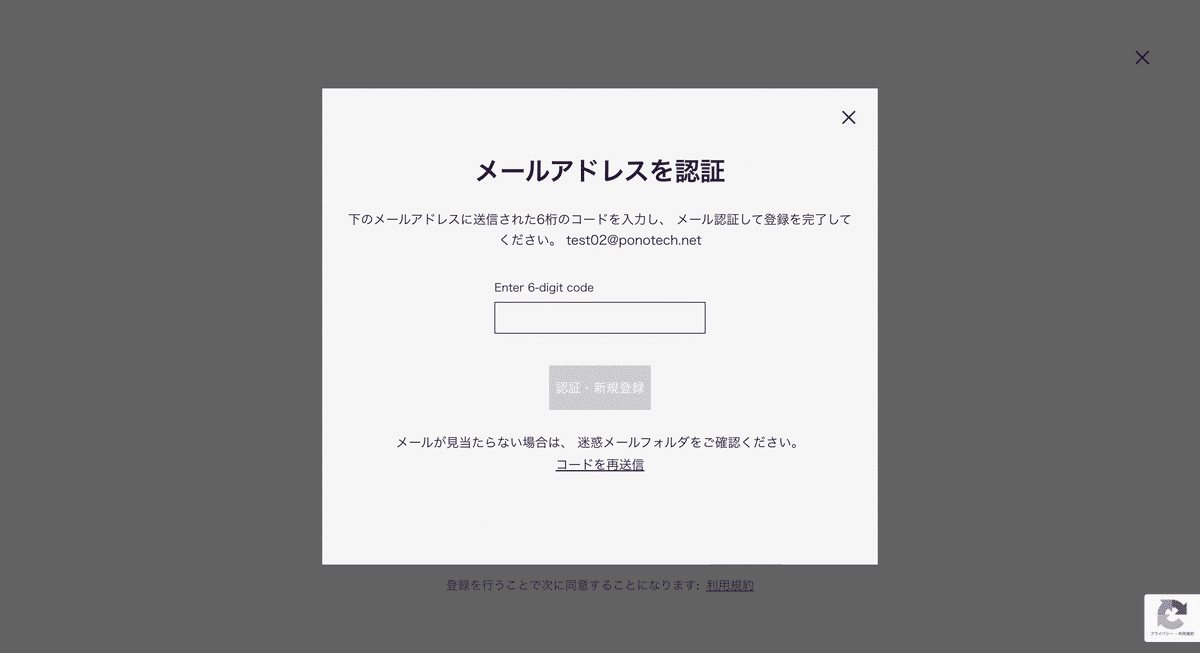

そうすると、メールアドレスの認証画面が表示されます。先ほど入力したメールアドレス宛てに認証コードが送信されているので、そのメールを確認します。

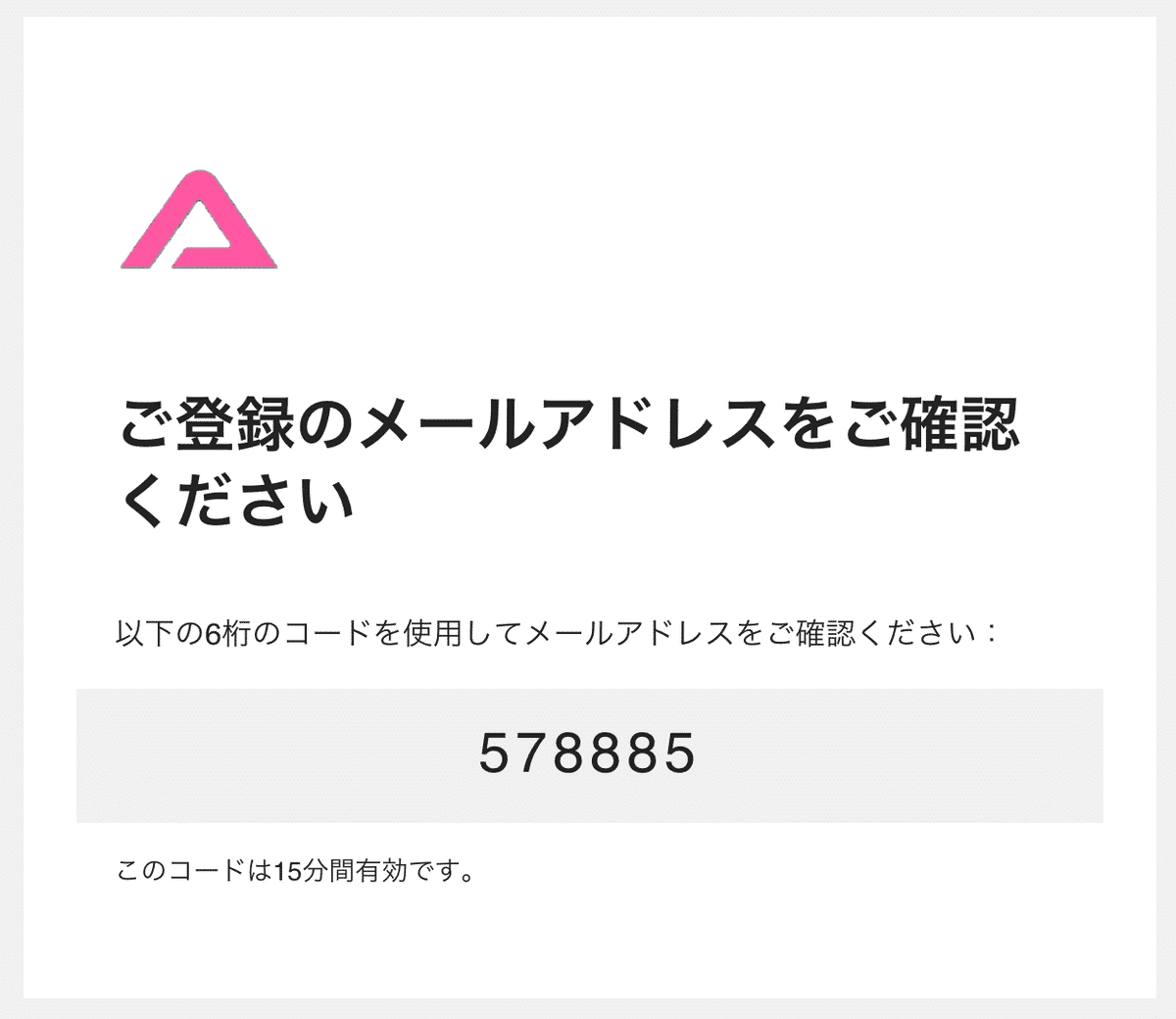

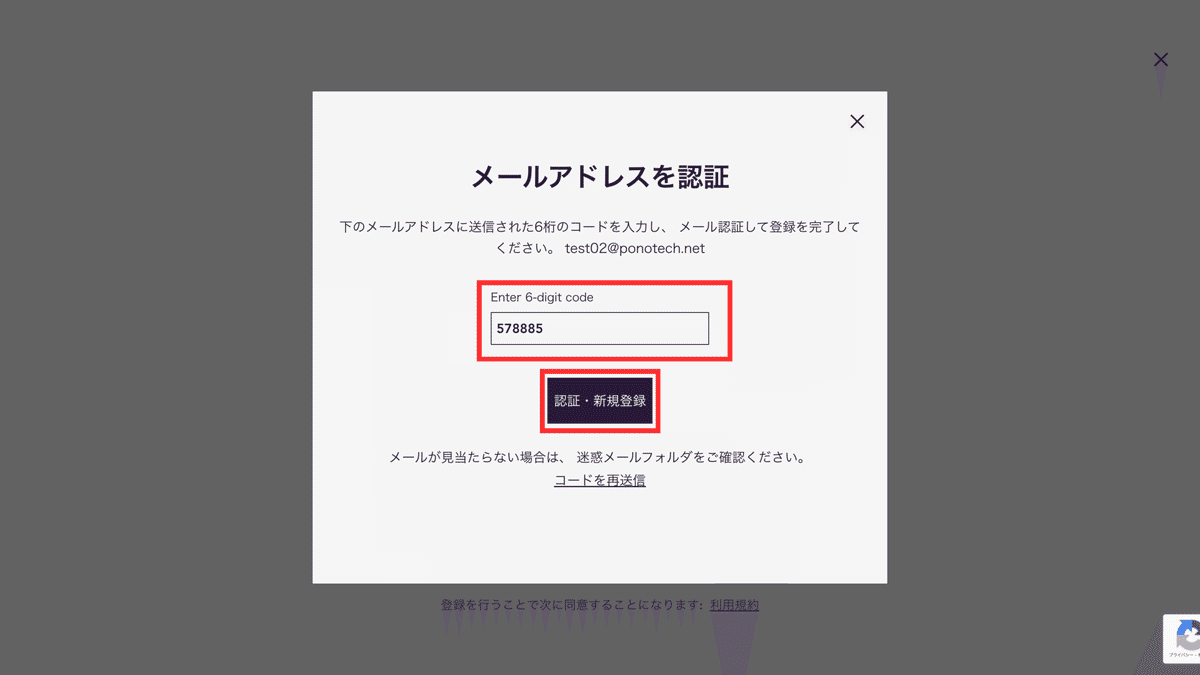

以下のようなメールが届くので、中央に表示されている認証コードを先ほどの画面に入力します。

正しい認証コードを入力すると、「認証・新規登録」ボタンを押せるようになります。入力したら、「認証・新規登録」ボタンをクリックしてください。

登録が完了すると、トップページに戻ります。右上のアイコンの箇所が「ログイン」から登録したメールアドレスに変わり、ログインされていることが確認できます。これでAICU.jpへの会員登録が完了になります。

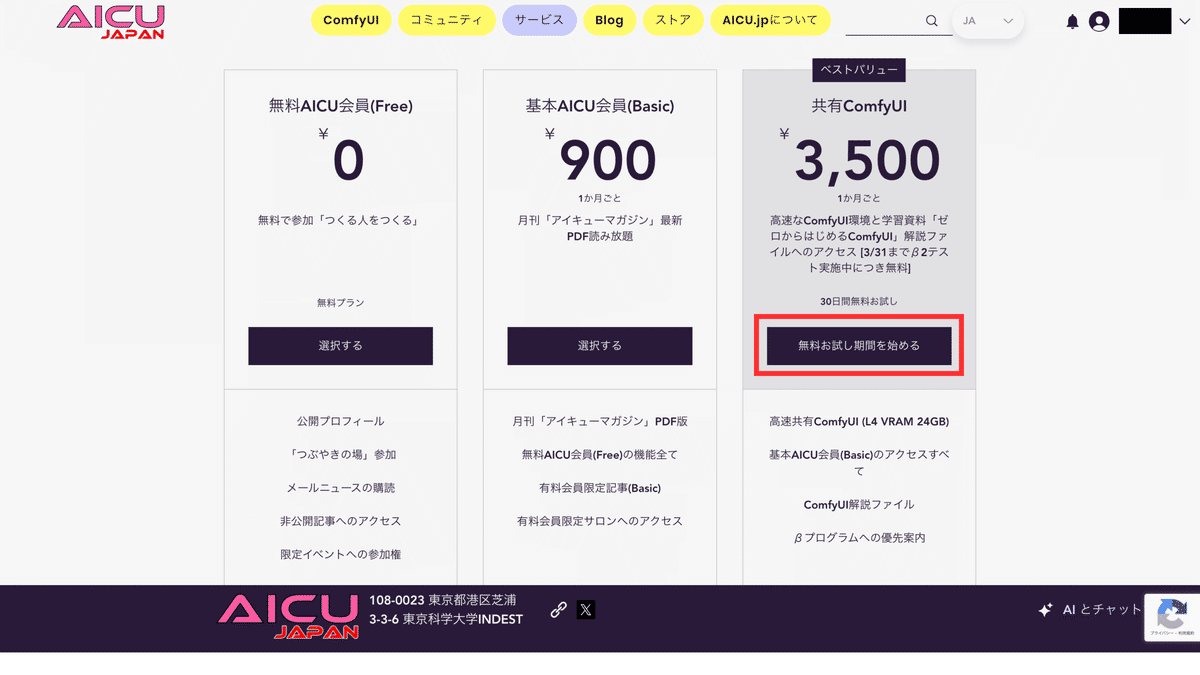

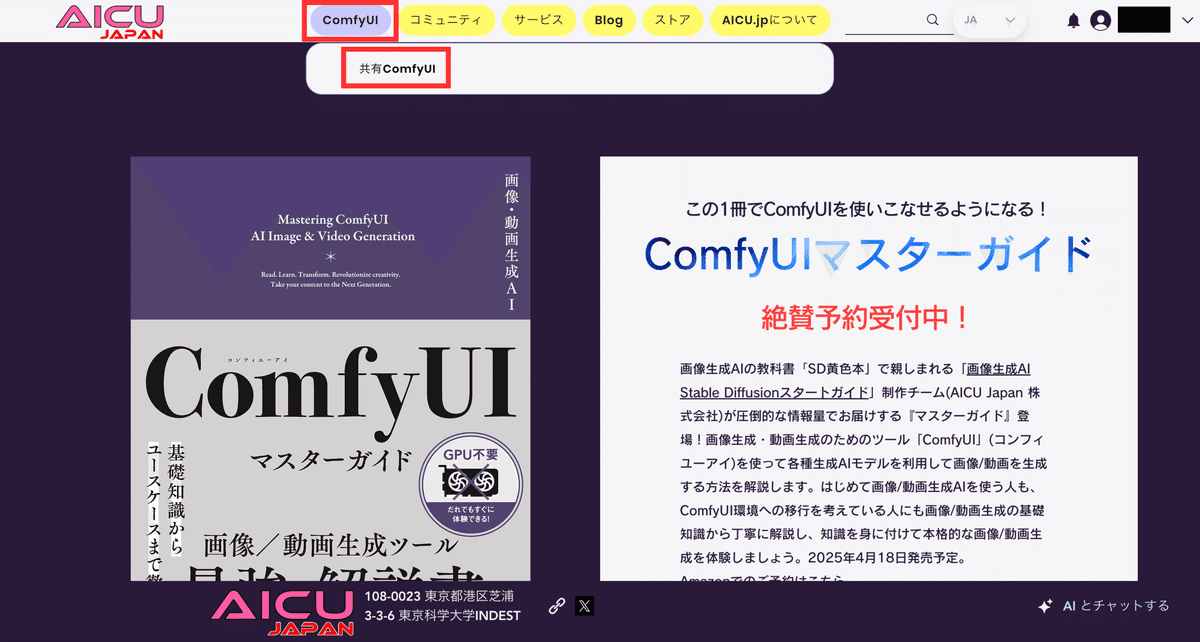

共有ComfyUIプランを購読しよう

会員登録が完了したら、次は「共有ComfyUI」プランを購読しましょう。トップページからメニューの「サービス」を選択します。

ここでは、3つのプランが表示されます。この中で、「共有ComfyUI」プランを購読します。共有ComfyUIプランは、30日間の無料期間が用意されているので、まずはお気軽にお試しください。

それでは、「共有ComfyUI」の「無料お試し期間を始める」をクリックします。

次にお支払い画面が表示されます。ここでクレジットカード情報の入力、プランポリシーへの同意を行い、「無料お試し期間を開始」をクリックしてください。

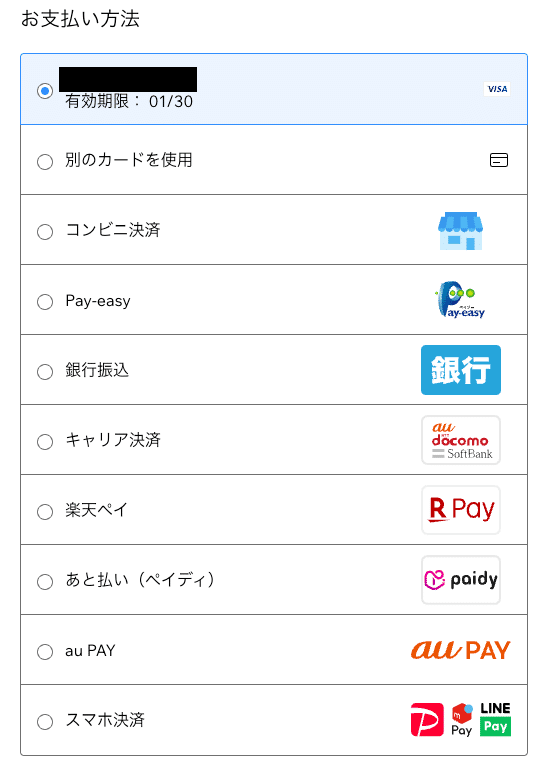

クレジットカードに加えてコンビニ払い、銀行振込、楽天Pay、PayPayなど各種支払いに対応しています(今後変更される可能性があります)。

また読者に向けてクーポンコードを用意しました。

「COMFYSB」

こちらのコードを上記の「クーポンコード入力」で設定することで、最大2回の請求サイクルで3,500円の割引、合計2ヶ月7,000円分が無料で利用可能になります。

(サービスの最新の提供内容につきましては、サイト掲示内容を優先します)

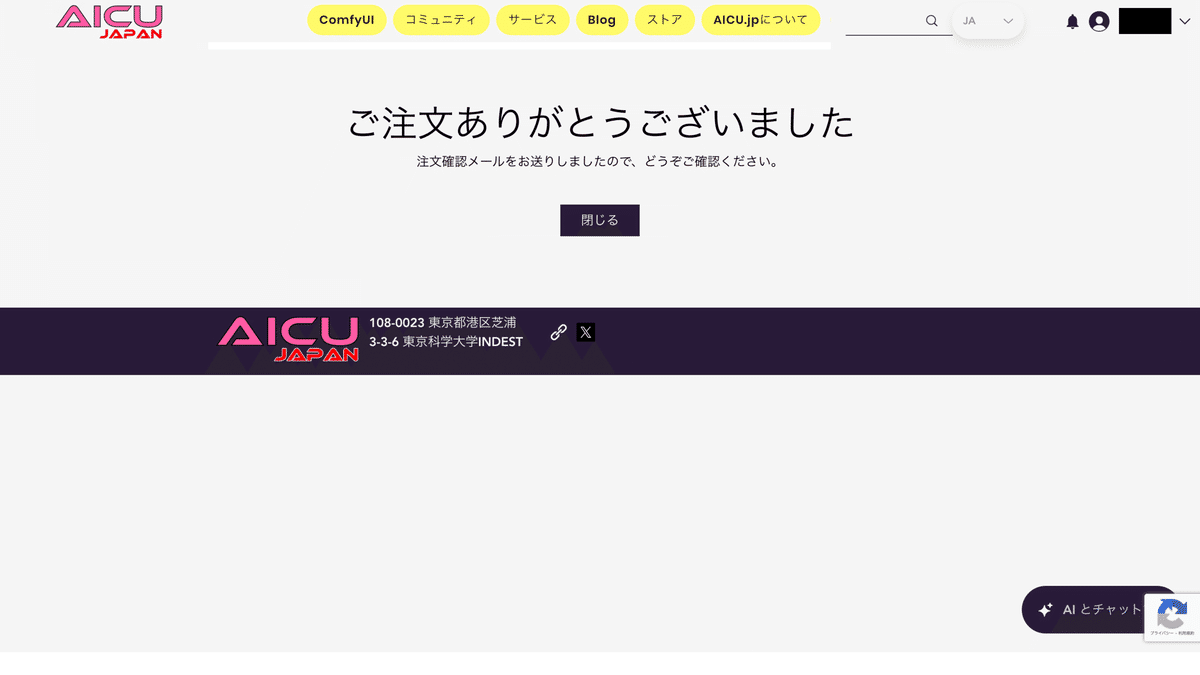

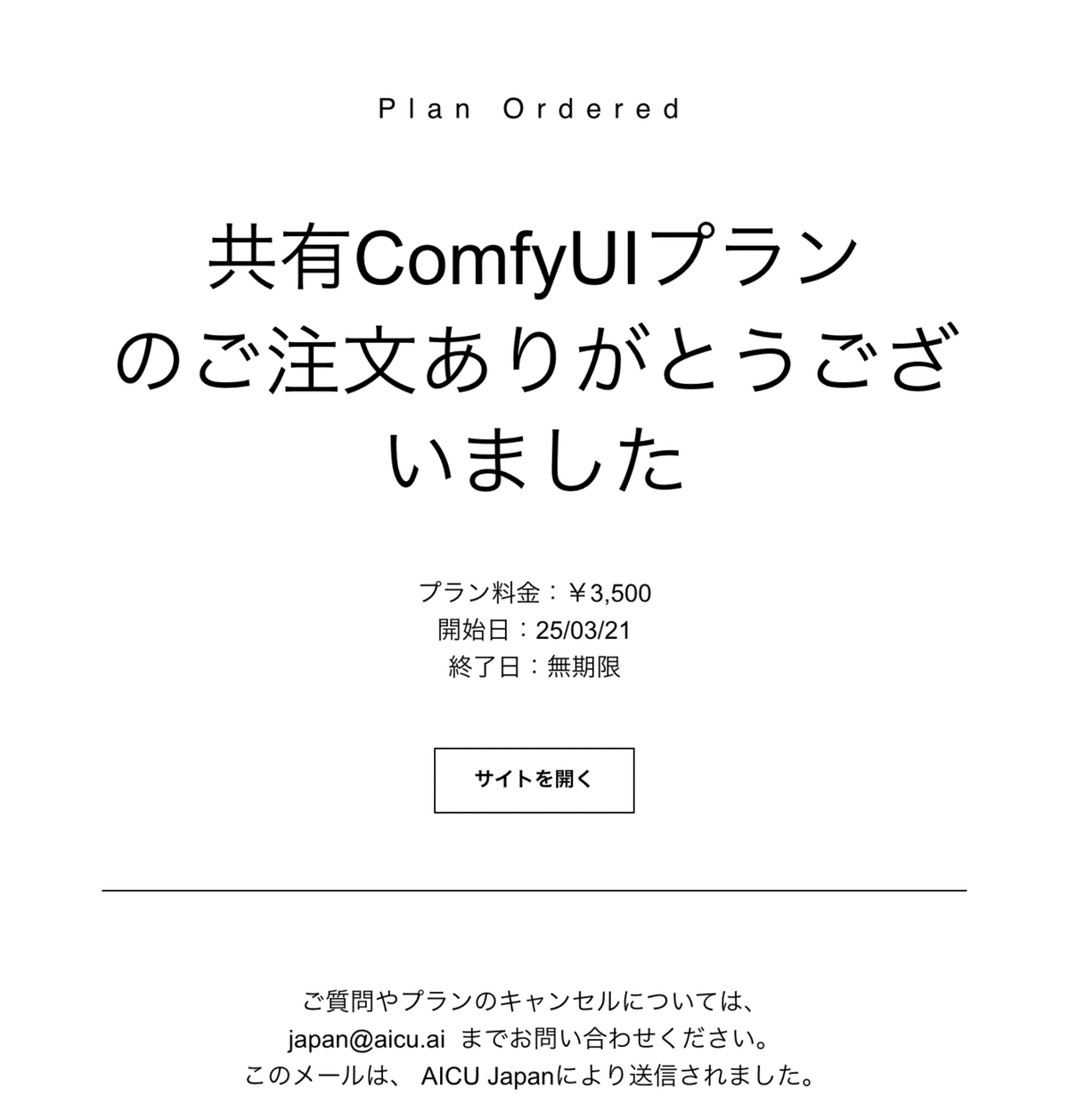

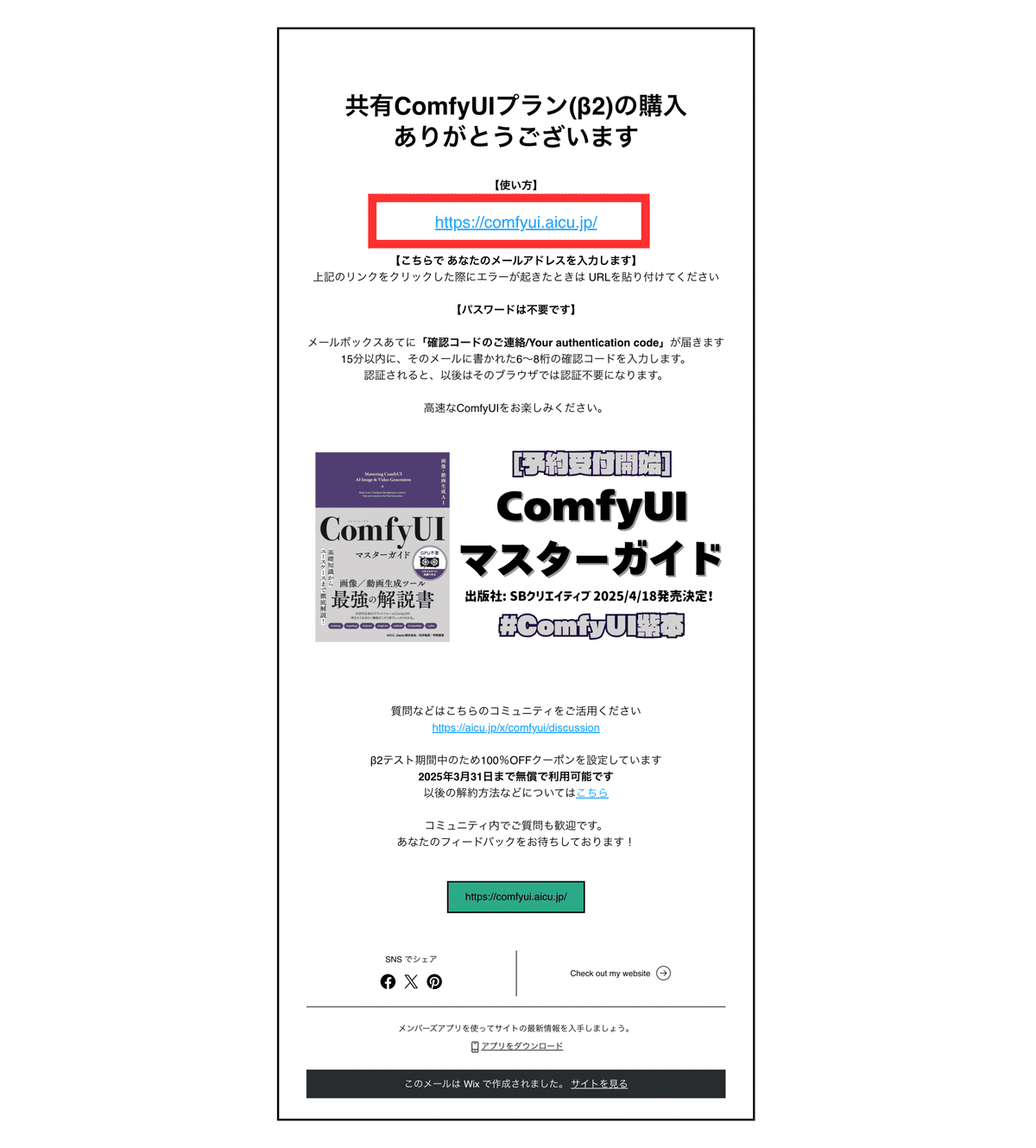

支払い方法の設定が完了すると、以下のページに遷移します。その後、登録されたメールアドレス宛てに複数のメールが届くので、そちらを確認してみましょう。

購読完了通知

まずは、支払い完了通知のメールです。こちらを持って登録完了となります。

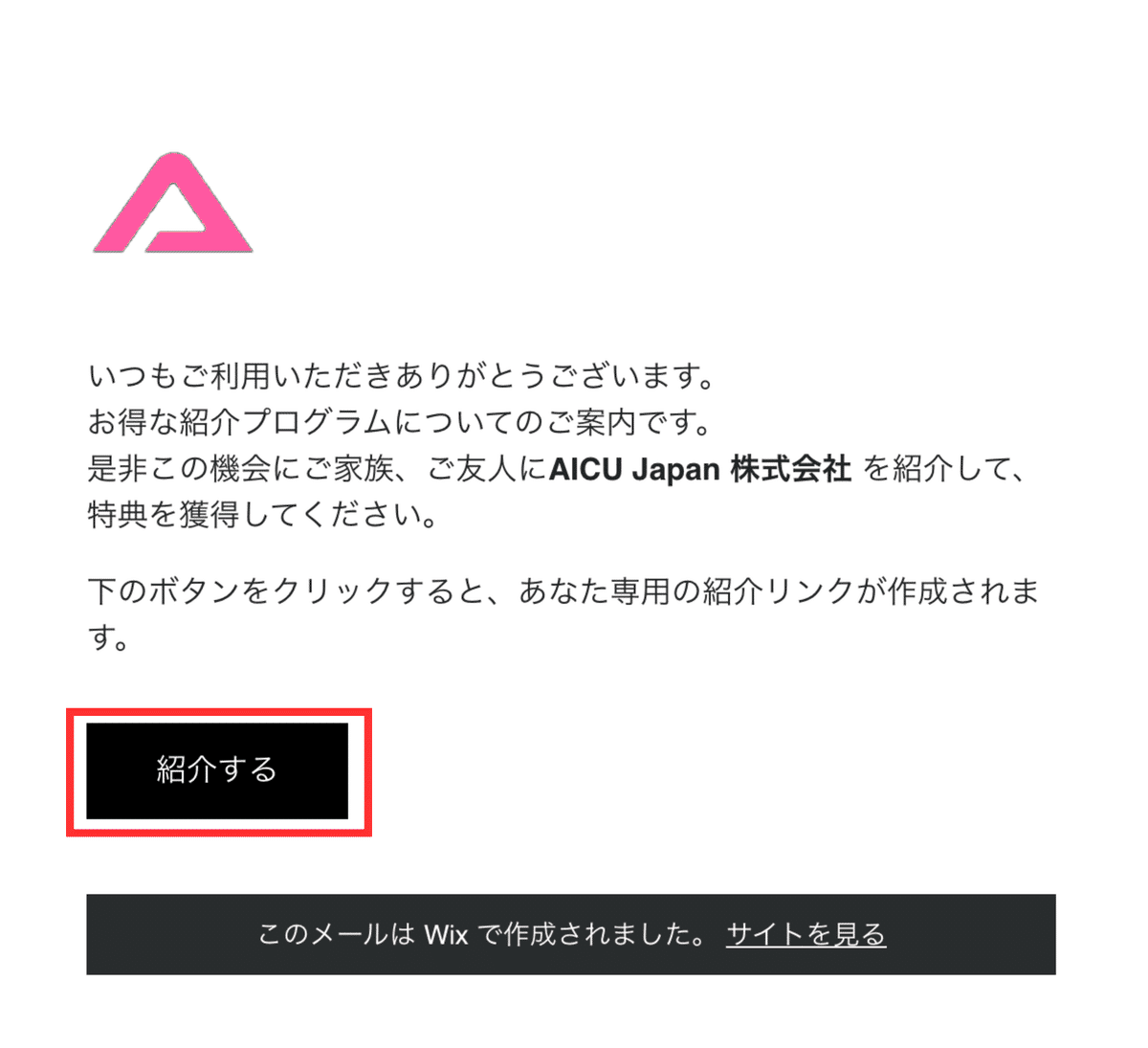

リファラルプログラム

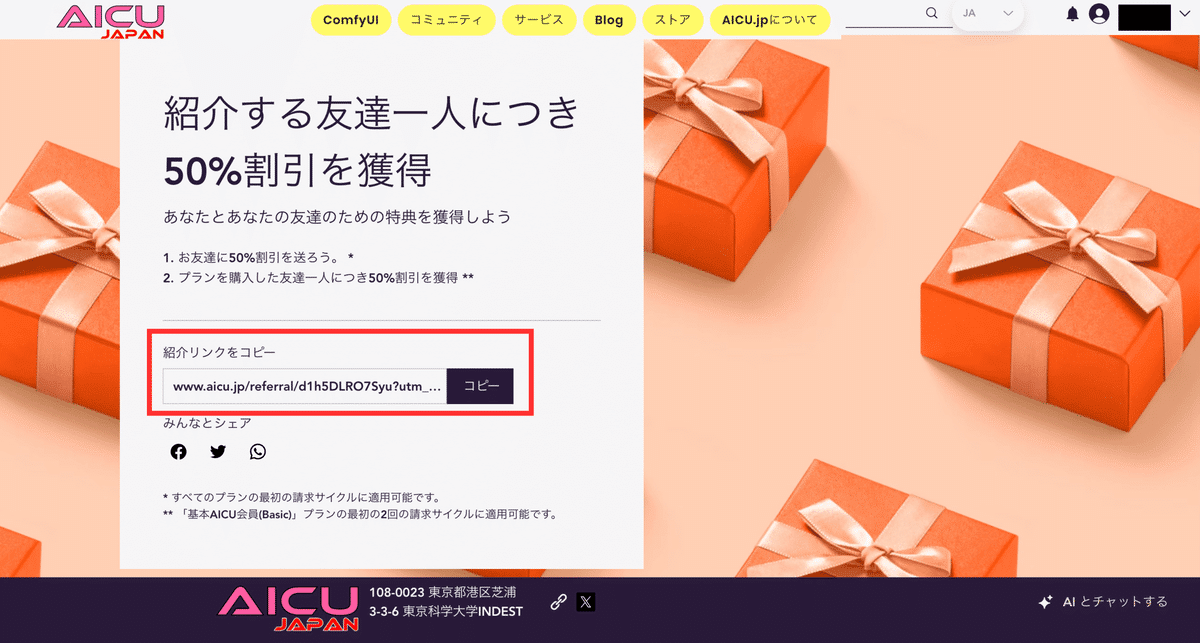

次に、リファラルプログラムのご案内メールです。紹介プログラムに参加するとメールが送られてきます。そこに記載されている「紹介する」をクリックすると、紹介リンク作成ページに遷移します。

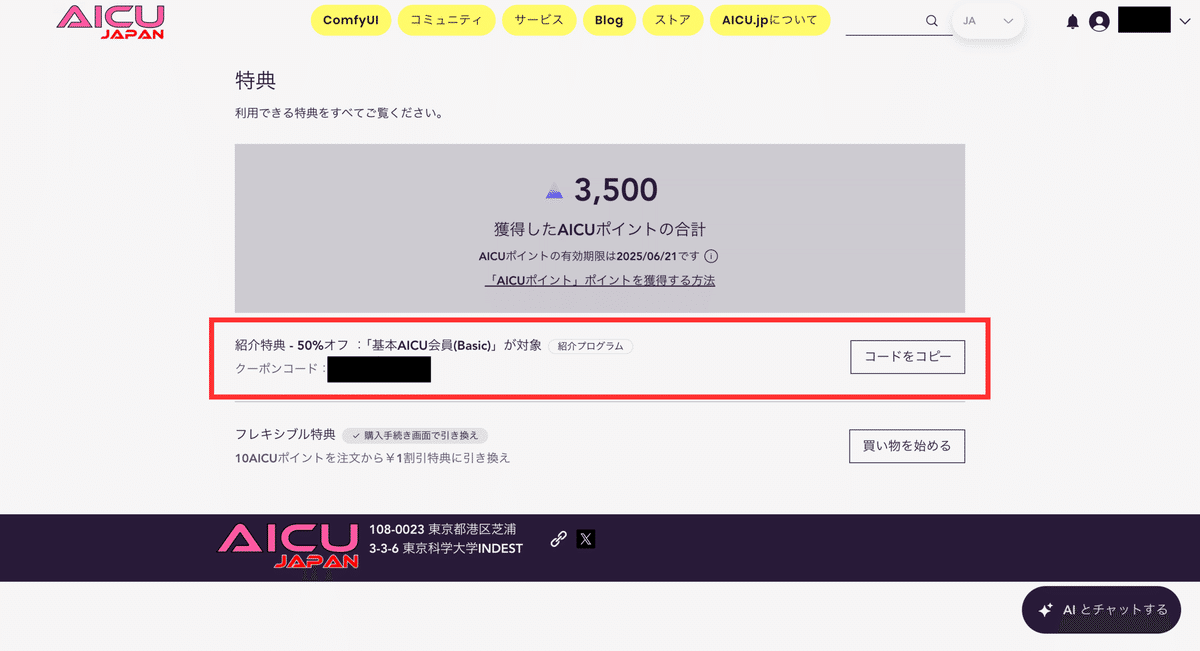

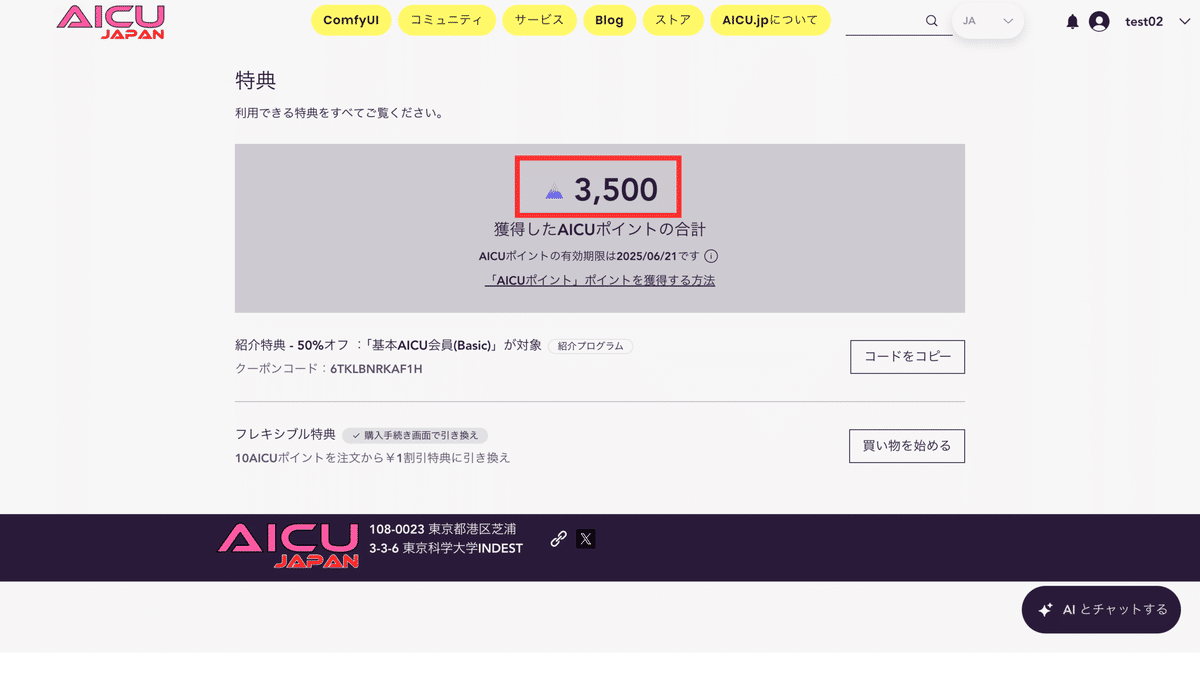

こちらが紹介リンク作成ページです。このページ内にある「紹介リンクをコピー」から紹介リンクをコピーしていただき、それをお知り合いの方にご紹介いただき、その方が会員登録していただくことで、紹介者および被紹介者の方々は50%オフのクーポンコードを取得できます(紹介者は被紹介者がプラン購読したときのみ)。

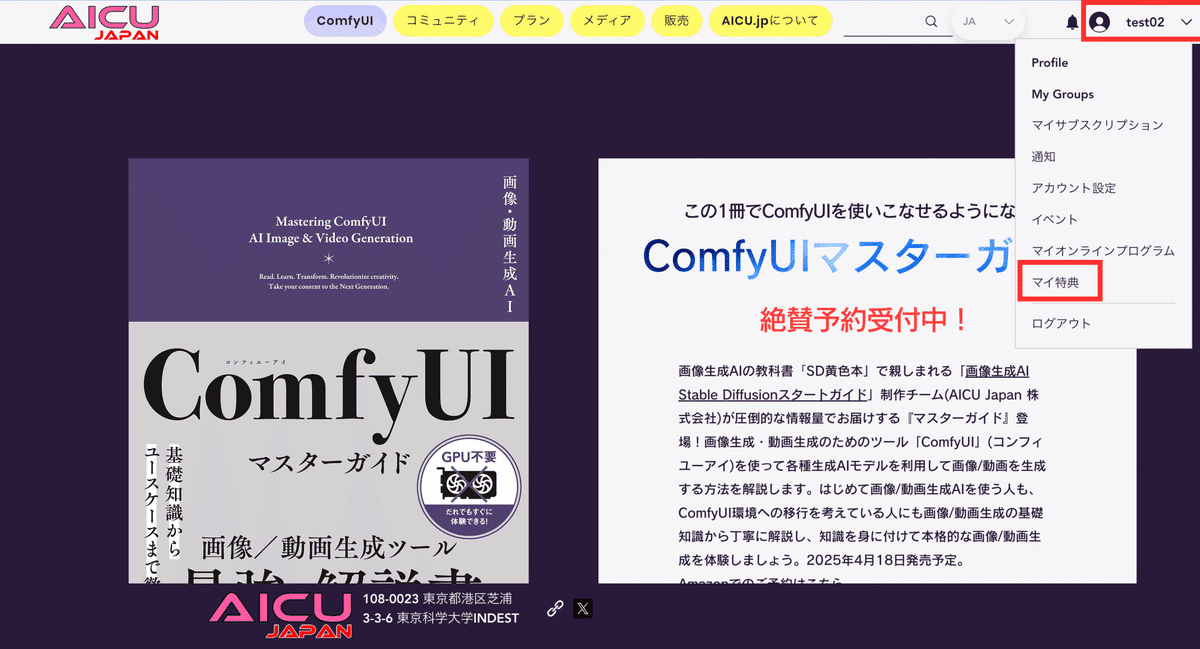

クーポンコードは、「マイ特典」から確認することができます。「マイ特典」は、画面右上のドロップダウンをクリックすると表示されるサブメニューから選択可能です。

以下がマイ特典の画面です。被紹介者の方がプランに購読すると、以下のようにクーポンコードが表示されます。このクーポンコードは、「基本AICU会員(Basic)」プランに適用可能です。「基本AICU会員(Basic)」プランを購読の際は、こちらのクーポンコードを利用することで50%オフになります。

ComfyUIグループへの招待

次は、「ComfyUI」グループへの招待メールについてです。AICU.jpには、コミュニティ機能があり、そこではユーザー同士がディスカッションできる場を設けています。様々なグループがある中で、「ComfyUI」グループは、共有ComfyUIプランに加入している方だけが参加可能なグループで、ここでComfyUIに関するディスカッションが行われます。

以下のようなメールが届きますので、ここで「参加する」ボタンをクリックしてください。

そうすると、ComfyUIグループの画面に遷移します。ここで他のメンバーと交流したり、最新情報を入手したり、画像や動画をシェアすることができます。ぜひ活発に意見交換をしていきましょう。

特典プログラム

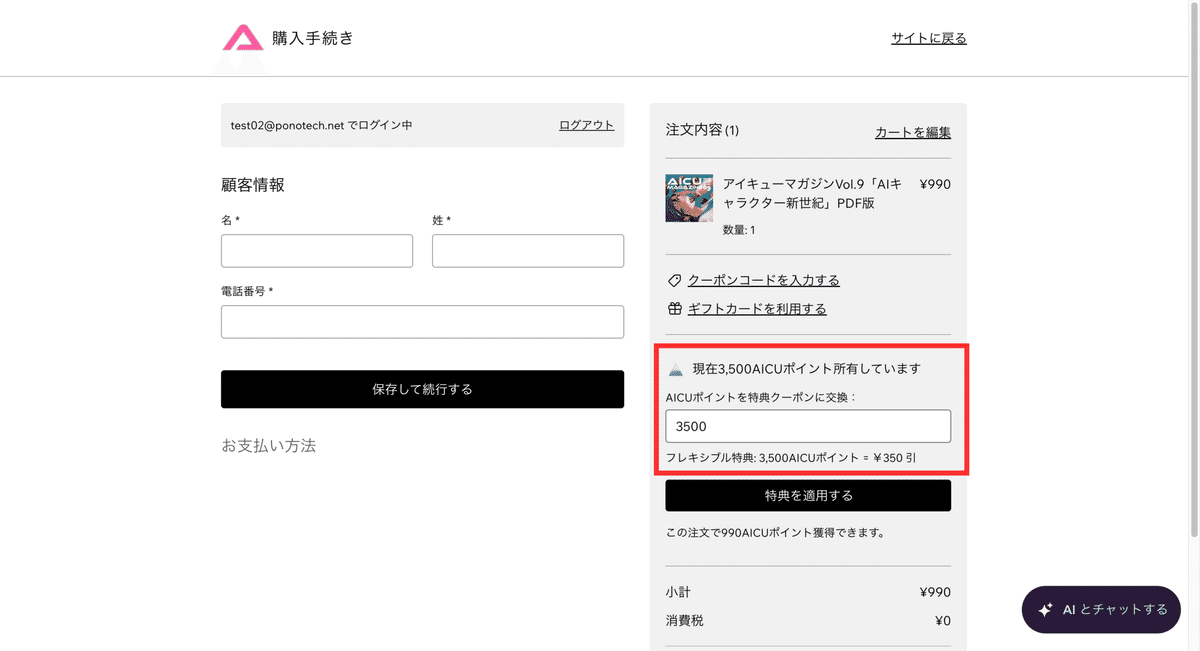

AICU.jpには、ポイントプログラムがあり、各プランに加入することで、AICUポイントを獲得することができます。現在保持しているポイントについては、このメールの「特典を見る」をクリックするか、前述した「マイ特典」ページを開くことで確認することができます。

このポイントは、ストアでマガジンなどの購入時に使用可能です。

共有ComfyUIプランの説明

最後のメールは、共有ComfyUIプランの説明メールになります。共有ComfyUIへのアクセス方法は、次項で説明します。このメールに記載されているアドレス「https://comfyui.aicu.jp/」をクリックすることで、共有ComfyUIにアクセスすることができます。具体的な説明は、次項で行います。

共有ComfyUIにアクセスしよう

それでは、共有ComfyUIにアクセスしてみましょう。共有ComfyUIには、トップページのメニュー「共有ComfyUI」をクリックすることでアクセスできます。

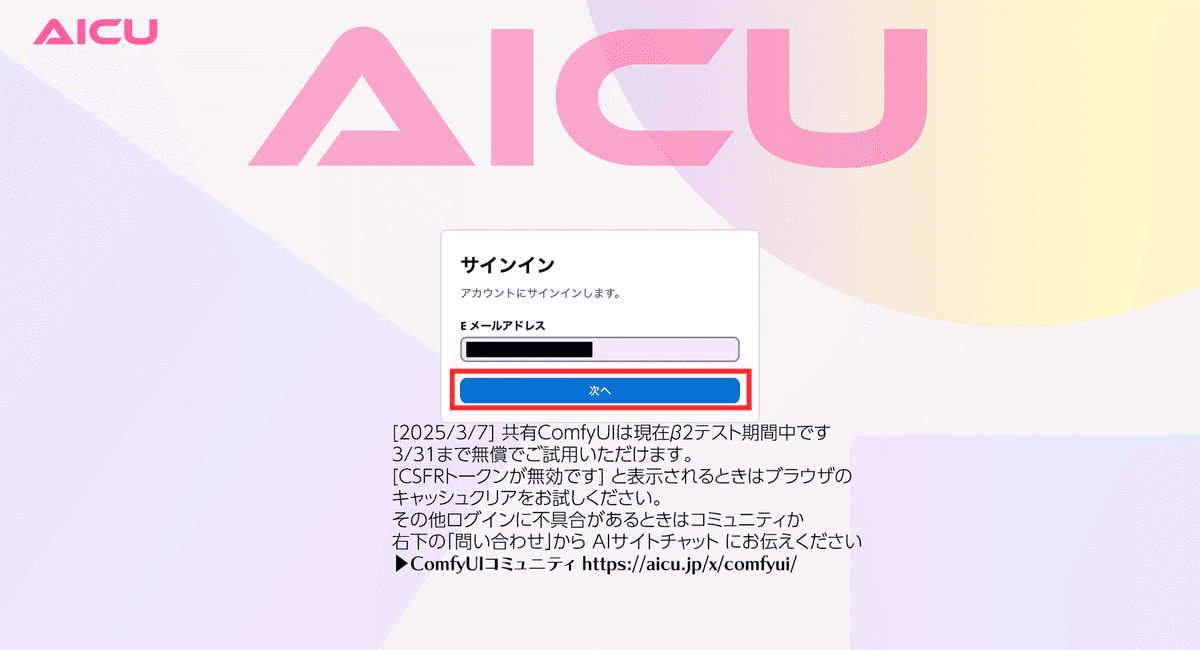

共有ComfyUIにアクセスすると、サインイン画面(ログイン画面)が表示されます。ここで、AICU.jpで登録したメールアドレスを入力し、「次へ」をクリックします。

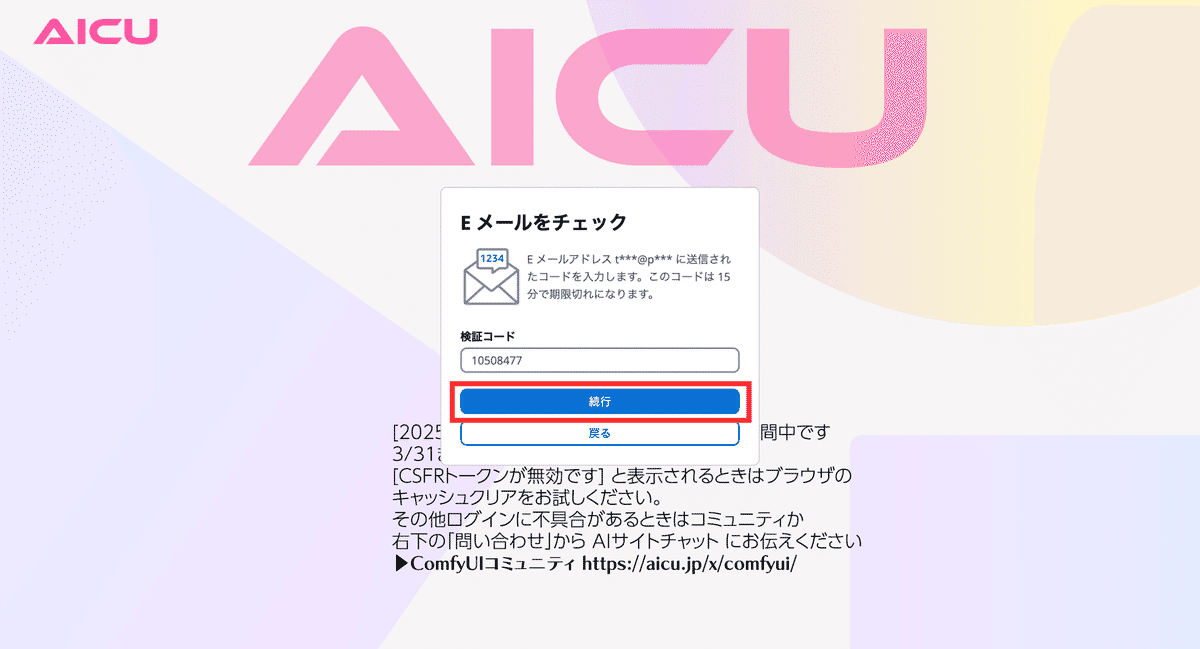

次に検証コードの入力を求められます。先ほど入力したメールアドレス宛に検証コードが記載されたメールが送信されています。メールには、「Your authentication code is xxxxxxxx」と記載されているので、xxxxxxxxの箇所を画面に入力してください。

これでログインが完了し、ComfyUIの画面が表示されます。

ユーザーインターフェースが日本語になっている可能性があります。

ここで動作確認を兼ねて、画面下部の青い「Queue」ボタンを押してみましょう。

実行が完了すると、ブラウザで設定されているダウンロードフォルダに生成された画像がダウンロードされます。今回の場合、以下のような画像が生成されるでしょう。

困った時は?〜トラブルシューティング〜

共有ComfyUIの操作で困ったことがあった時の対処方法を紹介します。

コミュニティで質問する

前述したコミュニティの「ComfyUI」グループでは、ユーザー同士で活発に意見交換が行われています。その中に困ったことが解決できる意見があるかもしれません。また、ここで質問することで、運営から回答することが可能です。また、他ユーザーからの支援を受けられることもあります。

「ComfyUIマスターガイド」サポートサイトを確認する

「ComfyUIマスターガイド」の出版に伴い、この書籍のサポートサイトを用意しています。こちらに頂戴した質問と回答、障害情報を記載するので、こちらを確認していただくことで、疑問点が解消できるでしょう。以下のリンクよりご確認ください。

AIサイトチャット「Will」を利用する

実験中のAIエージェント「Will」とAICU開発チーム・運営チームが皆さんのご質問にお答えします。こちらはプライベートチャットなので他の方々の視線を気にせずにご質問いただけます!

Willには現在のComfyUIマスターガイドの知識に加えて、共有ComfyUIの開発者や運営チーム、AICUがすでに刊行してきた書籍やブログなどのありとあらゆる「生きた知識」が入っています。

時間や回数制限、予期せぬ不具合はあるかもしれませんが、コミュニティの知識に加えて、今後のクリエイティブAI時代の強い味方として楽しんでいただけましたら幸いです。

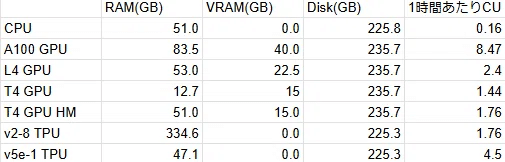

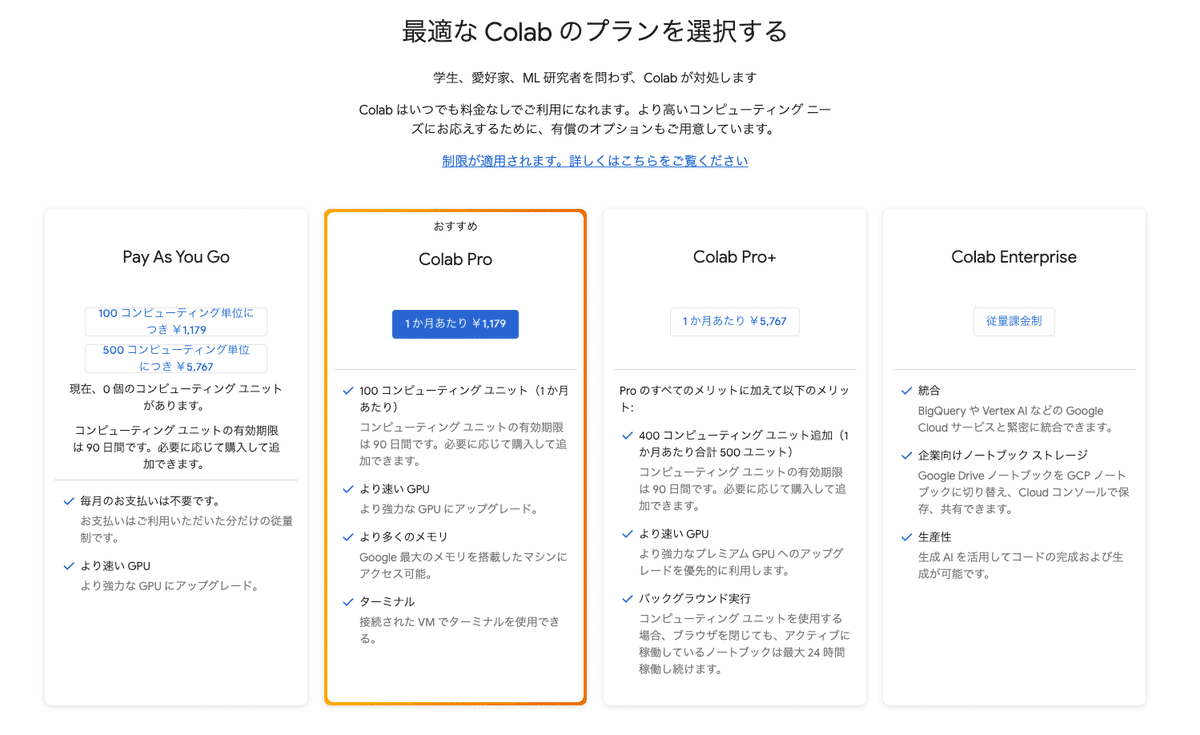

Google Colab環境を利用する

「共有ComfyUI」と並び、本書で動作確認している主な環境が、Google Colabです。

https://colab.research.google.com/

Colab(正式名称「Colaboratory」グーグルコラボレートリー)は、Googleが提供する無料のクラウドベースのPython開発環境です。ブラウザ上で利用でき、機械学習やディープラーニングなどの開発に適しています。環境構築が不要で、Googleアカウントさえあれば、無料でデーターセンター用GPUである「NVIDIA Tesla T4 GPU」が高確率で割り当てられます(保証はありません)。VRAMは15GB搭載されており、ComfyUIでの使用も1セッションのみ、最長12時間利用可能です。この辺りは明確なサービスポリシーなどは表示されていませんので、Google側の運用状況などで、打ち切られる可能性はあると考えましょう。

クレジットカードでの有料払いを許容できるのであれば月額1,072 円($9.99)で高性能 GPUである「Google Colab Pro」のサブスクリプション契約を行うことで、100コンピューティングユニット(CU)が割り当てられ、「NVIDIA L4 GPU」、「NVIDIA A100 Tensor Core GPU」といった高性能GPUを複数セッション、最長 24 時間利用できます。特にA100はVRAMが40GBであり、購入すると330万円ほどする機材なので、普段使いではなく、動画生成やLoRAといった高度な機械学習タスクを実行する場合は選択肢になります。なおサブスクリプション以外にも、CUを購入できる「Pay As You Go」というプランもあります。こちらも 月額1,072 円($9.99)で100CUを追加購入できます。

Google ColabでのComfyUIの使用準備

過去にGoogle Colab無料版でStable Diffusionをはじめとする画像生成AIを動作させるには、Colabの有料プランに加入する必要がありました。無料でComfyUIを使用することはできますが、セッションに制限があることが表示される場合があります。Googleの運営方針は明示されていないので、業務的・継続的に利用する場合は、Colab Proプランに加入することを推奨します。

基本ノートブック

ComfyUIをGoogle Colabで使用するには、ComfyUI ManagerのGitHubページで提供されているGoogle Colabノートブックを利用します。AICUでは環境構築を済ませた日本語解説付き基本ノートブックの提供を行っています。今後はこちらを起点としますのでブックマークしておくことをお勧めします。

<直販ストアでPDFが手に入ります>

https://j.aicu.ai/MagV11s

—

この記事の続きはこちらから https://note.com/aicu/n/n36b65b515668

Originally published at note.com/aicu on Apr 19, 2025.

Comments