2024年11月21日、Black Forest Labsは、ベースのテキスト画像生成モデルFLUX.1に制御性と操作性をもたらすモデルスイート、「FLUX.1 Tools」のリリースすることを発表しました。

「FLUX.1 Tools」リリース概要

オープンアクセスモデルと FLUX.1 [pro]を補完するBFL APIで利用可能な4つの異なる機能で構成されています。

- FLUX.1 Fill: 最先端のインペイントとアウトペイントモデル。テキストとバイナリマスクで現実の画像と生成された画像の編集と拡張を可能に。

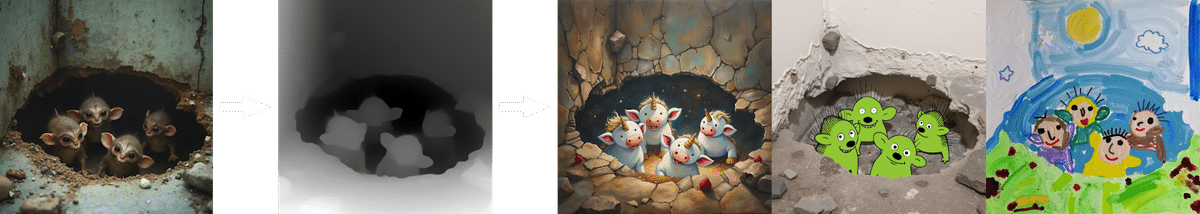

- FLUX.1 Depth: 入力画像から抽出された深度マップとテキストプロンプトに基づいて、構造的ガイダンスを可能にするモデル。

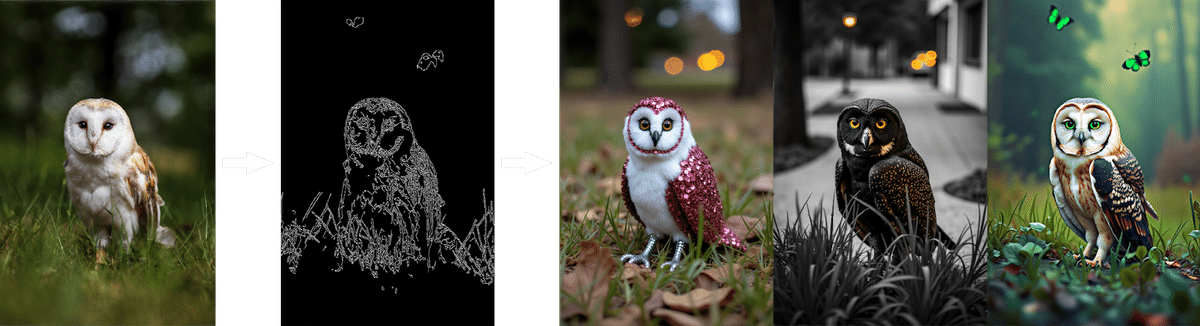

- FLUX.1 Canny: 入力画像から抽出されたキャニーエッジとテキストプロンプトに基づいて、構造的ガイダンスを可能にするモデル。

- FLUX.1 Redux: 入力画像とテキストプロンプトを混合および再作成できるアダプター。

このリリースは、研究コミュニティ向けに最先端のオープンウェイトモデルを提供すると同時に、APIを通じてクラス最高の機能を提供するという、二重のコミットメントを強化する目的とのことで、各ツールは BFL API で FLUX.1 [pro] のバリアント(亜種)としてリリースしつつ、推論コードと重みをガイダンス蒸留されたオープンアクセスFLUX.1 [dev]バリアントとして提供します。さらに、リリースされたモデルは、パートナーの fal.ai, Replicate, Together.ai, Freepik、krea.ai からも入手できます。

以下公式提供の画像より

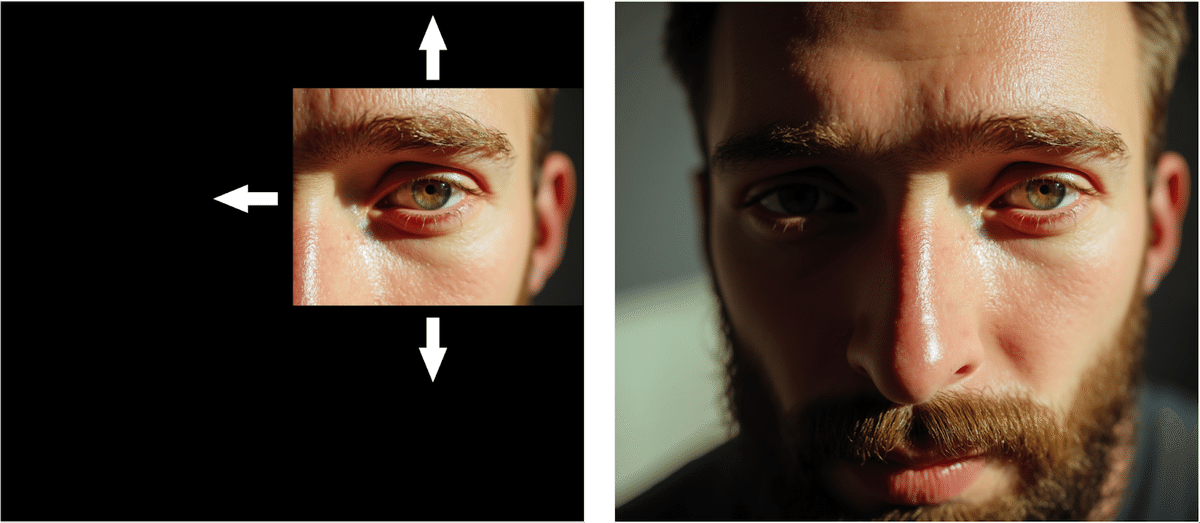

FLUX.1 Fillによるインペイントとアウトペイント

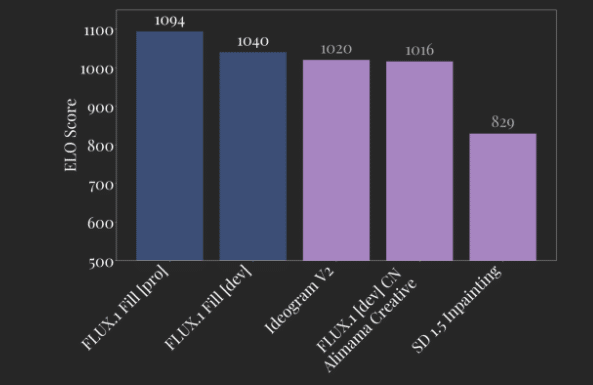

FLUX.1 Fillは、Ideogram 2.0などの既存のツールや、Alimama CreativeのFLUX-Controlnet-Inpaintingなどの人気のあるオープンソースバリアントを凌駕する高度なインペイント機能を導入します。既存の画像と自然に統合されるシームレスな編集が可能です。

さらに、FLUX.1 Fillはアウトペイントをサポートしており、ユーザーは元の境界を超えて画像を拡張できます。

[ベンチマークへのリンク]を実施した結果、Flux.1 Fill [pro]は他のすべての競合方法よりも優れており、現在までの最先端のインペイントモデルとなっています。2番目はFlux.1 Fill [dev]で、独自のソリューションよりも優れており、推論の効率も高くなっています。

Flux.1 Fill [dev]はFlux Dev Licenseの下で利用可能です。

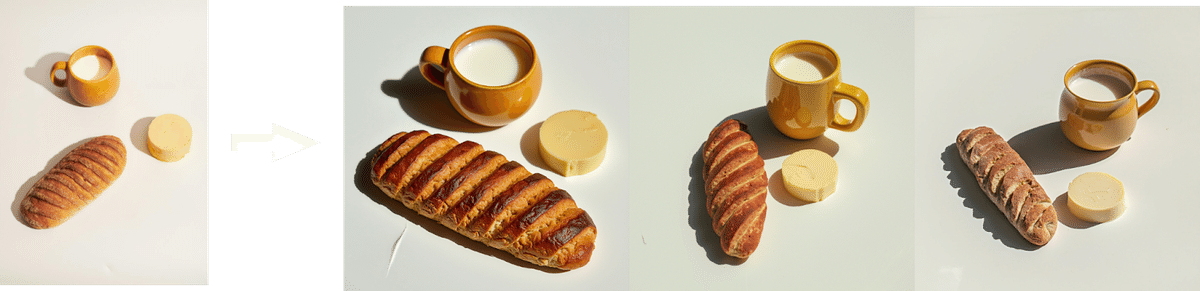

FLUX.1 Canny / Depthによる構造的コンディショニング

構造的コンディショニングは、キャニーエッジまたは深度検出を使用して、画像変換中の正確な制御を維持します。エッジまたは深度マップを通じて元の画像の構造を保持することにより、ユーザーはコアとなる構成をそのまま維持しながら、テキストガイド付きの編集を行うことができます。これは、画像のテクスチャ変更に特に効果的です。

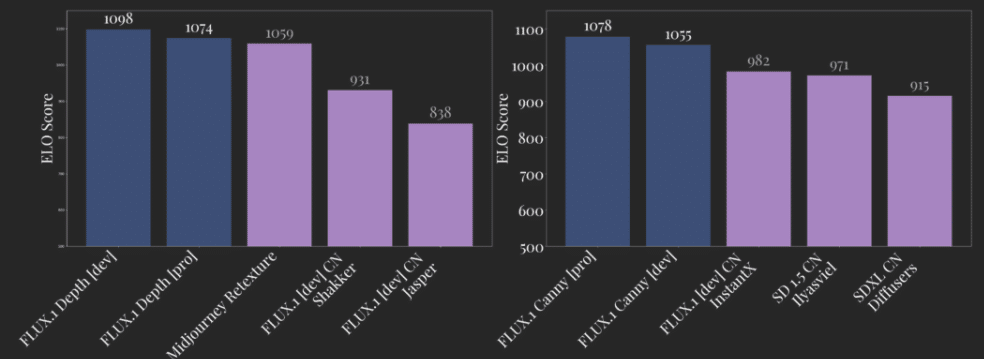

[ベンチマークへのリンク]の評価では、FLUX.1 DepthはMidjourney ReTextureなどの独自モデルよりも優れています。特に、FLUX.1 Depth [pro]はより高い出力多様性を提供し、FLUX.1 DepthのDevバージョンは深度認識タスクでより一貫した結果を提供します。キャニーエッジモデルの場合、[ベンチマークへのリンク]はこちらで、FLUX.1 Canny [pro]がクラス最高で、FLUX.1 Canny [dev]がそれに続きます。

FLUX.1 Canny / Depthは、最大限のパフォーマンスのためのフルモデルと、開発を容易にするためのFLUX.1 [dev]に基づくLoRAバージョンの2つのバージョンで利用可能です。

Flux Depth / Canny [dev]はFlux Dev Licenseの下で利用可能です。

- Hugging Faceで入手可能な完全なモデルの重み:[Depth] [Canny]

- Hugging Faceで入手可能なLoRAの重み: [Depth] [Canny]

- GitHubで入手可能な推論コード: GitHub

- Flux.1 Depth / Canny [pro]はBFL APIで利用可能です。BFL API

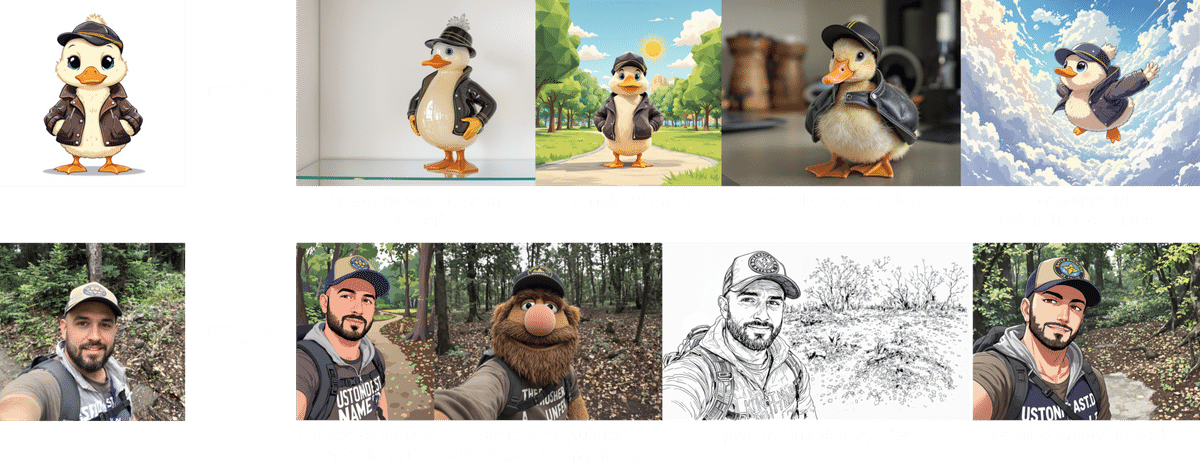

FLUX.1 Reduxによる画像のバリエーションとリスタイリング

FLUX.1 Reduxは、画像バリエーション生成のためのすべてのFLUX.1ベースモデルに対応するアダプターです。入力画像が与えられると、FLUX.1 Reduxはわずかなバリエーションで画像を再現し、特定の画像を改良できます。

これは、プロンプトによる画像のリスタイリングを可能にする、より複雑なワークフローに自然に統合されます。リスタイリングは、画像とプロンプトを提供することにより、APIを通じて利用できます。この機能は最新のモデルFLUX1.1 [pro] Ultraでサポートされており、入力画像とテキストプロンプトを組み合わせて、柔軟なアスペクト比で高品質の4メガピクセル出力を生成できます。

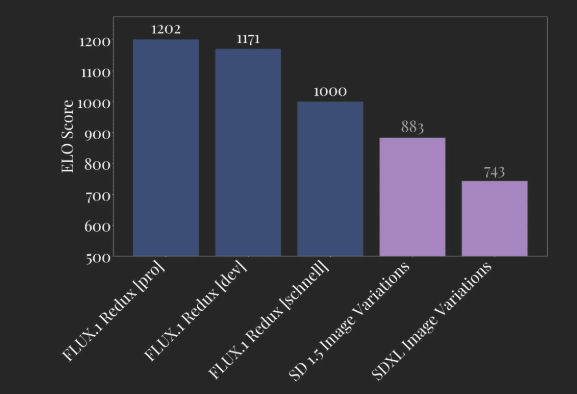

[ベンチマークへのリンク]は、FLUX.1 Reduxが画像バリエーションにおいて最先端のパフォーマンスを達成していることを示しています。

Flux.1 Redux [dev]はFlux Dev Licenseの下で利用可能です。

- Hugging Faceで入手可能なモデルの重み: [Redux]

- GitHubで入手可能な推論コード: GitHub

- FLUX1.1 [pro] UltraをサポートするFlux.1 Reduxは BFL APIで利用可能です。

有料APIは[api.bfl.ml]で提供されています。

ドキュメントはこちら https://docs.bfl.ml/

Falでの環境を確認!異次元の高画質を自在に操る新機能4つを試してみた

ここから先はAICU編集部による”自腹調査”です。

Falでは既にリリースされていました。

こちらの検索結果に表示されています。

https://fal.ai/models?keywords=flux&categories=image-to-image

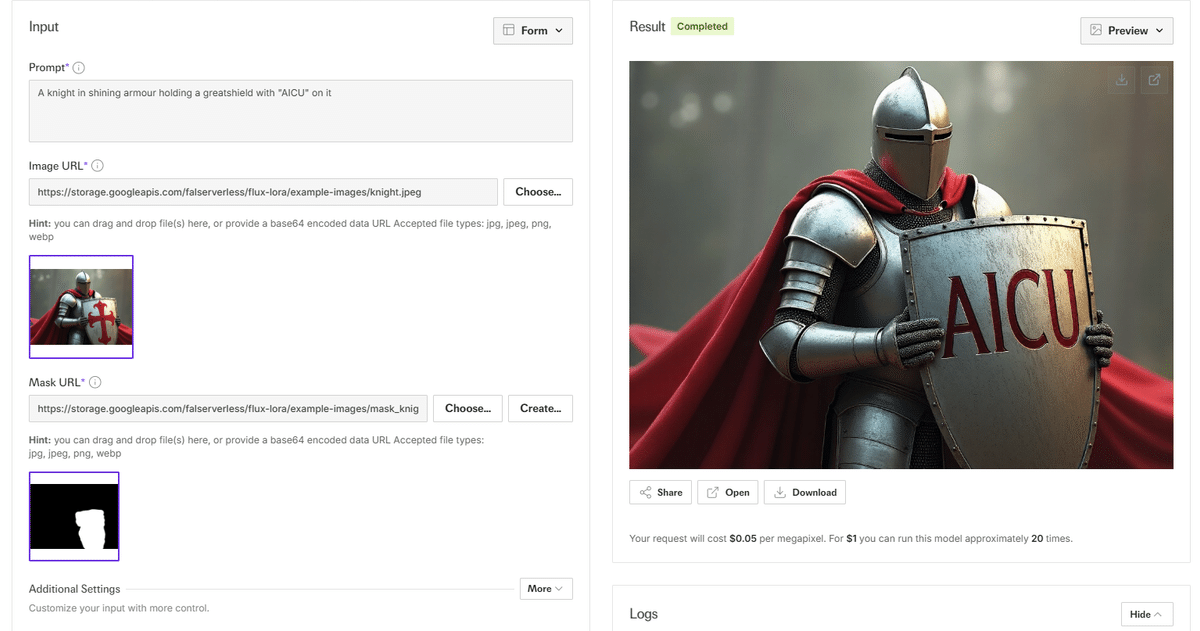

Fill: 強力なインペイント機能

https://fal.ai/models/fal-ai/flux-pro/v1/fill

ベースの画像がこちらです。

与えるマスク画像がこちらです。盾をざっくり塗った感じです。

以下のプロンプトを投じてみます。

A knight in shining armour holding a greatshield with “AICU” on it

できました!

コストは1メガピクセルあたり0.05ドルだそうです。

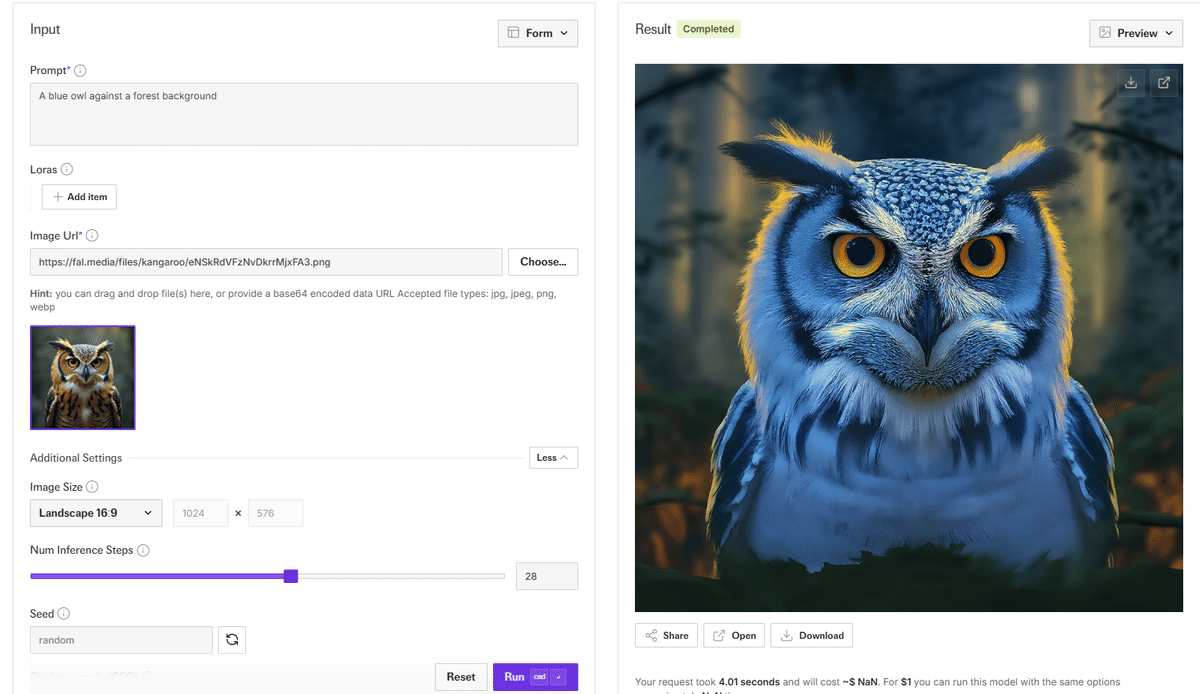

Canny: 高度な置き換え機能

サンプル「Flux-lora-canny」ではフクロウをピンクに塗り替えています。

https://fal.ai/models/fal-ai/flux-lora-canny

サンプル「Flux-pro-canny」ではFLUX.1 [pro]を使ったCannyが体験できます。

https://fal.ai/models/fal-ai/flux-pro/v1/canny

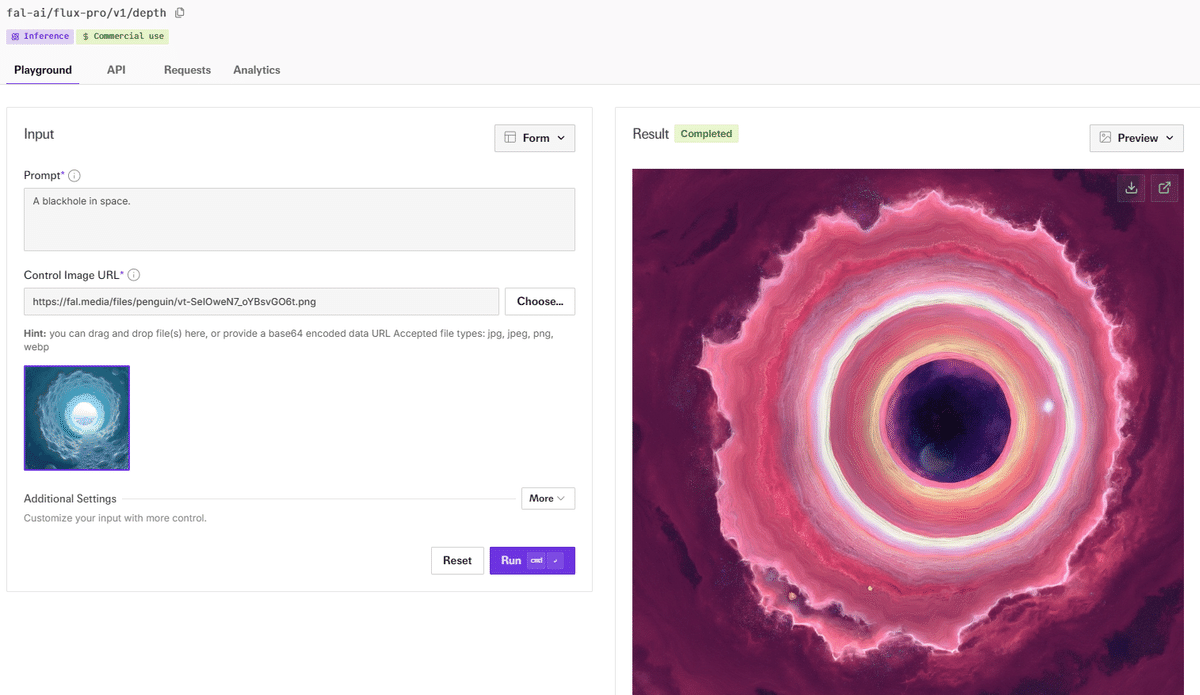

Depth

サンプルが何故かブラックホールの奥行き、という謎の画像なので開設を割愛します。

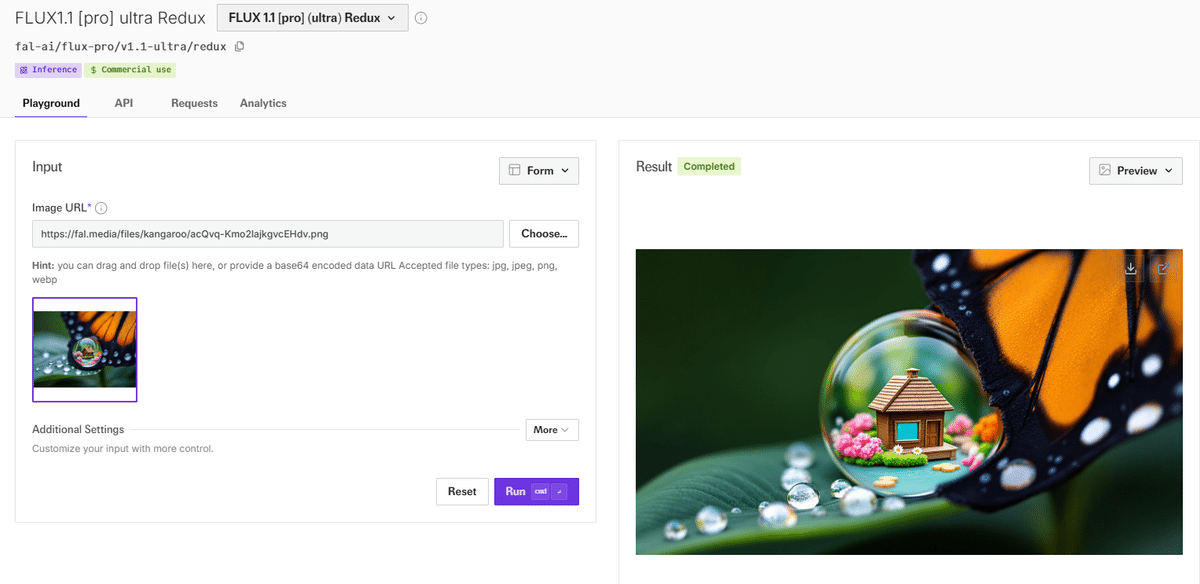

Redux

Flux[pro] ultra Redux https://fal.ai/models/fal-ai/flux-pro/v1.1-ultra/redux

入力画像とプロンプトを使って、もとのスタイルに近い画像を生成できるようです。

出力結果です。

制御性はあまり良くない印象ですが、画質は素晴らしいので使い道を考えて生きたいところですね。

ComfyUIがゼロデイ対応

「FLUX.1 Tools」が、ComfyUI で初日からサポートされるようになりました。

– FLUX.1 塗りつぶし – >画像の塗りつぶしや拡大に最適

– FLUX.1 Redux – >イメージの異なるバージョンを作成する

– コントロールネット – >キャニーガイドまたは深度ガイドを使用して画像を制御する

サンプル画像としてわかりやすいのでこちらのポストをぜひご確認ください。

https://twitter.com/ComfyUI/status/1859616046623359077

https://twitter.com/ComfyUI/status/1859616048108142753

https://twitter.com/ComfyUI/status/1859616050259820638

編集部の印象

Stability AI の API群とも近い感じですが、リリース直後からFalやReplicate、ComfyUIなどで利用できるのは流石ですね!

また商用利用できる点も良いですね。

FLUX1[pro]自体の画質は過学習気味な印象があります。

Alimama Creative の例では商用IPに類似した出力が示されていますが、Image-to-Imageに商用IPを使うのは日本の著作権法を侵害する可能性が非常に高いので、技術的にできるという点と、倫理的にやっていいか、という視点は並列に持っておくほうが良さそうですね。

いずれにせよ今回の「FLUX.1 Tools」はモデルとAPIだけでシンプルに制御できるので、サービスを開発するには役立ちそうです。Staility AI 3.5系の熾烈な戦いが始まりますね。

[PR] 基本を学びたいひとはこちら!

Originally published at https://note.com on Nov 21, 2024.

Comments