「高解像度の美しい画像を生成したいけど、高解像度で生成すると画像が崩れる...」

そんな悩みを抱えているクリエイターは多いのではないでしょうか?その悩みを解決しましょう!

こんにちわ、AICU media編集部です。

2025年もよろしくお願いいたします。

「ComfyUI マスターガイド」第41回目になります。

本記事では、冒頭に挙げた課題を解決する手法として、ComfyUIのTiled DiffusionとControlNetを組み合わせたワークフローをご紹介します。

本記事では、ComfyUIを使用して高解像度の画像生成を行うための、Tiled DiffusionとControlNetを組み合わせたワークフローについて解説します。このワークフローでは、RealVisXL V5.0 Lightningモデルとcontrolnet-union-sdxl-1.0を使用し、GPUメモリの使用を効率化しながら、高品質な画像のアップスケールを実現します。特に、タイル化された処理により、限られたGPUリソースでも大きなサイズの画像を生成することが可能になります。

2. 使用するカスタムノード

Tiled Diffusion & VAE for ComfyUI

Tiled Diffusionは、ComfyUIでTileを実行するためのカスタムノードです。Tileは、大きな画像を小さなタイルに分割し、各タイルを個別に処理することで、全体の画像を生成します。このアプローチにより、GPUのメモリに負担をかけることなく、高品質な画像生成が可能になります。

https://github.com/shiimizu/ComfyUI-TiledDiffusion

3. 使用するモデル

controlnet-union-sdxl-1.0

controlnet-union-sdxl-1.0は、SDXLで使用できる様々なControlNetを一つにまとめたプリプロセッサーモデルです。以下のリンクよりダウンロードし、「ComfyUI/models/controlnet」フォルダに格納してください。

RealVisXL V5.0 Lightning

生成モデルとしてRealVisXLのLightningタイプを使用します。Lightningタイプを使用することで、生成時間を非常に短くすることができます。以下のリンクよりモデルをダンロードし、「ComfyUI/models/checkpoints」フォルダに格納してください。

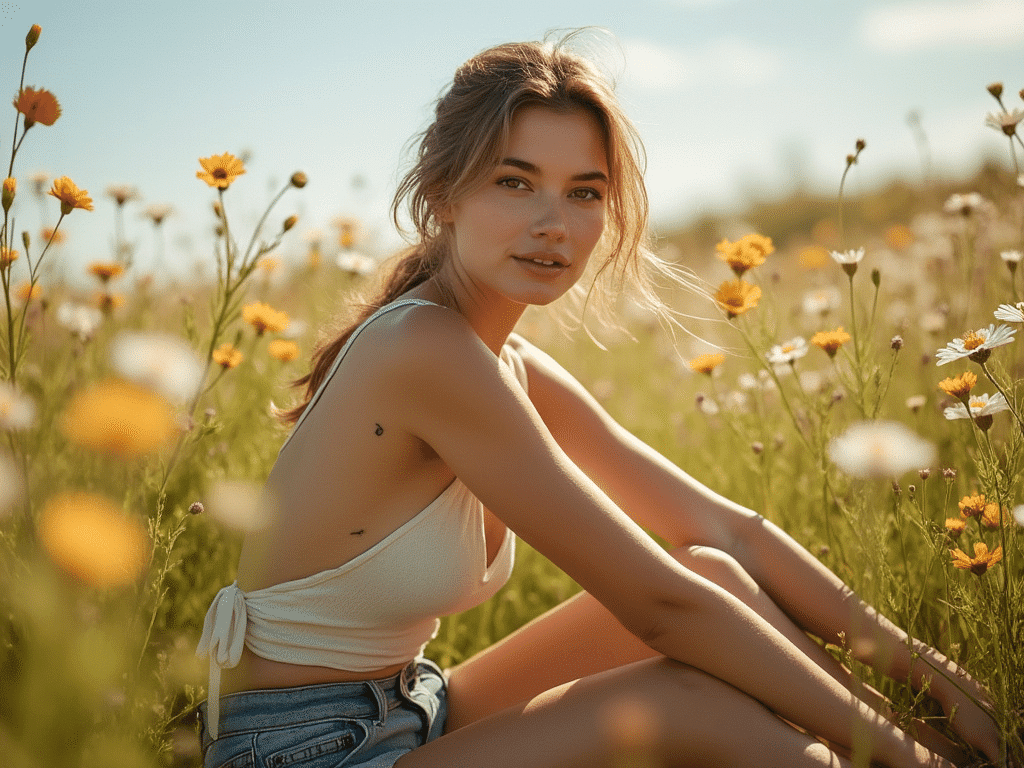

4. 使用する画像素材

画像は、以下のリンクよりダウンロード可能です。

-

画像素材(右クリックでダウンロード)

5. ワークフローの解説

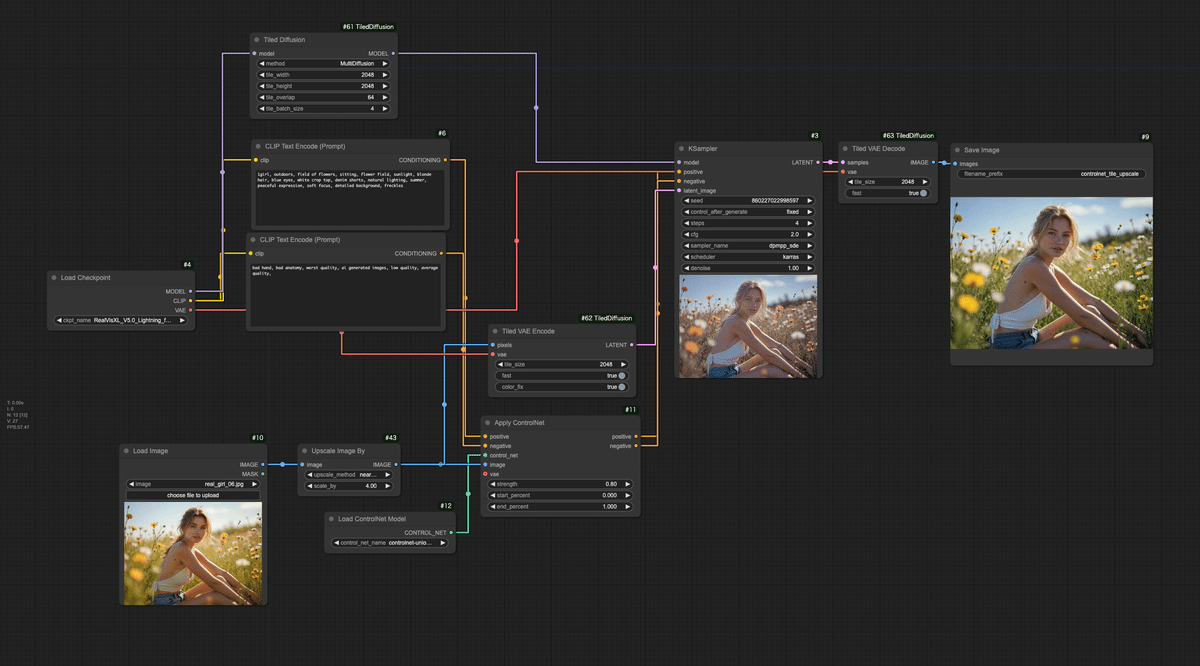

このワークフローは、ControlNetとタイル化された拡散を使用して画像をアップスケールおよび強化する高度な例です。以下がワークフローの全体像です。

★ControlNetを含めたGoogle Colabで利用できるComfyUIのインストールスクリプトへのリンクと、ワークフローは、文末よりダウンロード可能です。

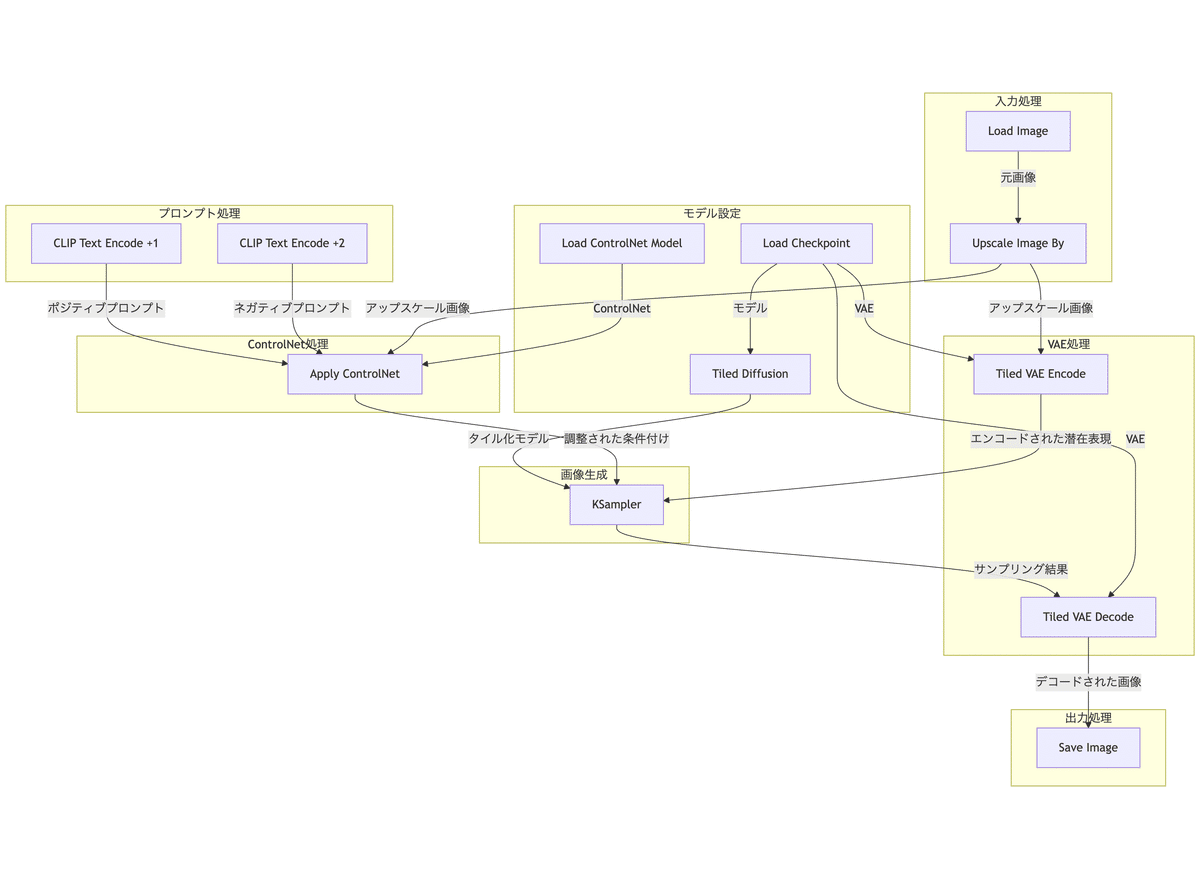

以下は、ワークフローをフローチャート形式で表示したものです。

以下に、このワークフローの主要な部分とその機能を詳細に説明します。

タイル処理とはいえアップスケールは大きなメモリが必要なのでGoogle Colabはハイメモリで起動することをおすすめします。

-

画像入力

-

LoadImage ノード: "real_girl_06.jpg" という画像を読み込みます。

-

-

モデルとControlNetの設定

-

Load Checkpoint ノード: "RealVisXL_V5.0_Lightning_fp16.safetensors" モデルを読み込みます。

-

Load ControlNet Model ノード: "controlnet-union-sdxl-1.0-promax.safetensors" ControlNetモデルを読み込みます。

-

Tiled Diffusion ノード: MultiDiffusionモードで2048x2048のタイルサイズを設定します。

-

-

画像処理

-

Upscale Image Byノード: 入力画像を4倍にアップスケールします。

-

-

VAEエンコード/デコード

-

Tiled VAE Encode ノード: アップスケールされた画像をタイル化してVAEエンコードします。

-

Tiled VAE Decode ノード: 生成された潜在表現をタイル化してデコードします。

-

-

プロンプト処理

-

ポジティブプロンプト: 「1girl, outdoors, field of flowers, sitting, flower field, sunlight, blonde hair, light brown hair, brown eyes, white crop top, denim shorts, natural lighting, summer, peaceful expression, soft focus, detailed background,」

-

ネガティブプロンプト: 「bad hand, bad anatomy, worst quality, ai generated images, low quality, average quality,」

-

-

画像生成

-

KSampler ノード:

-

Seed: 860227022998597 (固定)

-

Steps: 4

-

CFG Scale: 2

-

Sampler: dpmpp_sde

-

Scheduler: karras

-

Denoise: 0.8

-

-

-

ControlNet適用

-

Apply ControlNet ノード: ControlNetの影響力を0.8に設定。

-

-

出力処理

-

Save Image ノード: 生成された画像を "controlnet_tile_upscale" というプレフィックスで保存します。

-

6. 生成結果の確認

それでは、ワークフローを実行して、画像生成してみてください。以下が元画像と生成画像を比較した画像になります。少し色合いが変わってしまっていますが、形状は完全に同じになっています。

以下は顔をアップにして切り抜いた画像です。画像をクリックして拡大してもらうと分かりますが、解像度が高くなり、鮮明になっています。

ControlNetのTileでのアップスケールは、あくまでControlNetでの元画像の状態維持での画像生成になるので、やはり全く同じとはいきません。KSamplerのdenoiseの値を小さくすれば、変化の影響は抑えられますが、一方で変化が小さすぎると、解像度を上げても画像が荒くなってしまいます。

ここで、その変化を見るために、プロンプトを変更してみましょう。プロンプトに「blue eyes」(青い瞳)と「freckles」(そばかす)を追加してみます。

1girl, outdoors, field of flowers, sitting, flower field, sunlight, blonde hair, light brown hair, blue eyes, white crop top, denim shorts, natural lighting, summer, peaceful expression, soft focus, detailed background, freckles,

このプロンプトで生成した結果が以下になります。瞳は青くなり、そばかすが増えていることが分かります。このように、プロンプトの影響を受けるため、Tileでのアップスケールの際は、プロンプトも元画像に合わせるようにしましょう。

7. まとめ

本記事で紹介したTiled DiffusionとControlNetを組み合わせたワークフローは、高解像度画像の生成において非常に効果的な手法です。特筆すべき点としては、以下の通りです。

-

GPUメモリの効率的な使用:タイル化された処理により、限られたGPUリソースでも高解像度の画像生成が可能

-

画質の維持:ControlNetの活用により、アップスケール時も元画像の特徴を保持

-

柔軟な調整:プロンプトやdenoiseの値を調整することで、生成結果をコントロール可能

ただし、プロンプトの設定には注意が必要で、元画像の特徴に合わせた適切な記述が重要です。また、denoiseの値とプロンプトのバランスを取ることで、より望ましい結果を得ることができます。このワークフローは、高品質な画像生成を必要とするプロジェクトにおいて、有用なツールとなるでしょう。

X(Twitter)@AICUai もフォローよろしくお願いいたします!

【PR】ComfyUIを極めたいアナタにおくる!

生成AIクリエイティブAICUの動画ラーニングメディア

https://j.aicu.ai/Coloso3

画像生成AI「ComfyUI」マスターPlan

画像生成AI「Stable Diffusion」特に「ComfyUI」を中心としたプロ向け映像制作・次世代の画像生成を学びたい方に向けたプランです。最新・実用的な記事を優先して、ゼロから学ぶ「ComfyUI」マガジンからまとめて購読できます。 メンバーシップ掲示板を使った質問も歓迎です。

-

メンバー限定の会員証が発行されます

-

活動期間に応じたバッジを表示

-

メンバー限定掲示板を閲覧できます

-

メンバー特典記事を閲覧できます

-

メンバー特典マガジンを閲覧できます

-

動画資料やworkflowといった資料への優先アクセスも提供

ゼロから学ぶ「ComfyUI」マガジン

https://note.com/aicu/m/md2f2e57c0f3c

メンバーシップ参加者にはもれなく「AICU Creator Union」へのDiscordリンクをお伝えし、メンバーオンリー掲示板の利用が可能になります。

https://note.com/aicu/membership/boards/61ab0aa9374e/posts/db2f06cd3487?from=self

もちろん、初月は無料でお試しいただけます!

毎日新鮮で確かな情報が配信されるAICUメンバーシップ。

退会率はとても低く、みなさまにご満足いただいております。

✨️オトクなメンバーシップについての詳細はこちら

https://note.com/aicu/n/n876fab5a0736

★ここから先は有料パートです。ControlNetを含めたGoogle Colabで利用できるComfyUIのインストールスクリプトへのリンクと、今回の内容がすぐに使えるワークフローは、文末よりダウンロード可能です。

より初心者向けの丁寧な補足解説も含まれます!

この記事の続きはこちらから https://note.com/aicu/n/n9952df88b6d2

Originally published at https://note.com on Jan 12, 2025.

![[ComfyMaster41] ControlNet Tileで画像を高解像度化しよう!](https://corp.aicu.ai/hubfs/rectangle_large_type_2_b8f8ee1a22d1b65f7ab33e8f563c4dea.png)

Comments