これまで動画編を中心にお送りしてきたComfyMasterですが、今回は動画編をまとめ、「試験に出るComfyUI - 画像生成と動画生成の違いと歴史」として、理解を深めていきたいと思います。

https://note.com/aicu/m/md2f2e57c0f3c

Stable Diffusionを中心とする画像生成、そして最近の動画生成はどのような違いがあるのでしょうか。現在も進化を続けている動画生成の内部について、SDXL以降に登場した「AnimateDiff」を起点に歴史と技術を解説してみたいと思います。

AI動画生成に期待される機能

まず、AI動画生成に期待される機能について考えてみましょう。今までの画像生成はテキストから画像を生成する Text to Image (t2i) や、画像から画像を再生成する Image to Image (i2i) が主でした。動画の場合もテキストから生成する Text to Video(t2v) は当然求められますが、多くは生成した画像や、撮影した元写真などの画像を起点とする動画生成、つまり Image to Video (i2v) が多くなります。さらに元となる動画をスタイル変換する Video to Video (v2v)、そして、1枚の画像などの少ないヒントから3D空間や多視点映像、自由視点映像といった従来の発想からは生み出されなかった新しい機能「AIバーチャルカメラ」といった機能も現れ始めています。

Stability AIから

— AICU 「つくる人をつくる」クリエイターのためのAIメディア (@AICUai) March 18, 2025

バーチャルカメラ「Stable Virtual Camera」登場

多視点拡散モデルで2D画像を奥行きとパースペクティブがある立体ビデオへ https://t.co/fF1kJVeq8a

AnimateDiffの仕組みを説明できますか?

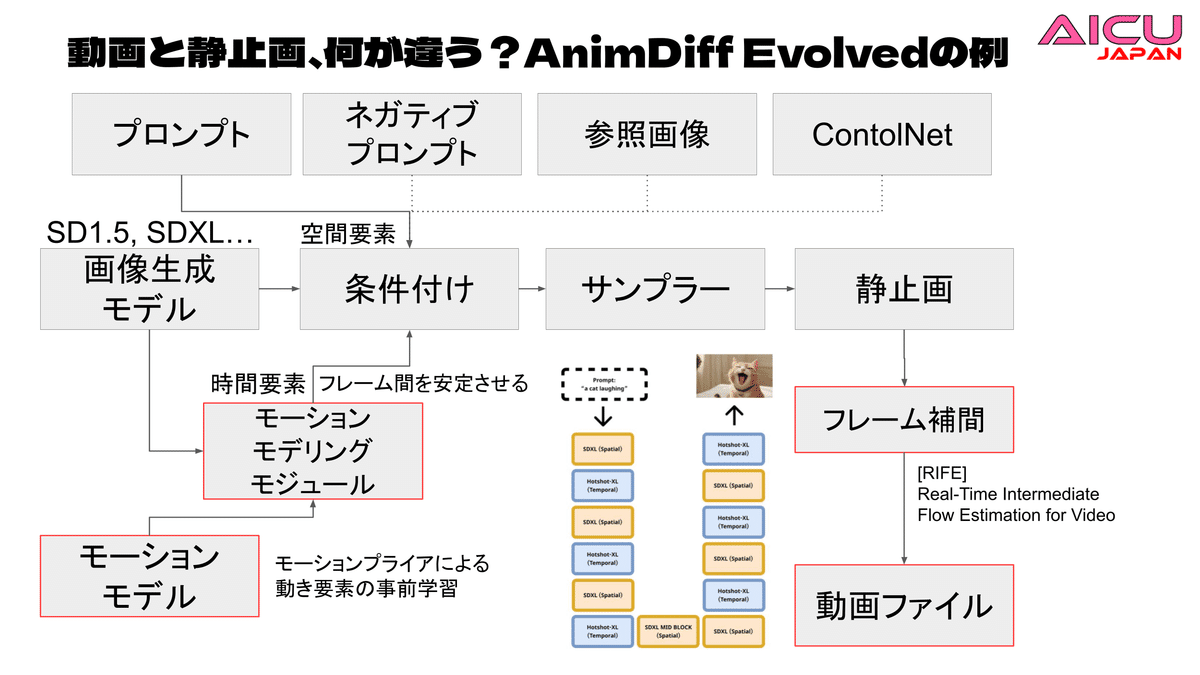

ここで今後登場する様々な動画生成AIモデルの内部の理解を助けるため、まずはAnimateDiff Evolvedを使って、静止画の連続から動画生成に至るまでの考え方を解説できるようになりましょう。Stable Diffusion 1.5 (SD1.5) 系をベースに開発されたAnimateDiffは、シンプルなテキストプロンプトから動画を簡単に作成できます。

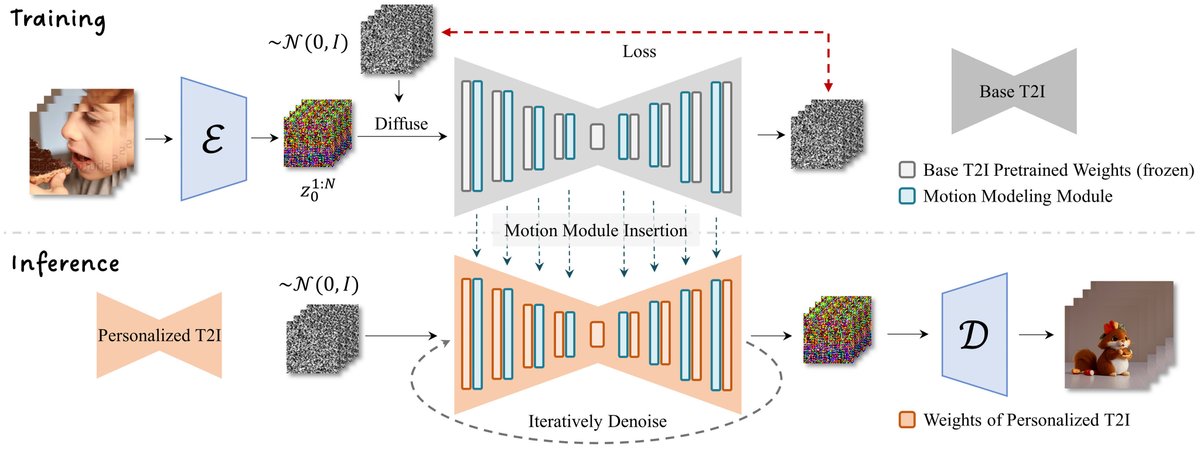

AnimateDiffの仕組みの核心は「モーション・モデリング・モジュール」という、事前にトレーニングされた時間方向の学習モジュールにあります。このモジュールは、実写の動画データからモーションプライア(Motion Priors)を学習しており、t2iのモデルに力学的な動きやアニメーションといった「動き」を静止画ベースのt2iモデルに追加することができます。さらにその後、動画クリップでトレーニングしています。このトレーニングされたモーションモジュールを既存のStable DiffusionのU-Netの条件付けに注入するだけで、同じ基盤モデルから派生したすべてのモデルは、多様な動画を生成するt2vモデルになります。つまり同じ基盤となるモデル、例えばSD1.5やSDXLといったt2iモデルに統合可能です。

Hotshot-XLによる高画質化

https://huggingface.co/hotshotco/Hotshot-XL

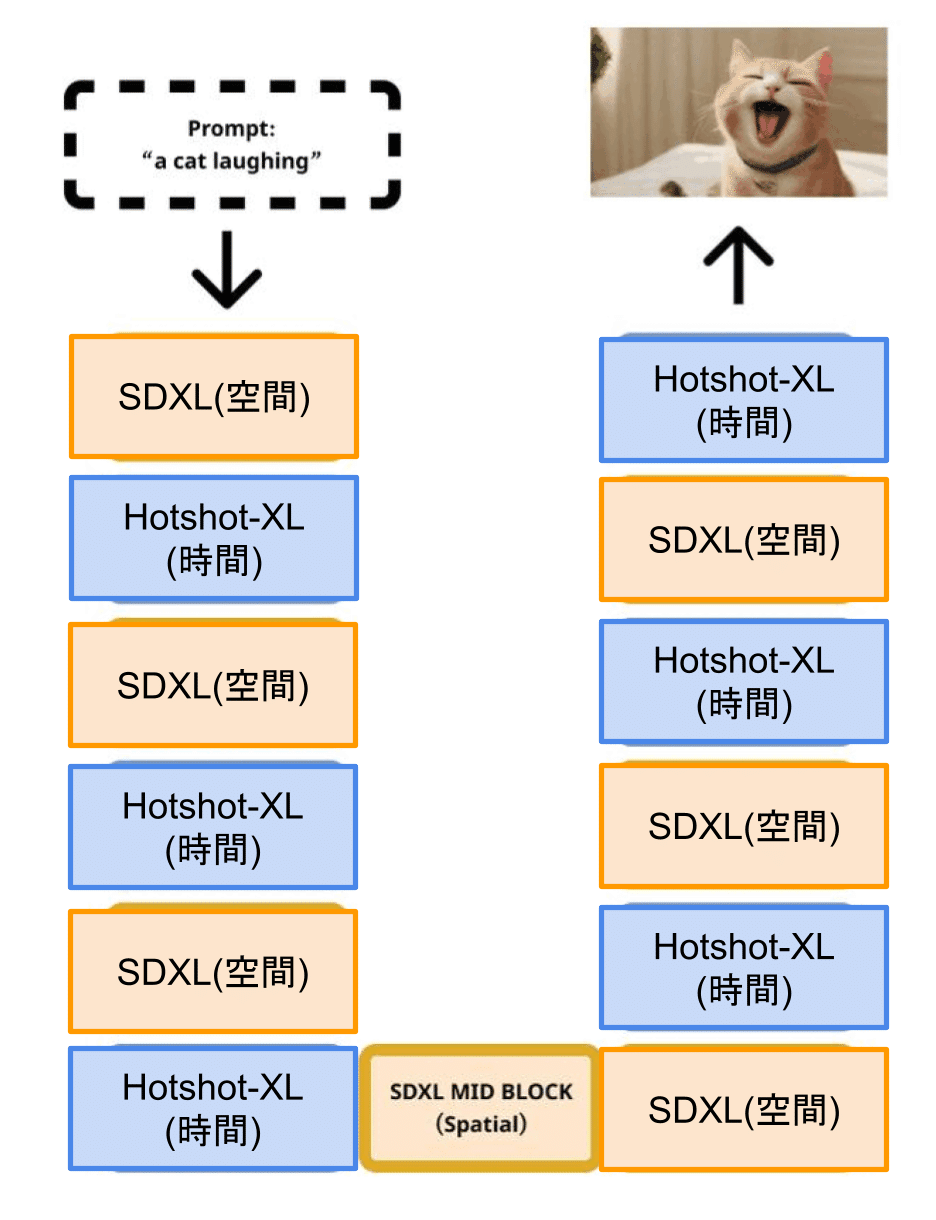

Hotshot-XLはSDXLと連携して動作するようトレーニングされたテキストから GIF動画への変換モデルです。8 FPS で1秒のGIFを生成するようにトレーニングされています。U-NETの中で従来の静止画を生成する過程に入り込み、時間方向の安定性を追加していることがわかります。Hotshot-XL は高画質なSDXLをベースにさまざまなアスペクト比でトレーニングされています。実際のComfyUIのノードとしてはサンプリングの設定、コンテキストの設定などの要素が増えていきます。

モーションプライア(Motion Priors)とは?

モーションプライアとは、動画データから学習される「動きの事前知識」です。例えば実写における動画の連続フレーム間において、被写体は基本的に同じ物体であり「一貫性」が期待されます。一方で「動きのパターン」、例えばカメラのパンやドリーの間、被写体が突然変わることはないでしょうし、被写体となる物体に対するライティングや陰影づけは一致している必要があります。さらに物体そのものが落ちる、動く、弾むといった力学的ダイナミクスを有していたり、人間のような被写体であれば、走っている、踊っている、視線が動く、表情が変わるといった「動きの要素」が存在します。この動きの要素を汎用性を確保して事前学習し、異なるt2iモデルにも適用できるようにすることで、モデルごとに動きを学習し直す必要はなくなるという手法です。

AnimateDiffの特徴

AnimateDiffの特徴と主な利点を整理しておきます。まずモデル固有の調整が不要です。既存のt2iモデルをそのままアニメーション生成に活用できるため、ユーザーはプロンプトやキーとなる画像の提供、スタイルの探求に集中してアニメーションを作成できます。次に、モーションモジュールとモーションプライアによる事前学習です。これにより、生成されるアニメーションは自然で視覚的に安定しています。さらに柔軟な動きのカスタマイズが必要な場合はMotionLoRAを用いることで、特定の動きのパターンを簡単に追加・調整できます。このMotionLoRAは少量のデータと短時間のトレーニングで動きを学習できるため、ユーザー間でのモデル共有も容易です。

基本のワークフローを使ってAnimateDiffを理解する

それではサンプルワークフローを使ってAnimateDiffを理解してみましょう。

Google Colabで動作するノートブックとワークフローへのリンクは文末で紹介します。

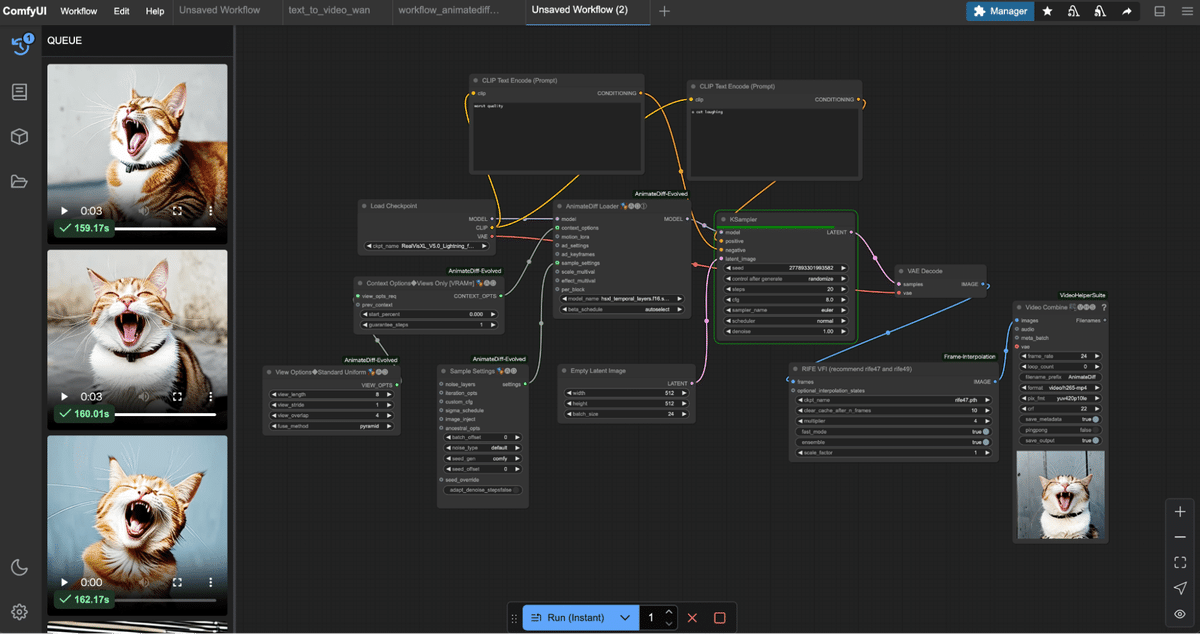

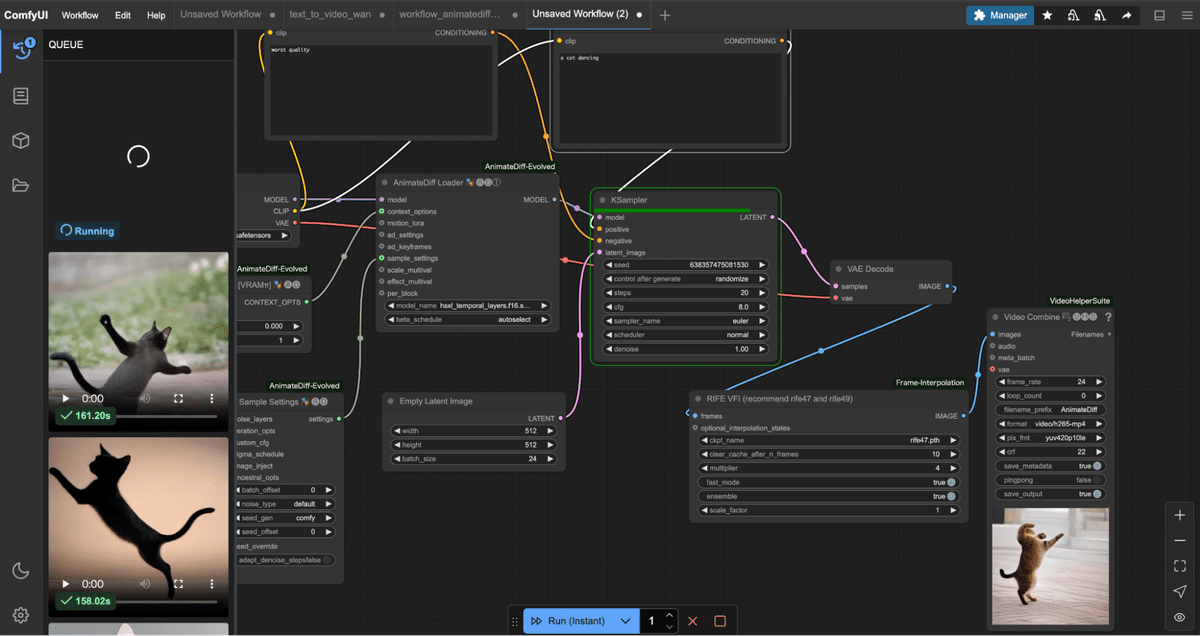

モデルとAnimateDiffの設定

Load Checkpoint ノード: 「RealVisXL_V5.0_Lightning_fp16.safetensors」モデルを読み込みます。SDXL-Lightningは、ByteDanceが発表した画像生成モデルで、高速かつ高品質な画像を生成することができます。stable-diffusion-xl-base-1.0 (SDXL)を基に構成され1〜8ステップでの生成が可能で高速高品質が期待できます。

AnimateDiff Loader ノード: AnimateDiffのモーションモジュールをベースモデルに適用します。ここでHotshot-XL「hsxl_temporal_layers.fp16.safetensors」を設定しています。

beta_schedule: autoselect

コンテキストオプション (Context Options)

複数のフレームをどのようにまとめて整合性をとっていくか、コンテキスト(前後関係)を指定していきます。コンテキスト長、ストライド(ステップの幅)、オーバーラップ、スケジュール(コンテキストをどのような間隔で適用するか)、ループさせるか、ブレンドといったパラメータがあります。ここでまはず、Views Only[VRAM↑↑]のノードを作ってAnimateDiff Loaderにつなぎ、start_percent=0, guarantee_steps=1を設定します。各パラメータの意味と推奨設定値は各モデルの推奨値を参照してください。さらに上流に、Context Options Standard Uniformノードを追加し、以下の推奨値を設定します。

view_length: 8

view_stride: 1

view_overlap: 4

fuse_method: pyramid

フレーム補間とMP4ファイルの設定

次に Empty Latent Imageを作成し、width=512, height=512, batch=24を設定します。これで24フレームを連続生成する状態になります。Hotshot-XLは、320 x 768、384 x 672、416 x 608、512 x 512、608 x 416、672 x 384、768 x 320の解像度でトレーニングされているため、いずれかを設定してください。Latent出力を静止画生成の場合と同じくKSamplerの入力に接続します。

またCLIPを2つダブルクリックして作成し、静止画のt2iと同様に接続していきます。ポジティブプロンプトに「a cat laughing」、ネガティブプロンプトに「worst quality」として、KSamplerの出力に静止画生成の場合と同じく、VAE Decodeを接続し、その先にフレーム補完ノード「RIFE VFI」を設定します。multiplier=4、さらに出力のImageに Video Combineを接続し、frame_rate=24, format=video/h265-mp4, とします。

ここまで接続したら、必要最低限の動画が生成できるはずです。Runボタンを押してキューを作成しましょう。もし不足要素があればメッセージが表示されますので解決しましょう。

キューに笑っている猫の3秒の動画が生成されれば成功です!

AnimateDiffによるt2vの動作確認

ワークフローの設定と生成された動画を見て気が付いたかもしれませんが、AnimateDiffはテキストプロンプト(CLIP)に接続されていませんが、生成された猫は笑っているはずです。アクビをしているようでもあります。

今回のワークフローでは、KSamplerのmodelの入力にAnimationDiffが条件付けとしてプラグインされつつも、あくまでKSamplerとしては2つのCLIPの条件付けに従い、Modelで設定されたスケジュールに基づいて、AnimateDiffに従って各フレームを生成しています。ここでプロンプトを「a cat dancing」に変えてみましょう。猫が踊っているように見えなくもないですが(誌面では表現しづらいですが)、動きとして一貫した「猫のダンス」ではなく、静止画としての「踊っている猫」を連続的に構図を似せて生成したように見えるのではないでしょうか。これはこのモーションモジュールが「猫のダンス」を学習しているわけではないという証拠でもあります。プロンプトを「a girl is dancing」とするとどんなダンスが出てくるか実験してみてください。バレエのようなヒップホップのようなダンスが出てくるはずです。これを「hiphop dancing」としたからといって、ダンスが安定するわけではありません。動作そのものをCLIPが条件付けしているからでは無く、プロンプトは、生成された画像経由でしか動作に影響を及ぼしていません。

ワークフローの補足

実は今回のワークフローは構造の理解と、最小限のモジュールを解説したため、サンプリングの設定がありません。またContext Optionsの代わりにView Optionsを使っています。

さらにモーションモジュールではAnimateDiffのモーションモジュール(mm)ではなく Hotshot-XL(hsxl_temporal_layers)を使用しています。モーションモジュールは最適なフレーム長がモデルによって異なります。例えばAnimateDiffのmmは16フレーム、HotshotXLは8フレームとなっています。Context Optionsは、アニメーションのコンテキスト(前後関係)を参照して数フレーム毎に処理する方法です。これにより、同時に使うメモリ(VRAM)の量を制限できます。大きな作業を小分けにしてメインメモリで評価しながら進めることで、VRAMの負担を減らして安定して高品質な動画を生成しようとしているのです。Views Onlyノードによる手法はモーションモジュールが見るべきデータ(潜在変数)をVRAMに置いたままにする方法です。この方法ではVRAMを節約できませんが、処理が安定しやすく、より速く動きます。なぜなら過去数フレームのデータが全てGPU上のVRAMに乗っており、かつ他のプロセスで参照したりメインメモリに転送する必要がないからです。

AI動画生成の急速な進化の歴史

AI動画生成は進化成長が激しい分野であり、有名なところではChatGPTでブランド力があるOpenAIが「Sora」をアナウンスし、2024年12月9日にリリースしました。それよりもはるか前、2023年2月にRunwayがv2vサービス「Gen-1」をAI動画生成サービスとしてリリースしており、Stability AIも「Stable Video Diffusion (SVD)」を2023年11月21日にオープンモデルとしてリリースしています。画像をより高速に、理論上、画像の生成を1ステップで行える潜在一貫性モデル(Latent Consistency Model :LCM) や敵対的拡散蒸留(Adversarial Diffusion Distillation:ADD)など、高速で安定して一貫性のある画像生成のモデルが提案されました。

https://stability.ai/research/adversarial-diffusion-distillation

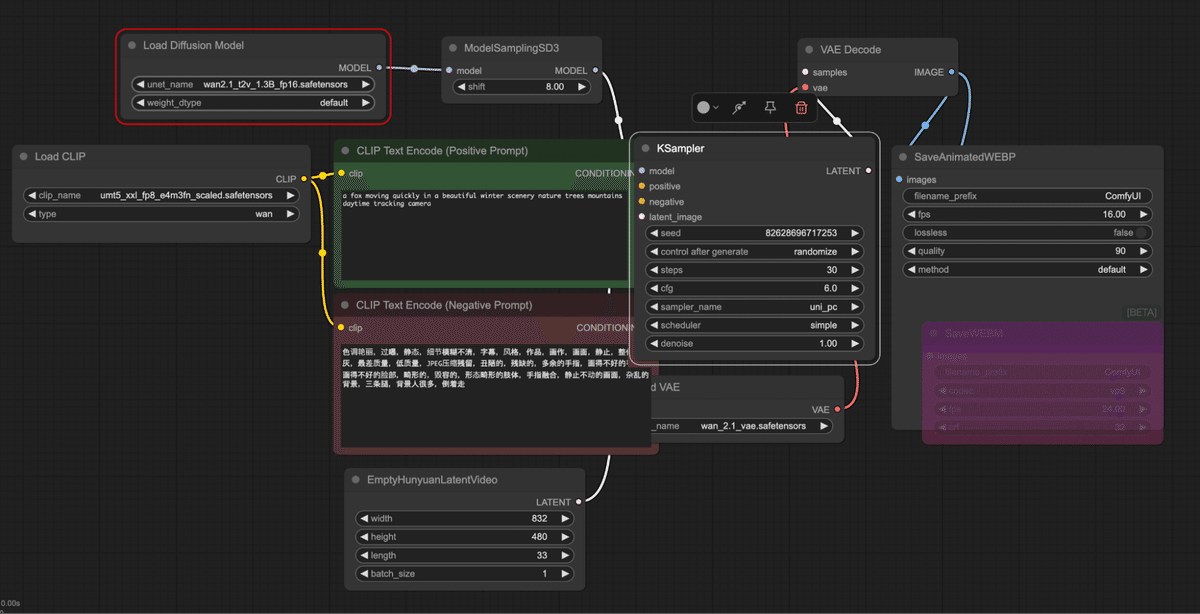

さらにSVDのリリース後も中国テンセントHunyuan(混元)Videoや、中国アリババのWanなどがオープンに公開されています。

本書を執筆している最新の状況ではStability AIによる多視点バーチャルカメラでの方向性と、プロンプトの代わりにビジョンとして画像の評価をさせることによる安定性を図るVision Transformer (ViT)という手法、さらにDiffusionモデルをTransformerに扱わせる Diffusion Transformer (DiT)が主流になってきています。

日本でも経済産業省と国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)が実施する、国内の生成AIの開発力強化を目的としたプロジェクト「GENIAC(Generative AI Accelerator Challenge)」の成果として AIdeaLab VideoJPの成果が公開されましたがその資料の中でもDiTが使われていることが説明されています。

最新のモデルが必ずしも読者の理解にとって良いか?という視点でみてみると、実はそうでもないかもしれません。新しいモデルはより効率よく、高速、高品質に、美しい結果が出ることを期待して、大規模なパラメーターになっていく傾向があり、細かい制御性や自分で組み立てる要素が減っていることもあります。本セクションではちょうど本書「ComfyUIマスターガイド」として、ComfyUIによる静止画をマスターした段階で、それをベースに動画に拡張していく解説ができたと考えます。ちょっと難しい要素が多くあったように感じるかもしれませんが、丁寧にみていくと非常に勉強になったはずです。

【中国アリババによる「Wan2.1」のt2vワークフロー。よりシンプルになっていて細かい制御はできない。中国語が公式にサポートされており、ネガティブプロンプト推奨プロンプトとして指定されています】

https://note.com/aicu/n/ncb4fd8c45af5

https://note.com/aicu/n/n661bd6e7bebb

https://note.com/aicu/n/nc37f872eae43

AICU Japan株式会社について

AICUは「つくる人をつくる」をビジョンに掲げ、最新の生成AI、クリエイティブAI技術を皆さまにお届けしています。

📝noteでは、生成AIに関する最新情報や使い方の解説を発信しています。ぜひフォローして、最新情報をチェックしてください!

📩メールマガジン「週刊AICU通信」では、AI関連のニュースやトレンド、イベント情報などを毎週お届けしています。購読登録はこちらから!

【月刊AICUマガジン】「つくる人をつくる」クリエイティブAI専門誌、毎月魅力的な特集や深掘りお送りします[Kindle Unlimitedで無料]

【書籍化します!】「ComfyUIマスターガイド」

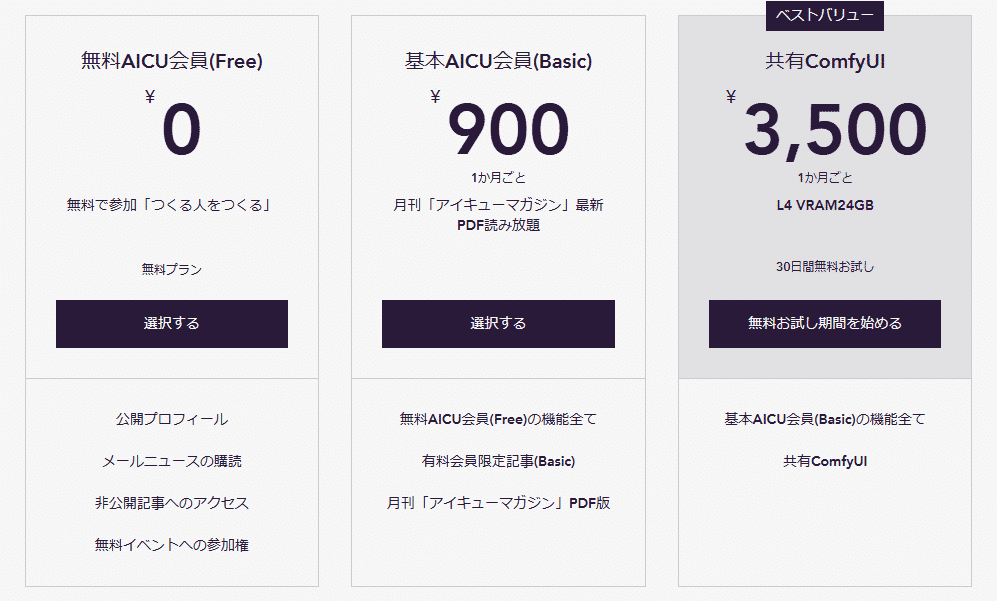

【今すぐ使えるComfyUI】「共有ComfyUI」オープンβ2実施中!

https://www.aicu.jp/pricing-plans/list

★3/31までβテスト中につき無料参加可能です★

【月刊AICUマガジン】「つくる人をつくる」クリエイティブAI専門誌、毎月魅力的な特集や深掘りお送りします[Kindle Unlimitedで無料]

Xでも情報発信中!フォローしてね😉

https://x.com/AICUai

※noteのComfyUIマスタープランと、上記の「共有ComfyUI」はしばらく並列に運営していきます。他にもたくさんサービスを開発していきますので応援よろしくお願いいたします!

資料:Google Colabで動作するノートブックと使用したワークフロー

—

この記事の続きはこちらから https://note.com/aicu/n/n93bd4cadc32a

Originally published at https://note.com on Mar 21, 2025.

![[ComfyMaster59] 試験に出るComfyUI - 画像生成と動画生成の違いと歴史](https://corp.aicu.ai/hubfs/rectangle_large_type_2_332e55c8089acce34c18931e21f0bef6-2.png)

Comments