2025年6月26日、サンフランシスコにあるGitHub本社でComfy Orgチームが主催する、初のハッカソン「ComfyUI Mini Hackathon」が開催されました。2時間68チームが参加。まさに革新的なアイデアの数々。ライブビルドされ、その場でオープンソース化されました!

✨ Kontext DevによるAR 3Dステッカー

⚡ 1つのノードからLoRAパイプラインをゼロから構築

💡 初めてのComfyノードをつくれる!

2時間でここまでできるとは驚きです!

https://corp.aicu.ai/ja/meetup20240927

開会式

は〜い、皆さん、こんにちは!ComfyUIから来ました。ComfyUIチーム全員がここにいます。ComfyUIミニハッカソンへようこそ!ComfyUIコミュニティの皆さんとお会いできて、とてもうれしく思います。

始める前に、ハッカソンについて非常に簡単な紹介をします。コーディングの時間をより多く残せるように努めます。まず第一に、本日のスポンサーに心から感謝を申し上げたいと思います。

アフターパーティーを後援してくださったRunpodに感謝します。そして、この素晴らしい会場を再び提供してくださったGitHubにも改めて感謝します。ここにいられることを本当にうれしく思います。

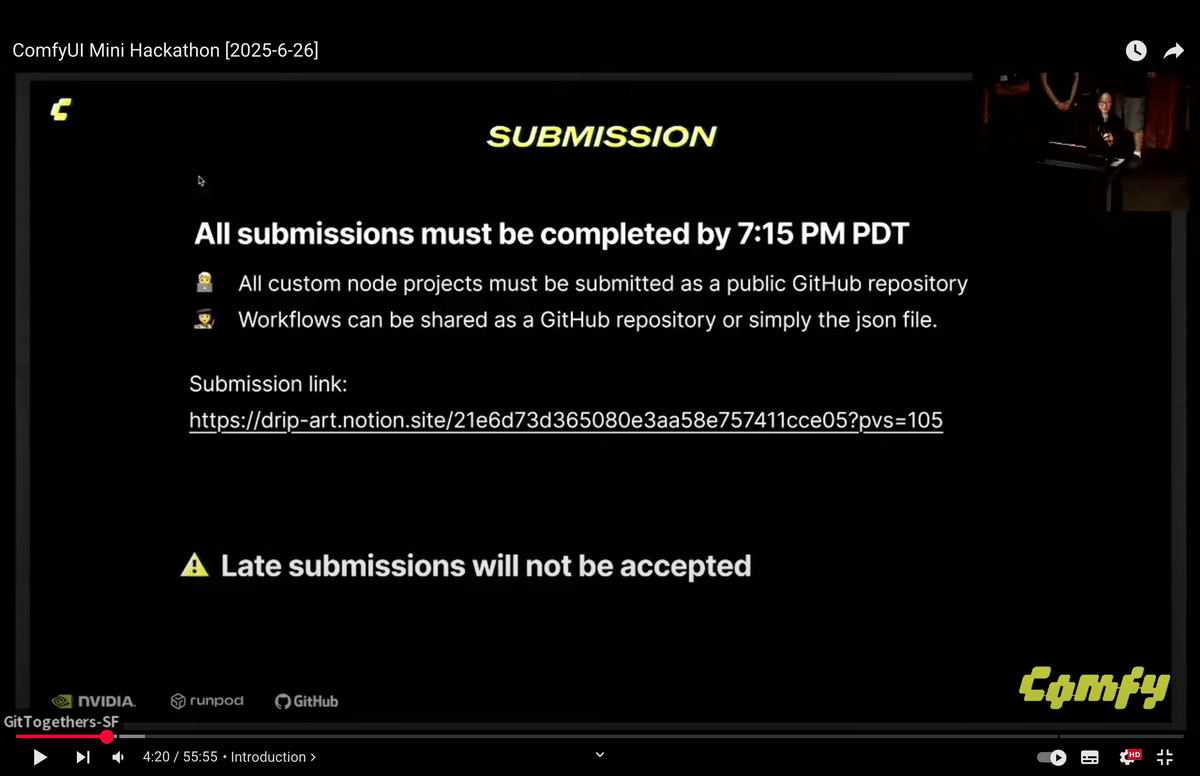

さて、本日のテーマはこちらです。この紹介の後、ハッキングパートを開始します。コーディング時間は約2時間ですので、プロジェクトのすべての提出は7時15分までに終了します。そして、このサイトで勝者を発表し、8時30分までに会場を出なければなりません。本日のハッカソンには2つのトラックがあります。1つは開発者トラックでもう一つはクリエイティブトラックです。

①ComfyUIパイプラインを使用した製品。

②ワークフローの提出

そして、こちらが賞品です。各トラックで、RTX特別賞があります。こんにちは、私はパースです。ComfyでComfyUIの使い方を教えています。そして、皆さんを審査します。

審査員紹介

皆さん、こんにちは。ジュリアンです。以前は自分のワークフローを発表していましたが、今夜は皆さんを審査するために来ました。

皆さん、こんにちは。私はイェドリックです。オンラインではKosinkaDinkとしても知られています。以前、いくつかのカスタムノードを作成しました。そして、開発者トラックを審査します。ありがとうございます。

こんにちは、私はオンラインではComfyとして知られています。このプロジェクトを作成しました。開発者トラックを審査します。

皆さん、こんにちは。私の名前はベンジャミン・リューです。卒業式を欠席してここに来ました。開発者トラックの審査ができることに非常に興奮しています。

皆さん、こんにちは。私の名前はアーウィンです。私はComfyのパワーユーザーです。Comfyでたくさんのクールなアートを作成し、いくつかのカスタムノードも作りました。私はワークフロー側で審査します。ありがとうございます。

Comfyにあまり詳しくない方向けに、簡単な紹介ガイドを用意しています。

7時15分までに完了し、提出用のリンクもあります。そこではチーム番号を添えて提出する必要があります。チーム番号がない場合は、受付に行ってください。もし何か質問があれば、Comfy Tシャツを着たチームメンバーを見つけてください。提出期限の7時15分が近づいたら、再度お知らせします。

発表会

それでは、プレゼンテーションを開始します。進行方法ですが、各チーム持ち時間は2分です。8時30分までにはここを出なければなりません。8時まで2分ずつで、その時間に勝者を発表します。7時15分までに提出した場合です。では、発表順を素早く読み上げます。ファーストネームだけを呼びます。サウラブ、ジェームス、ロイス、オーディン、ロンボ、リー、ジェームス、発音が悪かったら申し訳ありません。ニハル、ジャレッド、サンティアゴ、アリエル、カズキ、エドワード、アレックス、サウラブさん、前に来てもらえますか?自己紹介をお願いします。

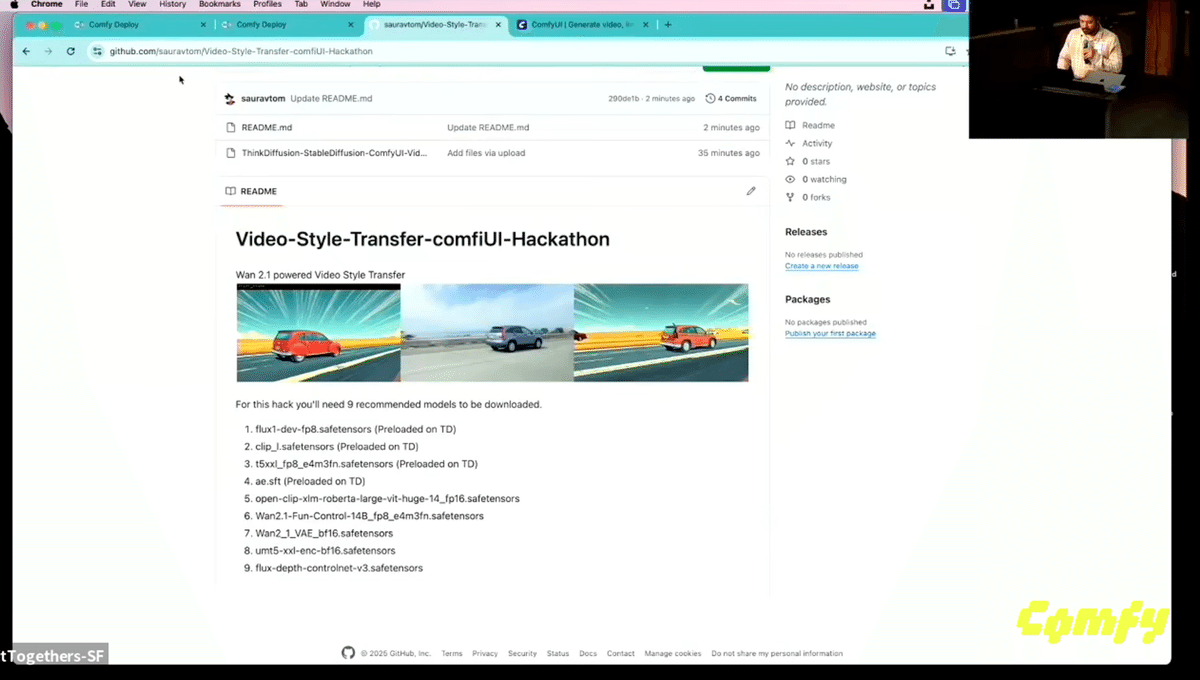

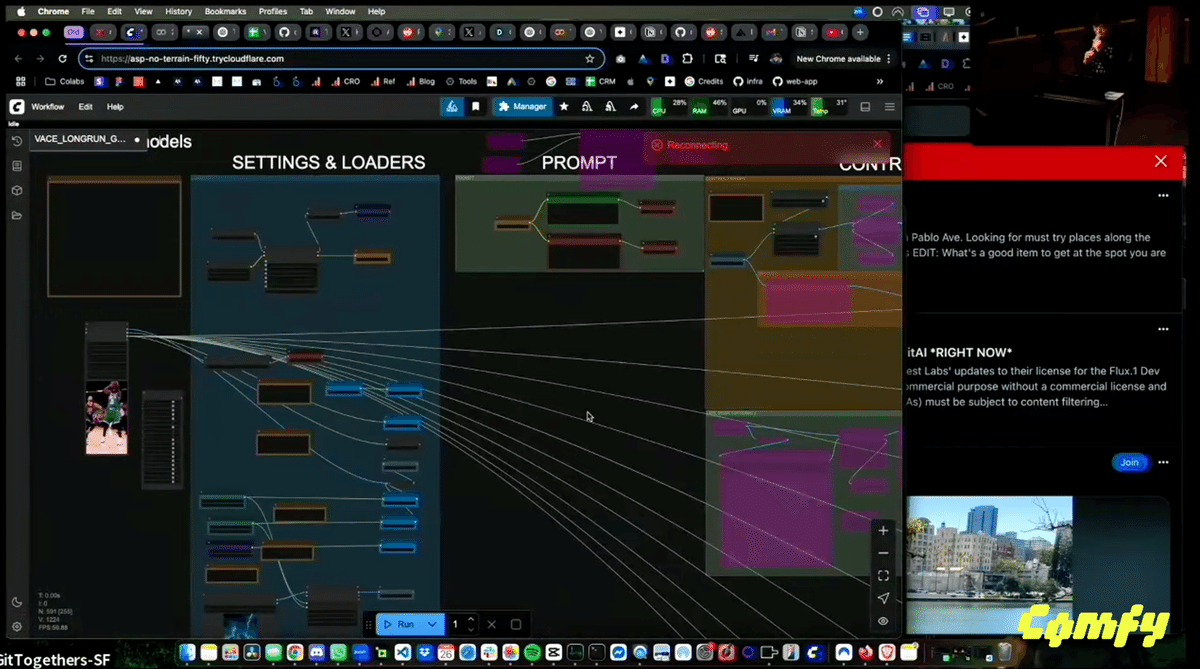

皆さん、こんにちは。ありがとうございます。私の名前はサウラブです。このハッカソンのために、ビデオにスタイルを転送できるビデオスタイル転送を構築しました。このハックでは、Wan2.1ビデオライブラリといくつかのカスタムモデルを使用しました。ターミネーターからクリップを選んで、それにスタイル転送をかけます。ジブリモード。コンプリートデプロイ、そしてそれが完了すると、ビデオが転送されます。

はい、次はジェームスさん、お願いします。こんにちは、私の名前はジェームスです。ワークフロー部門で競っています。基本的に、私が取り組んでいたプロジェクトは、開始フレームと終了フレームのワークフローです。そして、これを特に動きの激しいクリップのために構築したいと思いました。そして、これがFluxContextから生成されたフレームです。これはそのクリップのより高いフレームレートバージョンです。以上です。とてもシンプルです。ありがとうございました。

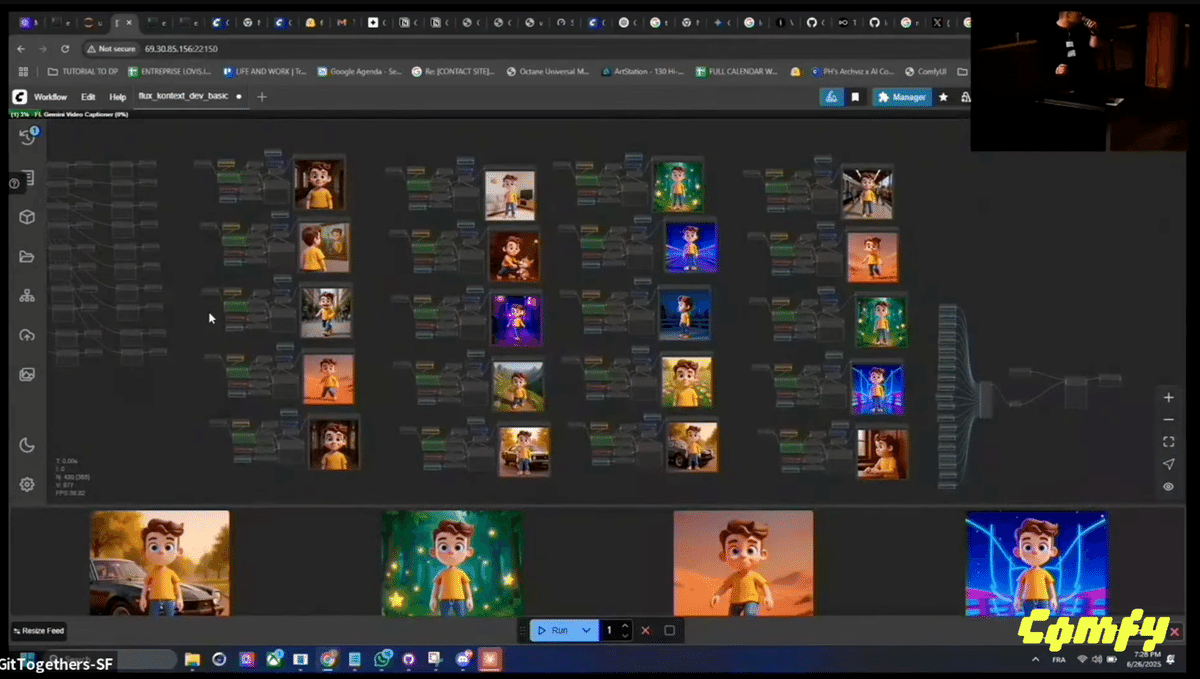

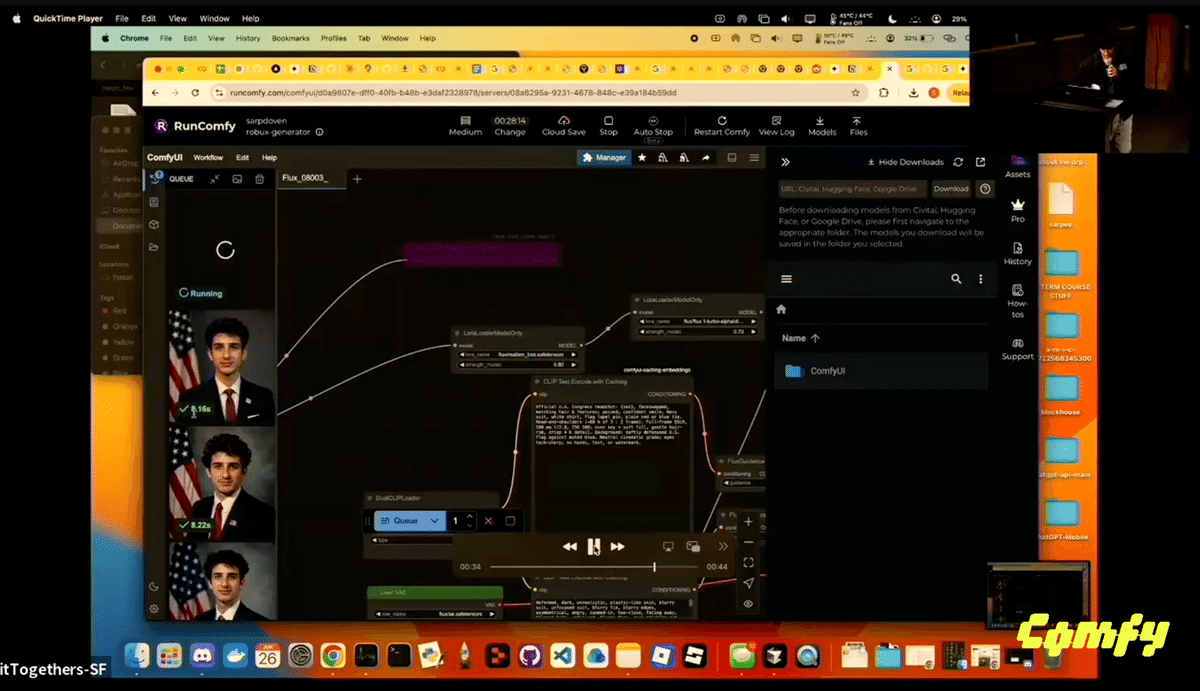

これは少しクレイジーなワークフローに見えますが、コンセプトはシンプルで、1枚の画像からLoRAモデルを生成します。このLLMに接続すると、自動的にプロンプトを作成してくれます。そして最終的に、すべての画像を組み合わせてLoRAを自己学習させます。すぐに別の例もお見せできます。これがキャラクターで機能することを示すためです。ワンクリックで好きなもののモデルを作成できます。そして、このワークショップは明日、皆さんが利用できるようになります。

https://github.com/lovisdotio/workflow-comfyui-single-image-to-lora-flux

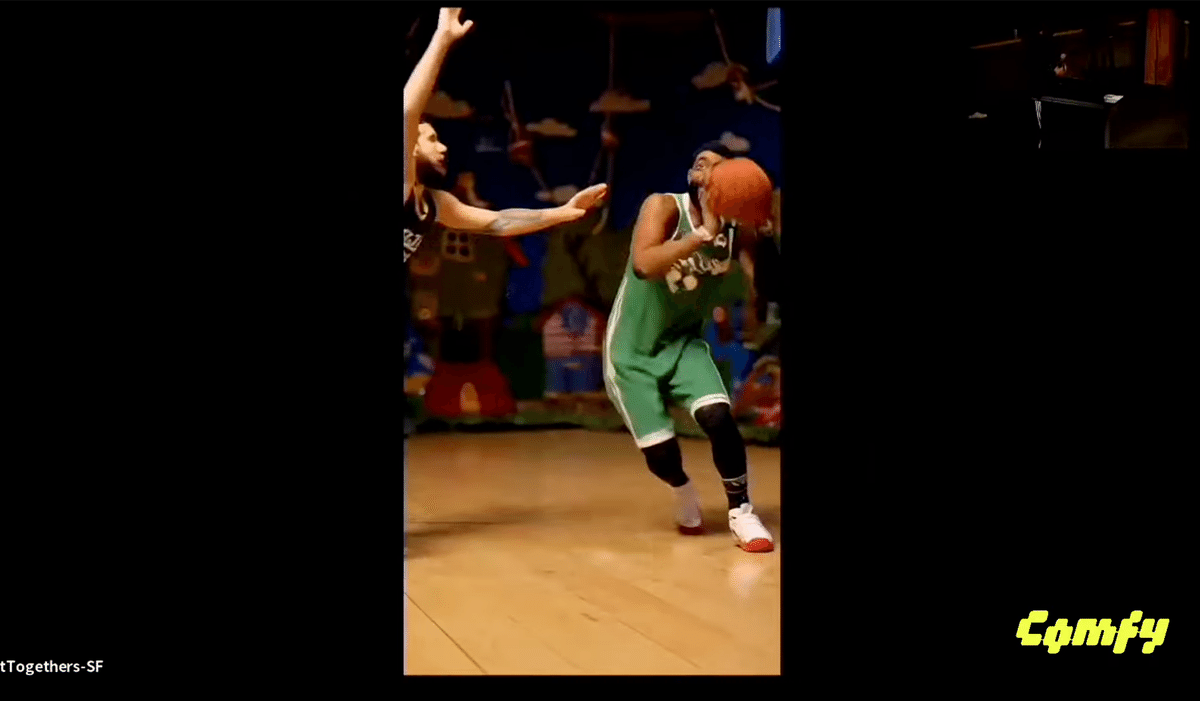

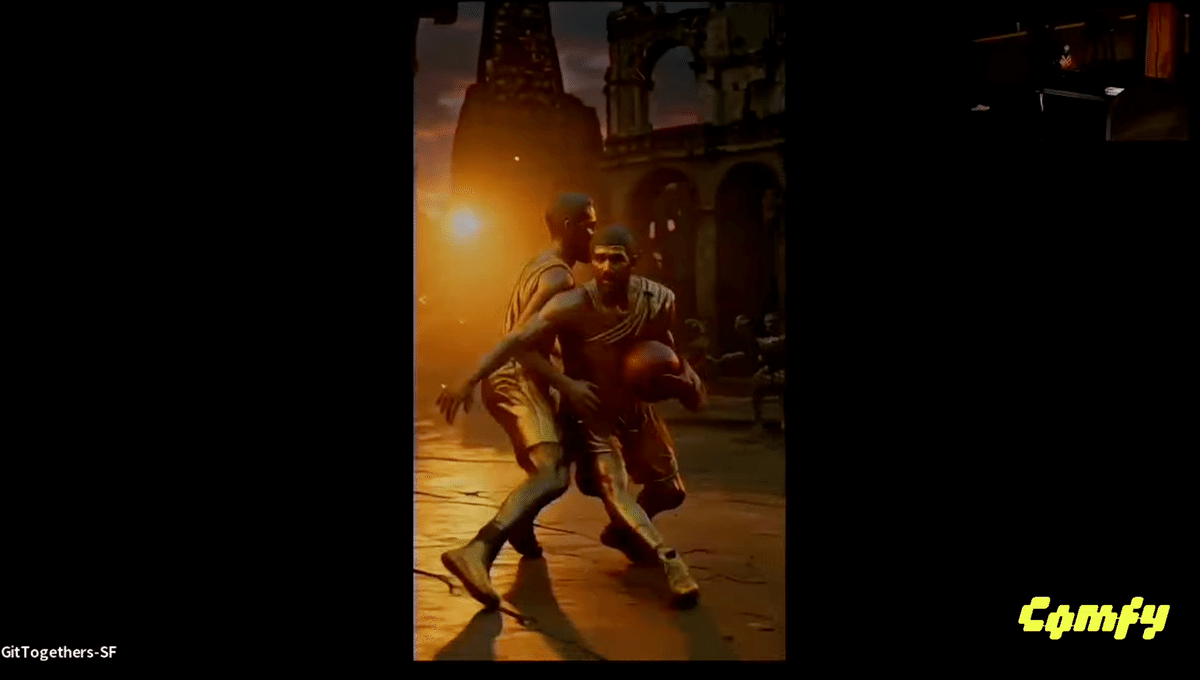

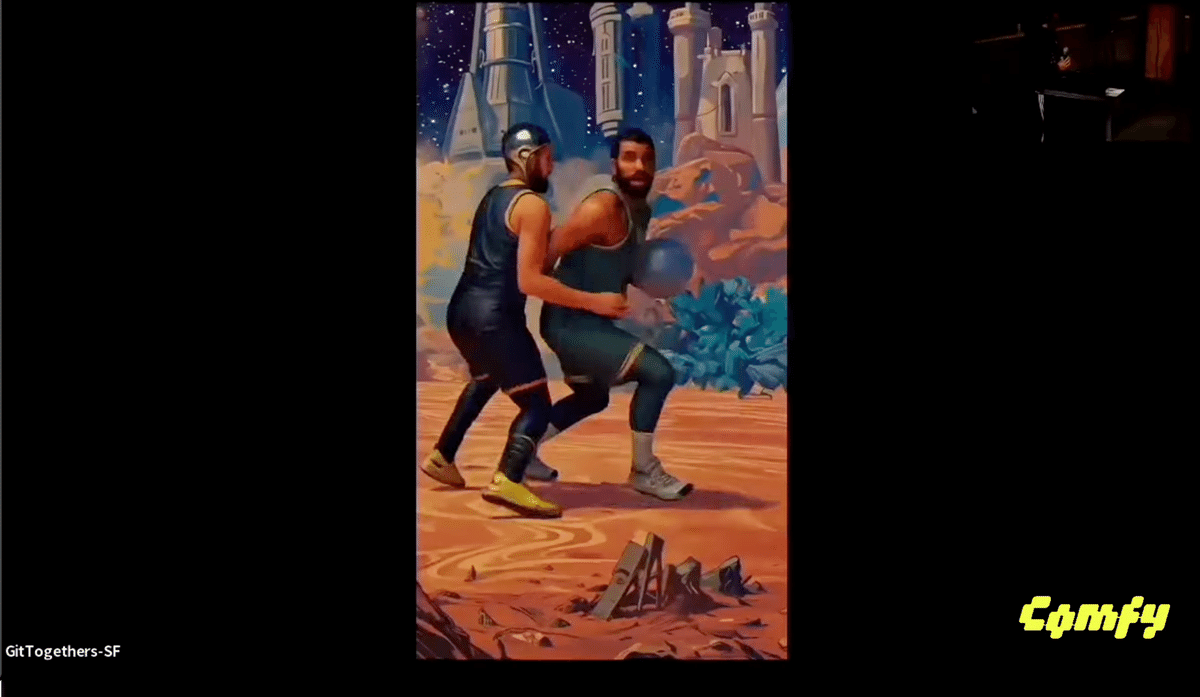

こんにちは、私はランボーです。ワークフロー部門に参加しています。ビデオ・トゥ・ビデオは私のお気に入りのワークフローの1つですが、最も遅いものの1つでもあります。そこで、このハッカソンでは、以前は時には数時間かかっていたワークフローをどれだけ速くできるか試したかったのです。そして、TensorRTや量子化など、すぐに使えるあらゆる最適化を探求しました。このワークフローはFluxContextを使用して最初のフレームを生成し、WANを使用してビデオを生成します。GeGaf、WaveSpeed、TensorRTを含むこれらすべての方法を使用して、7秒間のビデオを7本生成することができました。それぞれ約10分です。クレイジーなことではありませんが、数時間かかっていたのが大きな進歩です。そして、この種の作業はプロジェクトの初期段階で非常に役立つと思います。まだどの方向に行きたいか100%確信が持てないときです。とにかく、結果をお見せしたいです。カイリー・アービングがステフィン・カリーをクロスオーバーするものです。

次のステップは、できるだけリアルタイムに近づける必要があります。なぜなら、いつかスポーツイベントを見て、お気に入りの選手をお気に入りのスーパーヒーローやビデオゲームのキャラクターに変えることができるようになると思うからです。その現実に近づけていきたいです。ありがとうございました。

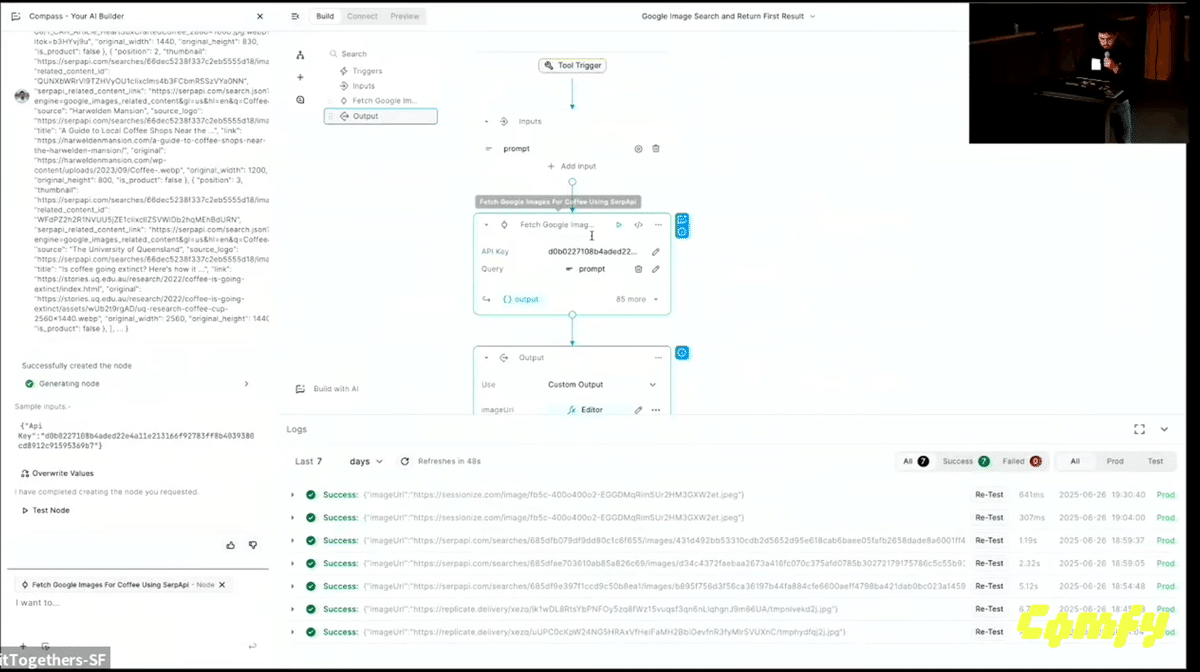

ナハルです。開発トラックです。Comfyを見てみましたが、かなりクールですね。APIノードがたくさんあるのは見ましたが、十分ではないと感じました。例えば、人の名前を入力するだけで、その人に帽子をかぶせることができるようなフローを作りたかったのです。コンテキストモデルがその人物を知らなくても、その人に応じたカスタマイズ画像を作成できます。Buildshipを呼び出すカスタムノードを作りました。APIのプラットフォームで、今はGoogle SERP APIを呼び出して誰かの画像を取得し、それを返すだけです。それが私の名前を取得して、APIを呼び出して画像を取得する方法です。プレビューされているものと、パーソナライズされた製品とマージされ、その画像を生成できるようになります。

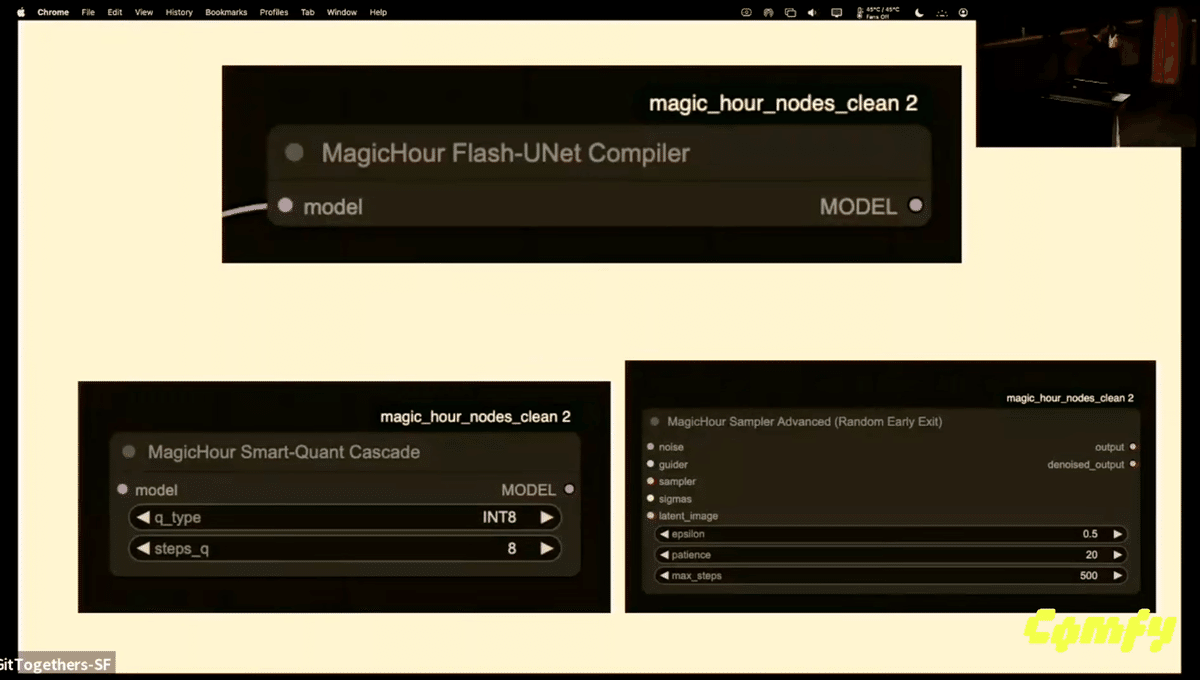

皆さん、こんにちは。私の名前はサープです。そして、私は開発トラックに参加しています。今日は3つの異なるノードを作成しました。時間が少し短いので、3つを簡単に説明します。最初の1つはUNet Flashコンパイラです。ワークフローが実際に実行される前に、任意のUNetモデルをVRAMにロードします。約20%の速度向上が見られました。デモでそれをお見せします。量子化は強力なツールであり、それをワークフローに持ち込みたいと考えています。各量子化に何ステップ必要かを設定し、ワークフローを動的に高速化して、両方の長所を活かすことができます。VRAM使用量を抑えながらモデルを使用できます。そして最後はより実験的なもので、本質的にはスマートツールです。これにより、多くの計算時間が節約され、GPUが本番環境で他の用途に使えるはずの全体的な計算量を大幅に削減できます。これは私の最後の製品の画像比較で、実際に私が訓練した新しいモデルです。しかし、多くの人が話さないのは、実際にFluxモデルを訓練することです。モデルからの推論は、モデルのトレーニングよりもはるかに安価です。特に推論エンドポイントのウェブサイトではそうです。こちらはQ4 GGUFフォーマットでトレーニングされた私のモデルです。そして、これが実行中のデモです。コンパイラーノードで、時間の違いと画像の品質の違いが全体的に見られます。これは私の新しい製品も使用しています。短くまとめますが、以前の8秒と比較して、約5秒で本質的に完璧な画像を生成することができます。同じ計算量と全体的に同じGPUを使用してです。現在、私のGitHubで利用可能です。聞いていただきありがとうございました。

ナハルです。私たちのプロジェクトは開発者トラックで、カスタムノードを構築しました。タスクに基づいて、私たちに教えてくれます。そして、それに基づいてモデルの重みを転送します。タスクに適したモデルを提案し、その重みが次のノードに転送されます。

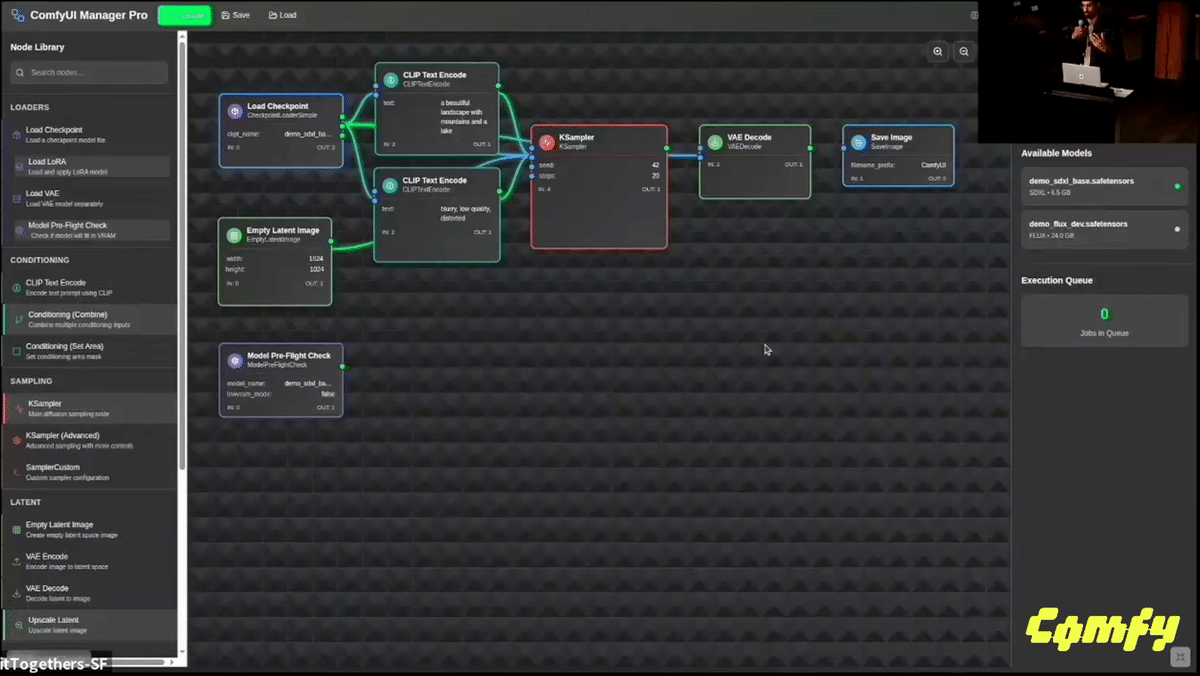

私たちはより良いものを作りました。Comfyでモデルを読み込む際の主な問題の1つは、読み込まれるのを待っていて、問題があることがわかると、すべてが機能しなくなります。モデルが何であるか、パイプライン、それに問題があるかどうかを確認できます。モデル間の互換性、可能なあらゆる種類の最適化、そして最も重要なことに、実際に設定できます。必要なものを、モデルの反映を見ることができます。これは、ノードを管理および最適化するためのツールです。モデルのアーキテクチャで、ワークフローをスピードアップさせます。そして、それがどのように動作したかの集計情報を提供します。

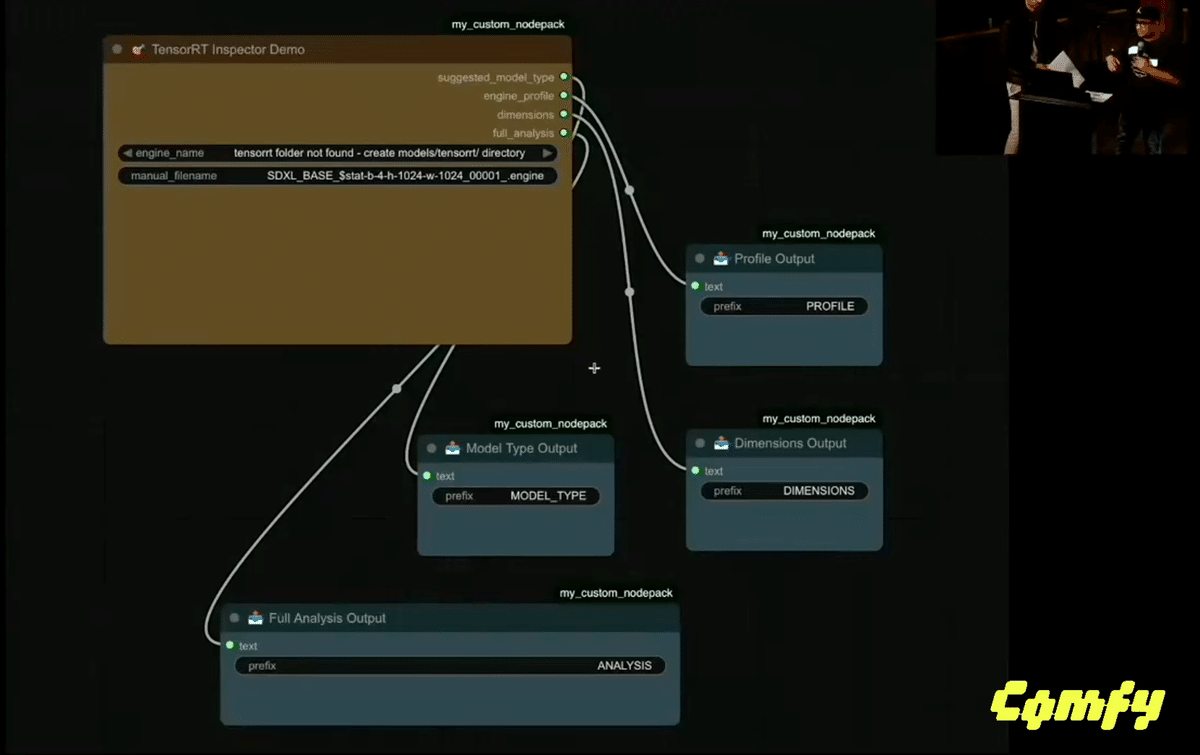

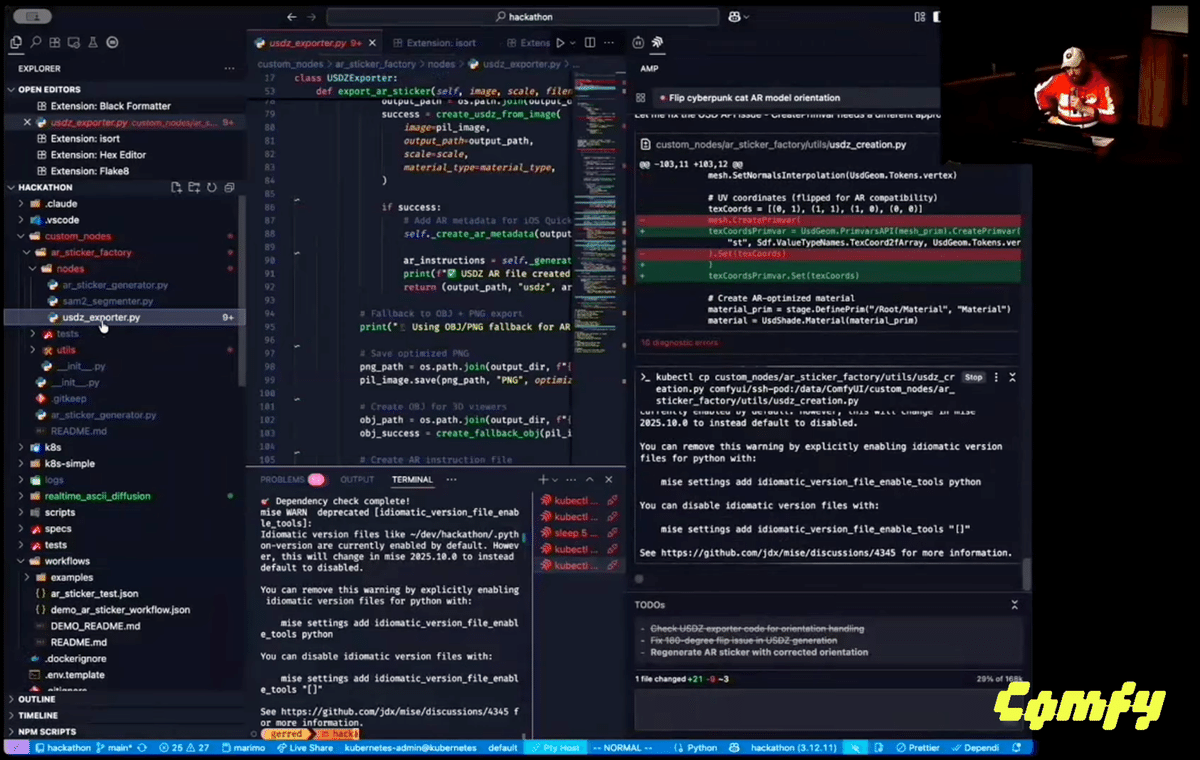

私はジャレッド・ディロンです。開発者トラックに参加しており、これは機能するはずです。それで、私が最終的に決めたのは、開発者トラックで、3つの異なるノードとそれに付随するワークフローを作成したことです。そして、画面全体を共有します。完璧です。それで私が行ったのは、iPhone上で。そこで私が最終的にやったことは、いくつかのStable Diffusionを取り入れて、そしてTensorRTです。そこでTensorRTを使ったARエクスポート用のカスタムノードを立ち上げました。テストとして、AirDropで人々に送れるARステッカー生成のワークフローを作成しました。それが実行されている間、これを一旦閉じます。しかし、基本的にはここにTensorRTを通過する3セットのノードがあります。

そして、これは8台のH100で立ち上げています。すぐにここで実行できます。そして、それを組み合わせてテクスチャ付きのオブジェクトフォーマットに変換します。そして、それを開くと、これらのうちの1つで、私が得られるものは、私が次にできることです。テクスチャマッピングを修正する必要があります。では、画面全体を共有します。これを実際にまず私の携帯にAirDropすることです。そして、私がすることは、まず私の携帯を手に取ることです。AirDropします。さて、私の携帯にステッカーがあります。そして、それを置くことができます。もしそのステッカーを開くと、ここでもテクスチャマッピングが少しずれていますが、急いでいます。画面の床に。ここのテーブルの方が少し簡単です。テクスチャが反転するまで、実際にここに来てオブジェクトを見ることができます。私たちはそれを動かすことができ、ここにテーブルの上に置くことができます。そして、ARに戻せば、実際に見ることができるようになります。そして、そのステッカーを貼ることができます。最終的にはそれをマルチプレイヤーにして、ドラッグして回ることもできるでしょう。

次はサンティアゴ、その次はアリエル、そしてカズキです。

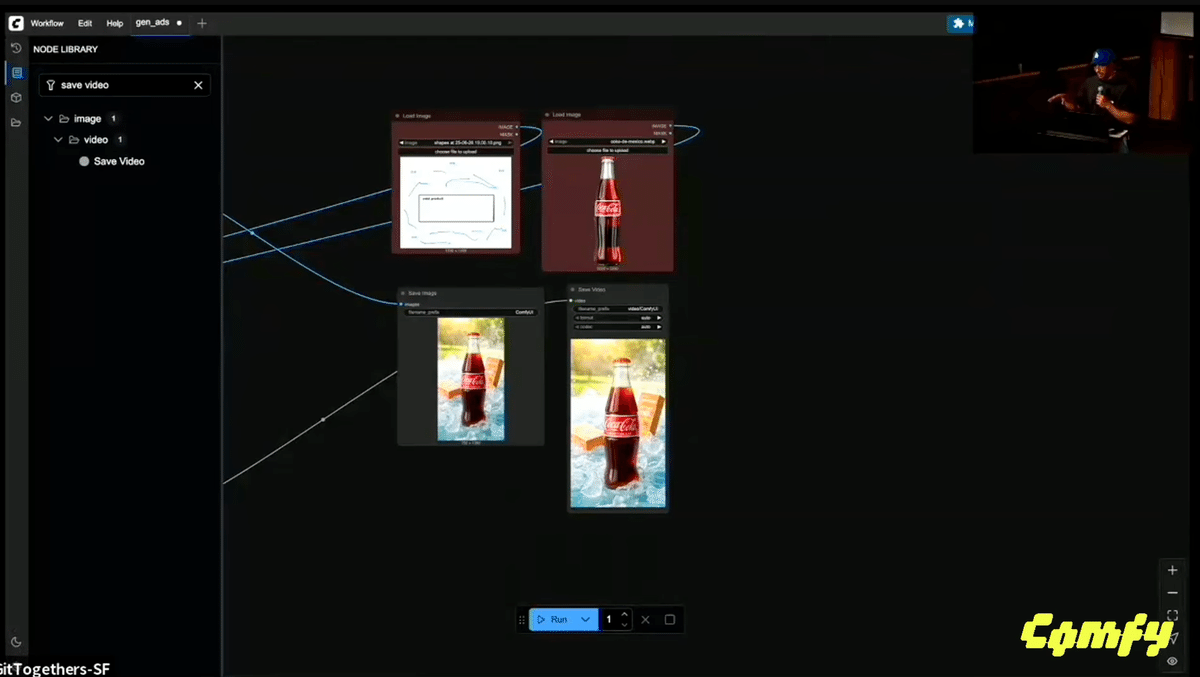

私はワークフローにいました。被写体を入力すると、ワークフロー、つまりアイデアは、その特定のシナリオの複数のイテレーションを作成し、そしてビデオを作成することです。これで、例えばInstagramやTikTokなどのさまざまなキャンペーンでテストでき、どのクリエイティブがそれらのキャンペーンでより良いパフォーマンスを発揮するかを確認するのに役立ちます。それらのクリエイティブでより良いパフォーマンスを発揮するでしょう。

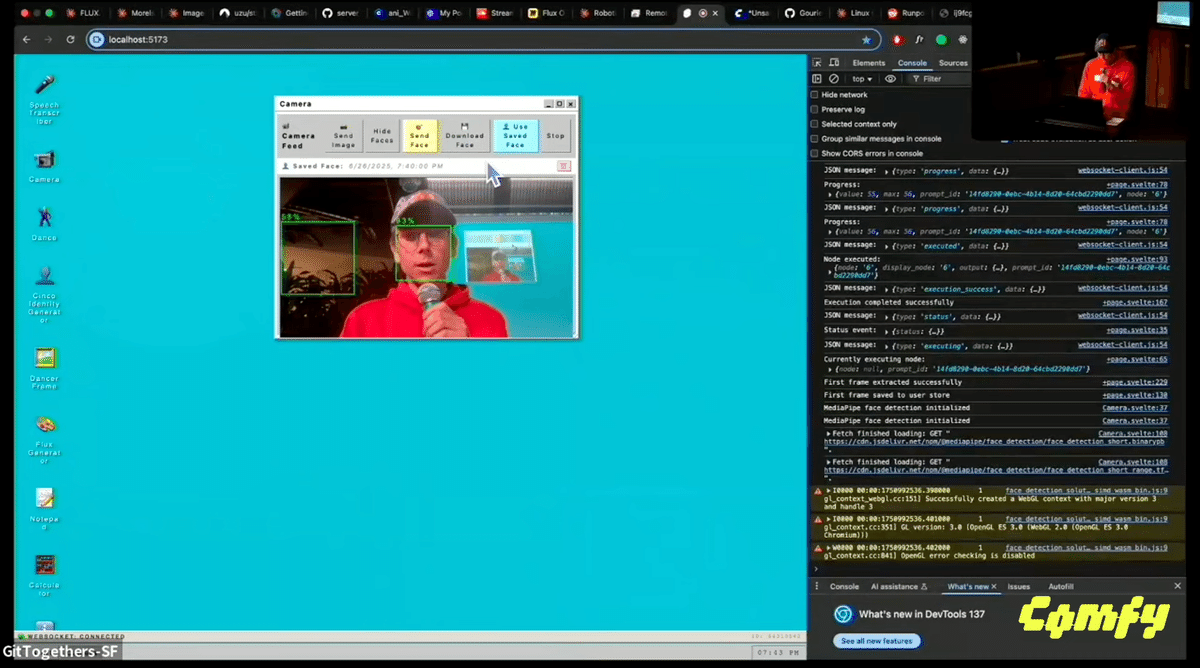

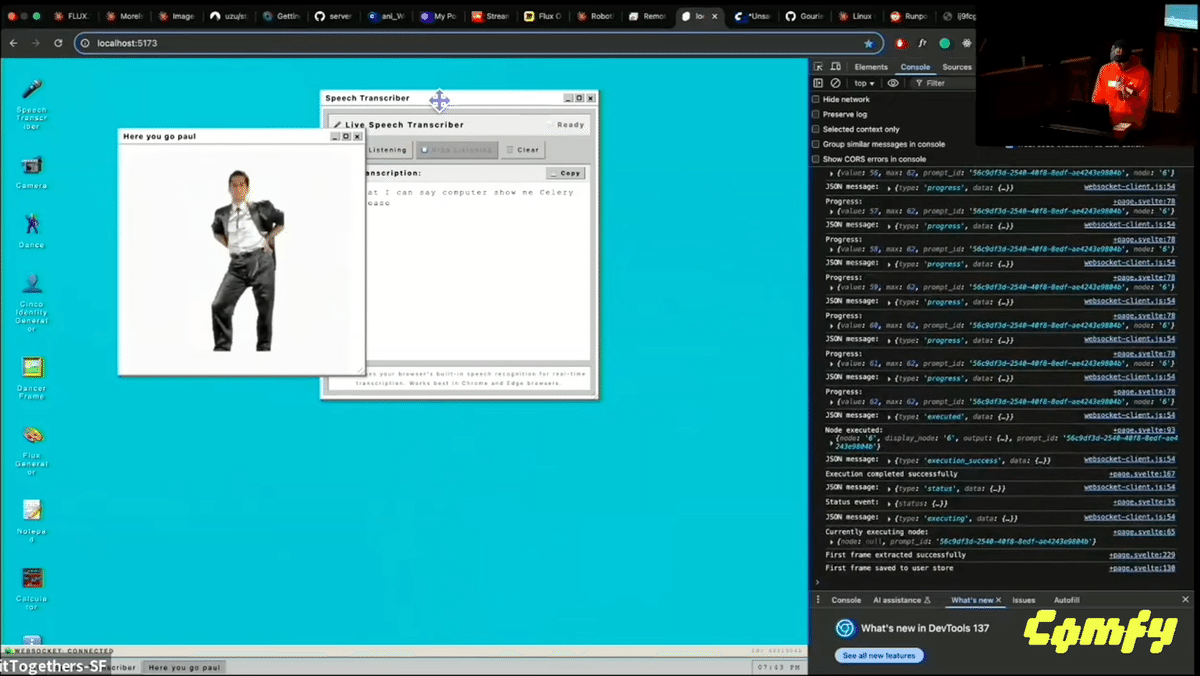

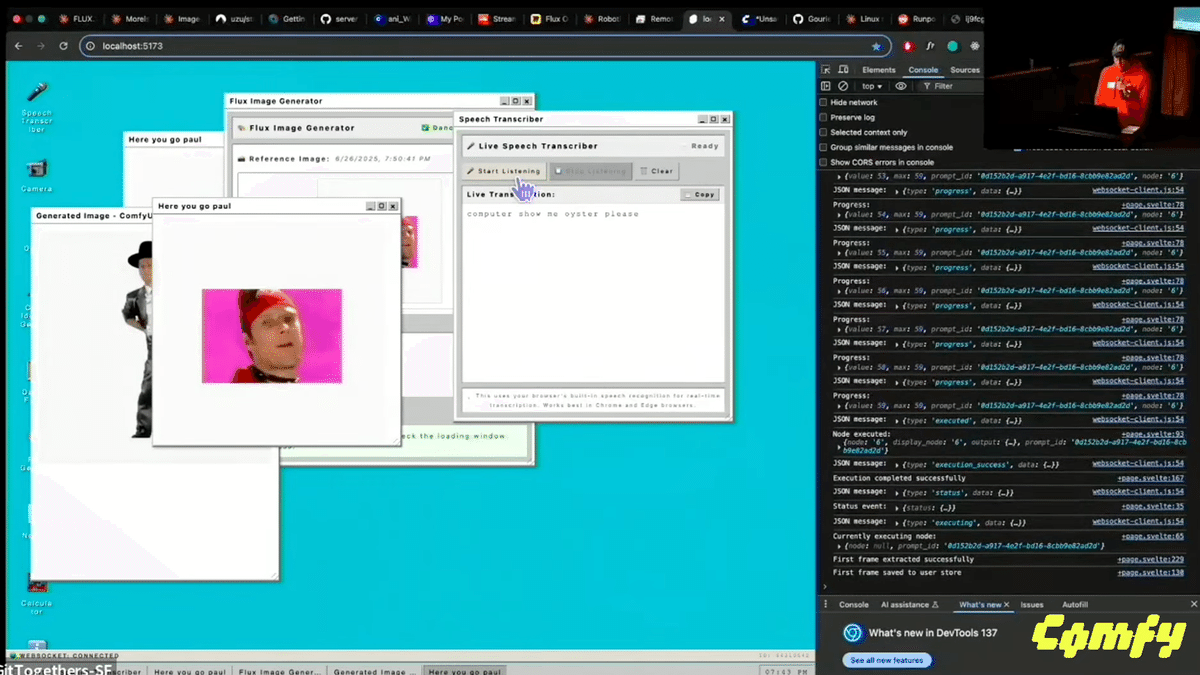

私はアリエルです。自分だけの小さなUIを作りました。そして、Comfyをバックエンドとして使用する開発者トラックに参加しています。おっと、少し見せすぎましたね。でも、ええ、ここにWindows 95風のインターフェースがあります。カメラで顔を検出してくれます。すでに顔は保存済みです。UIと話すこともできます。正直に言うと、このUIの一部は過去に作ったものです。話しかけることができます。「コンピュータ、サラリーマンを見せてください」と言えます。少し時間がかかります。でも、ええ、コンピュータは私の友達です。実際の私よりもずっと上手なダンサーにもなれます。それはいいですね。ええ、今日Flux Context Devがリリースされたのには本当に興奮しました。それを実行させて、そうですね、ここで本当に自分のライフスタイルを作り上げることができます。

もう一つ、これも試してみようと思います。でも、まずは私に帽子をかぶせてもらいましょう。これらはすべて非常に低解桑像です。コンピューター、オイスターを見せてください。そして、オイスター・スタイルを見ることができます。ええ、Comfyは素晴らしいです。聞いてくれてありがとう。

次はカズキ、次はエドワード、次はアビジャ、そしてニックです。

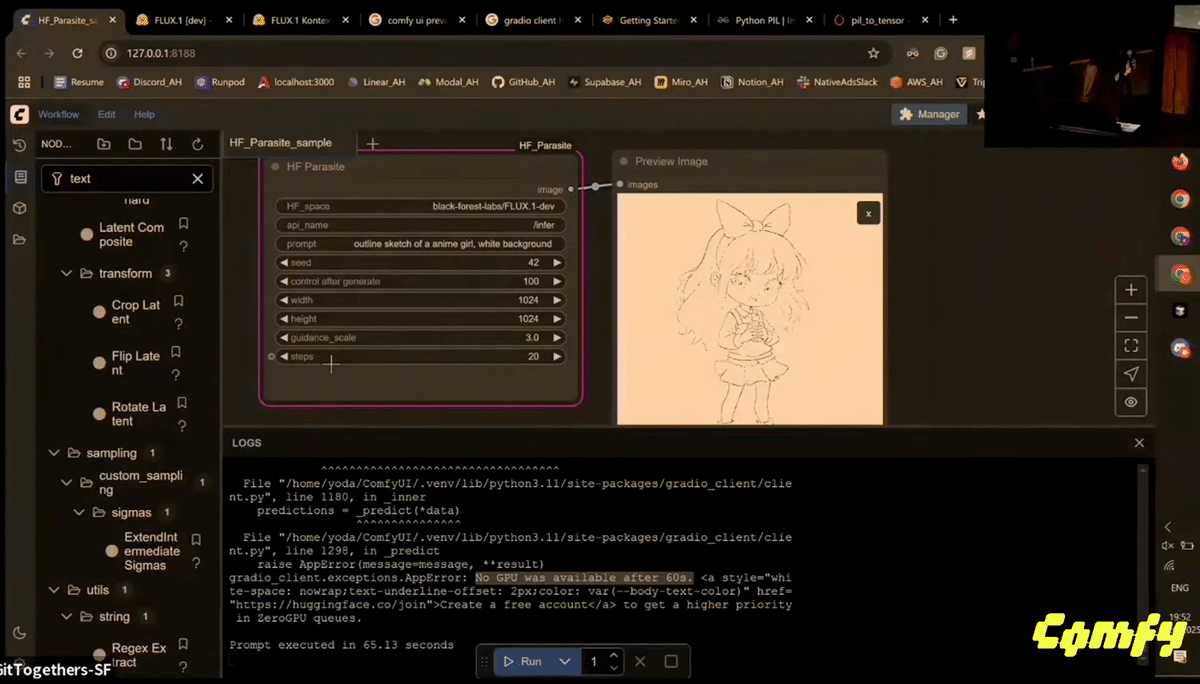

実際にRTX GPUを持っている人は何人いますか?そして、ハッキングフェーズで新しいモデルが出てくるような。これを見てください、「num inference steps」と書かれています。各単一スペースごとにカスタムノードを作成できるような、すべてのAPI名を解析して、あなたが使えるようにします。何にでも接続すること、それがビジョンです。簡単なことですが、その手順を見てください。残念ながら、私たちのHugging Faceスペースには利用可能なGPUがありません。私のアカウントのクレジットを使いました。後でぜひ試してみてください。ありがとうございました。

ありがとう。次はエドワード、そしてアブジットです。アレックスとニック、そしてファラズ。

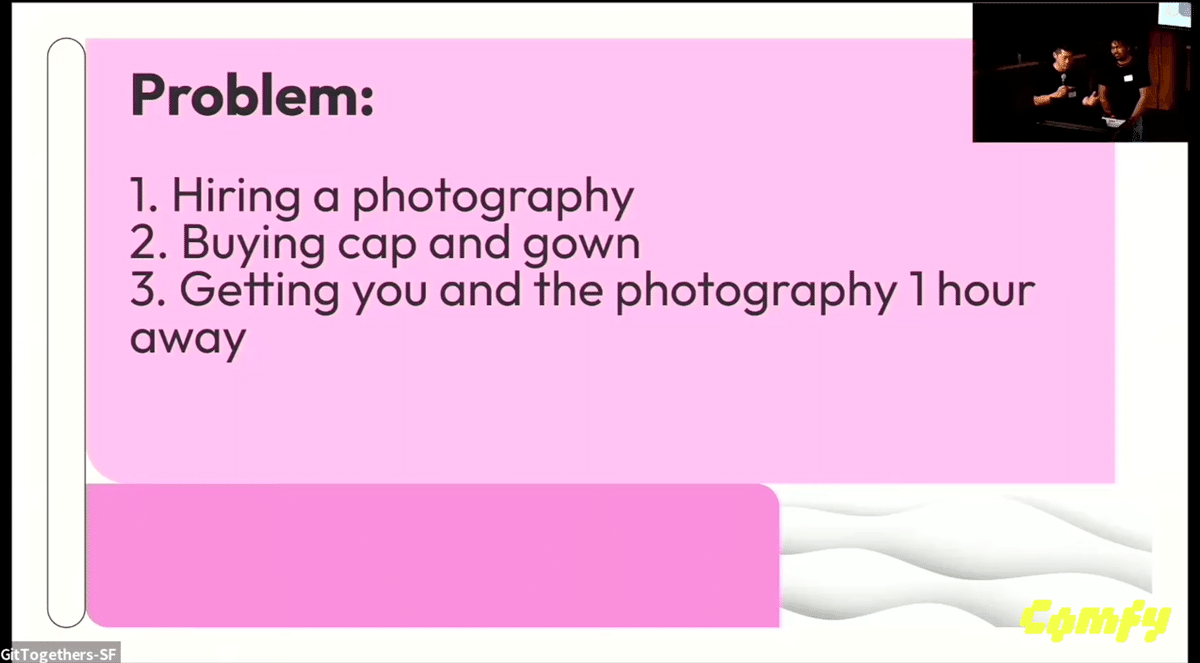

私はエドワードです。コンテンツトラックで、4人チームです。私たちにとっては、直面するであろう典型的な問題と、それにComfyUIをどのように適用できるかについて話していました。そして、あなたと写真家を1時間かけて別の場所に連れて行って写真を撮ることです。例えば、ボルダーであなたの写真を撮って、背景をボルダーにするようにします。これが私たちのワークフローです。いくつかの異なるプロンプトとモデルを試してみました。各タスクに最適なモデルが何かを見極めようとしていました。ご覧のように、卒業写真のサンプルがいくつかあります。15GBのファイルを時間内にダウンロードできず、動作するデモを用意できなかったという小さな問題に直面しましたが、私たちのアーキテクチャは完全に構築されており、本当に期待していました。いずれにせよ、私たちのワークフロー全体がここにあります。

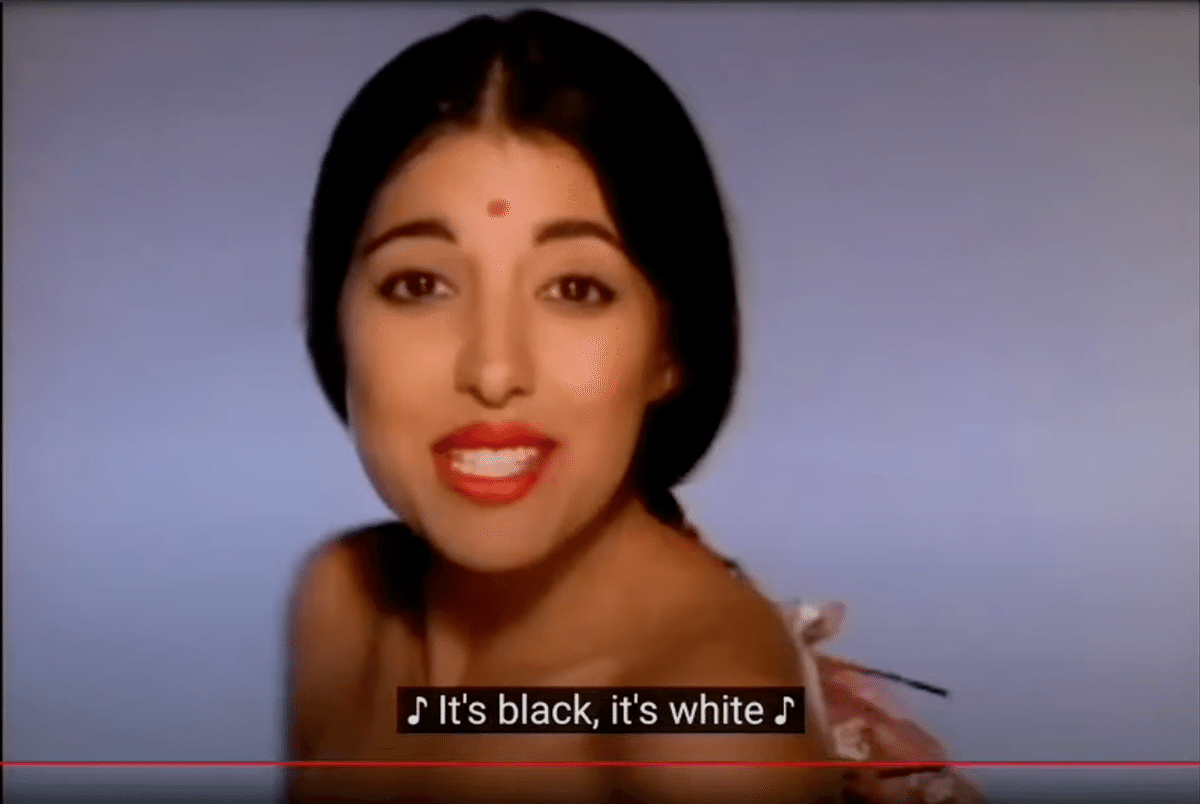

ファラズになります。写真を組み合わせて素敵な小さなエンジンを作りました。どうぞ。インクルーシビティの精神で、マイケル・ジャクソンの「ブラック・オア・ホワイト」のミュージックビデオについて考えていました。それで、Fluxからたくさんの写真を手に入れました。そうやって思いついたのです。

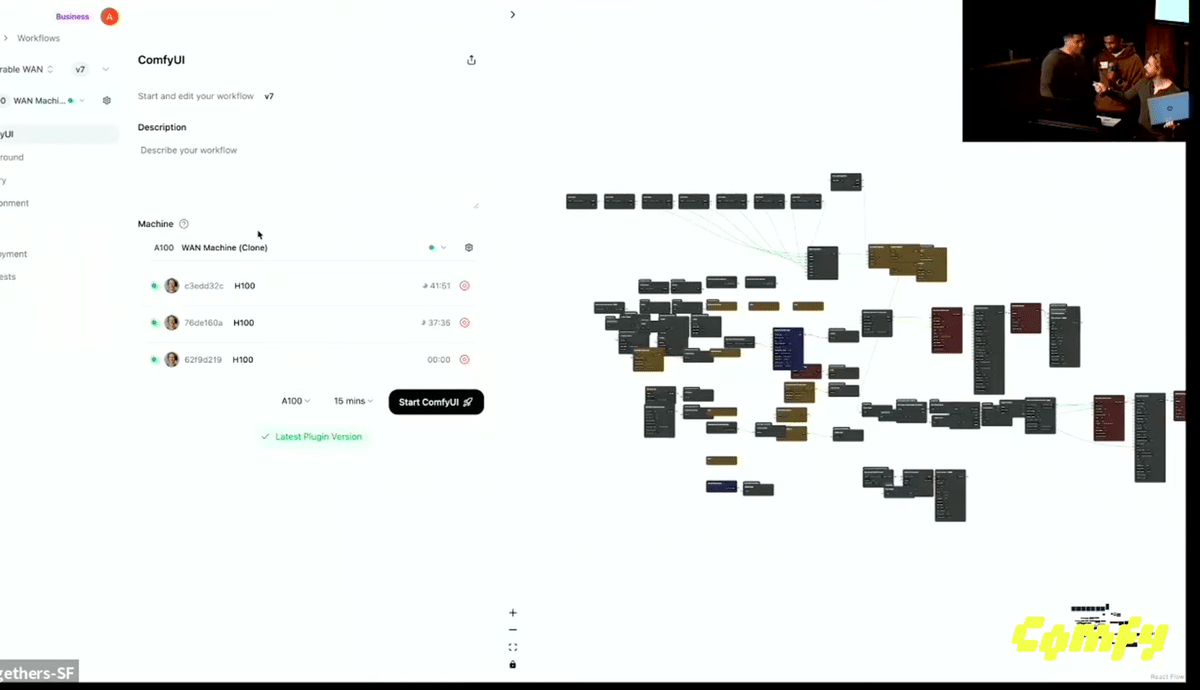

ニックはここの専門家です。これは私が経営しているスタートアップ、Comfy Deployです。アブヒジットがクリエイティブなコンセプトを思いつきました。でも、もし動けばの話ですが、動きません!私たちのH100は全部死んでると思います。こうなるとは思わなかった。

時々動きますが、ワークフローを想像してみてください。ノードがあります。私たちはレイテントをあちこちに渡し、それらを使って何かをします。最終的にはそれらをデコードして、ビデオにつなぎ合わせる画像にします。多くの便利な機能が組み込まれているので、より少ないステップで済みます。昨年行われた実行バージョンでは、Comfyがノードを決定する方法を、深い再帰的なものから変更しました。なので、ループが使えるようになり、これはループを使っています。任意の数の画像を取り、それぞれを処理して開始と終了を与えます。ノードを見ればもっと印象的です。マスクを使って、画像を取り、時間とともにゆっくりとマスクを減らしていきます。Framepackとは少し違いますが、最終的な結果として、スライディングウィンドウ上でコンテキストを認識した開始と終了ができます。

「ブラック・アンド・ホワイト」のミュージックビデオを見れば、この人は彼女に変身し、彼女は彼に変身し、彼は彼女に変身し、そしてそのように続いています。

これはVisionモデルですか?それとも1対1でやる感じですか?ゲームでの補間?とてもいいですね。ああ、でもこれはロードされないと思います。

接続できそうにないので、ラップトップから直接デモを行います。私の名前はファラズで、コンテンツトラックに参加しています。何ができるかというと、どんなニュースでも取り込んで、ニュースキャスターのビデオを出力するだけです。ここで重要なのは、ウォルター・クロンカイトという非常に古いニュースキャスターを再現したことです。それで私がしたことは、その顔を使い、その参照画像を使ってその全体の画像を作成し、そしてワンショット音声クローニングを使って、テキストを音声に変換することができます。

私が直面した問題のほとんどは5090関連でした。でも、これが少しでも助けになればと思います。マイクを手に持ってデモをしてみます。

(ラップトップを手で持ちながら・・・)

ニュースキャスター「ほぼ20年間、結局のところ、私たちは夕方にこのように会ってきました。これは移行の時、バトンタッチの時です。ベン・グリオン空港と軍事施設近辺を狙った30発のミサイル。リアルタイム。イスラエルの防空システムがほとんどを迎撃しましたが、いくつかはテルアビブに着弾しました。激しい戦闘が夜通し続き、イランとイスラエルが直接的な軍事攻撃を行った。太平洋時間の午後2時10分頃に始まり、イスラエルが発射しました。」

重要なのは、このビデオはつなぎ合わせることで、好きなだけ長くすることができるということです。30秒や40秒のような動画を作成している企業がありますが、このビデオはワンショットで3分まで行くことができます。3分後には切り替えを始めなければなりません。背景、テキスト、すべてがワークフローです。数字は持っていませんが、良い点は、生成されるビデオの量です。ビデオを生成するのにかかる時間は、実際にレンダリングするのにかかる時間よりもはるかに短いです。皆さん、ありがとうございます。

表彰式

まず、NVIDIAに感謝の意を表したいと思います。NVIDIAのコーリーさんをステージにお迎えし、5090を実際に見せていただきましょう。

皆さん、お招きいただき本当にありがとうございます。皆さんが作っているものすべてに、私たちは本当に誇りに思っていると言いたいです。皆さんが2時間で作り上げたものを見るのは、とてもエキサイティングでした。私たちは、皆さんがAIで、特にこのようなローカルGPUで何を作り出せるかに非常に興奮しています。私たちをここに呼んでくださったComfyに感謝します。今夜の勝者の方は、後で私たちを見つけてください。あなたが作ったものについてもっとお話ししたいですし、私たちのコミュニティであなたの作品をいくつか共有できるかもしれません。本当にありがとうございました。

ありがとうございます。そして次が最もエキサイティングなパートです。DevTracksの審査員の皆さんをステージにお迎えし、賞品を発表していただきましょう。

さて、グループ番号12番の方、ステージにお上がりください。

おめでとうございます。

https://github.com/gerred/stickerkit

さて、Tシャツを受け取るグループが2つあります。ComfyUI Tシャツ、そしてあなたは世界で唯一それを持つことになります。さて、Tシャツの最初の受賞者は、グループ番号34番です。HuggingFace Space Node。

https://github.com/Kazuki-Yoda/ComfyUI_HF_Parasite

やった!本当にありがとう。

Comfyはどこだ?ああ、ここにいた。よし、写真を撮ろう。

そして、開発ワークフローのためのTシャツ受賞者がもう一人。グループ番号5番、彼の本当に素晴らしいオールドスクールなWindows 95ラッパーです。

3、2、1、カンフィー。

ワークフロートラックの準備はいいですか?早速ですが、第3位はTシャツを獲得したロヴィッツです。Tシャツが欲しかったんでしょ、だからあげるよ。Tシャツ欲しかったんだよね?もらった?28番、エイデンがいます。エイデンさん、ステージにお願いできますか?OK、Tシャツを受け取ってください。

よし、チーム23番、ランボー・リーさん、こちらへ上がって賞品を受け取ってください。

やあ、相棒、元気かい?おめでとう。本当にありがとう。楽しんで!

https://github.com/runshouse/comfyui_hackathon?tab=readme-ov-file

ComfyUIは、熱心な開発者に上限なしの報酬を提供しています。

もし興味があれば、今すぐチームに加わりましょう! http://comfy.org/careers

日本人の依田和樹さん、素敵な作品、おめでとうございます!

Originally published at note.com/aicu on July 1, 2025.

Comments