2025年7月28日にリリースされたオープンな動画モデル「Wan2.2」、オープンリリースでライセンスモデルも商用利用可能な次世代動画モデルです。ローカルGPUやクラウド、MacBook(M4)などに横断的にインストールして安定性を評価してみた手順書とデータを公開します。

https://corp.aicu.ai/ja/wan-20250728

WindowsやMacで動かすには

リリースがアナウンスされていますが、ComfyUI Desktopの自動更新には原稿執筆時点(7/29)では、最新のバージョンが配信されていないようです。

https://www.comfy.org/download

Windowsならポータブル版をアップデートすれば使えるはずです。

https://docs.comfy.org/installation/comfyui_portable_windows

なお未確認情報ですが、色の問題と、クラッシュする可能性が報告されていますので、慌てずにしばらく待ったほうがいいかもしれません。それでもやってみたい人はソースからインストールを実行してみましょう。

https://github.com/comfyanonymous/ComfyUI

venvによる仮想環境がある場合は適用してから実行しましょう

git clone https://github.com/comfyanonymous/ComfyUI.git

./.venv/bin/python3 -m pip install -r ./requirements.txt

python3 main.pyWan2.2-5B-ti2v

まずは最も軽量なWan2.2-5B-ti2vを動かしてみます。

https://docs.comfy.org/tutorials/video/wan/wan2_2

ComfyUI公式のサンプルワークフローはこちらです。

https://note.com/api/v2/attachments/download/d0fdb2dee27e1e9c7c32f60bf3f08c44

Wan22ImageToVideoLatentというモデルでエラーが起きた場合、まずはComfyUI Desktopのバージョンが0.3.46以降になっているか確認しましょう。

Some nodes require a newer version of ComfyUI (current: 0.3.45). Please update to use all nodes.

Requires ComfyUI 0.3.45: Wan22ImageToVideoLatent

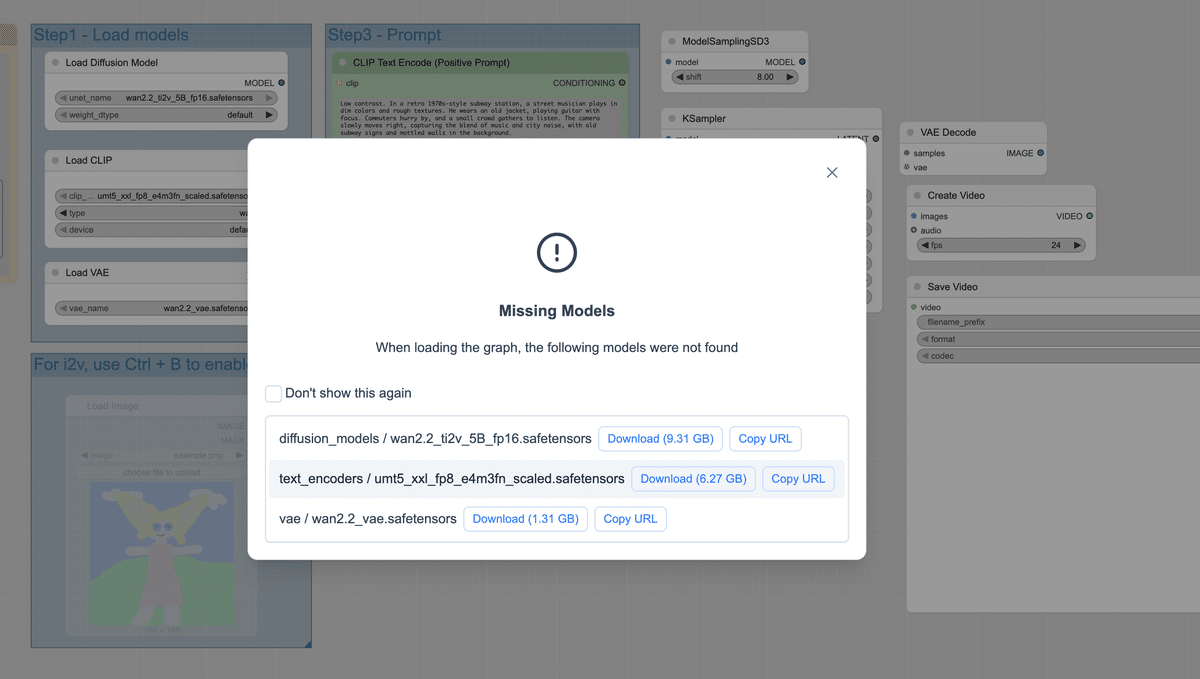

必要なモデルについてのダウンロード&インストール先が表示されますので入手していきます。

サンプルプロンプト

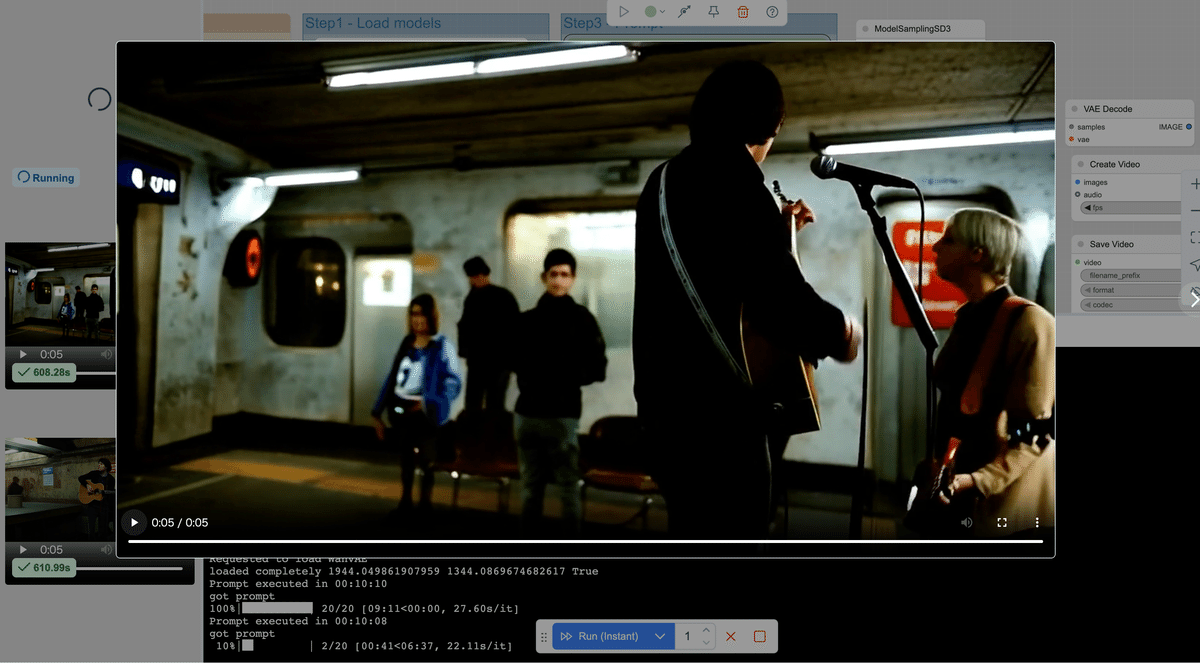

Low contrast. In a retro 1970s-style subway station, a street musician plays in dim colors and rough textures. He wears an old jacket, playing guitar with focus. Commuters hurry by, and a small crowd gathers to listen. The camera slowly moves right, capturing the blend of music and city noise, with old subway signs and mottled walls in the background.

Wan2.2-5B-ti2vはあまり美しいとは言い難いですが、それでも難度の高いシーンを描写しています。参考まで、WindowsでGTX4090の環境であれば240秒ぐらいで5秒の動画が生成できています。

Wan2.2-5B-ti2v 5sec in 600 sec (V100) pic.twitter.com/32NBiAvsqW

— AICU - つくる人をつくる (@AICUai) July 28, 2025

他のモデルにも挑戦してみる

今回のWan2.2初期リリースは3つのモデルがリリースされており、パラメータ数も大幅に変わります。

ハイブリッドモデル「Wan2.2-TI2V-5B」(5B)

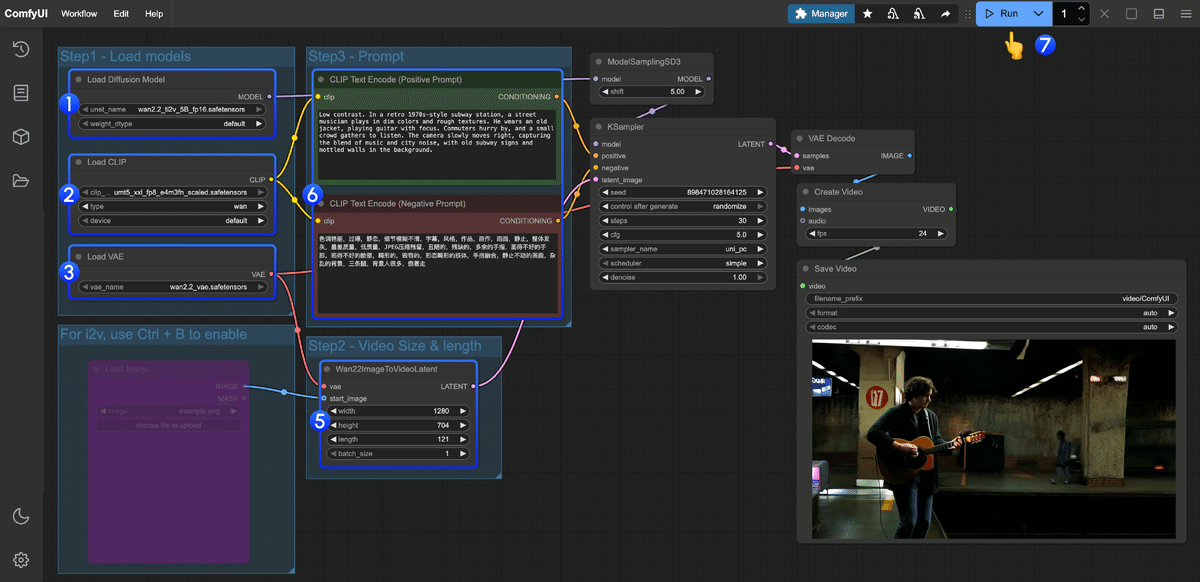

text-to-video と image-to-video の両方を単一のモデルでサポートします。上記で解説した通り、ワークフローは非常にシンプルです。

①Load Diffusion Model ノードが wan2.2_ti2v_5B_fp16.safetensors モデルをロードしていることを確認してください。

②Load CLIP ノードが umt5_xxl_fp8_e4m3fn_scaled.safetensors モデルをロードしていることを確認してください。

③Load VAE ノードが wan2.2_vae.safetensors モデルをロードしていることを確認してください。

④(オプション) 画像からビデオへの生成を実行する必要がある場合は、ショートカット Ctrl+B を使用して Load image ノードを有効にし、画像をアップロードできます。

⑤(オプション) Wan22ImageToVideoLatent ノードでは、サイズ設定とビデオフレームの合計数 (長さ) を調整できます。

⑥(オプション) プロンプト (ポジティブおよびネガティブ) を変更する必要がある場合は、CLIP Text Encoder ノードで変更してください。

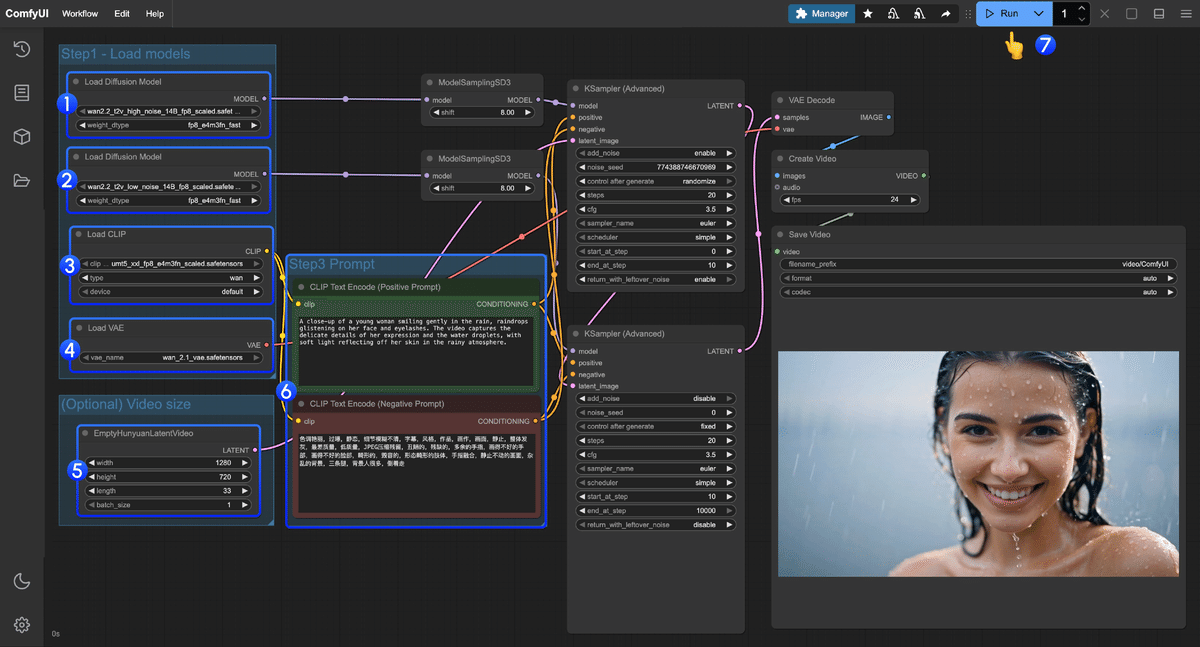

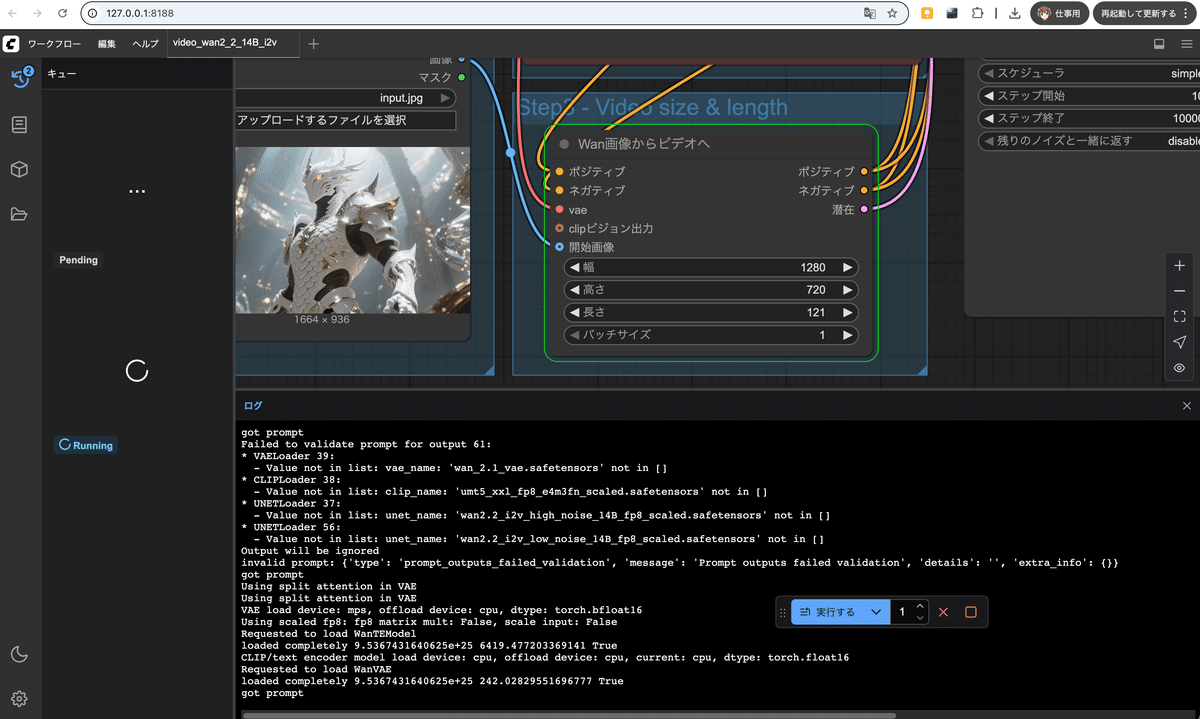

画像からビデオ「Wan2.2-I2V-A14B」(14B)

コンテンツの一貫性とスムーズな動的プロセスを維持しながら、静止画像を動的なビデオに変換します。

①最初の Load Diffusion Model ノードが wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors モデルをロードしていることを確認します。

②2 番目の Load Diffusion Model ノードが wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors モデルをロードしていることを確認します。

③Load CLIP ノードが umt5_xxl_fp8_e4m3fn_scaled.safetensors モデルをロードしていることを確認します。

④Load VAE ノードが wan_2.1_vae.safetensors モデルをロードしていることを確認します。

⑤(オプション) EmptyHunyuanLatentVideo ノードでは、サイズ設定とビデオフレームの合計数(長さ)を調整できます。

⑥(オプション) プロンプト (肯定的および否定的) を変更する必要がある場合は、手順 5 の CLIP テキスト エンコーダー ノードで変更してください。

このワークフローのポジティブプロンプトです。

A close-up of a young woman smiling gently in the rain, raindrops glistening on her face and eyelashes. The video captures the delicate details of her expression and the water droplets, with soft light reflecting off her skin in the rainy atmosphere.

(雨の中、優しく微笑む若い女性のクローズアップ。顔やまつげに雨粒がキラキラと輝いています。この動画は、雨の空気の中で彼女の肌に反射する柔らかな光と、繊細な表情や水滴のディテールを捉えています。)

ネガティブプロンプトに中国語があるのがWanの特徴ですね

色调艳丽,过曝,静态,细节模糊不清,字幕,风格,作品,画作,画面,静止,整体发灰,最差质量,低质量,JPEG压缩残留,丑陋的,残缺的,多余的手指,画得不好的手部,画得不好的脸部,畸形的,毁容的,形态畸形的肢体,手指融合,静止不动的画面,杂乱的背景,三条腿,背景人很多,倒着走

(明るい色、露出オーバー、静止、ぼやけた細部、字幕、スタイル、アートワーク、絵画、画像、静止、全体的に灰色、最低品質、低品質、JPEG 圧縮残留物、醜い、不完全、余分な指、下手な手、下手な顔、変形、傷ついた、奇形の手足、癒合した指、静止画像、雑然とした背景、3 本の足、背景に多数の人物、後ろ向きに歩く)

高ノイズと低ノイズの2つのノードと、CLIP、そしてVAEはWan2.1のものを使用するのが特徴です。5Bに関してはVRAM8GBで動作するように設計されているようです。

テキストから画像「Wan2.2-T2V-A14B」(14B)

映画レベルの美的コントロールと正確なセマンティックコンプライアンスを備えたテキスト説明から高品質のビデオを生成します。

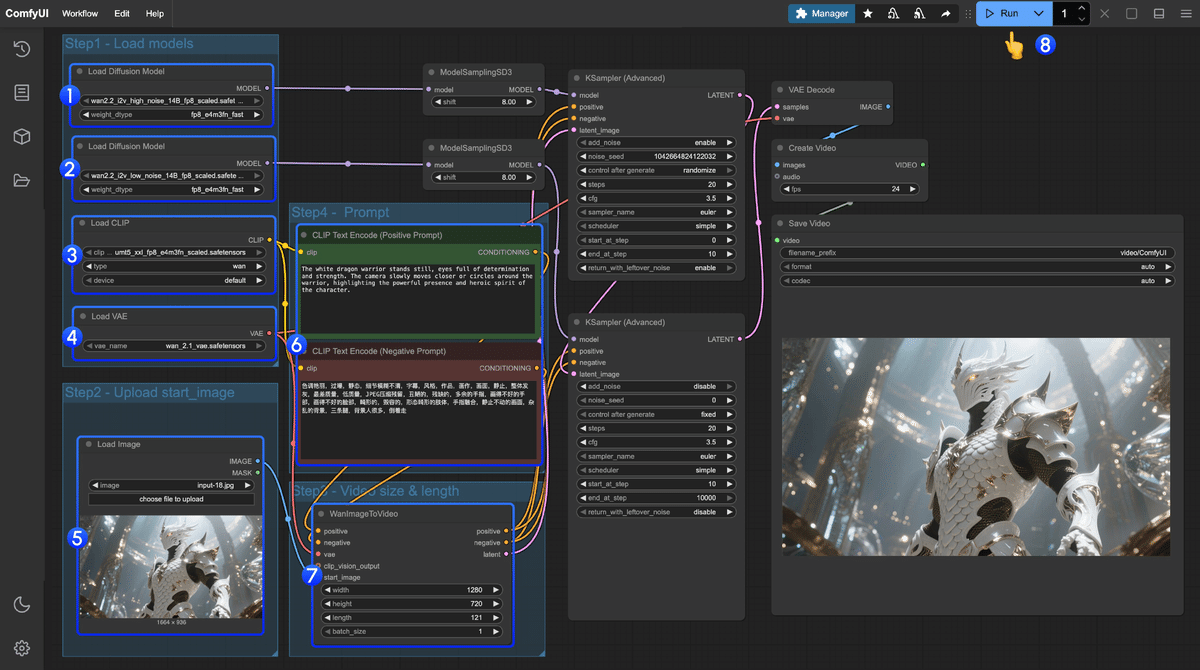

入力画像 ワークフロー

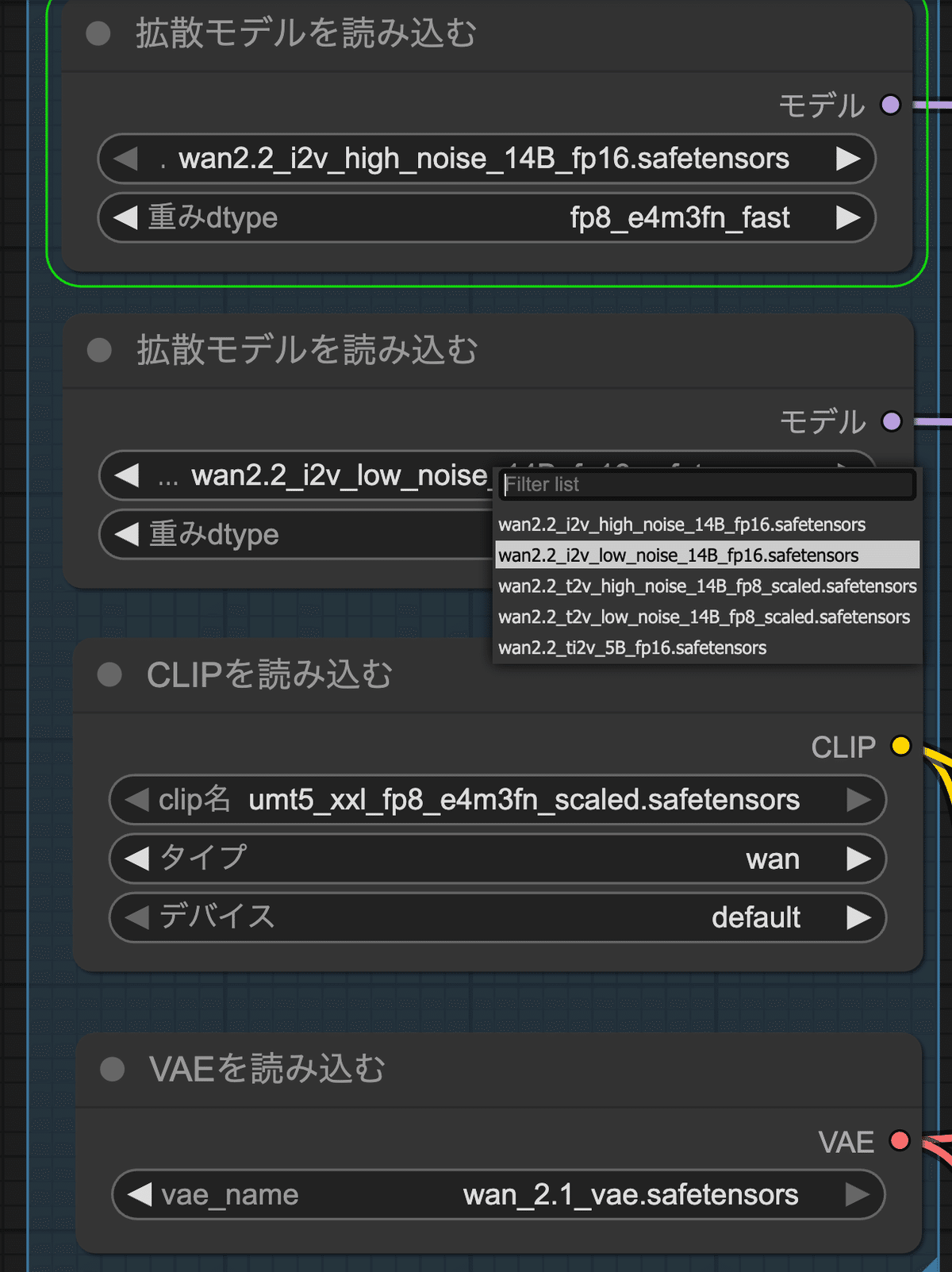

①最初の Load Diffusion Model ノードが wan2.2_i2v_high_noise_14B_fp8_scaled.safetensors モデルをロードしていることを確認してください。

②2 番目の Load Diffusion Model ノードが wan2.2_i2v_low_noise_14B_fp8_scaled.safetensors モデルをロードしていることを確認してください。

③Load CLIP ノードが umt5_xxl_fp8_e4m3fn_scaled.safetensors モデルをロードしていることを確認してください。

④Load VAE ノードが wan_2.1_vae.safetensors モデルをロードしていることを確認してください。

⑤Load Image ノードで、初期フレームとして使用する画像をアップロードします。

⑥プロンプト(ポジティブおよびネガティブ)を変更する必要がある場合は、手順 6 の CLIP Text Encoder ノードで変更します。

⑦(オプション)EmptyHunyuanLatentVideo では、サイズ設定とビデオフレームの合計数(長さ)を調整できます。

The white dragon warrior stands still, eyes full of determination and strength. The camera slowly moves closer or circles around the warrior, highlighting the powerful presence and heroic spirit of the character.

(白竜の戦士は、決意と力強さに満ちた瞳でじっと立っている。カメラはゆっくりと戦士に近づき、あるいは周囲を回りながら、その力強い存在感と英雄的な精神を際立たせている。)

t2vではなくi2vです。☆公式マニュアルにも間違いがあります。

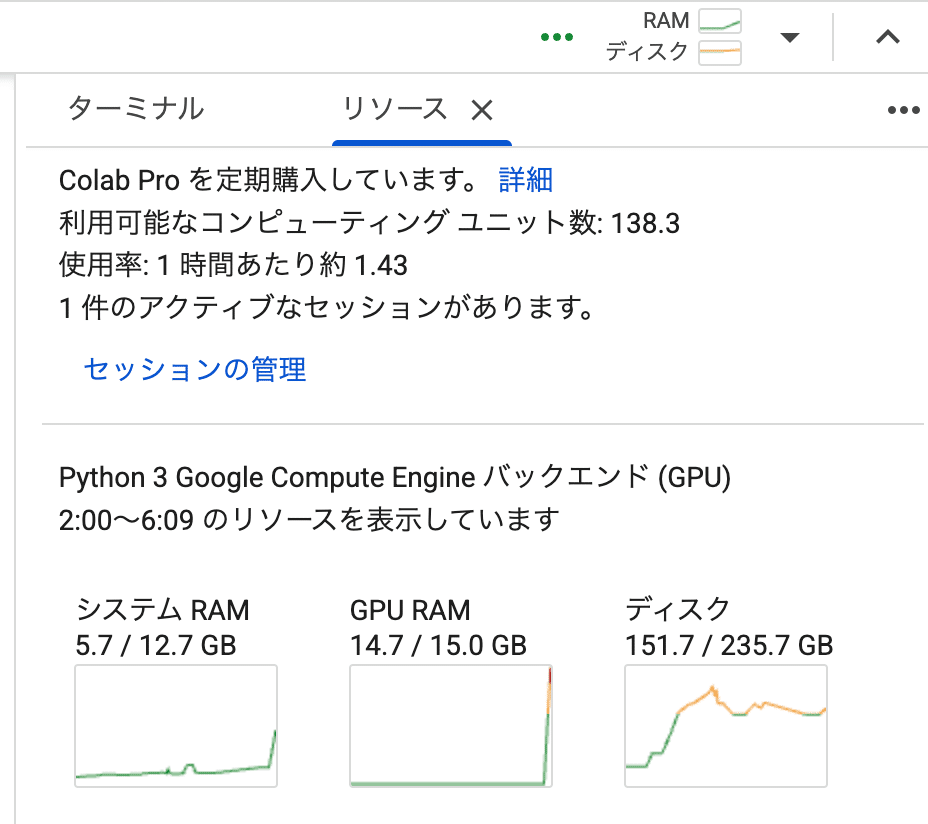

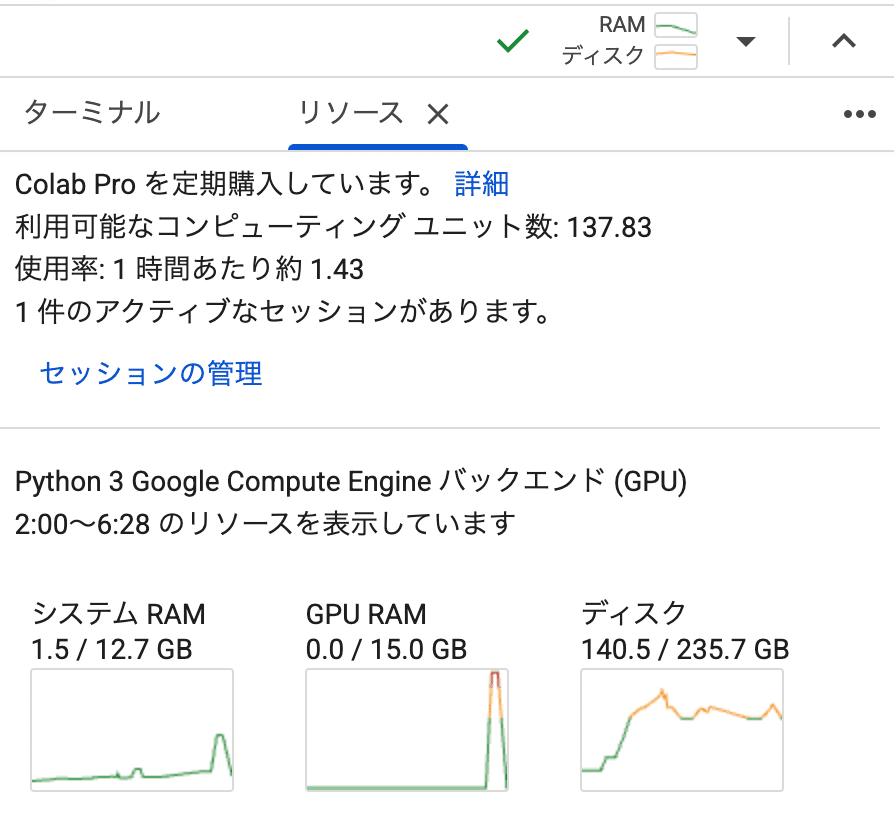

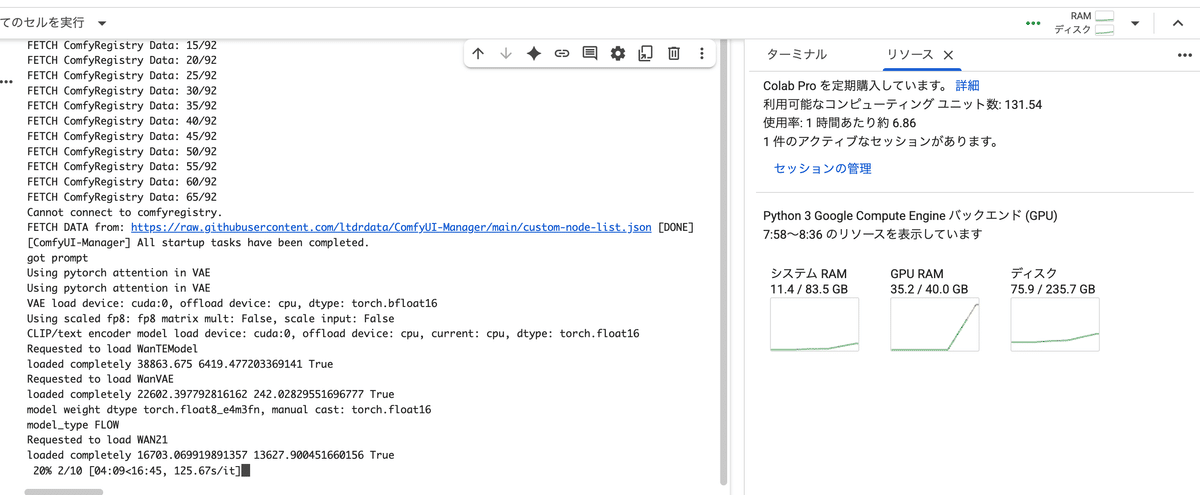

Google Colabでの不具合(T4 GPU環境)

5Bは比較的問題なく動作するようですが、問題は14Bの動作です。T4 GPU(VRAM15GB)で の Google Colabで実験した例ですが、途中でクラッシュするようです。

クラッシュした場合は、最後のセルを実行しなおします。トンネルのURLは変わります。

A100 (VRAM40GB)で試す場合は、より安定に状況を確認できます。

しかし127.97s/it、つまり1イテレーションあたり2分ぐらいかかりますので、10イテレーションで20分といった速度感です。

A100の Google Colab コンピューティングユニット(CU)は 1 時間あたり約 6.86なので、1動画あたり2CUは消費するということを覚えておくといいかもしれません。

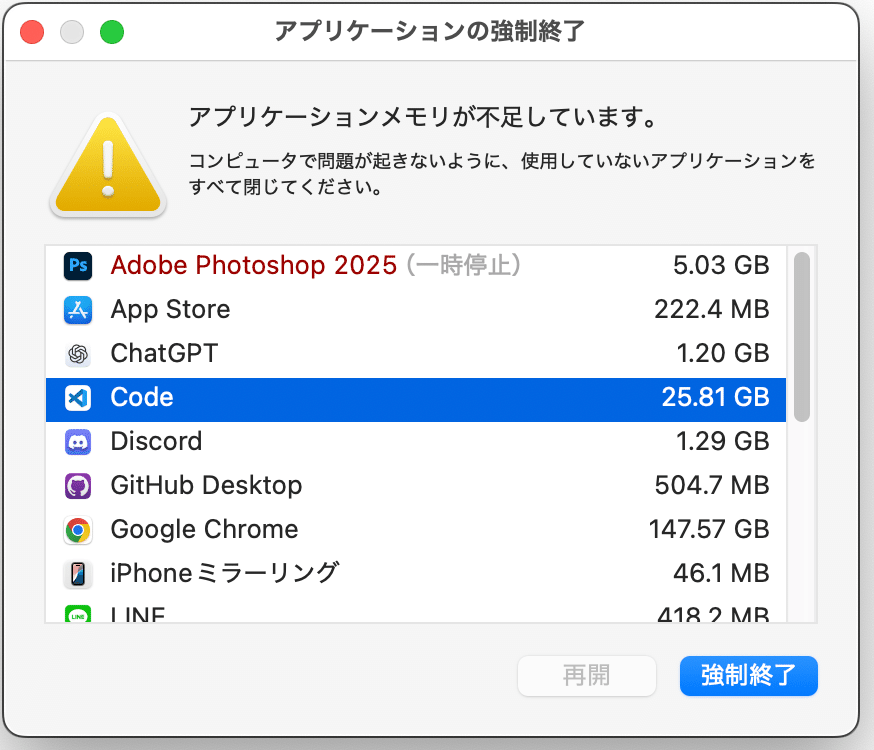

Mac Book Pro (M4) 128 GBでの実験の不具合

ユニファイドメモリのおかげで128GBまで使えるMacBook Pro (M4)の場合はどうでしょうか。

快調に推論している様子ですが…途中で突然落ちてしまいます。

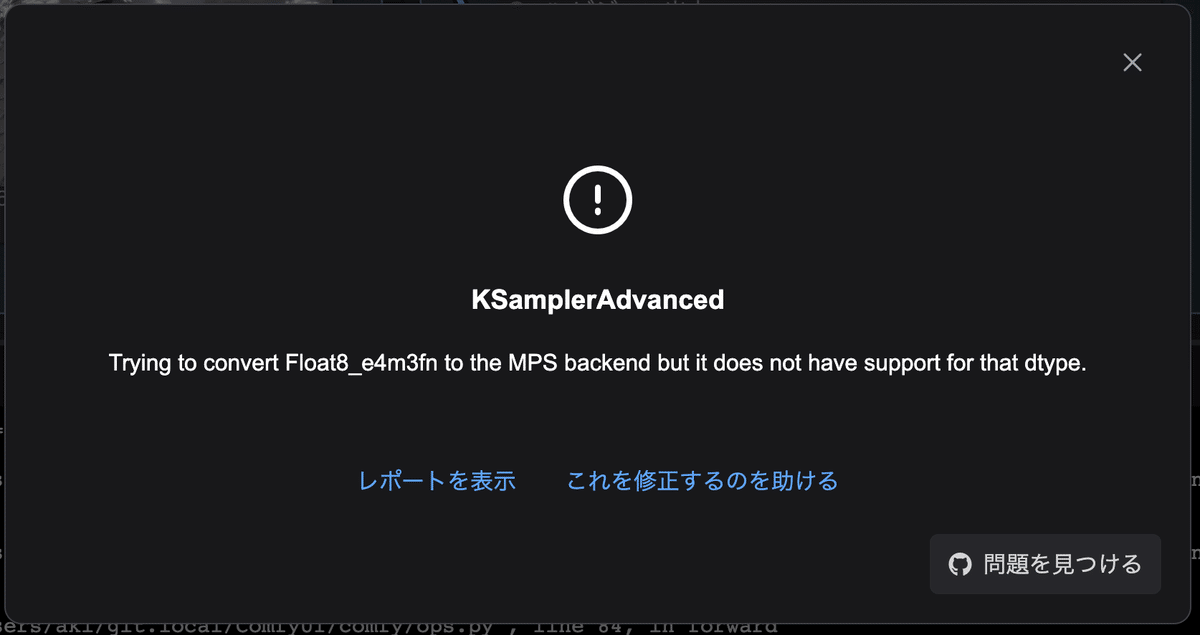

エラーの核心は

TypeError: Trying to convert Float8_e4m3fn to the MPS backend but it does not have support for that dtype.Mac(MPS)での問題

Wan2.2 モデルは float8 (FP8: Float8_e4m3fn) という最新の軽量データ型を使っています。これは主に NVIDIA GPU (Ampere以降) や CUDAバックエンドで最適に動作する設計です。しかしMac Bookでの環境は 「Device: mps」つまり、Apple Silicon の Metal Performance Shaders バックエンドで、MPSはFP8非対応です。

MPS(Apple Silicon)での制限

AppleのMPSバックエンド(Metal)サポート状況

float32 あり

float16 (half) 一部対応

bfloat16 限定的

float8(e4m3)❌ 未対応

したがって、Wan2.2などFP8モデルはMPSでは動かせません。

FP16版のモデルを選ぶ(もし提供されていれば)

将来的にはFP16互換版もある可能性があります(例:wan2.1_i2v_14B_fp16.safetensors)。ただし、現時点のWan2.2はFP8ベースで最適化されているので、Mac単独での実行はしばらくあきらめたほうがよさそうです。

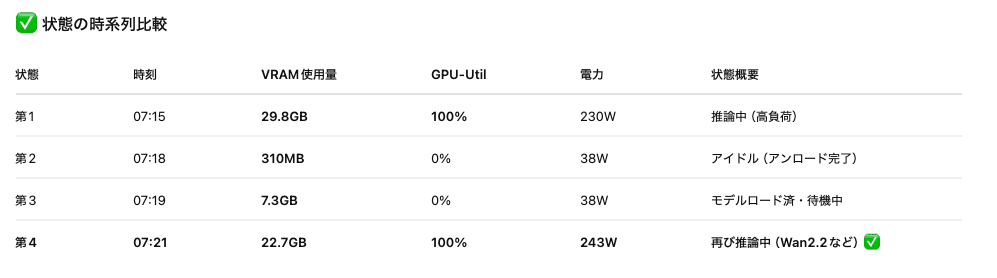

共有ComfyUIでも試用中

AICU AIDX Labが使用している「共有ComfyUI 2号機」でもハイブリッドモデル「Wan2.2-TI2V-5B」(5B)が動作しています。14Bも実験中ですが、プロセスの管理が難しそうです。

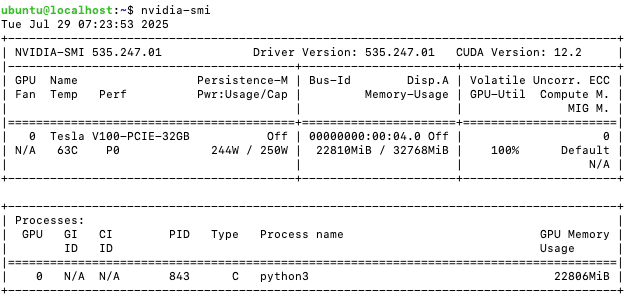

なおこのサーバーは さくらインターネットの「高火力 VRT」を利用しており、以下のようなスペックになります。

-

4Core-56GB-V100x1

-

GPU: Tesla V100 (32GB VRAM)

5Bでの推論速度は5分のビデオ、毎回のプロンプトでおおよそ 9分強(~10分)/20ステップ の処理時間です。

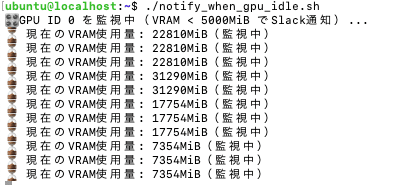

動画生成中のGPUの様子です。

監視スクリプトを開発することで安定性を増すことができます。

このようにして、品質高く維持するために、さまざまなAI技術を活用しています。実際の運用や利用上では軽量化モデルなどの検討をしたほうが良さそうです。

https://www.aicu.jp/pricing-plans/list

共有ComfyUIは「AICU Lab+プラン」に名称変更予定です。またあらたに「レンタルAIプラン」が加わりました。クラウドGPUとローカルGPUを両方利用できるプランです。

みなさまのご利用をお待ちしております。

Google Colabノートブックについては試用中でもあるので、ペイウォールの先にて公開させていただきます。

この Google Colab向け notebook は ComfyUIでのWan2.2を実験的に起動できるように解説・設定しています。

—

この記事の続きはこちらから https://note.com/aicu/n/n072491018e0c

Originally published at note.com/aicu on July 28, 2025.

Comments