ComfyUI公式配信のアーカイブです。今回は、新しく登場した動画生成モデル「WAN 2.2」のコントロール機能「VACE」について、高度なワークフローを使いながら徹底的に解説します。

https://twitter.com/i/broadcasts/1OyKAjzdMbgGb

-

はじめに&Comfyの最新情報

-

スペシャルゲスト Julianの登場

-

本日のテーマ:オープンソースとVACE 2.2

-

ワークフローの概要とカスタムノードについて

-

ワークフローの詳細解説

-

ワークフローの入力設定(定数)

-

デプスマップの生成

-

Florence 2によるプロンプト自動生成

-

モデルの読み込み(WAN & VAE)

-

VACEコントロールモジュールの解説

-

WAN video wrapperローダーとLora

-

VRAM管理のためのブロック・スワップ機能

-

ワークフローをサブグラフ化して簡略化

-

デモ①:アニメキャラクター

-

デプスマップの可視化と解説

-

デモ②:毛糸の人形

-

疑応答とディスカッション

-

デモ③:複数人の動画

-

T-Cashと品質に関する考察

-

追加の質疑応答と高度なテクニック

-

エンディング

はじめに&Comfyの最新情報

みなさん、こんにちは。「Comfy Org」、ComfyUI公式配信へようこそ。いつも通り、私Purrsがお届けします。後ほどPhilも参加するかもしれませんが、まだわかりません。彼はいつも少し遅れて登場しますからね。

さて、皆さんいかがお過ごしでしょうか。Comfy界隈では大きな出来事がたくさんありました。Comfy Cloudをローンチし、資金調達も発表しました。そして、現在開催中のチャレンジも盛り上がっています。昨夜すべての応募作品をチェックしましたが、本当に素晴らしいものばかりでした。モンタージュ動画はまだ編集中ですが、明日にはブログで公開予定です。Comfyに関する必要な情報はすべて blog.comfy.org と comfy.org にありますので、ぜひソーシャルメディアもフォローしてください。

スペシャルゲスト Julianの登場

今週はComfyにとって大きな一週間でした。クラウドのプライベートベータ版も開始しました。サインアップ方法などの詳細はblog.comfy.orgで確認できます。cloud.comfy.orgにアクセスしてログインすれば、ウェイティングリストに登録され、準備が整い次第ご案内します。私もかなり試しましたが、ローカルマシンからクラウドに処理をオフロードできるのは本当に素晴らしいです。

(Julianが参加)

おっと、今日はLAX(ロサンゼルス国際空港)から特別なゲストが来てくれたようです。ちょっと彼を呼び込んでみましょう。こんにちは、Julian!

「やあ、空港からちょっと顔を出しただけだよ!」

友人のJulianは数週間留守にしますが、また戻ってきます。彼はロンドンのギャラリーで自身のAIアート作品を展示するんですよ、ボスのようにね!

「そう、AIアートだよ。 filthy AIアーティストでも、物理的なギャラリーで作品を展示できるってことを証明してるんだ。」

「じゃあ、またすぐに会おう!」

気をつけて、楽しんできてね!

本日のテーマ:オープンソースとVACE 2.2

さて、今現在利用可能なモデルの幅広さについて、皆さんはどう感じていますか? 個人的には少し圧倒されています。最近はSeedreamやNano Banana、Veo3などをよく使っています。これらはクローズドソースのものですが、今日のテーマはオープンソースです。

昨夜からようやくWAN 2.2 VACEを触り始めたんですが、これが本当にすごい。以前はFun Controlを使っていて、これも非常に良いのですが、VACEは全くの別物です。今日は主にデプスマップ(Depth Map)に関連することを見ていきますが、VACEはマルチコントロールモデルなので、OpenPoseなど他のものとも連携できます。

ワークフローの概要とカスタムノードについて

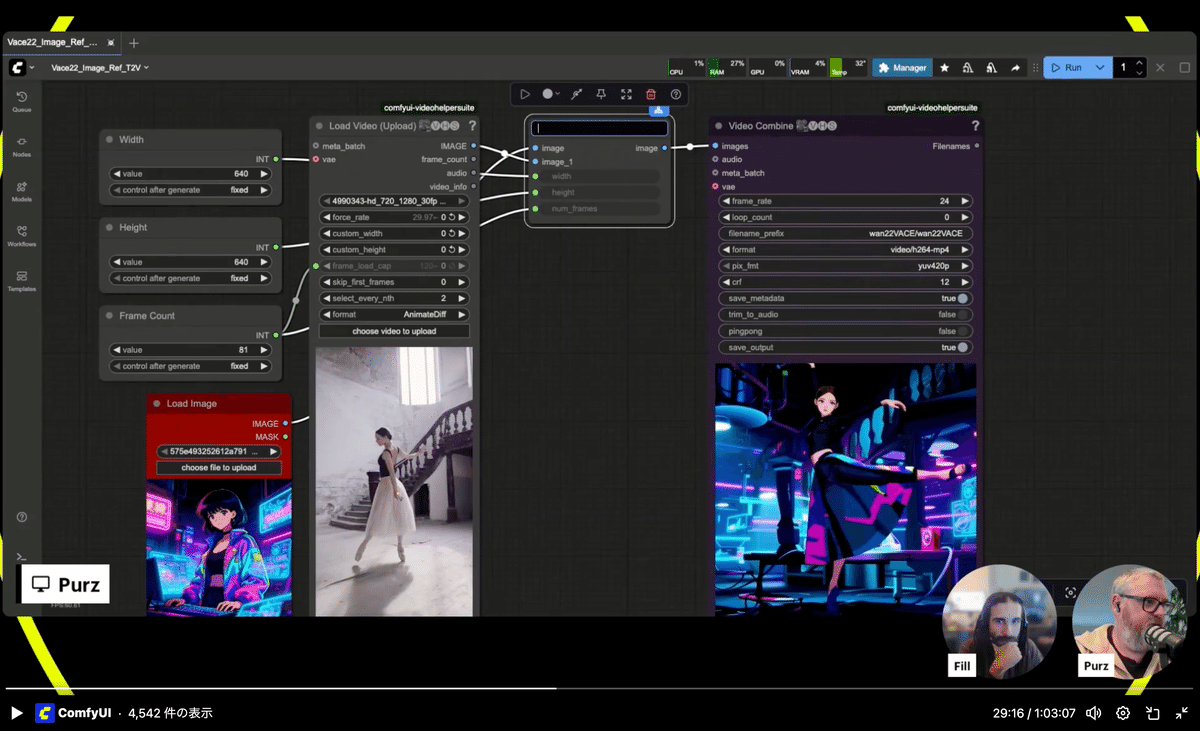

まずはワークフローを開いて、一つ一つのコンポーネントをゆっくりと見ていきましょう。このワークフローは多くの要素で構成されています。セッションの最後には、このワークフローをDiscordで共有しますので、Comfy OrgのDiscordに必ず参加しておいてくださいね。

このワークフローはbanodoco.aiというサイトの誰かから入手したもので、クレジットを明記するために後で名前を確認しておきます。

一つ注意点ですが、今日はネイティブのノードではなく、「WAN video wrapper」というカスタムノードの世界で作業します。このカスタムノードの制作者であるKajai氏は、常に最新モデルの最先端を走っています。なので、最新・最高のモデルは、まず「WAN video wrapper」で利用可能になることが多いです。

動画生成に慣れてきたら、このノードを使うことで、より完全なコントロールが可能になります。ノードの数は多くなりますが、banodoco.aiのコミュニティが必要なものを提供してくれます。彼らのDiscordには、私やあなたと同じようにAIに夢中なユーザーたちが、発見したことすべてを共有しています。

ワークフローの詳細解説

では、このすごいワークフローを見ていきましょう。これは通常よりも大きなワークフローで、中級者から上級者向けの内容になります。

このワークフローの基本は実は非常にシンプルです。Comfyに付属しているFun Controlのワークフローでも似たようなことはできます。VACEがもたらすのは、入力映像に対するより正確なコントロールです。

こちらが入力画像で、こちらが入力動画です。そして、これらを処理に通すと、このようなクールな結果が得られます。

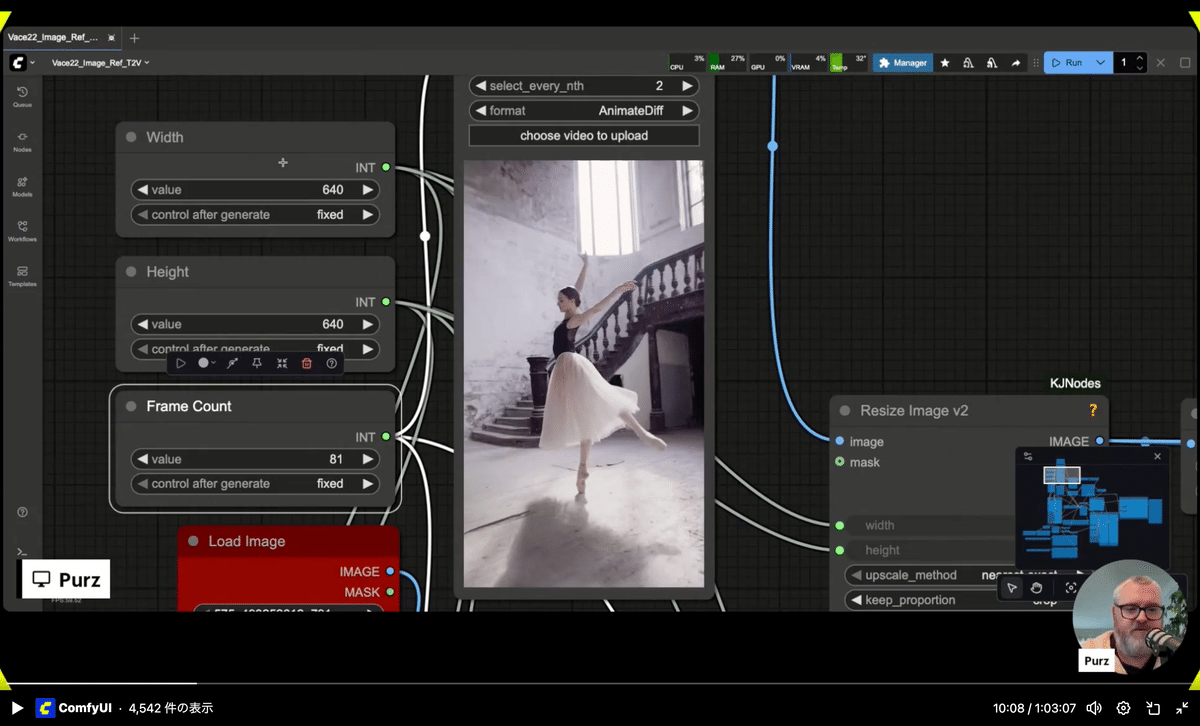

ワークフローの入力設定(定数)

まず、ワークフローの最初に幅(Width)、高さ(Height)、フレーム数(Frame Count)を定数として宣言しています。こうすることで、後から一箇所でこれらの値を変更できるので非常に便利です。キャンバス全体のサイズやフレーム数をここで決定し、リサイズなどが必要な複数のノードにこの値を接続します。これにより、8箇所のノードで「640x640」と手入力する手間が省けます。

デプスマップの生成

次に、入力動画からデプスマップを生成し、そのデプスマップをVACEに入力します。デプスマップとは、ビデオ内の各オブジェクトがカメラからどれだけ離れているか、その距離を推定したものです。

このデプスマップを可視化するために、「Video Combine」ノードを追加してみましょう。プレビューしたいけれど、大量のプレビューファイルをハードドライブに保存したくない場合に便利なテクニックです。

Florence 2によるプロンプト自動生成

入力画像は、ここで同じサイズにリサイズされます。そして「Florence 2」というノードを使っています。これはマルチモーダルな画像認識モデルで、画像を入力すると様々な処理ができます。今回は、画像の内容をキャプション(文章)にしてもらうために使っています。これにより、画像を見て自分で説明的なプロンプトを毎回入力する手間が省けます。

このノードパックは「ComfyUI-Florence2」で、これもKajai氏によるものです。ダウンロードしたFlorence 2モデルをノードに接続し、どのモデルを使用するかを選択します。私は「Florence 2 large」が好きですが、他にも色々あるので試してみてください。

https://www.aicu.jp/post/cm-23

生成されたキャプションは「String Concatenate」ノードに送られ、プロンプトの先頭に「anime illustration of」という接頭辞を追加します。こうすることで、リアルな画像ではなく、アニメ風のイラストを生成するようにモデルに指示できます。LORAのトリガーワードを設定する際にも非常に便利な方法です。

モデルの読み込み(WAN & VAE)

モデルの読み込み部分です。「WAN video VAE loader」では、1.2.2のテキストビデオモデルに対して1.2.1のVAEを使用します。これは少し奇妙な仕様ですが、2.2のVAEは5Bモデルでしか使われません。14Bモデルには2.1のVAEを使いましょう。

14Bと5Bの違いについて簡単に説明すると、パラメータ数の違いです。14B(140億パラメータ)モデルの方が大きく、より多くのVRAMを消費しますが、品質は高くなる傾向があります。VRAMに余裕があるなら14Bをおすすめします。もしVRAMが少ない場合でも、量子化されたGGUFモデルが利用可能で、8GBや12GBのカードでも動作させることができます。

VACEコントロールモジュールの解説

VACEはWAN 2.2に組み込むモジュールのような制御システムで、ControlNetによく似ています。Strength(強度)、Start Percent(開始率)、End Percent(終了率)といったパラメータがあります。

Start/End Percentは、レンダリングプロセス全体を通して、どの時点でVACEが介入し、どの時点で制御を解放するかを0から1(0%から100%)で指定するものです。例えば、0.3から1.0に設定すれば、最初の30%は自由に生成させ、その後VACEが介入して仕上げる、といった制御が可能です。

WAN video wrapperローダーとLora

「WAN video wrapper loader」ノードは、ネイティブのものより多くの入力を持ちます。これは、膨大な種類のWANモデルに対応するためです。今回はVACEモデルを「extra model」の入力に接続します。

また、LiteX2 T2V14B Rank256 distilled Lora を使用しています。これにより、モデルが蒸留(distill)され、通常20〜40ステップ必要なレンダリングが4〜8ステップで完了するようになります。これにより、生成時間が大幅に短縮されます。

VRAM管理のためのブロック・スワップ機能

「WAN video block swap」ノードについてです。ネイティブのComfyUIではこの処理は自動化されていますが、wrapperではシステムメモリにスワップするブロックの数を手動で制御できます。この数値を高くすると、VRAMの使用量は減りますが、VRAMとRAMの間でデータを移動させる時間がかかるため、生成時間は長くなります。

これはVRAMが不足してエラーが出る場合に調整するもので、問題がなければ特に気にする必要はありません。

ワークフローをサブグラフ化して簡略化

さて、この複雑なワークフローを一つのサブグラフにまとめて、もっと見やすくしてみましょう。こうすれば、日々の作業で使うときにもっと簡単になります。

入力画像、入力動画、そして出力だけが見えるような、すっきりとしたノードになります。プロンプトの接頭辞やステップ数なども外に出しておけば、サブグラフの中に入らなくても設定を変更できますね。

これで、この一つのノードが、先ほどまで見てきたすべてのワークフローを内包することになります。

デモ①:アニメキャラクター

では、入力画像を変えてみましょう。バレリーナのように踊らせてみます。

(生成開始)

サブグラフの中を覗けば、今でもすべての処理が裏側で動いているのがわかります。

デプスマップの可視化と解説

これがVACEに入力しているデプスマップです。この深度情報を基に、参照画像(今回はアニメキャラ)の人物を動かしています。

背景をマスクして除去したり、別の背景に合成したりすることもComfyなら可能です。

デモ②:毛糸の人形

さあ、結果が出ました。いい感じですね。

次は、プロンプトの接頭辞を「anime illustration」から「yarn doll(毛糸の人形)」に変えて、私の写真を使ってみましょう。このSeedreamで作った画像を、小さなダンサーに変えられるか試してみます。

質疑応答とディスカッション

(視聴者からの質問)

Q: ブロック・スワップは品質を低下させますか?

A: いいえ、品質は低下しません。ただ生成に時間がかかるようになるだけです。VRAM不足のエラーが出る場合に、メモリに収まるまでブロックサイズを増やす、というトレードオフの関係です。

Q: カスタムノードのダウンロードで問題が起きたことはありますか?

A: 個人的にはありませんが、インターネット接続の状況に大きく依存します。接続が不安定な時にカスタムノードを更新すると、転送が静かに失敗して後々問題になることがあるので、安定した環境で行うのが良いでしょう。

デモ③:複数人の動画

(デモ②の結果表示)

すごい、これは面白すぎる!素材感を見てください。本当にクールです。

では、もっとカオスな、複数の人が映っている動画を使ったらどうなるか試してみましょう。プロンプトは「yarn me」のままです。先ほどブロック・スワップの値を40から15に下げたので、生成時間がどれくらい速くなるかも見てみましょう。

(生成開始)

前回は333秒かかりましたが、今回は…およそ1分速くなりましたね。25%の高速化です。

T-Cashと品質に関する考察

この機会に、別の高速化手法についても話しておきましょう。それは、distilledモデルを使わずに、フルモデルとT-Cash(またはEasy Cashなど)を併用する方法です。これは、各ステップで生成される内容が前のステップとあまり変わらない場合、そのステップをスキップするという考え方です。

これにより推論時間を短縮できますが、distilledモデルと同様に品質は若干低下する可能性があります。時間と品質、どちらを優先するかの選択ですね。時間に余裕があるなら、T-Cashなどをオフにして20〜30ステップでじっくり生成するのがベストです。

追加の質疑応答と高度なテクニック

(デモ③の結果表示)

ワオ、これも本当に良いですね。このモデルが大好きです。

これが入力画像で、これが制御用のデプスマップ、そしてこれが結果です。あるべき姿よりもずっと良いものが出来上がりました。

VACEのすごいところは、入力映像のちらつき(フリッカー)をあまり気にしない点です。必要な情報だけを取り込み、不要なものは無視するのが非常に上手です。

今日はデプスマップだけを使いましたが、OpenPoseや、点の動きだけで軌道を指定するような映像でも制御できます。VACEは信じられないほど頑健なので、ぜひ色々なものを試してみてください。例えば、Line ArtとNormal Crafterのプリプロセッサを組み合わせると、信じられないような制御映像が作れますよ。

エンディング

このワークフローは配信終了後にDiscordで共有します。

VACEについては、また深掘りしていきます。隔週木曜日にはDiscordでの交流会もやっているので、来週はぜひ参加してください。

そして明日、チャレンジの結果発表がありますので、ぜひ注目してください。皆さんのポーズコントロールは本当にすごかったです。

クラウドへのサインアップもお忘れなく。ウェイティングリストに登録していただければ、準備ができ次第ご案内します。Comfyはまだまだこれから加速していきますよ。

それでは皆さん、また金曜日にお会いしましょう!安全運転で、良い一週間を!バイバイ!

編集部注:元ストリームはこちらです

https://x.com/i/broadcasts/1OyKAjzdMbgGb

☆現在アクセスできない状態です

Originally published at note.com/aicu on Sep 18, 2025.

Comments