ComfyUIライブストリーム速報 (2025/6/4) & 公式ブログ情報:ついに登場「FLUX.1 Kontext」API!開発者解説とComfyUI最新動向

本日2025年6月4日、ComfyUIの公式ライブストリーミングが配信されました。このAICUブログ記事では、その模様をお届けするとともに、ComfyUI公式サイトで発表されたばかりの革新的な「FLUX.1 Kontext API」に関する公式ブログ記事の内容も合わせてご紹介します。

ライブストリームには、ホストのPurs氏、Midjury Man (Julian AIR)氏に加え、ComfyUIの主要開発者の一人でフロントエンドや素晴らしいデザイン全般を担当するPablo氏、そして「FLUX.1 Kontext」を開発したBlack Forest Labs (BFL) からDustin氏が特別ゲストとして参加しました。

ComfyUI公式ブログも発表:「GPT Killer: FLUX.1 Kontext API Node Day-0 Support」

ライブストリーミングに先立ち、ComfyUI公式サイトのブログでは、2025年5月30日付で「GPT Killer: FLUX.1 Kontext API Node Day-0 Support」と題した記事が公開され、「FLUX.1 Kontext」が公式ComfyUI APIノードとして利用可能になったことが発表されました。

この新しい編集体験は、ComfyUIワークフロー内で既に試すことができます。オープンソース版も「間もなく登場!」とのことです。

FLUX.1 Kontext モデルのハイライト (ComfyUI公式ブログより):

https://comfyui.org/en/gpt-killer-flux1-kontext-api

-

FLUX.1 Kontextは、テキストと画像の両方を用いた編集と生成のために設計された、一連の生成的フローマッチングモデルです。

-

従来のT2Iモデルとは異なり、Kontextは画像とテキストの両方を使用したインコンテクスト画像操作をサポートし、以下を可能にします:

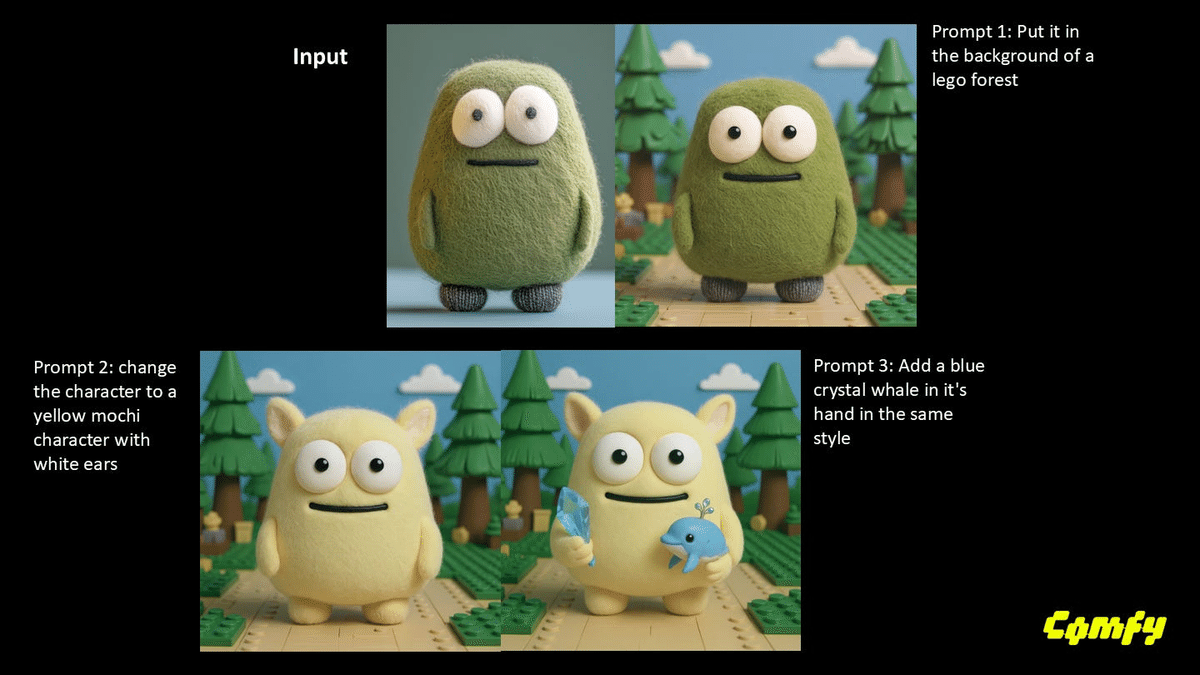

ステップを跨いでの同一画像の編集

精密なオブジェクト修正、テキスト編集

キャラクターの一貫性を保ったマルチステップ編集

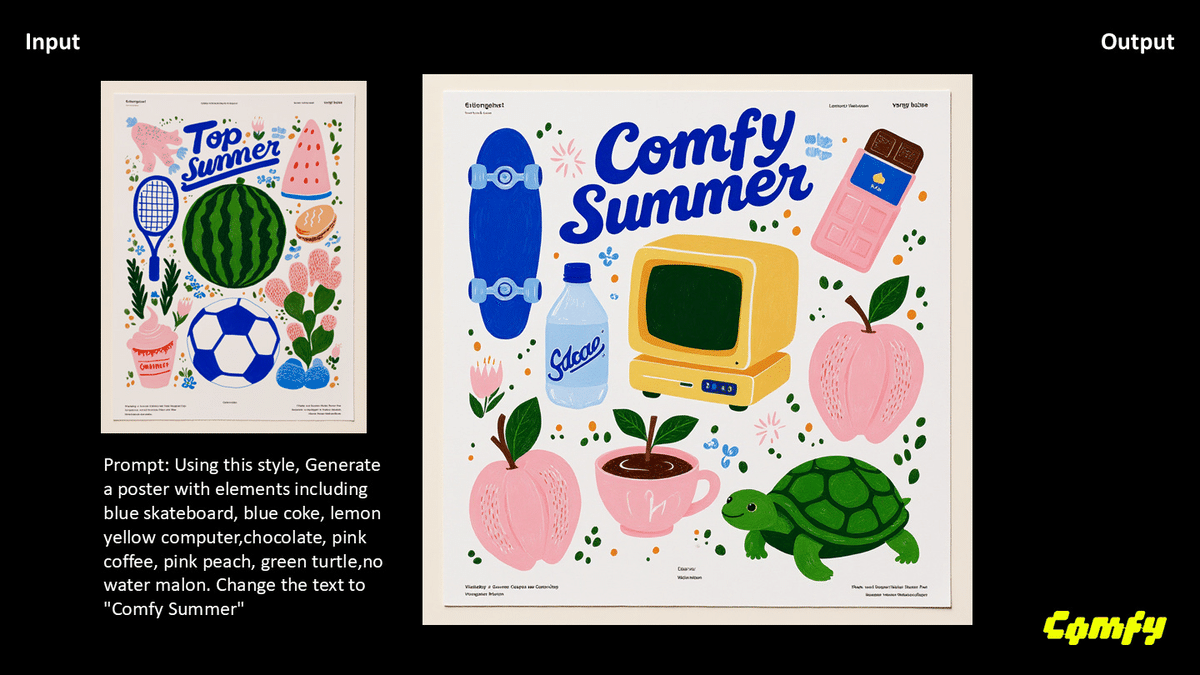

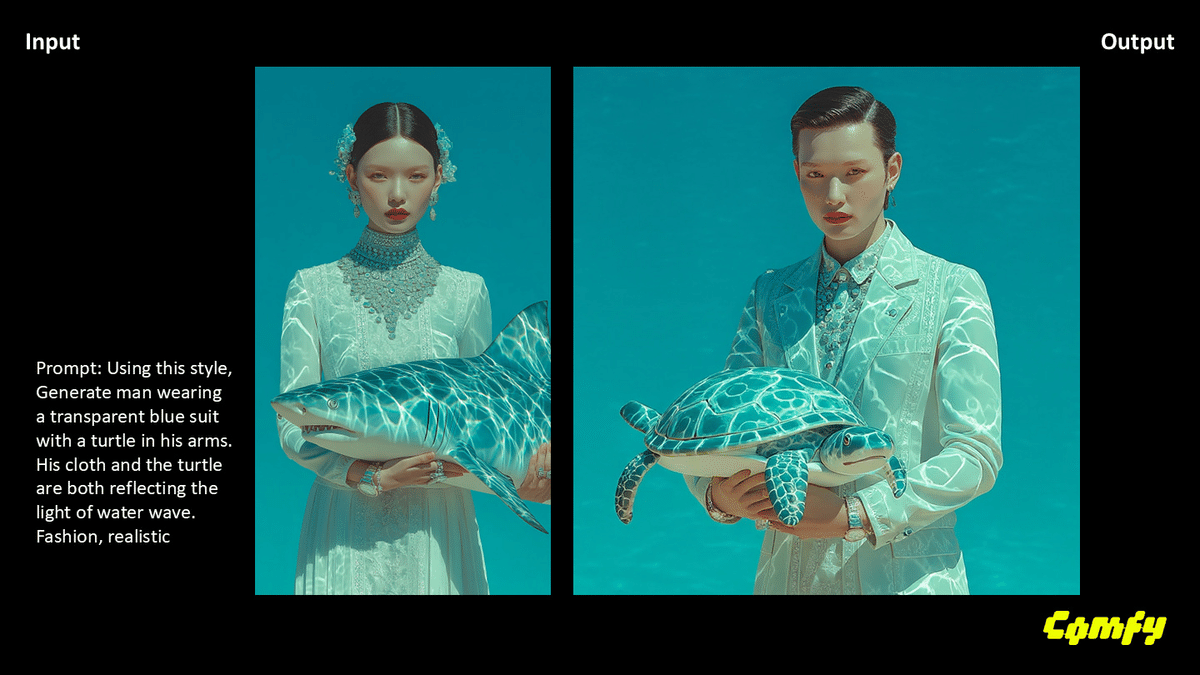

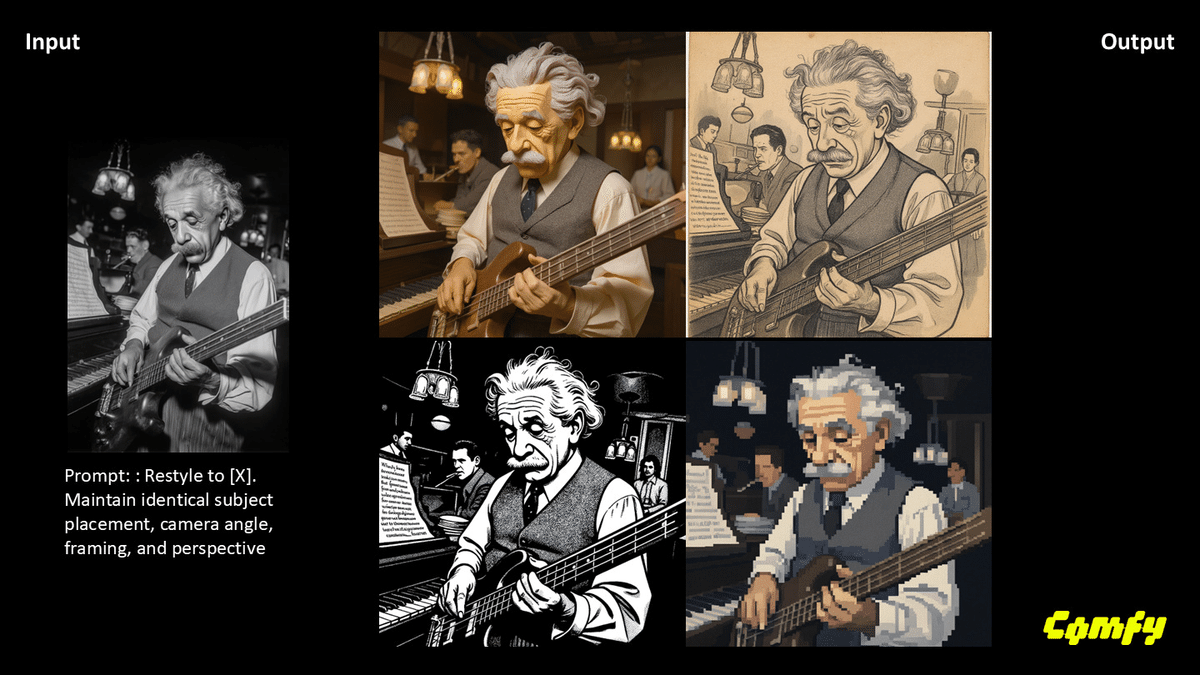

スタイルの維持と転送

構図制御:フレーミング、カメラアングル、ポーズ

背景制御

-

超高速推論

-

このシリーズでは2つのモデルがローンチされました:

-

Kontext Pro: 編集、合成、リミックスに最適。

-

Kontext Max: タイポグラフィ、プロンプトの精度、速度の限界を追求。

-

利用開始方法 (ComfyUI公式ブログより):

-

ComfyUI または ComfyUI desktop をアップデート。

-

ログインしてクレジットを購入。

-

ワークフロー → Browse Templates を確認 → Image API → Flux.1 Kontext へ移動。

-

任意のテンプレートをクリックして実行!

公式ブログでは、オブジェクト&テキスト編集、連続編集、スタイル参照、スタイル転送、背景制御などの素晴らしい出力例も紹介されています。詳細なドキュメントや価格については、ComfyUI公式サイトのドキュメントページで確認できます。

ライブストリーム本編:FLUX.1 Kontext 詳細解説と開発秘話

ライブストリームでは、この「FLUX.1 Kontext」について、開発者であるBFLのDustin氏からさらに詳しい解説がありました。

特別ゲスト:Black Forest LabsのDustin氏が語る開発の舞台裏

-

開発の挑戦: このような多機能なモデルをどのようにトレーニングし、堅牢なものにするかというアプローチ自体が最初の大きな課題だったそうです。既存のテキスト画像モデルの知識を活用しつつ、多様なタスクや指示を一般化できるように学習させることに注力したとのこと。

-

一貫性と品質: ほぼ毎回高品質な結果を得られるように、最終調整とアライメントに多大な労力を費やしたと語っていました。

-

コミュニティの活用事例: 古い家族写真の修復など、ユーザーが創造的な使い方をしているのを見るのが素晴らしいとコメント。

-

高解像度対応: 将来的にはより高解像度のモデルが登場する可能性も示唆されましたが、現時点では未確定とのことです。

-

空間・照明理解: モデルの優れた空間認識や照明の理解は、トレーニングによって純粋に学習された特徴であると説明。

-

ControlNetやLoRAについて: オープンソース版がリリースされれば、ControlNetのような制御も可能になるだろうとのこと。また、KontextにおけるLoRAは、従来の画像コンセプトではなく、「タスクLoRA」のような形で、特定の編集タスクを学習させる方向性が考えられると述べました。バウンディングボックスを使った制御の可能性についても言及がありました。

ライブデモ:FLUX.1 Kontextの驚異的な画像編集・生成能力

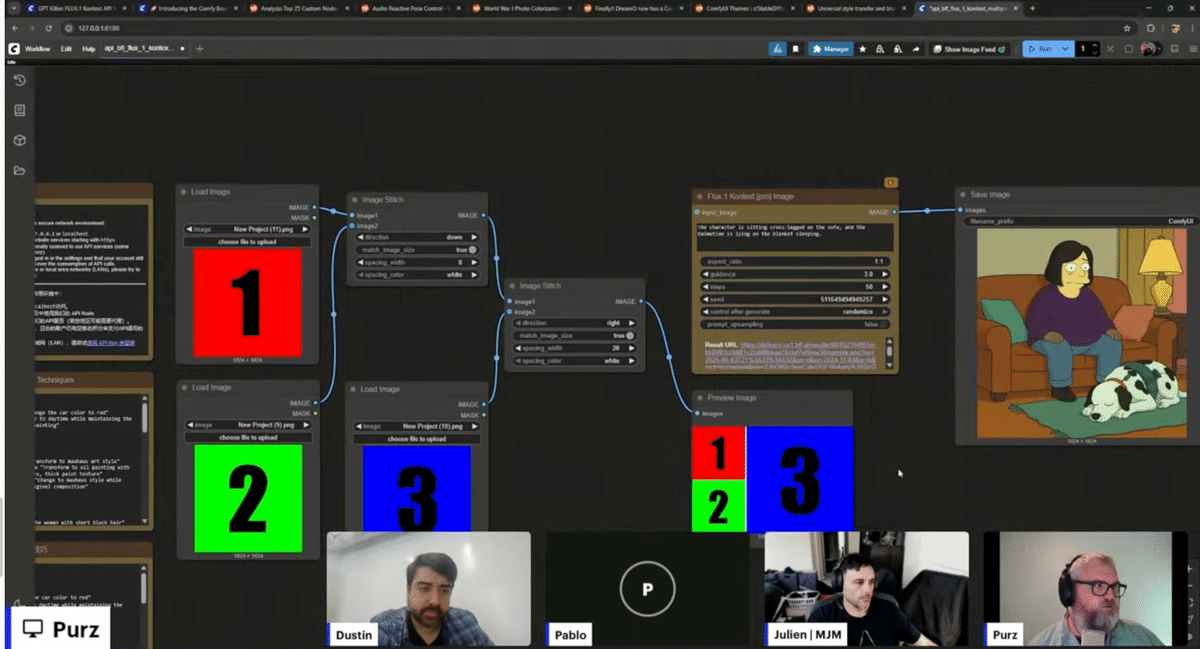

ストリームでは、FLUX.1 Kontextの実際の使用例がデモンストレーションされました。特に注目されたのは、ComfyUIコアに新たに追加された**「Image Stitch」ノード**です。これにより、複数の画像を結合して入力として使用できます。

デモでは以下の様な例が示されました。24:30-

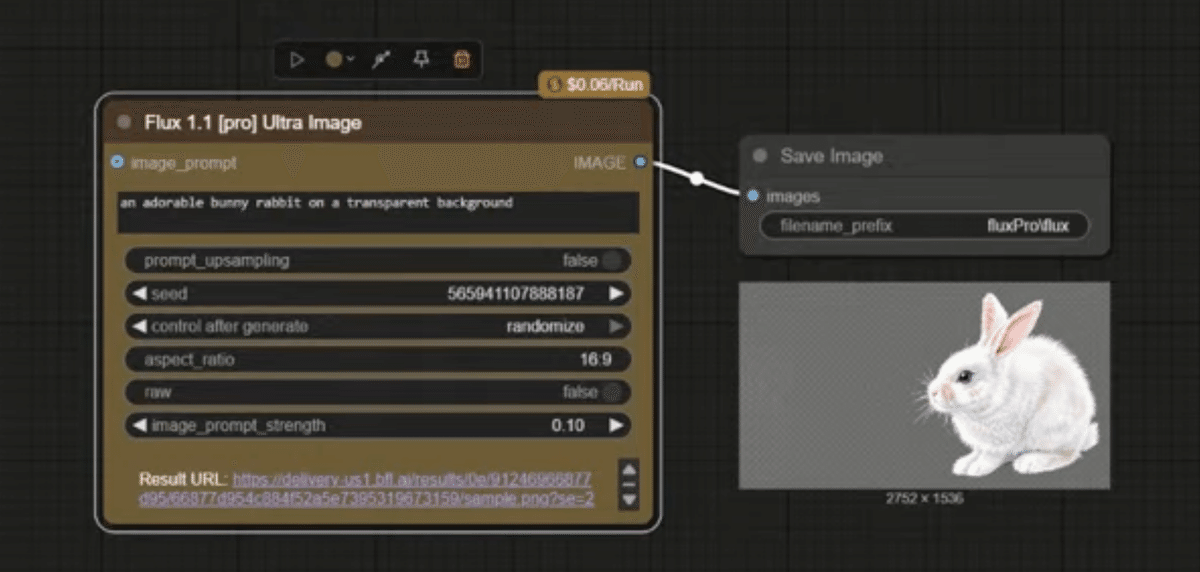

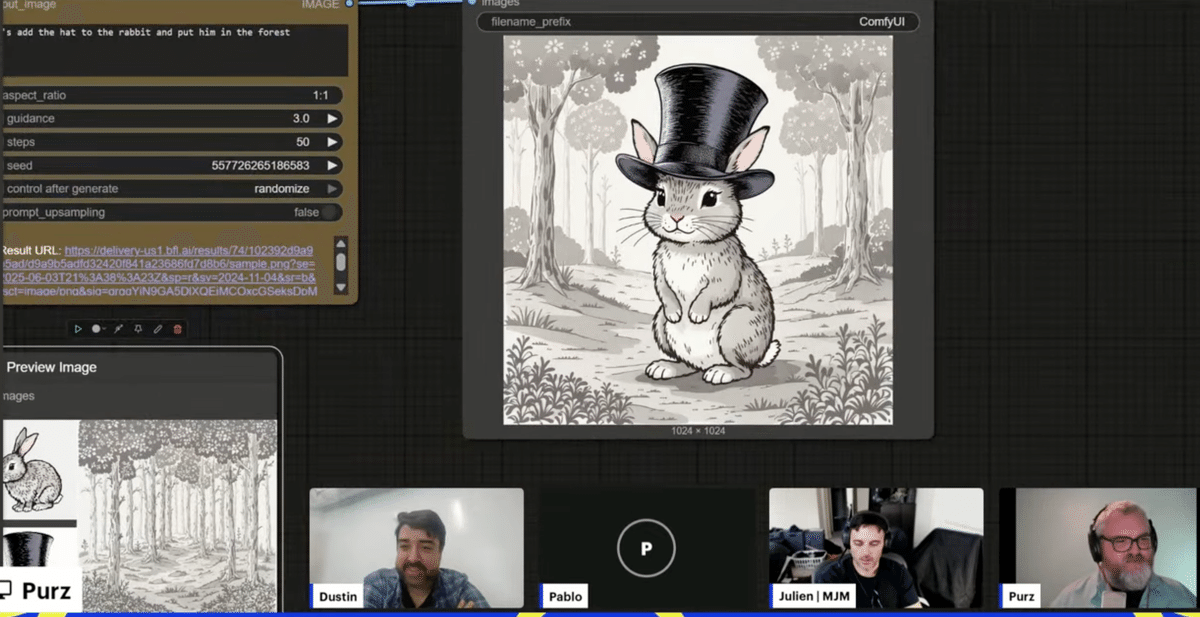

1.「透明な背景のかわいいウサギ」「白い背景のシルクハット」「森の鉛筆画」をそれぞれFlux Proで生成。

2.これら3枚の画像を「Image Stitch」ノードで結合。

3.結合された画像と「ウサギに帽子をかぶせ、森の中に配置して」というプロンプトをFlux1-Kontextに入力。

結果:見事に指示通りの、帽子をかぶったウサギが森の中にいる鉛筆画風の画像が生成されました。さらに「リアルな写真にして」という指示で写実的な画像に、「新聞を読ませて」で新聞を読むウサギの画像へと変化させる様子も披露されました。

Purs氏は、自身の顔写真と犬の写真を組み合わせたり、パーティーにいる自分を生成したり、様々な実験結果を共有。表情の変化、テキストの埋め込みなど、その柔軟性と精度の高さが強調されました。入力画像の品質が出力に影響する点も指摘されました。

ComfyUIエコシステムの最新アップデート情報

Flux1-Kontext以外にも、ComfyUIコミュニティにおける最新の動きが多数紹介されました。

-

ComfyUIバウンティプログラム: ComfyUIの開発に貢献し、報酬を得られるプログラムが開始されました。

-

カスタムノードTop25 (インストール数別):

-

パフォーマンス・最適化部門では「T-Cash」が1位。

-

モデル実装部門では顔編集に強い「Reactor」が最も人気。次いで「IPAdapter」「AnimateDiff」など。

-

-

コミュニティハイライト: Ryan on the Inside氏による音声反応型ポーズ制御、カラー化・修復ツール「One More One Photo」、DREAMO ComfyUIネイティブ実装、ComfyUIテーマ、Clown Shark Bat Wing氏によるスタイル転送とブラー抑制ガイドなど。

コミュニティとのQ&Aと今後の展望

ストリーム中には視聴者からの質問も活発に交わされ、APIのクレジット消費の確認方法などについても触れられました。Dustin氏は、コミュニティが作成した作品をTwitterで「#context」のようなキーワードで検索して楽しみにしていると語りました。

Purs氏は、ストリーム中の自身のオーディオインターフェースの不調について謝罪し、次回までの改善を約束しました。

まとめと次回の配信

「FLUX.1 Kontext」の登場は、ComfyUIにおける画像生成・編集の可能性を大きく広げるものです。API版でその力を体験しつつ、オープンソース版のリリースと、それによって可能になるさらなるカスタマイズや制御に期待しましょう。詳細はComfyUI公式サイトのブログやドキュメントも合わせてご確認ください。

次回のComfyUIライブストリームは金曜日に配信予定です。引き続きComfyUIの進化から目が離せません!

このブログ記事は、ComfyUI公式ライブストリーミング (2025/6/4) およびComfyUI公式サイトブログ (2025/5/30発表) の内容を基に作成されました。

—

この記事の続きはこちらから https://note.com/aicu/n/n7f0f3c04e8f8

Originally published at note.com/aicu on June 9, 2025.

![[ComfyUI] Flux1-Context API登場](https://corp.aicu.ai/hubfs/rectangle_large_type_2_6981439d1a1e901e21820e8c45d1d90a.png)

Comments