2024年4月22日にComfyUIを開発するComfy Community Hangoutが開催されました。

「ハングアウト」とは「一緒に時間を過ごす」「遊ぶ」という意味です。Wan2.1FLF(First Last Frame)とFun Controlが紹介されました。

番組概要

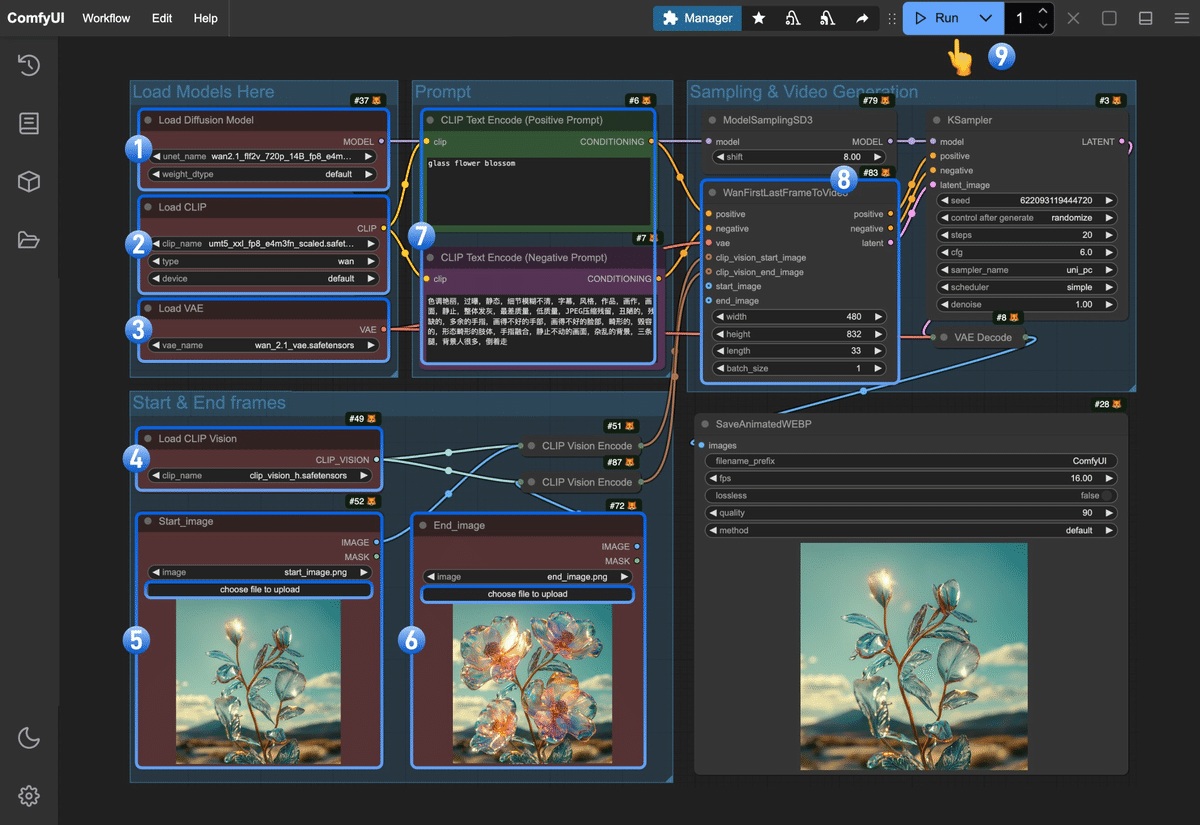

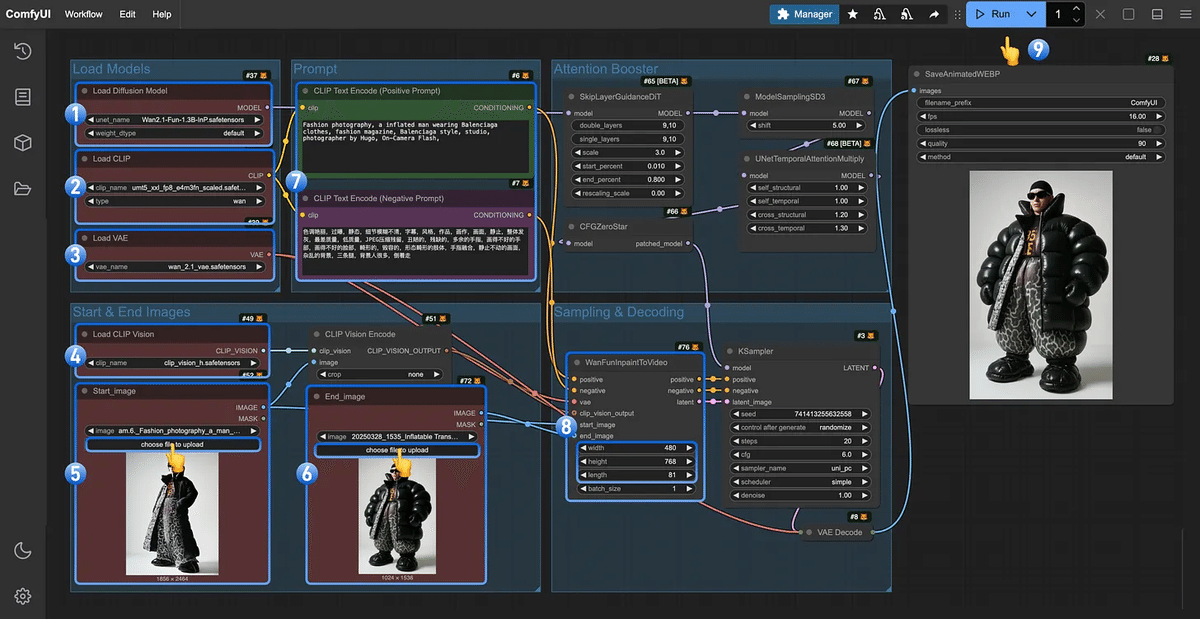

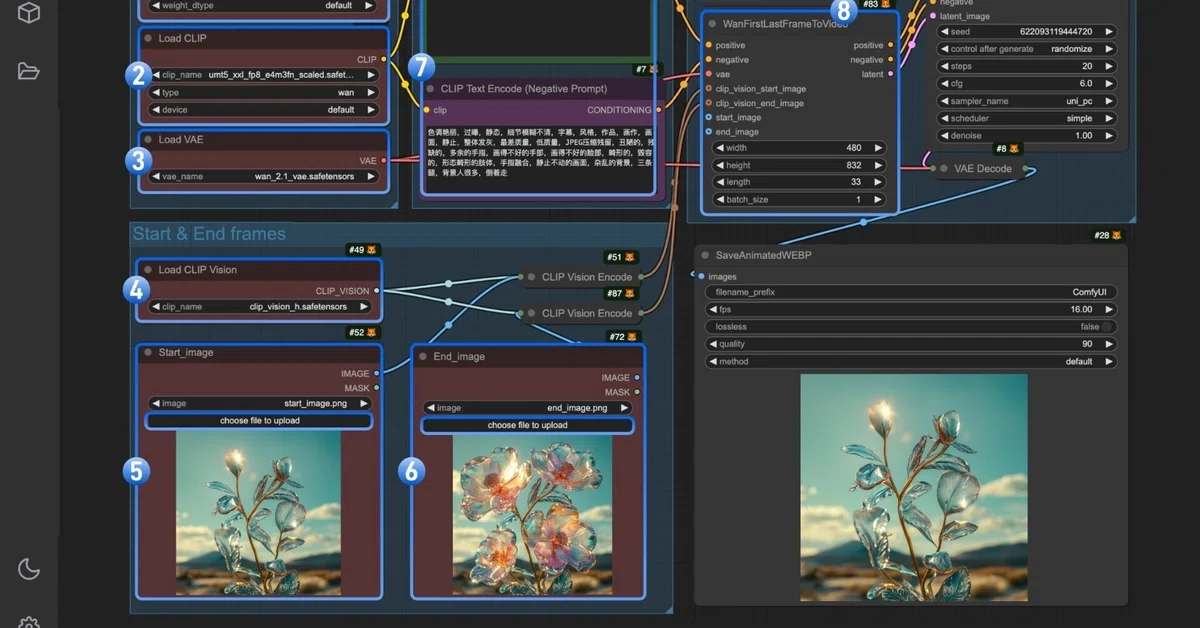

Comfy UIにおける新しいビデオ生成機能「Wan2.1 FLF(First Last Frame)」「Wan2.1 Fun Control」などの紹介と、低VRAM環境での最適化方法やトラブルシューティング、テンプレート活用法、最新のAIモデルやワークフローの共有、参加者との質疑応答を中心にした技術雑談配信です。

Comfy UIの新機能

-

FLF(First Last Frame) は、2枚の画像を使ってアニメーションを生成。

-

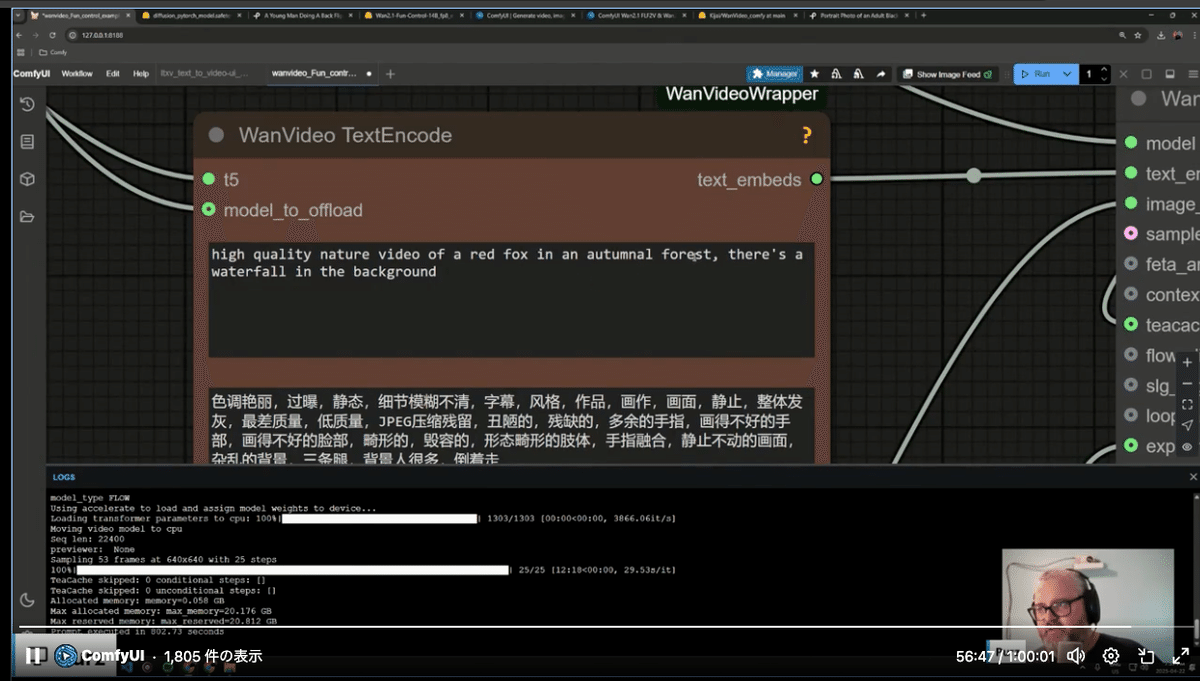

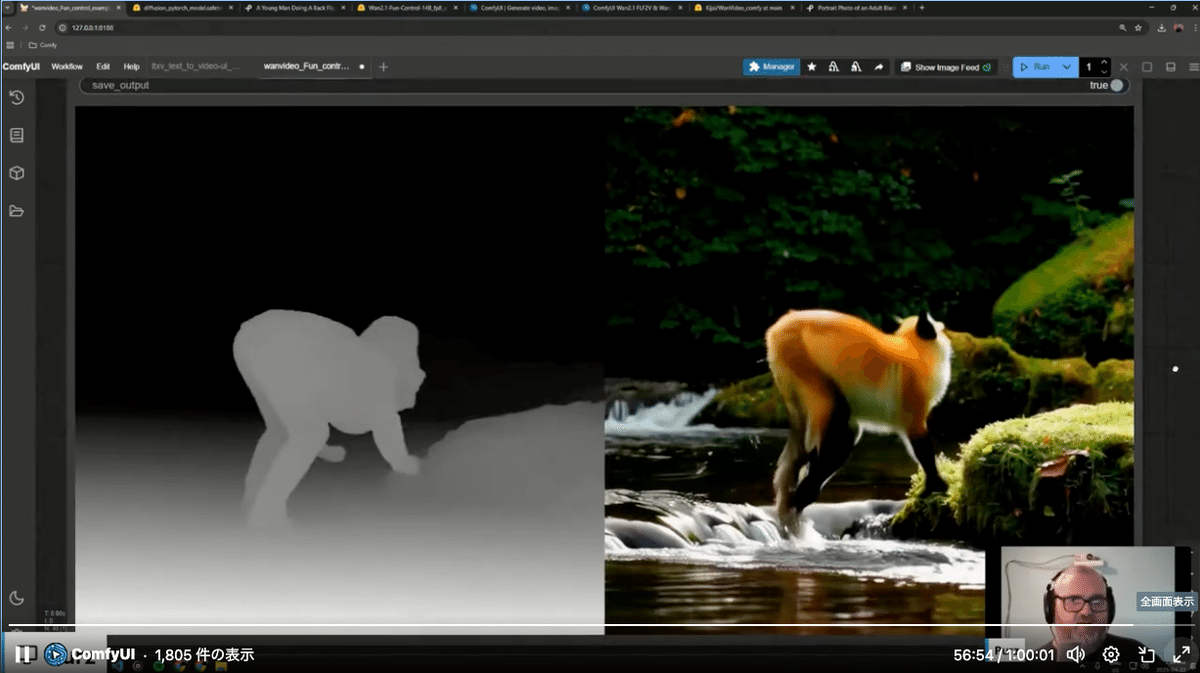

Fun Control は、動画による動作制御(OpenPoseやDepthなど)を活用した生成。

-

ネイティブ対応済みの機能としてComfy内でテンプレートからすぐ使用可能。

最新の「Comfy Community Hangout」にて、生成動画の新たな波を牽引するComfyUIの機能が紹介されました。注目されたのは、FLF(First Last Frame) と Fun Control の2つです。

FLF では、ユーザーが「最初の画像」と「最後の画像」を指定することで、その間の映像を滑らかに補間し、まるでストーリーボードのような自然なアニメーションを生成できます。一方、Fun Control は、OpenPoseやDepth(深度)などの動画から動きの情報を抽出し、それに基づいた詳細な動画生成を可能にします。

これらのツールはすでにComfyUIのテンプレートとして標準搭載されており、複雑な設定なしにリッチな動画生成を始められます。

https://blog.comfy.org/p/comfyui-wan21-flf2v-and-wan21-fun

Wan2.1 FLF2V 720P fp16 ワークフローはこちら

Wan2.1 Fun Control & Wan2.1 Fun InP

https://huggingface.co/spaces/alibaba-pai/Wan2.1-Fun-1.3B-InP

ワークフローと結果動画はこちら

https://raw.githubusercontent.com/Comfy-Org/example_workflows/main/wan2.1_fun_inp/wan2.1_fun_inp.webp

公式ドキュメントはこちらです

https://docs.comfy.org/tutorials/video/wan/fun-control

低VRAM環境の工夫

今回の配信で特に印象的だったのは、低VRAM環境でも動作する量子化モデル(quantized models)の登場です。RTX 3060のような一般的なGPUでも、14Bサイズのモデルを使った生成に成功したという報告がありました。これは、コミュニティのKajai氏らによって配布された軽量版モデルのおかげです。

この技術は、ハイスペックなマシンがなくても本格的なAI動画生成が楽しめるという点で、大きな可能性を広げています。

-

Kajai氏によるquantized model(量子化モデル)が紹介され、VRAMの少ないGPU(例: RTX 3060など)でも動作可能。

-

例として、14Bモデルを12GB VRAMで動かすユーザーの成功例も。

実装手順

-

モデルのDL場所、格納先(diffusers, clip, VAEフォルダ)を明示。

-

Comfy内で R キーを押すと再スキャンされ、モデルが選択可能に。

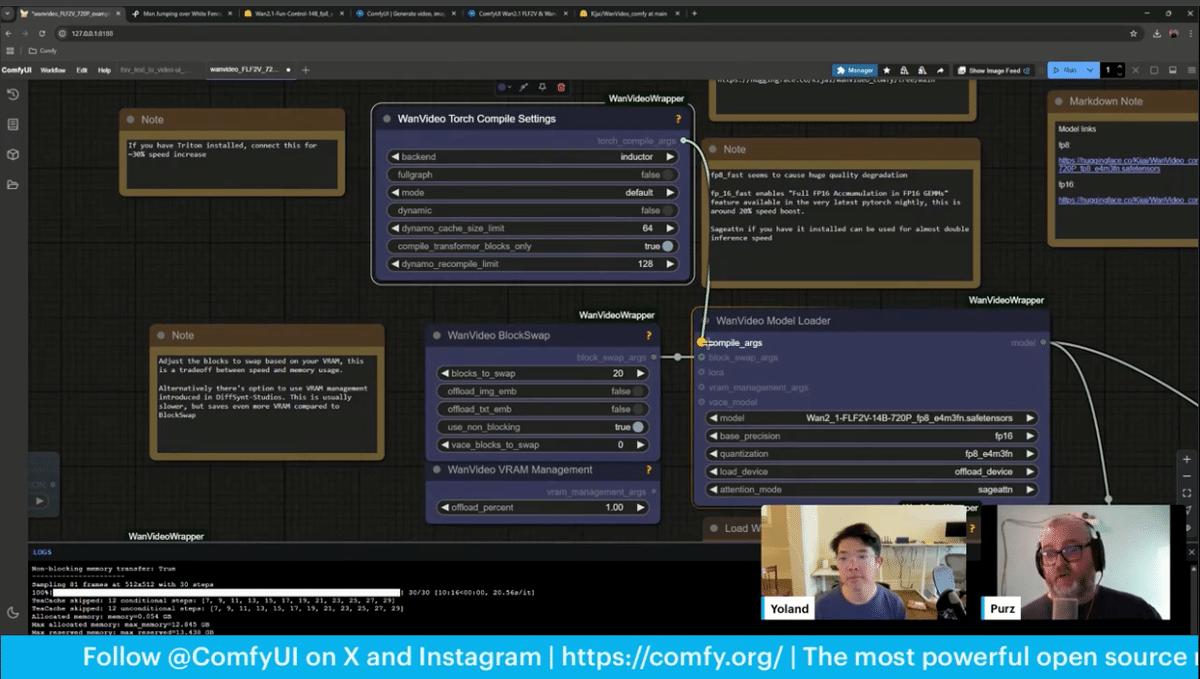

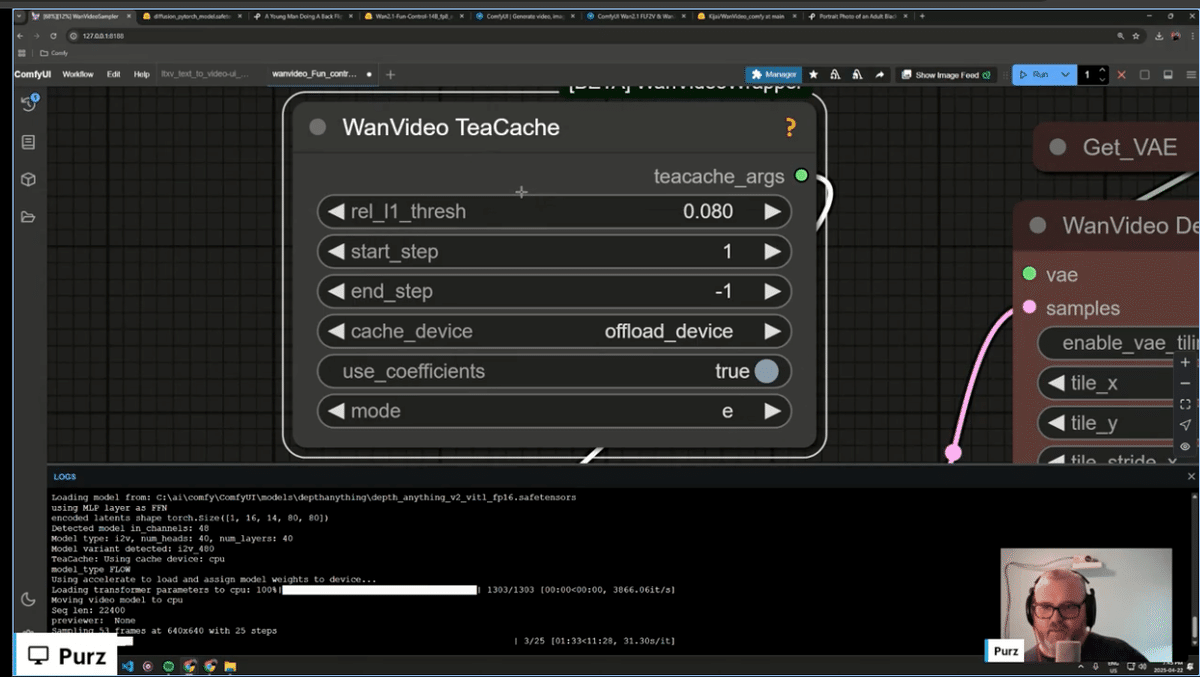

TeaCacheやTorch Compileなどの最適化

今回の配信では、処理の高速化にも焦点が当てられました。T-Cache を利用することで、無駄な処理ステップをスキップでき、生成速度が大幅にアップします。

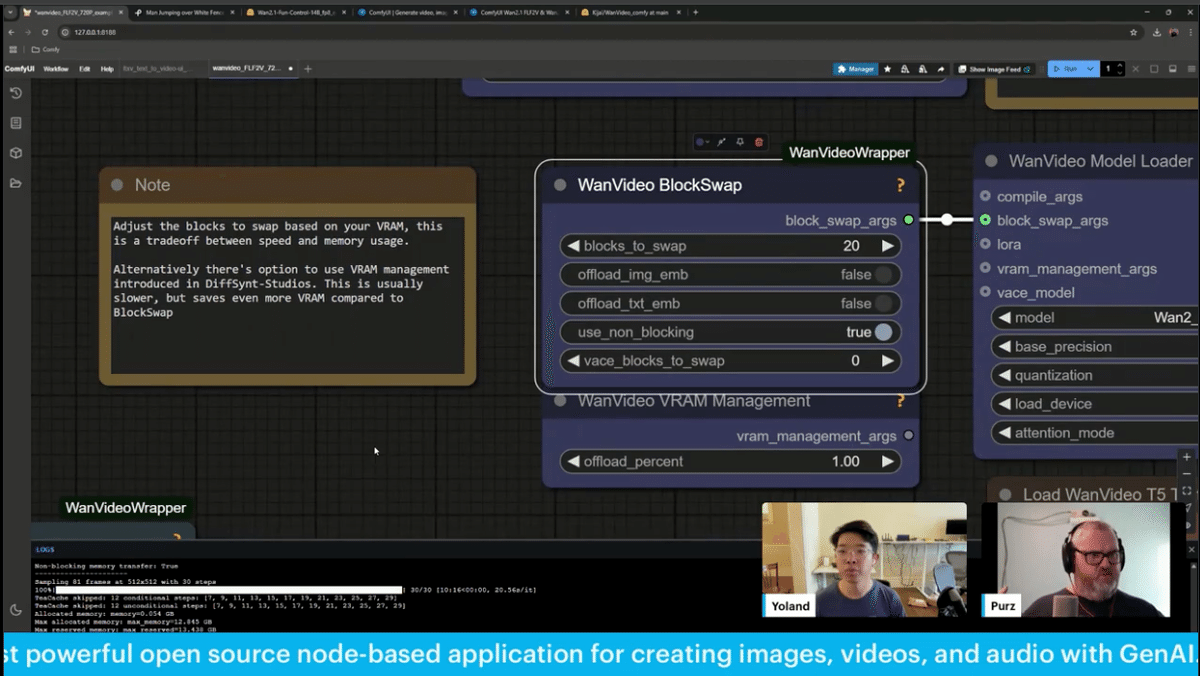

さらに、Torch Compile を使えば、NVIDIAの40xxシリーズのGPUでは最大30%の高速化が見込めます。これらに加え、Block Swap などのメモリ管理ツールを使うことで、描画時間と画質のバランスを細かく調整することも可能になります。

-

T-Cacheで不要なステップをスキップし、生成速度を向上。

-

Torch CompileはNVIDIA 40xx系GPUで最大30%の速度向上。

-

Block Swap設定でメモリと速度のバランスを調整可能。

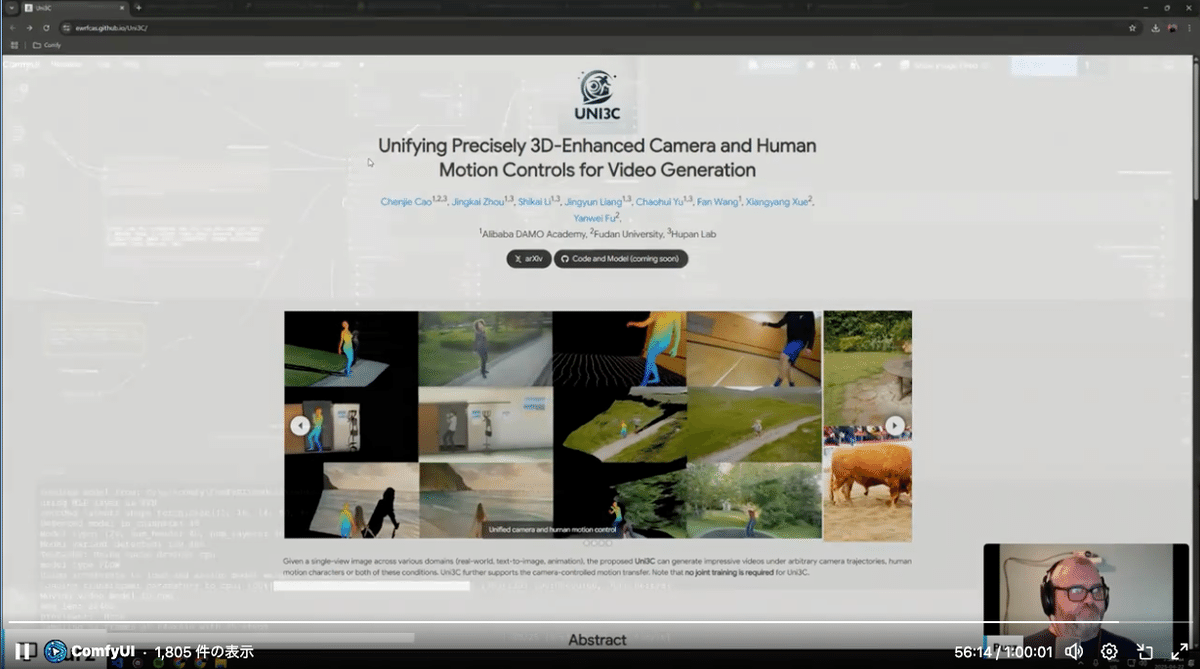

UNI3C

最新論文の紹介です。

Unifying Precisely 3D-Enhanced Camera and Human Motion Controls for Video Generation

Uni3C:カメラ&人物モーション制御の統一的フレームワーク

Alibaba DAMOアカデミーと復旦大学の共同研究により登場したUni3Cは、動画生成におけるカメラ制御と人物動作制御を同時に扱える初の統合型フレームワークです。

-

PCDController:単眼Depth画像から生成した点群を利用し、カメラ動作を精密に制御

-

3Dワールドガイダンス:SMPL-X人物モデルとシーン点群を整列・合成し、モーションとカメラを同時制御

これにより、以下のような複雑な演出が可能になります:

-

任意のカメラ軌道(360度オービットなど)

-

既存モーションへの視点付きトランスファー

-

単一画像からの多視点生成(実写・T2I・アニメ問わず)

しかも、共通アノテーション不要で柔軟なモジュール学習が可能という点が革命的です。

https://ewrfcas.github.io/Uni3C/

実例:犬の動画を使った生成

-

Pexelsから犬の動画を取得し、Depth Anythingでマスク作成→Funモデルに適用。

-

カメラ操作はプロンプトでコントロール可能。

-

結果は「赤いキツネが自動車のある森でバク宙する」などの内容に。

コミュニティとの交流

-

Discord上での画像投稿受付、アドバイス募集。

-

今後も毎週火曜に配信予定(金曜はTownhall形式)。

このレベルの内容を週2回とは、大変なことになってきました!

開発の背景から実演、質問への即答まで、全体を通して非常にリズミカルでわかりやすい進行を見せてくれました。

進化するコミュニティと未来への展望

このHangoutは単なる機能紹介ではありません。これは、オープンで創造的なエコシステムの進化の現在地を示すものでした。

ComfyUIのDiscordは、テンプレートの共有やバグ報告、モデル交換などで活発に機能しており、毎週火曜日のライブ配信や金曜日のTownhall形式のイベントも継続中です。

これらのツールが成熟するにつれ、インディーアニメーション、プロトタイピング、さらにはプロのポストプロダクションの現場にまで影響を与える存在となるでしょう。

「誰でもAIで動画が作れる時代」は、もう未来ではありません。すでに始まっています。

さあ、あなたもComfyUIの波に乗ろう!

テンプレートはすでに公開中。コミュニティにもぜひ参加してみてください。

ComfyUIは単なるツールではありません。これは一つのムーブメントです。

ちょうど今週末、AICU Creators Talk 7 「画像・動画生成AI ComfyUI マスターガイド」完成記念パーティが開催されます。

Amazon予約ページ

出版社:SBクリエイティブ

配本開始予定日;2025年5月9日

AICU最新刊の見本誌以外にも、SD黄色本の多言語版、AICUマガジンバックナンバー、そして海外アート展での展示作品など多彩企画が予定されています。もちろんミートアップも!

https://corp.aicu.ai/ja/aicu-creators-talk-7-20250415

イベント詳細 https://j.aicu.ai/ACT7

19:00 オープニング

19:05 書籍の紹介:各章の見どころ(白井暁彦)

19:30 著者:早野康寛さんによる解説/執筆を終えて

20:50 QA参加のご感想(ないとっちさん、Bandwagonさん)

20:00 認定証授与式

20:10 AICU新規事業説明会

20:30 懇親会(予定)

ComfyUIマスターの購読者にはイベント10%オフクーポンを配布します!

—

この記事の続きはこちらから https://note.com/aicu/n/nc7e965e6dfa9

Originally published at note.com/aicu on Apr 23, 2025.

Comments