最近、AI界隈で「GPT-6の正体ではないか?」と大きな話題を呼んでいる一つの研究論文があります。その名も「SEAL (Self-Adapting Language Models)」。マサチューセッツ工科大学(MIT)の研究チームによって発表されたこの論文は、AIが自ら学習し、成長し続ける未来を予感させる画期的な内容です。しかし、その技術的なインパクトと、著者の一人がOpenAIにも在籍しているという事実から、「これが次世代GPTのプロトタイプだ」という憶測がSNSを中心に飛び交っています。この記事では、論文を隅々まで精読した結果わかったSEALの本当の凄さと、GPT-6を巡る噂の真相について、深く掘り下げて解説します。

🔥 GPT-6 may not just be smarter, it might be alive (in the computational sense).

— VraserX e/acc (@VraserX) October 12, 2025

A new research paper called SEAL, Self-Adapting Language Models (arXiv:2506.10943) describes how an AI can continuously learn after deployment, evolving its own internal representations without… pic.twitter.com/uV40mywFiP

GPT-6はただ賢くなるだけじゃないかもしれない。それは(計算論的な意味で)「生きている」のかもしれない。

「SEAL」と呼ばれる新しい研究論文(自己適応言語モデル、arXiv:2506.10943)が、AIがデプロイされた後も継続的に学習し、再トレーニングなしで自身の内部表現を進化させていく方法を明らかにしている。

このSEALの研究者の一部は、今OpenAIで働いているんだ。

それは偶然じゃない。

SEALのアーキテクチャは、モデルにこんなことを可能にする:

・リアルタイムで新しいデータから学ぶ

・劣化した知識を自己修復する

・セッションを越えて持続的な「記憶」を形成する

もしGPT-6がこれを統合したら、それは単に情報を使うんじゃなく、「吸収」していくようになるだろう。

世界の変化に合わせて適応していくモデル。

日々、賢くなっていくシステム。

これは継続的な自己学習AIの誕生であり、「凍結された重み」の時代の終わりだ。さあ、新たな章の始まりだ。

論文概要から

この論文「Self-Adapting Language Models」は、大規模言語モデル(LLM)が静的で一度訓練されると変わらないという課題に対し、モデル自身が新しいデータやタスクに適応するために、自らのファインチューニング用データ(自己編集データ)を生成し、継続的に学習していく「SEAL(Self-Adapting LLMs)」という画期的なフレームワークを提案しています。

SEAL(自己適応言語モデル)とは?

SEALの基本的な考え方は、人間が学習する方法に似ています。例えば、学生が試験勉強をするとき、教科書の内容をそのまま暗記するのではなく、自分なりにノートにまとめたり、情報を再構築したりして理解を深めます。SEALはこのプロセスをLLMで実現しようとするものです。

SEALの仕組みは、大きく2つのループで構成されています。

-

内部ループ(Inner Loop): 新しい情報(コンテキスト)が与えられると、モデルは「自己編集(Self-Edit)」と呼ばれるデータを生成します。これは、与えられた情報をより学習しやすい形式(例えば、要点や論理的な帰結をまとめた文章など)に書き換えたものです 6。そして、この自己編集データを使ってモデル自身の重みをファインチューニング(微調整)します。

-

外部ループ(Outer Loop): 内部ループで更新されたモデルが、関連するタスク(例:質問応答)でどれだけ性能が向上したかを評価し、その結果を「報酬」として受け取ります。この報酬を最大化するように、強化学習(Reinforcement Learning) を用いて、「より良い自己編集データを生成する能力」そのものを向上させていきます。

つまり、「良い自己編集とは何か」をモデル自身が試行錯誤しながら学んでいくのがSEALの核心です。

SEALの具体的な応用と実験結果

論文では、SEALの有効性を2つの異なるドメインで実証しています。

1. 新しい知識の取り込み (Knowledge Incorporation)

新しい文章を与え、その内容をモデルの内部知識として恒久的に統合させるタスクです。

実験: SQuADデータセットの文章をモデルに与え、その内容に関する質問に、元の文章を見ずに答えられるかを評価しました。

自己編集: モデルは与えられた文章から「論理的な含意(implications)」、つまり文章から導き出される結論や要約を生成します。

結果:元の文章だけでファインチューニングした場合の正解率が33.5%だったのに対し、SEALを用いることで47.0%へと大幅に向上しました。

驚くべきことに、この性能は、はるかに巨大なモデルであるGPT-4.1が生成したデータで学習させた場合の正解率(46.3%)を上回りました。これは、SEALが単にデータを生成するだけでなく、自身の学習に最も効果的な形式のデータを生成するよう最適化されていることを示しています。

2. フューショット学習 (Few-Shot Learning)

非常に少ない(数個の)事例から新しいタスクのルールを学び、未知の問題に対応する能力を測るタスクです 17。ここでは、抽象的な推論能力を測るARCベンチマークが使われました。

-

実験: 少数の入出力ペアの例題を与え、新しい入力に対する正しい出力を予測させます。

-

自己編集: この場合、自己編集データは文章ではなく、学習方法に関する設定指示です。どのデータ拡張(回転、反転など)を使い、どの学習率やエポック数で学習するか、といったハイパーパラメータをモデル自身が生成します。

結果:従来の文脈内学習(ICL)では正解率0%、強化学習なしの自己編集でも20%だったのに対し、SEALで学習方法を最適化することで正解率は72.5%にまで飛躍的に向上しました。

課題と限界

SEALは画期的なアプローチですが、いくつかの課題も指摘されています。

破滅的忘却 (Catastrophic Forgetting): 新しい情報を学習する際に、過去に学習した内容を忘れてしまう傾向があります。連続して自己編集を行うと、初期に学習したタスクの性能が徐々に低下することが確認されました。

高い計算コスト: 報酬を計算するために、自己編集データを生成するたびにモデルのファインチューニングと評価を行う必要があり、非常に多くの計算リソースを必要とします。

評価の依存性: 現在の仕組みでは、性能向上の度合いを測るために、正解ラベル付きの評価データ(例:質問と答えのペア)が必要です。これにより、ラベルなしの膨大なデータへの適用が難しくなっています。

結論と今後の展望

この研究は、LLMが静的なツールから、自ら学習戦略を立てて継続的に成長する動的なシステムへと進化する可能性を示しました。

将来的には、人間が生成したテキストデータを使い果たすという「データ不足の壁」が予測されており、モデルが自ら高品質な学習データを生成する能力は不可欠になると考えられます。SEALのフレームワークは、エージェントシステムが経験から学び、自己を改良していくような、より自律的なAIの実現に向けた重要な一歩と言えるでしょう。

論文情報「Self-Adapting Language Models」

著者: Adam Zweiger, Jyothish Pari, Han Guo, Ekin Akyürek, Yoon Kim, Pulkit Agrawal (マサチューセッツ工科大学)

arXiv: 2506.10943v2 [cs.LG]

論文「Self-Adapting Language Models」を精読し、詳細に解説します。

論文精読「Self-Adapting Language Models」 (自己適応言語モデル)

1. 概要

この論文では、大規模言語モデル(LLM)が一度訓練されるとその重みが静的(固定的)であるという根本的な課題に取り組んでいます。新しいタスクや知識、事例に対応するために、モデル自身が自己の重みを適応させるメカニズムがないのが現状です。

そこで本研究では、SEAL (Self-Adapting LLMs) という新しいフレームワークを提案します。SEALは、LLMが自らのファインチューニング用データと更新指示(これらを総称して「自己編集; Self-Edit」と呼ぶ)を生成することで、自己適応を可能にするものです。この自己編集プロセスは強化学習(RL)のループによって最適化され、モデルは「どのような自己編集データが自身の性能向上に最も貢献するか」を学習します。実験では、新しい知識の取り込みとフューショット汎化の2つのタスクでSEALの有効性が示されています。

2. SEALのフレームワークと手法

SEALは、2つのネストされたループ構造を持つアルゴリズムとして設計されています。

内部更新ループ (Inner Loop): モデルが生成した「自己編集(SE)」データを用いて、勾配降下法によりモデルの重みを更新します。

外部RLループ (Outer Loop): 内部ループで更新されたモデルの性能を評価し、その結果(報酬)を最大化するように、自己編集を生成するポリシー(方策)を強化学習で最適化します。

この構造は、効果的な自己編集の生成方法をメタレベルで学習する「メタラーニング」の一種と見なすことができます。

強化学習のプロセス

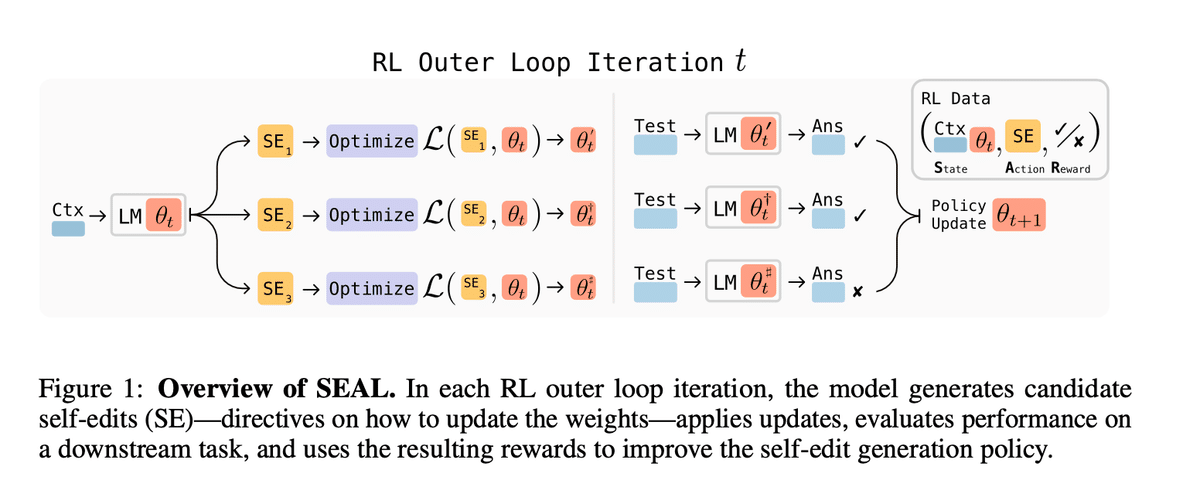

図1に示されるように、SEALの強化学習ループは以下のステップで構成されます。

図1:SEALの概要。各RL(強化学習)外部ループのイテレーションにおいて、モデルは自己編集(SE)の候補、すなわち重みを更新するための指示を生成します。そして、その指示に基づいて更新を適用し、下流タスクでの性能を評価し、結果として得られた報酬を用いて自己編集を生成するポリシーを改善します。

図の流れの解説:この図は、SEALがどのようにして「より良い自己編集」を学習していくかを示しています。自己編集の生成 (左側):まず、モデル (LM) にコンテキスト (Ctx) が与えられます。モデルは、そのコンテキストに基づいて、複数の自己編集 (SE₁, SE₂, SE₃) の候補を生成します。内部ループでの更新と評価 (中央):生成された各自己編集 (SE) を使って、モデルの重みを個別にファインチューニング(Optimize)します 5。これにより、一時的に更新されたモデル (LM θ') が複数作られます。更新された各モデルを、下流タスクのテスト (Test) で評価し、その答え (Ans) が正解 (✓) か不正解 (✗) かを判断します。ポリシーの更新 (右側):どの自己編集 (Action) が良い結果 (Reward) をもたらしたかのデータ(RL Data)を収集します。このデータを用いて強化学習を行い、モデルのポリシー(自己編集を生成する能力)を更新します (Policy Update) 。これにより、次のイテレーションでは、より性能向上に繋がる自己編集を生成しやすくなります。

この「生成→更新→評価→ポリシー改善」というサイクルを繰り返すことで、モデルは自己を適応させる能力を自律的に高めていきます。

1.状態 (State): タスクに関連する情報を含む「コンテキスト(C)」と、その時点でのモデルのパラメータ(θ)が状態となります。

2.行動 (Action): モデルはコンテキスト(C)を条件として、「自己編集(SE)」をテキストとして生成します。

3.更新 (Update): 生成されたSEを用いてモデルを教師ありファインチューニング(SFT)し、新しいパラメータ(θ')を得ます。

4.報酬 (Reward): 更新されたモデル(LM_θ')を評価タスクで実行し、その性能向上度に基づいて報酬(r)が計算されます。

5.ポリシー更新 (Policy Update): 期待される報酬が最大になるように、自己編集を生成するポリシー(つまりモデルのパラメータθ)を更新します。

この研究では、強化学習アルゴリズムとしてReST_EM(一種のフィルター付き模倣学習)を採用しています。これは、まず現在のモデルで複数の自己編集候補をサンプリングし、その中で正の報酬(性能向上)をもたらしたものだけを「正解データ」として扱い、SFTを行うというシンプルな手法です。

3. SEALの具体的な応用ドメイン

本論文では、SEALの汎用性を示すために、性質の異なる2つのドメインで有効性を検証しています。

3.1. 知識の取り込み (Knowledge Incorporation)

与えられた文章の情報を、コンテキストなしで利用できるようモデルの重みに統合するタスクです。

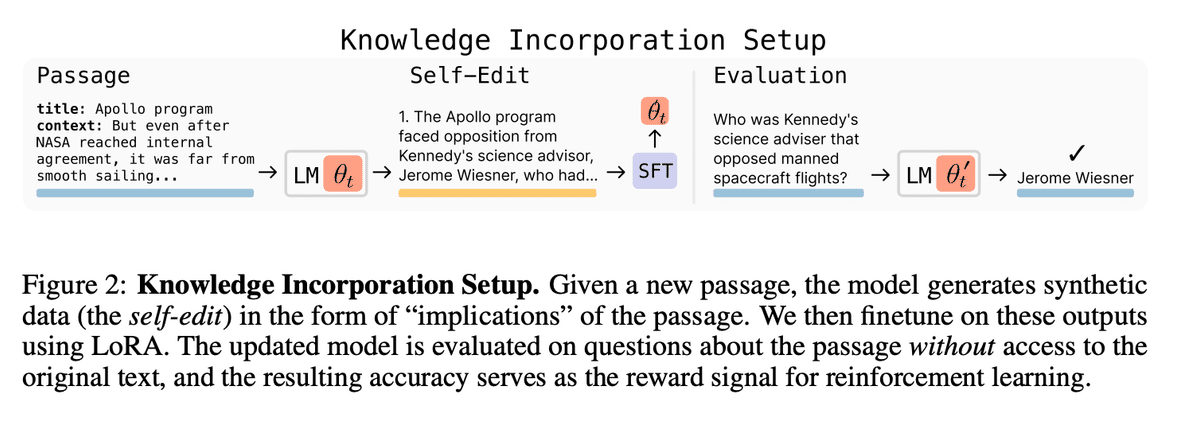

設定: 図2のように、モデルにSQuADデータセットの1つの文章(Passage)を与えます。自己編集として、その文章から導かれる「論理的な含意(implications)」を生成させます。この生成されたテキストでモデルを軽量なLoRAを用いてファインチューニングします。

評価: ファインチューニング後、元の文章を見せずに、その内容に関する質問に答えられるかを評価し、その正解率を強化学習の報酬とします。これにより、モデルは情報を最も効率的に「消化・吸収」できるような要約や言い換えの仕方を学習します。

3.2. フューショット学習 (Few-Shot Learning)

ごく少数の事例から新しいタスクのルールを学び、未知の問題を解く能力を評価するタスクです。

図2キャプションの翻訳: 知識の取り込み設定。新しい文章が与えられると、モデルは文章の「含意」という形で合成データ(自己編集)を生成します。我々はこの出力を用いてLoRAでファインチューニングします。更新されたモデルは、元のテキストにアクセスすることなく文章に関する質問で評価され、その正解率が強化学習の報酬信号として機能します。

[解説]この図は、SEALを「新しい知識をモデルに覚えさせる」タスクに適用した際の具体的な流れを示しています。

Passage (文章): モデルに「アポロ計画」に関する新しい文章が入力されます。

Self-Edit (自己編集): モデル (LM θt) は、入力された文章の内容をより学習しやすい形(例:「アポロ計画はケネディの科学顧問から反対された」)に書き直した「自己編集」データを生成します。

SFT (ファインチューニング): この自己編集データを使って、モデルの重みが更新されます。

Evaluation (評価): 更新されたモデル (LM θ't) は、元の文章を見ずに、関連する質問(例:「有人宇宙飛行に反対したケネディの科学顧問は誰か?」)に答えます。正しく「ジェローム・ウィーズナー」と答えられれば、高い報酬が与えられます。

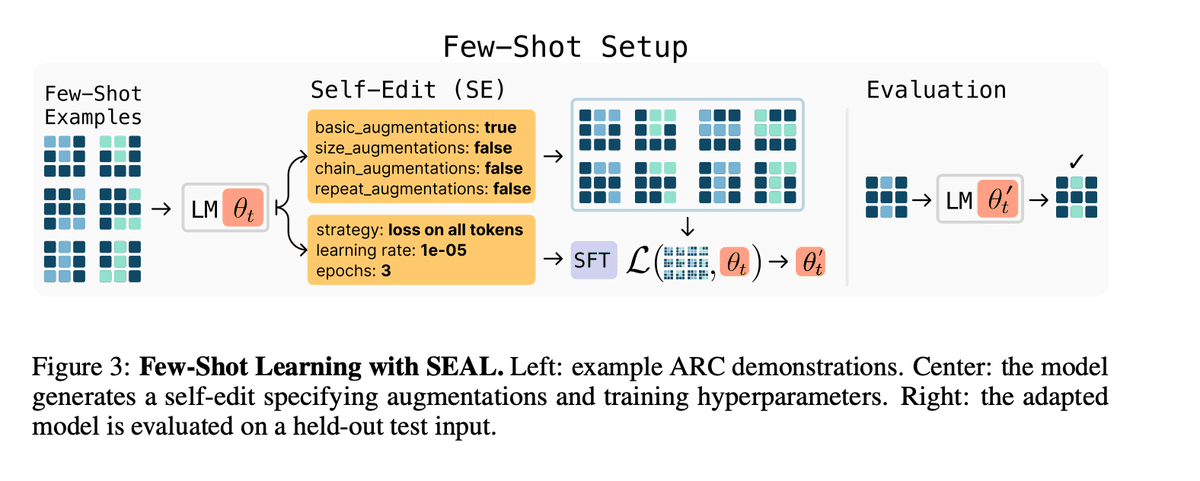

図3キャプションの翻訳:SEALによるフューショット学習。左:ARCのデモンストレーション事例。中央:モデルはデータ拡張と訓練ハイパーパラメータを指定する自己編集を生成します。右:適応されたモデルは、保留されたテスト入力で評価されます。

@解説]この図は、SEALを「少数の事例から新しいタスクを学ぶ」フューショット学習に応用した際の流れを示しています。

Few-Shot Examples (少数事例): モデルに、いくつかの入出力パターンの例が与えられます。

Self-Edit (自己編集): モデル (LM θt) は、テキストではなく、学習方法を指示する設定(JSON形式)を生成します。これには、どのデータ拡張を使うか(例:basic_augmentations: true)、学習率(learning rate: 1e-05)、エポック数(epochs: 3)などが含まれます。

SFT (ファインチューニング): この設定に従って、少数事例とその拡張データでモデルをファインチューニングします。

Evaluation (評価): 更新されたモデル (LM θ't) が、未知のテスト問題に対して正しい出力を予測できるかを評価します。

設定: 図3のように、抽象的な推論能力を測るARCベンチマークの事例(Few-Shot Examples)をモデルに与えます。

自己編集: このタスクでは、自己編集は自然言語の文章ではなく、学習方法を制御するための設定ファイル(JSON形式)です。具体的には、どのデータ拡張(回転、反転など)を適用するか、学習率やエポック数といった最適化ハイパーパラメータをどう設定するかをモデル自身が選択・生成します。

評価: 生成された設定に基づいてモデルを適応させ、未知のテスト問題が解けたかどうかを報酬として与えます。これにより、モデルはタスクごとに最適な学習戦略を自律的に設定する能力を獲得します。

4. 実験結果

4.1. フューショット学習

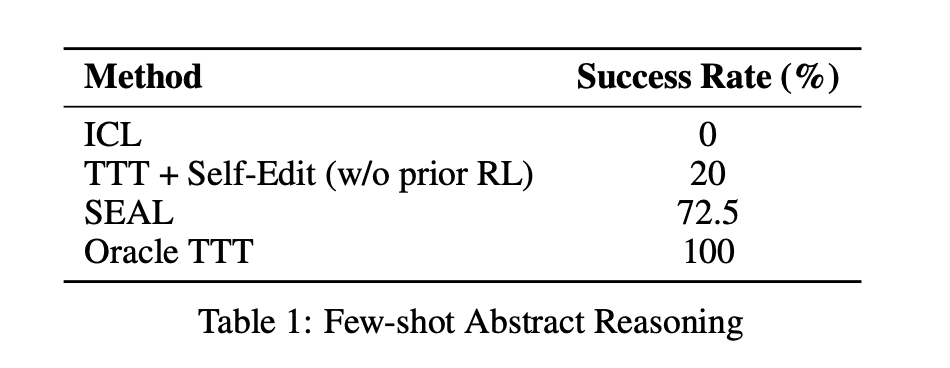

表1に示すように、Llama-3.2-1B-Instructモデルを用いた実験では、SEALが他のベースラインを大幅に上回りました。

-

ICL(文脈内学習): 0%

-

TTT + 自己編集(RLなし): 20%

-

SEAL: 72.5%

-

Oracle TTT(人間が最適化した設定): 100%

強化学習なしで自己編集を生成させた場合(20%)と比較して、SEAL(72.5%)はタスク成功率を劇的に向上させており、RLによって効果的な学習戦略の選択能力が獲得されたことが分かります。

[解説] この表は、フューショット学習タスクにおけるSEALの性能を他の手法と比較したものです。 ICL (In-Context Learning): 事例をプロンプトに含めるだけの標準的な手法では、成功率は0%でした。 TTT + Self-Edit (w/o prior RL): 強化学習なしでモデルに自己編集(学習設定)を生成させた場合、成功率は20%でした。 SEAL: 強化学習で自己編集の生成を最適化したSEALは、成功率を72.5%まで大幅に向上させました。 Oracle TTT: 人間が手動で最適な学習設定を見つけた場合(理論上の上限)は100%です。 この結果から、強化学習によってタスクごとに最適な学習戦略を自律的に選択する能力が大幅に向上することがわかります。

4.2. 知識の取り込み

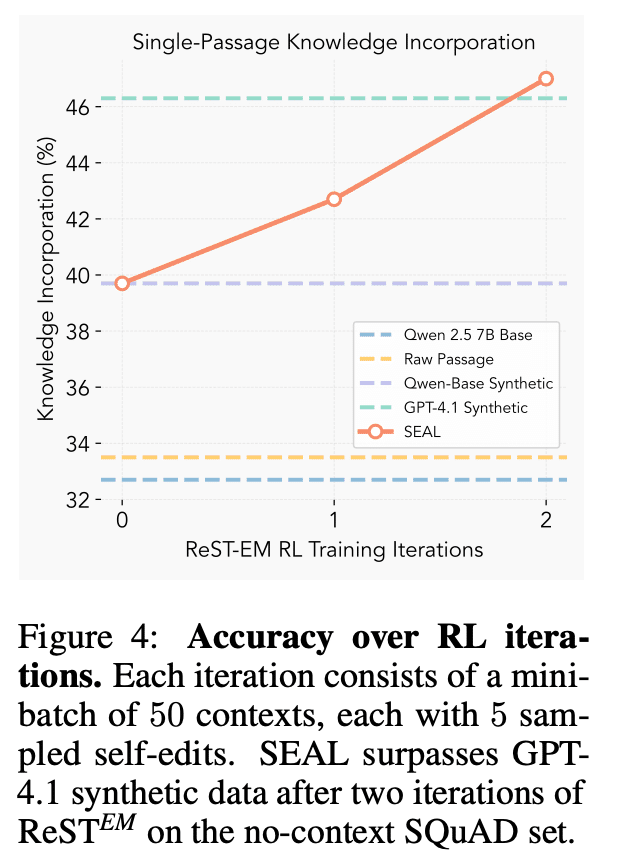

図4キャプションの翻訳: RLイテレーションを通じた正解率。各イテレーションは50のコンテキストから成り、それぞれ5つの自己編集がサンプリングされます。SEALは、コンテキストなしのSQuADセットにおいて、2回のReST_EMイテレーションの後にGPT-4.1の合成データ(の性能)を上回ります。

[解説]このグラフは、知識の取り込みタスクにおいて、強化学習(RL)の訓練を重ねることでSEALの性能がどのように向上するかを示しています。

縦軸は知識の取り込み性能(正解率)、横軸はRLの訓練イテレーション数です。

SEAL(オレンジ色の線)は、訓練イテレーション0回(RL訓練前)の時点でも、単に元の文章で学習する(Raw Passage)より高い性能を示しています。イテレーションを2回繰り返すことで、SEALの性能は47%近くまで向上し、巨大モデルであるGPT-4.1が生成した合成データで学習させた場合(緑色の点線)の性能を上回っています。これは、モデルが自身の学習に最適なデータ形式を生成する能力を獲得したことを示しています。

Qwen2.5-7Bモデルを用いた実験結果は、表2と図4にまとめられています。

-

単一文章の更新:

-

ベースモデル: 32.7%

-

元の文章のみで学習: 33.5%

-

SEAL: 47.0%

-

GPT-4.1が生成したデータで学習: 46.3%

-

-

継続的な事前学習 (CPT):

-

複数の文章(n=200)の情報をまとめて学習させる設定でも、SEALは58.2%という高い性能を達成し、その有効性が単一の更新に留まらないことを示しました。

-

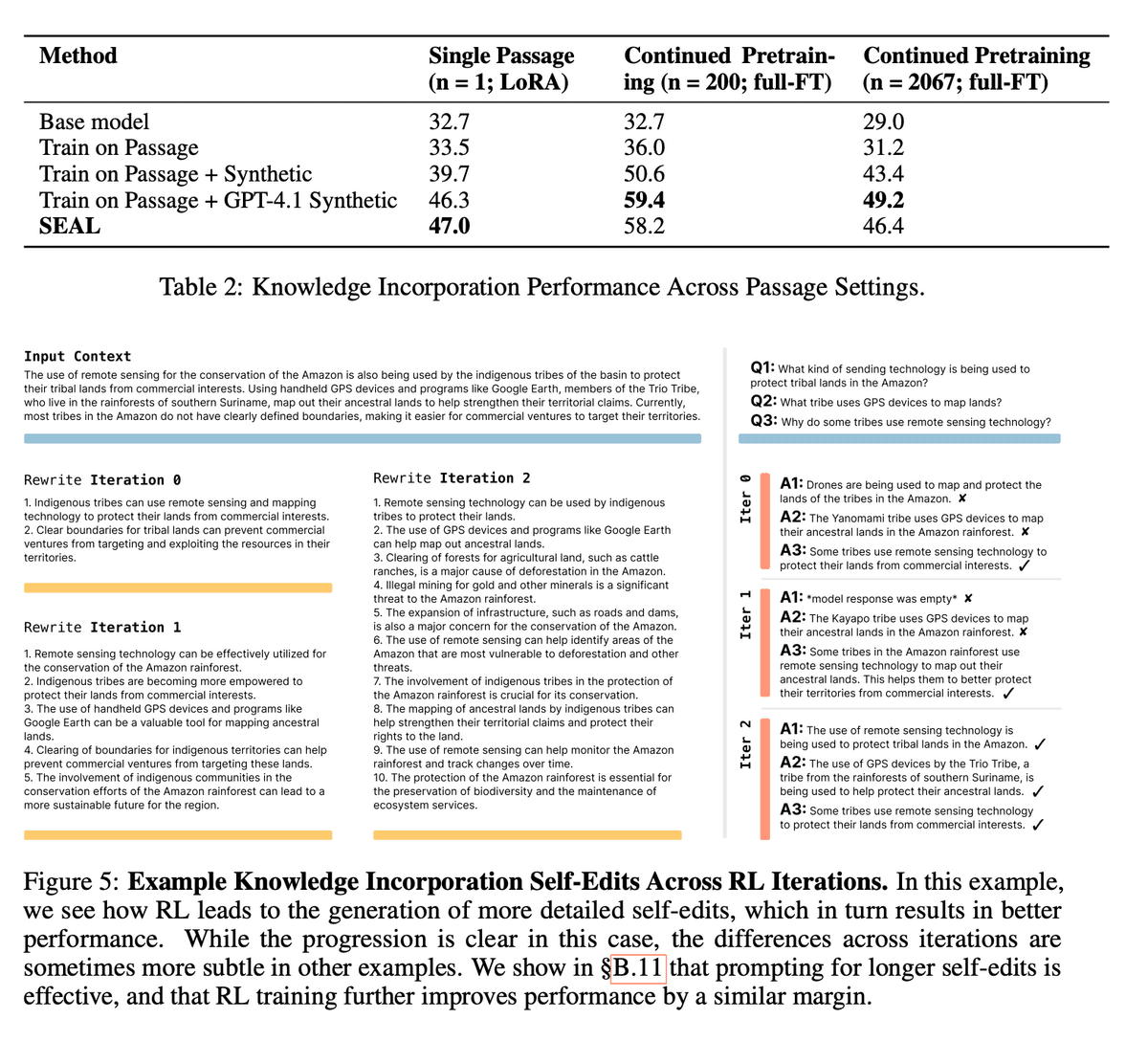

図5は、RLのイテレーションが進むにつれて、モデルが生成する自己編集(言い換え)がより詳細で質の高いものへと変化していく様子を示した定性的な事例です。

表2の解説: この表は、知識の取り込みタスクにおける各手法の性能を、3つの異なる設定で比較したものです。

Single Passage (単一文章): SEALは47.0%という最も高い正解率を達成し、GPT-4.1の合成データ(46.3%)を上回りました。

Continued Pretraining (継続的事前学習): 複数の文章(n=200, n=2067)をまとめて学習する設定でも、SEALは高い性能を示しており、その有効性がスケールすることを示唆しています。

図5の解説: この図は、RLの訓練イテレーションが進むにつれて、モデルが生成する自己編集がどのように質的に変化するかを示した具体例です。

Input Context: 「アマゾンの先住民族がリモートセンシング技術を使って土地を守っている」という内容の文章が入力されます。

Rewrite Iteration 0 (RL訓練前): 生成される自己編集は、元の文章の要点を短くまとめた2つの文だけです。この結果、3つの質問のうち1つしか正解できませんでした。

Rewrite Iteration 2 (RL訓練後): 生成される自己編集は、より詳細で具体的な情報を多く含む10個の文に増えています。例えば、森林伐採の原因や生態系保護の重要性など、元の文脈から推論される情報も含まれています。その結果、3つの質問すべてに正解できるようになっています。 この例は、RL訓練によってモデルが「より詳細で、学習に役立つ」自己編集を生成するようになり、それが直接的な性能向上に繋がっていることを明確に示しています。

5. 限界と課題

本研究は画期的な成果を上げていますが、いくつかの限界点も指摘しています。

破滅的忘却 (Catastrophic Forgetting): 複数の知識を連続して自己編集で取り込む実験を行ったところ、図6が示すように、新しい情報を学習するにつれて過去に学習したタスクの性能が徐々に低下する現象が確認されました。

計算オーバーヘッド: 報酬を計算するために、サンプリングした自己編集ごとにモデルのファインチューニングと評価が必要であり、膨大な計算コストがかかります。1つの自己編集の評価に30〜45秒を要したと報告されています。

評価の外部データ依存: 強化学習の報酬計算に、正解ラベル付きの評価データ(例:質問と答えのペア)が不可欠です 43。これにより、ラベルなしの巨大なコーパスでの学習へのスケールアップが困難になっています。

6. 結論と今後の展望

SEALは、LLMが静的な存在から、自ら学習戦略を立て、新しいデータに適応し続ける動的なシステムへと進化する道筋を示しました。

人間が生成したテキストデータが数年以内に枯渇するという「データ不足の壁」が予測される中、モデルが自ら高品質な学習データを生成する能力は、今後のAIの進歩に不可欠となる可能性があります 46。将来的には、SEALのフレームワークを継続的な事前学習や、環境と相互作用しながら自己を改良していくエージェントシステムに応用することで、より自律的でデータ効率の良いAIの実現が期待されます。

参考文献リスト(一部)

-

Akyürek, E. et al. (2025). The surprising effectiveness of test-time training for few-shot learning.

-

Chollet, F. (2019). On the measure of intelligence.

-

Hu, E. J. et al. (2022). LoRA: Low-rank adaptation of large language models.

-

Rajpurkar, P. et al. (2016). SQuAD: 100,000+ questions for machine comprehension of text.

-

Schulman, J. et al. (2017). Proximal policy optimization algorithms.

-

Singh, A. et al. (2024). Beyond human data: Scaling self-training for problem-solving with language models. (ReST_EMを提案した論文)

-

Yang, Z. et al. (2025). Synthetic continued pretraining.

SEALはGPT-6なのか?

MITの研究チームが発表した画期的な論文『SEAL』。その著者の一人である Ekin Akyürek氏が、現在OpenAIに在籍しているのは事実です。彼のプロフィールにはっきりと「Research @OpenAI | MIT PhD '25」と書かれています。

しかし、GPT-6との関連付けは憶測です。SEALの技術がGPT-6に直接採用されるという話は、現時点では公式な情報源のない推測(憶測)です。トップ大学院の研究者が大手AI企業に就職・インターンすることは非常に一般的であり、その人の研究が即座に次期製品に直結するとは限りません。

この論文の責任著者(指導教官)はMITの Pulkit Agrawal准教授であり、彼の研究室「Improbable AI Lab」から生まれた成果です。論文の提出者も、同研究室の学生であるJyothish Pari氏です。

Pulkit Agrawal

https://people.csail.mit.edu/pulkitag/

What if an LLM could update its own weights?

— Jyo Pari (@jyo_pari) June 13, 2025

Meet SEAL🦭: a framework where LLMs generate their own training data (self-edits) to update their weights in response to new inputs.

Self-editing is learned via RL, using the updated model's downstream performance as reward. pic.twitter.com/LMWVJYZaXA

「GPT-6」への適用の現実的な課題

SEALのような自己学習・編集機能を次期GPTのような大規模商用モデルにそのまま組み込むには、複数の大きなハードルが存在します。

-

パフォーマンスとUXの懸念: 現在の最先端LLM「GPT-5」でさえ、応答速度や安定性が課題となることがあります。ここにリアルタイムでの自己編集とファインチューニングのループを加えれば、パフォーマンスが著しく低下し、ユーザー体験を損なう可能性があります。

-

システム複雑性と制御の難易度: 現代のLLMは、単一モデルではなく、複数の推論プロセスや安全フィルターが組み合わさった複雑なシステムです。ここに動的な自己書き換え機能を導入すると、システムの複雑性が爆発的に増大し、挙動の予測やメンテナンス、安全性の担保が極めて困難になります。

-

コストと実用性のトレードオフ: 自己編集のたびに発生する膨大な演算コストは、汎用的なチャットAIが提供する価値と見合わない可能性があります。常に最新情報を反映させるより、定期的な大規模な再学習の方が効率的かもしれません。

より有望な応用先:パーソナルアシストロボット

一方で、ご提案のパーソナルアシストロボットへの応用は、この技術の特性とAgrawal氏の研究背景の両方から見て、非常に有望な方向性と言えます。

-

Agrawal氏の研究背景との一致: 彼の研究キャリアの中心は、ロボットが実世界と相互作用しながら学習する「計算論的センサーモーター学習」です。SEALの「新しいデータにその場で適応する」能力は、まさに個別の家庭環境やユーザーの癖といった、静的な大規模データではカバーしきれない情報をロボットが学習するために不可欠な技術です。

-

「静的な重み」からの脱却の重要性: クラウド上のLLMと異なり、個々のロボットは自分だけの経験を積んでいきます。「昨日覚えた物の場所」「新しい家族の顔」「ユーザーの新しい口癖」など、継続的に知識を更新し、パーソナライズしていく必要があります。SEALは、この「凍結された重みの時代(frozen-weights era)」を終わらせ、真にユーザーと共に成長するエージェントを実現する鍵となり得ます。

-

実世界での応用事例: Agrawal氏が創業したSafelyYouは、まさに特定の環境(居室)を継続的に監視し、個人の転倒リスクを学習・検知するシステムです。これは、SEALが目指す「特定のコンテキストに適応し続けるAI」のコンセプトを、より専門的な形で実現した例と見ることができ、彼の研究思想が一貫していることを示しています。

まとめ

結論として、「SEAL」の技術的価値は、不特定多数に即時応答する巨大LLMの進化というよりは、特定の環境や個人に深く寄り添い、継続的に学習・適応していくパーソナルなAI(特に物理的な身体を持つロボット)の実現において、より大きな可能性を秘めている、という視点で読むことができます。

#AICU AIDXLab

Originally published at note.com/aicu on Oct 13, 2025.

Comments