GREE Tech Conference 2025にて、グリーホールディングス株式会社 マネージャーの奥野 緑氏が登壇しました。「生成AIを安心して活用するために 『情報セキュリティガイドライン』 策定とそのポイント」と題し、同社における生成AI活用のためのルール整備について講演しました。大変示唆に富んだ内容であるとともに「つくる人をつくる」をビジョンにするAICUでも取り入れるべき内容が多くあったので紹介していきたいと思います。

動画は1:40:00ぐらいから始まります

ガイドライン策定の背景

ガイドライン策定の背景にあるのは、「急速な生成AI普及」です。2023年、ChatGPTが数ヶ月で利用者数1億人を突破し、「『AI元年』と呼ばれる社会的ブームに」なりました。これを受け、グリー社内からも「安心して活用したい」といった要望が高まりました。このため、「生成AIの業務活用には明確なルールが必要であること」が明らかになり、ガイドライン策定に至りました。

「生成AI利用ガイドライン」の解説

ガイドラインの目的

ガイドラインでは、以下の3つを目的として明記しています。

-

生成AI活用による業務効率向上とアイデア創出の促進

-

情報漏洩リスクの回避

-

安全な活用のためのルール・手続きの明確化

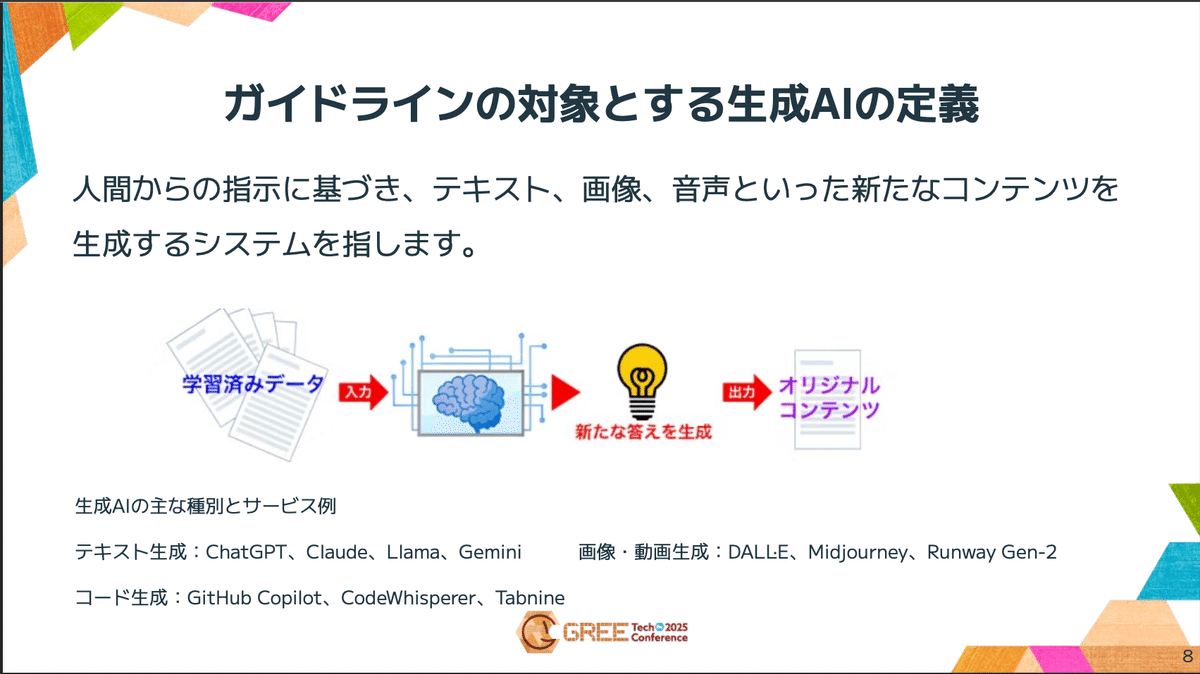

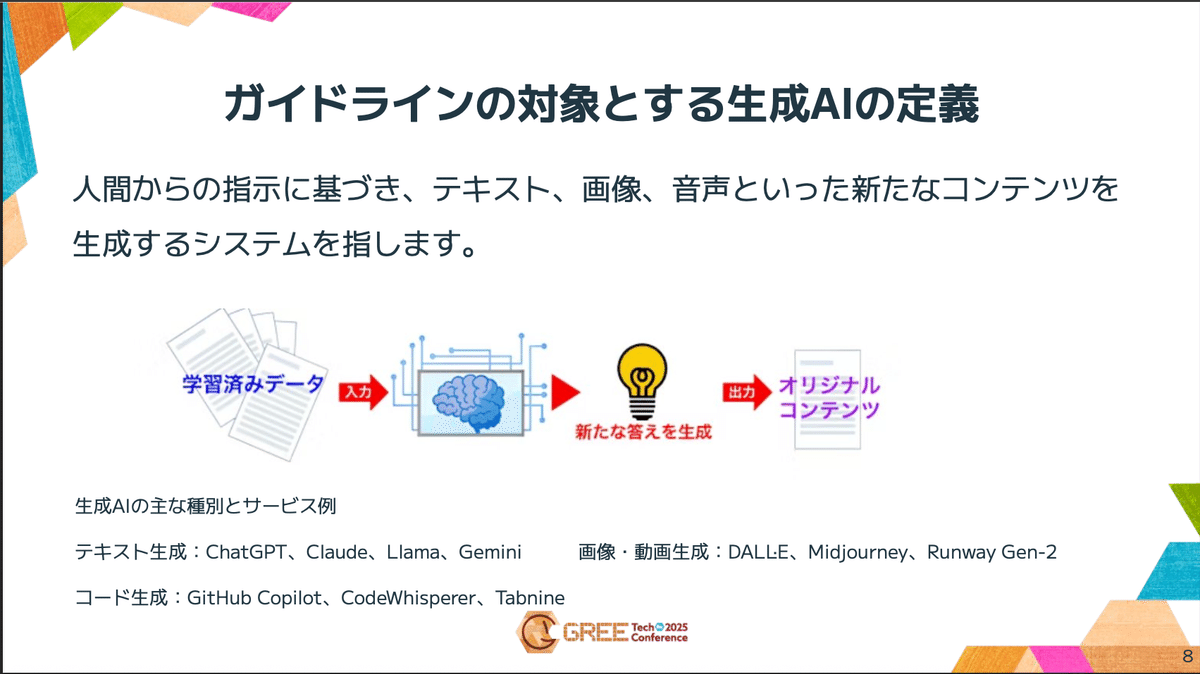

対象とする生成AIの定義

ガイドラインの対象は、「人間からの指示に基づき、テキスト、画像、音声といった新たなコンテンツを 生成するシステム」と定義しています。これにはChatGPT、Claudeといったテキスト生成AIのほか、画像・動画生成やコード生成AIも含まれます。

「定義がないと…」と奥野さんは語ります

ガイドラインでは、目的の次に、対象とする「生成AIの定義」も明記しています 。「定義がないと…」と奥野さんは語ります。その真意は、「もし定義が曖昧だと、これは対象となるのか、ならないのかといった混乱や抜け漏れが生じてしまいます」 という点にあります。

そのため、「ガイドラインの適用範囲を明確にすることも大切だと考えています」 と述べ、定義の重要性を強調しました。 ちなみに、グリーのガイドラインでは、生成AIを「人間からの指示に基づき新しいコンテンツを作り出すシステム全般を指しています」 と定義しています。

利用可否の判断:「情報分類」が鍵

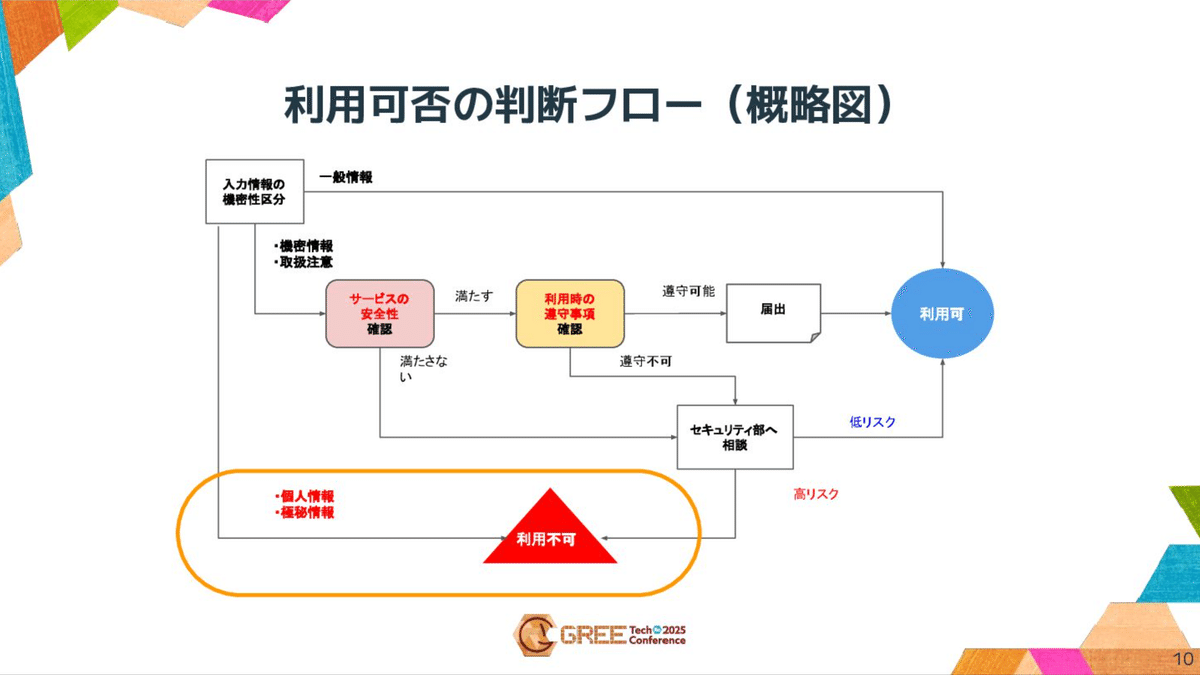

グリーでは、「情報分類別で生成 AIへの入力可否を判断」しています。

情報分類別で生成 AIへの入力可否を判断

グリーの情報分類(極秘情報、機密情報、取扱注意、一般情報)と「個人情報あり」「個人情報なし」の軸で、生成AIへの入力可否を定めた表です。

このルールの下では、「極秘情報」(回復不可能な損害)は個人情報の有無にかかわらずNGとなります。「機密情報」(容易に回復できない損害)と「取扱注意」(損害を与えるおそれが少ない)は、「個人情報なし」の場合に限り、「『サービスの安全性』と『利用時の遵守事項』が守れたら」OKとなります。

セキュリティ部が判断するのではなく、サービスのオーナーがその機密度・重要度で判断するそうです。

利用可否の判断フロー(概略図): 入力情報の機密性区分に応じた利用可否の判断フローです。個人情報・極秘情報は即座に「利用不可」へと分岐しています。

なぜ個人情報・極秘情報を安易に入力してはいけないのか

奥野氏は、「なぜ個人情報・極秘情報を安易に入力してはいけないのか」について、法律とリスクの両面から解説しました。

1. 法律上の規定

法律上の定めはコンプライアンス上「何よりも優先すべき」ですが、実は「極秘情報」に関しては、「法律上の規定なし」というのが現状です。一方、「個人情報」については個人情報保護法に規定があります。ポイントは第17条「利用目的を特定」、第18条「目的外利用はNG」、これは通常の個人情報利用と同じルールが当てはまります。しかし第27条の「本人同意なく第三者提供は禁止」という点については気をつけなければなりません。

個人情報保護委員会は、AIへの入力が機械学習などに使われなければ「第三者提供に当たらない」と整理しています。しかし、グリーでは「ただしAIの挙動や実際の取扱いは不透明」と判断し、「社内ルールとしては同意取得が安心」というスタンスをとっています。

結論として、法律は「禁止はしてはいない」ものの、「第三者提供」に該当する可能性への対応が必要だとしています。

2. 法律以外のリスク

なぜ法律上は「第三者提供には当たらない」とされつつも、グリーグループでは「個人情報・極秘情報を安易に入力してはいけないのか」という点について、奥野氏は法律面以外にも、以下の4つのリスクがNGの理由として整理しました。

理由①: 「外部送信=制御不能」

まず1つ目は、入力情報は外部に送信され、「完全な追跡・削除は難しい」という点です。生成AIに情報を入力した瞬間に、もう自分たちはコントロールできないという生成AIの特徴があります。生成AIに情報を入力すると、その時点で外部に送信されてしまうので、送った瞬間にこちらでの管理は難しくなります。また、入力した情報がサービス提供者側で一時的に保存される可能性もあり、たとえ学習しない設定があっても、一度送った情報をどこに保存されているのかを追跡したり、後から消したりすることは完全には現実的に不可能となります。

理由②: 「運用・バグリスク」

2つ目の理由は、サービス側の不具合で情報が露出するリスクです。生成AIのバグにより意図せぬ漏洩リスクがあるということです。過去にはチャット履歴が公開されてしまったようなサービスもありました。

理由③: 「検知策の未成熟」

3つ目は、不適切な利用を検知するツールが未成熟で、「監査ログを備えるAIサービスが少ない」現状です。生成AI専用のセキュリティツールがまだ十分に普及していないことや、生成AIサービス自体に監査ログが備わっていないものが多いという理由があります。そのため、利用の記録や追跡が難しく、インシデントが発生した際に適切に対応できるかというのは不透明です。

理由④: 「信頼性評価の難しさ」

4つ目は信頼性評価の難しさ、生成AI特有のセキュリティ基準に基づく「審査・認証する公的制度は整備途上」であるためです。AI向けの国際規格は実は既に存在しています。2023年に制定されたISO/IEC 42001です。この規格は倫理性や透明性などを含むAIを安全かつ信頼できる形で運用するための総合的な仕組みであり、単体ではありませんが、セキュリティも含まれています。ただし、規格は整備されたものの、審査、認証を行う体制はまだ整備中で、AIサービスの信頼性を客観的に評価する仕組みはまだ十分とは言えません。

「条件付きOK」の条件

このように生成AIに入力した情報はコントロールが効かず消せないし漏れるかもしれないというリスクがあります。さらにそのようなリスクを低減するための監視や認証の仕組みもまだ整っていないという状況です。だからこそ個人情報や極秘情報は最重要な情報として現時点では生成AIサービスへの入力しないようにという慎重なルールにしています。

グリーグループではその判断材料としていくつかのチェックポイントを設けています。

まずISMSやPマークなどの認証を持っているか。これらは生成AI専用の認証ではありませんが、サービスの提供元が情報セキュリティや個人情報保護の観点で一定の基準をクリアしているかを図る目安になります。インシデント歴は過去に重大なインシデントが発生していないか、もし発生した場合でもその時にちゃんと適切な再発防止策が取られて同じようなインシデントが再発していないかというのを確認しています。

秘密保持契約については、入力したデータを守ることが契約やポリシーとして明示されているかというのを確認します。具体的には、サービス提供元の利用規約やプライバシーポリシーを確認して、秘密保持、データ保護などの条項が明記されているかというのをチェックしています。

次の「入力データが学習に利用されないか」というのは、こちらの項目は生成AI独自の確認項目で、一番重要とも言えます。学習しない、もしくは利用者側で学習しない設定にできるかということを確認しています。最後の問い合わせ窓口が整備されているか、こちらは不具合があったときにすぐ相談できる体制となっているかというのを確認しています。こうした観点を総合的に確認することで、このサービスは機密情報や取り扱い注意情報を入力しても大丈夫かを判断しています。

もう一つの条件として、利用時の遵守事項があります。先ほどのサービスの安全性はサービス自体が安全かどうかということの確認事項でした。一方でこちらは利用者自身が守るべきルールとなります。こちらもまた一例なのですが、基本的な確認事項としては、個人情報や極秘情報は入力禁止というのを念押しして、必ず会社のアカウントで使うこと、つまりプライベートのアカウントは控えてねっていうのと、生成コードを業務に組み込む場合はそのまま使わず、必ずレビューを実施することといった遵守事項をつけています。

さらにグリーグループのサービスに組み込む場合には、APIキーや管理画面用のアカウントを各利用部門にて適切に管理することを求めています。

agent機能のリスク

また最近ではエージェント機能を使う生成AIサービスも増えてきました。これはAIが自動で操作を進めてしまうリスクがあるため、自動実行ではなく都度確認する設定にすること、また削除や変更、APIキーの利用といった危険な操作はさせないことというルールも設けています。このようにサービスの安全性に加えて、利用者側にも守るべきルールを設けています。

https://www.aicu.jp/post/chatgpt-atlas-20251022

ガイドラインができるまで

次に前述のガイドラインをどのような流れで作ったのかについてお話しします。まず、セキュリティ部にてガイドライン案を作成しました。具体的には、生成AI利用に伴うリスクの洗い出しと、そのリスクを低減するための対策、ルールを策定しました。既にお話しした、どこまでの情報なら入力してよいかとか、どんなサービスなら利用してよいかといった条件などです。

利用時の遵守事項

利用者が守るべきルールも定められています。

特に「agent機能がある場合」は、「『都度確認』設定とし、『常時承認』設定は使わない」、「削除・構成変更などリスクの高い操作は原則人手で実行」といった、より慎重なルールが設けられています。

策定の流れと関連部門

ガイドラインの策定は、セキュリティ部だけでなく、「法務部門」「個人情報管理部門」「リスクマネジメント部門」「情報システム・インフラ部門」といった関連部門と連携して進められました。

決定プロセスは、セキュリティ部での方針案作成、関連部門との連携を経て、「情報セキュリティ委員会にて方針案を検討・承認」、最終的に「経営会議での決定」という流れをたどりました。

これは、「『事業に大きく関わる事項』として、最終的に経営会議で承認され、全社的な利用方針として決定」されたことを意味します。

一過性の流行によるAIの導入ではなく、経営の重要な判断としての取り組みであり、個々の技術者や経営層のスタンドプレイではないことが想像できます。

課題及び工夫

ガイドライン運用の課題

ガイドラインの運用には、6つの主要な課題があります。

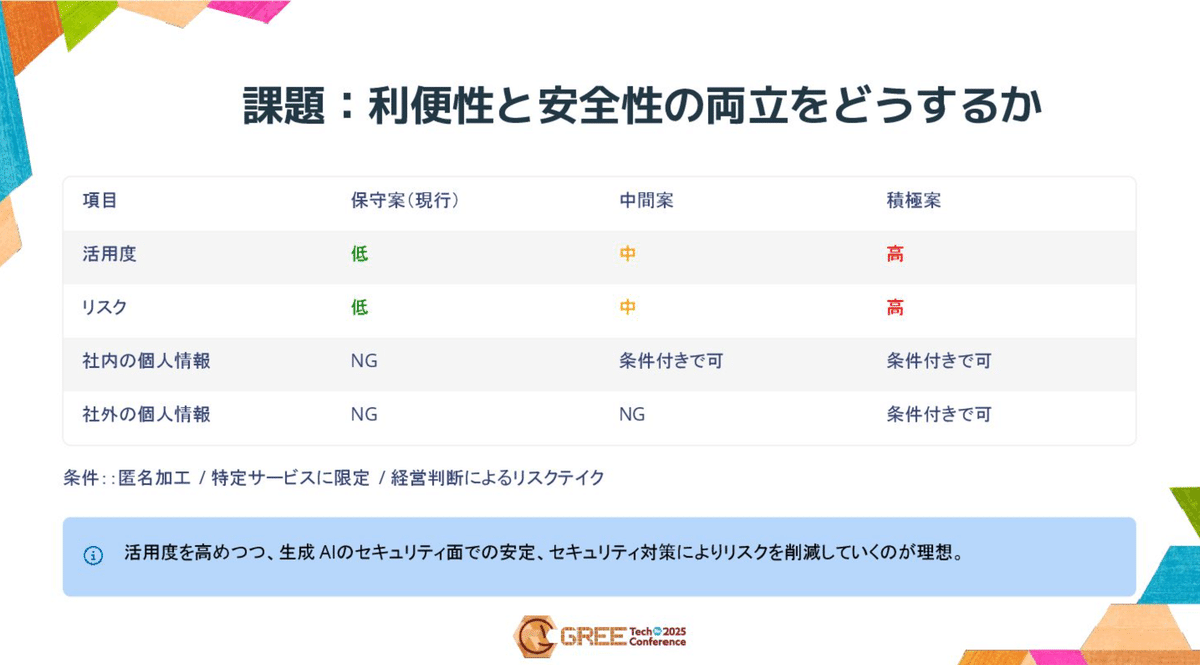

ガイドライン運用における6つの課題です。「技術進化への対応」「利便性と安全性の両立」「ルールの複雑化・利用者の理解不足」「相談対応の負荷」「検知策の未成熟」「公的認証の未整備」が挙げられています。

最大の課題は「利便性と安全性の両立」です。特に個人情報の取り扱いについては、活用の度合いとリスクのバランスをどう取るか、継続的な検討が求められます。

課題:利便性と安全性の両立をどうするか: 個人情報の取り扱いに関する3つの案(保守案・中間案・積極案)を比較した表です。現行の「保守案」では社内外の個人情報をNGとしていますが、将来的には「活用度を高めつつ、セキュリティ対策により、リスクを削減していくのが理想」としています。

また、「ルールの複雑化」も課題であり、実際の判断フローは社内システムとの連携なども含む複雑なものとなっています。

運用における4つの工夫

これらの課題に対し、グリーでは4つの工夫を実践しています。

利用者の効率化

「公式導入済み生成AIは『ホワイトリスト』に登録し、個別の安全性確認を省略」しています。さらに「『確認中リスト』『NGリスト』を公開し、利用可否の自己判断を迅速化」しています。

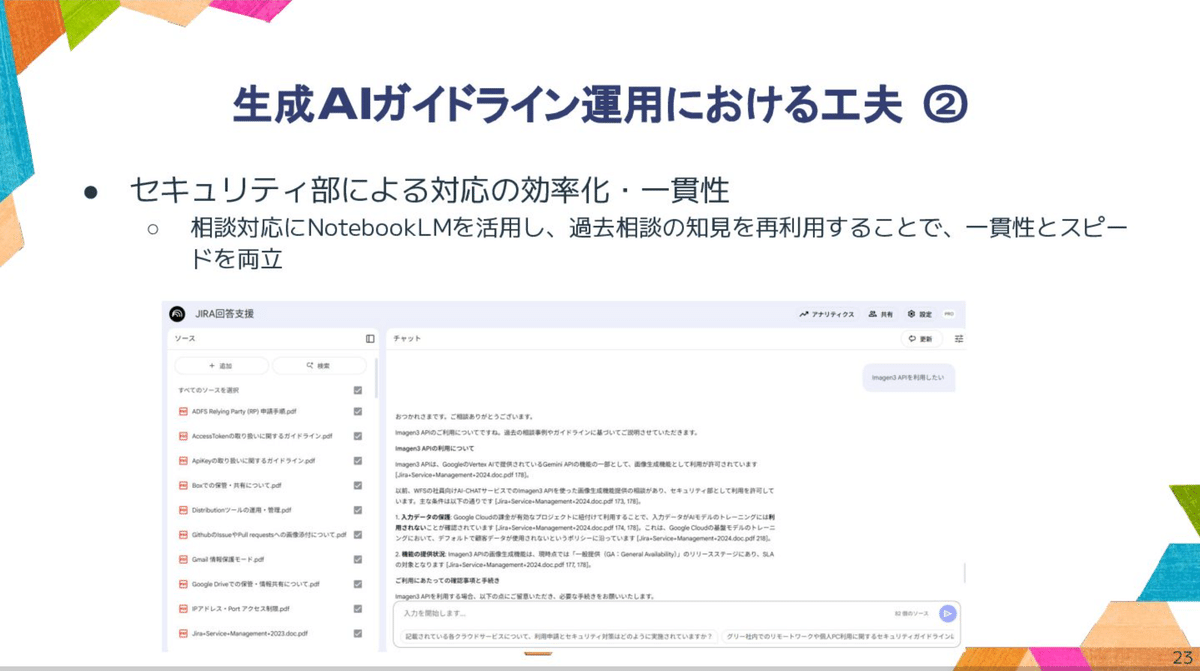

対応の効率化・一貫性

「相談対応にNotebookLMを活用し、過去相談の知見を再利用することで、一貫性とスピードを両立」させています。スライドでは「JIRA回答支援」の例が示されました。

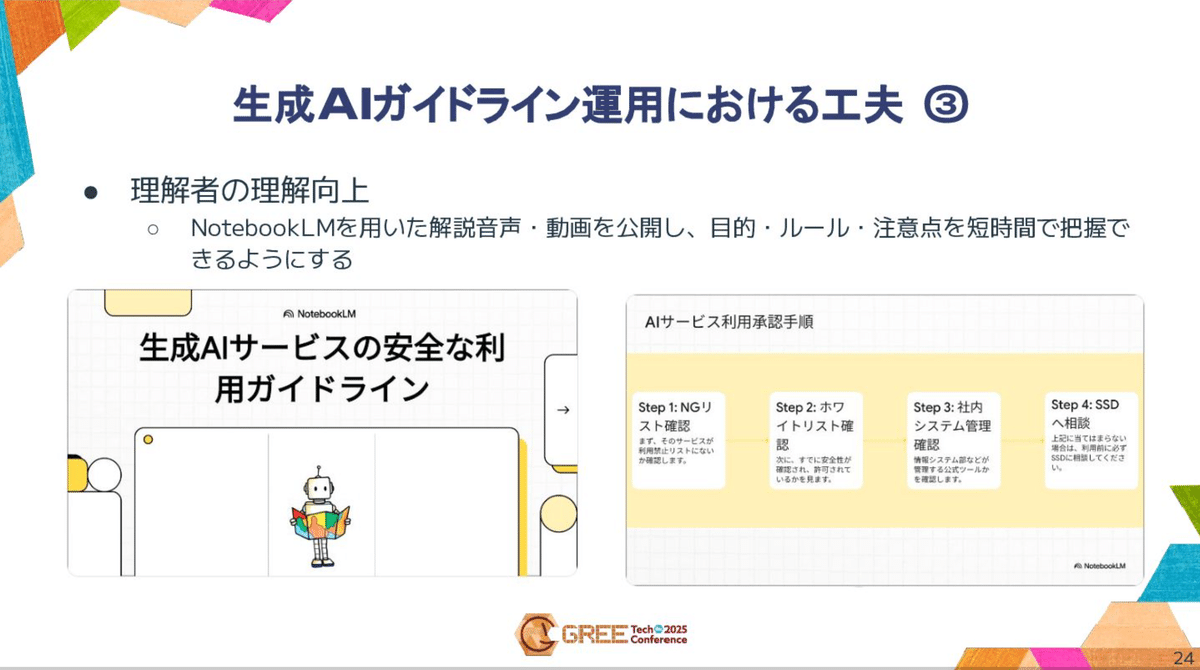

利用者の理解向上

「NotebookLMを用いた解説音声・動画を公開し、目的・ルール・注意点を短時間で把握できるようにする」取り組みも行っています。

他社事例の収集

「ガイドライン/利用状況の情報交換を継続し、...随時更新」するとともに、「社外の利用動向・ベストプラクティスを定期的に経営陣へ共有し、意思決定を支援」しています。

まとめ:安全に生成AIを活用するために

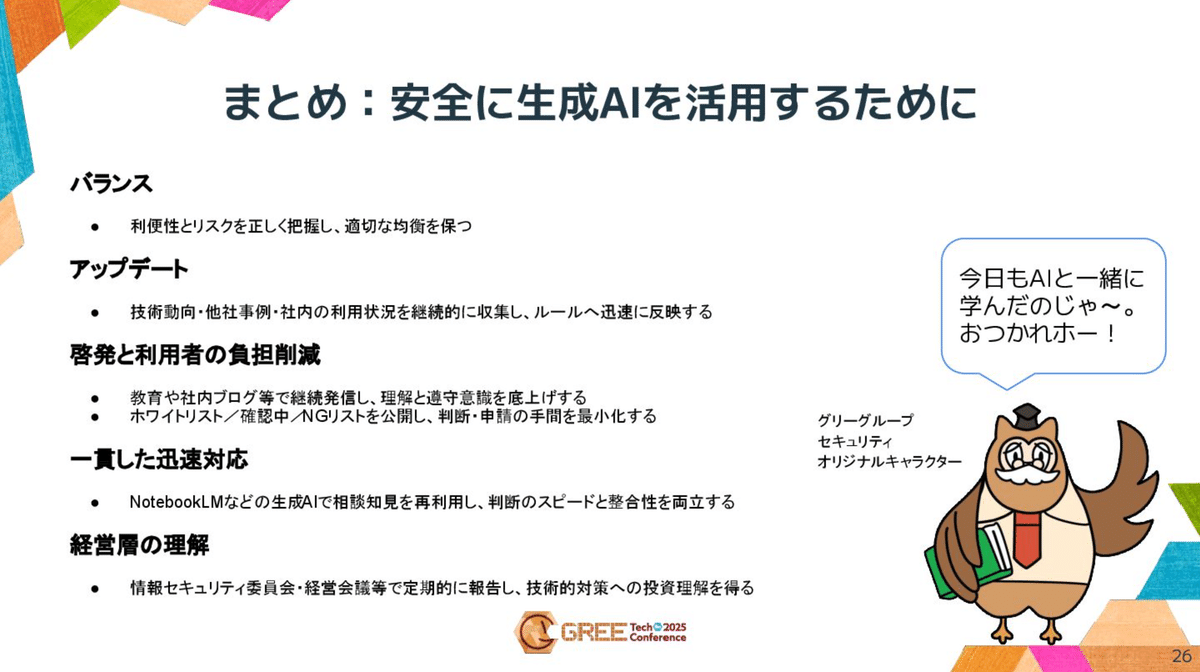

奥野氏は、安全な活用のために大切なこととして以下の5点を挙げました。

-

バランス: 「利便性とリスクを正しく把握し、適切な均衡を保つ」

-

アップデート: 「技術動向・他社事例・社内の利用状況を継続的に収集し、ルールへ迅速に反映する」

-

啓発と負担削減: 「教育や社内ブログ等で継続発信し、理解と遵守意識を底上げする」

-

一貫した迅速対応: NotebookLMなどを活用し、「判断のスピードと整合性を両立する」

-

経営層の理解: 「情報セキュリティ委員会・経営会議等で定期的に報告し、技術的対策への投資理解を得る」

以上で講演を締めくくりました。

https://hd.gree.net/jp/ja/sustainability/internet-society/information-security/

AICU AIDX Labの感想

「ルールは利用を邪魔するためではなく、安心して使うための土台」。

非常に短い時間の講演でありながら、生成AIをエンタープライズが使用する上での2025時点でのガイドライン「現在地」が非常にロジカルに描かれているのが印象的でした。多くのAI情報商材のマーケティングでは「AIを使うこと」が目的化していたり、一方では十分なAI利用が一般化したり、エンジニアリングやマーケティング、顧客管理などのITサービス企業の通常業務の中での使用可能なガイドラインの整備が未解決だったりする現状が見え隠れする中、他者でも見習うべきガイドラインとその策定経緯が公開されたことは意義深いと考えます。また中でもChatGPT Atlasにも代表される、ユーザーに代わって操作代行もできるエージェント時代の問題についても触れられています。

AICUでは「つくる人をつくる」をビジョンに活動しています。今回はITメガベンチャーの老舗であるグリー、しかも内部監査やセキュリティといった部門から、「企業が安心して活用するためのガイドライン」を「つくる人」を発見できたことを嬉しく思いました。

皆様の企業でも、もし「もっと面白い取り組みをしているよ」という例があれば、是非をお伝えください。

最後に本記事を執筆するにあたり関係各位に謝辞を述べさせていただきます。

グリーホールディングス株式会社 ビジネス・テクノロジー本部 セキュリティ部 企画チーム 奥野 緑さん

株式会社グリー 佐島 豊さん

ご取材ご対応いただきありがとうございました!

こちらも是非ご参照ください

https://note.com/gree_it/n/nca3bb121fb79

https://corp.aicu.ai/ja/gree-tech-20251026

Originally published at note.com/aicu on Oct 25, 2025.

Comments