2024年5月13日に OpenAI は新しい生成aiモデルであるGPT-4oをリリースしました。

公式リリースの翻訳をベースにわかりやすく詳細にお送りします。

https://openai.com/index/hello-gpt-4o/

新しくできるようになったこと

- 音声と動画から返答できる音声モード

- テキスト、推論、コーディングの改善

- 応答速度の高速化

- APIの低価格化

- 無料ユーザ向けのツール

GPT-4oの紹介

GPT-4o (Omni) は、人間とコンピューターのより自然な対話に向けたメジャーアップデートです。テキスト、音声、画像のあらゆる組み合わせを入力として受け入れ、テキスト、音声、画像の出力のあらゆる組み合わせを生成します。音声入力にはわずか 232 ミリ秒で応答でき、平均では 320 ミリ秒で、会話の中における人間の応答時間とほぼ同じです。英語のテキストおよびコードでは GPT-4 Turbo のパフォーマンスに匹敵し、英語以外の言語のテキストでは大幅に改善され、API でははるかに高速で 50% 安価です。 GPT-4o は、既存のモデルと比較して、特に視覚と音声の理解に優れています。

GPT-4oの機能について

現在、GPT-4oは既存のどのモデルよりも、あなたが共有する画像を理解し、議論することに優れています。例えば、異なる言語で書かれたメニューの写真を撮影し、GPT-4oに話しかけて翻訳したり、料理の歴史や意義について学んだり、おすすめの料理を教えてもらったりできるようになりました。将来的には、より自然なリアルタイムの音声会話や、リアルタイムの動画でChatGPTと会話できるように改良される予定です。例えば、ChatGPTにスポーツの試合中継を見せることで、ルールを説明してもらうことができます。これらの新機能を備えた新しい音声モードが、今後数週間のうちにアルファ版としてリリースされる予定だそうです。

GPT-4o 以前は、音声モードを使用して、平均 2.8 秒 (GPT-3.5) および 5.4 秒 (GPT-4) の遅延で ChatGPT と会話していました。これを実現するために音声モードは 3 つの個別のモデルのパイプラインを用いていました。1つ目で音声をテキストに変換し、2つ目でGPT-3.5 または GPT-4 にテキストを取り込んでテキストを出力し、3 番目でそのテキストを音声に変換しています。このプロセスはGPT-4 が多くの情報を失うことを意味します。GPT-4 は、音調、複数の話者、環境音を直接観察することができず、笑い声や歌を発声したり、感情を表現したりすることができませんでした。

GPT-4o では、テキスト、ビジョン、オーディオにわたって単一の新しいモデルをエンドツーエンドでトレーニングしています。これはすべての入力と出力が同じニューラル ネットワークによって処理されることを意味します。 GPT-4o はこれらすべてのモダリティを組み合わせた最初のモデルであるため、このモデルで何ができるか、そしてその限界を探る上で、まだ表面をなぞったにすぎないと言えます。

動画によるデモ

- 複数の声で歌う https://vimeo.com/945587746

- カメラを使って指示されたものに対しスペイン語で答える https://vimeo.com/945587424

- オンライン会議に参加する https://vimeo.com/945587401

- リアルタイム翻訳をする https://vimeo.com/945587808

- 子守唄を考えて囁くように歌う https://vimeo.com/945587944

- 相手の要求に応じて素早くしゃべる https://vimeo.com/945587927

- バースデーケーキを見せることで近くにいる人の誕生日であることを推測する https://vimeo.com/945587911

- 犬を見せることでかわいらしいものを見るような反応をする https://vimeo.com/945587891

- ギャグに対して面白いという反応を見せる https://vimeo.com/945587876

- 周りの風景を見せることでどこにいるか、何が見えるかを盲目の相手に説明する https://vimeo.com/945587840

- 2つのGPT-4o同士で対話させる https://vimeo.com/945587185

- 面接時の容姿についてカメラで見てもらいながら相談するhttps://vimeo.com/945587286

- じゃんけんのレフェリーをする https://vimeo.com/945587306

- 皮肉を言う https://vimeo.com/945587393

- 家庭教師として数学の問題を子供に教える https://vimeo.com/945587328

GPT-4oの評価について

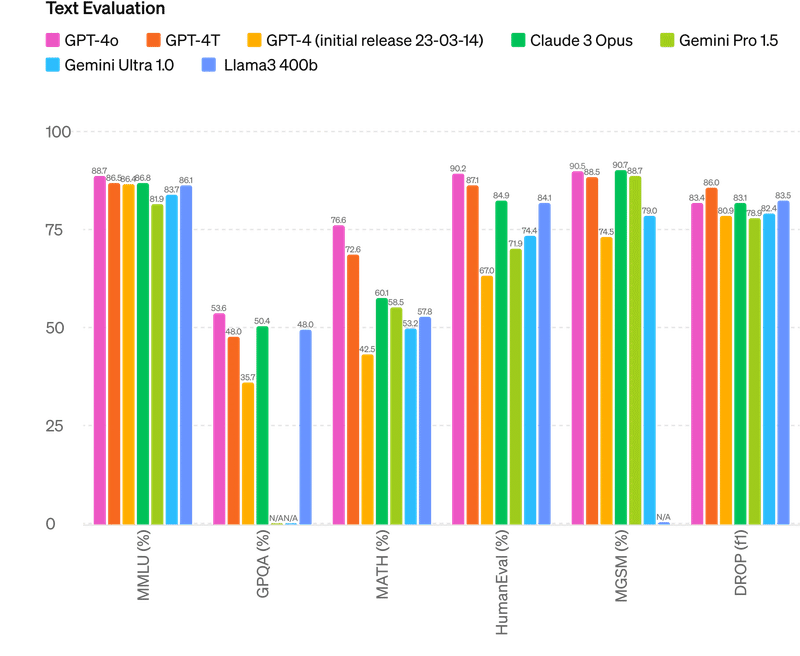

Text Evaluation テキスト評価

推論の改善 — GPT-4o は、0 ショットの COT MMLU (一般知識の質問) で 88.7% のハイスコアを記録しました。これらすべての評価は、評価ライブラリでおこないました。さらに、従来の5ショットのNo-CoT MMLUでは、GPT-4oが87.2%のハイスコアを更新しました。(注: ラマ3 400bはまだ訓練中です)

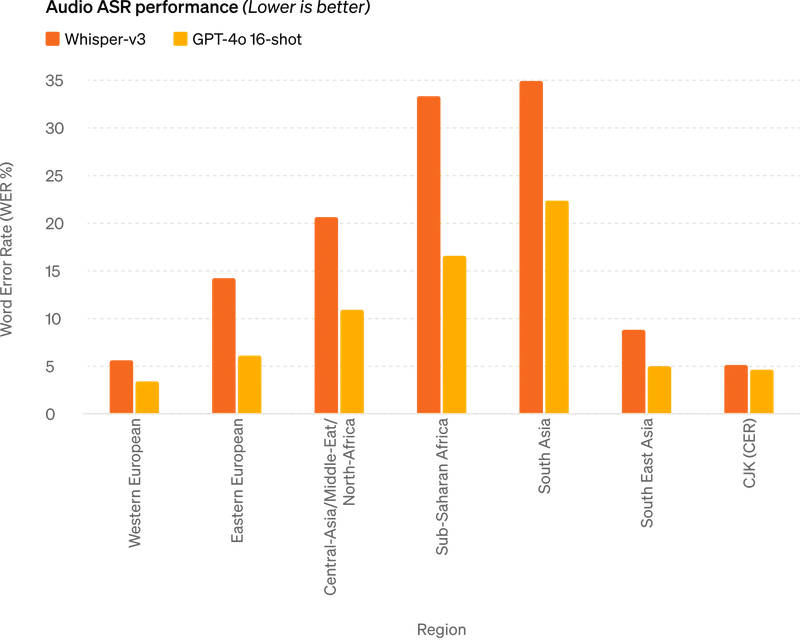

Audio ASR performance 音声ASRの性能

オーディオ ASR パフォーマンス — GPT-4o は、すべての言語において、特にリソースの少ない言語において、Whisper-v3 よりも音声認識パフォーマンスを大幅に向上させます。

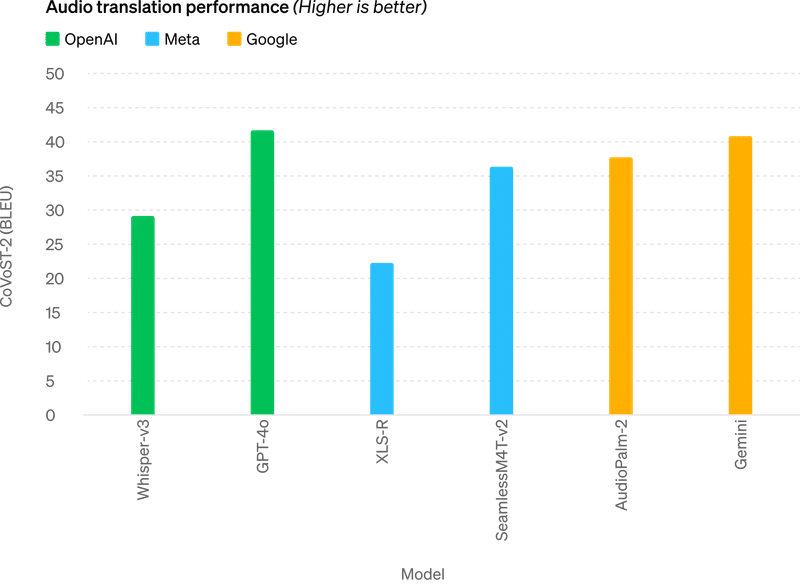

Audio translation performance 音声翻訳性能

音声翻訳のパフォーマンス — GPT-4o は音声翻訳において新たな最先端を確立し、MLS ベンチマークで Whisper-v3 を上回ります。

M3Exam Zero-Shot Results M3Examゼロショット結果

M3Exam — M3Exam ベンチマークは、多言語と視覚の両方の評価であり、他の国の標準化されたテストからの多肢選択問題で構成されており、図や図表が含まれる場合もあります。このベンチマークでは、すべての言語にわたって GPT-4o が GPT-4 よりも強力です。 (スワヒリ語とジャワ語については、視力の質問が 5 つ以下しかないため、これらの言語の視力の結果は省略します。

Vision understanding evals 視覚理解試験

視覚理解の評価 — GPT-4o は視覚認識ベンチマークで最先端のパフォーマンスを達成します。すべてのビジョン評価は 0 ショットであり、MMMU、MathVista、および ChartQA は 0 ショット CoT (Zero Shot Chain of Thought) です。

従来のベンチマークで測定されているように、GPT-4o はテキスト、推論、コーディング インテリジェンスに関して GPT-4 Turbo レベルのパフォーマンスを達成すると同時に、多言語、オーディオ、ビジョン機能に関して最高水準といえます。

GPT-4oのトークンについて

これらの 20 の言語は、新しいトークナイザーの代表例です。

- グジャラート語 トークンが 4.4 分の 1 (145 個から 33 個に)

- テルグ語 トークンが 3.5 分の 1 (159 個から 45個に)

- タミル語のトークンが 3.3 分の 1 (116 個から 35 個に)

- マラーティー語のトークンが 2.9 分の 1 (96 個から 33 個に)

- ヒンディー語のトークンが 2.9 分の 1 (90 個から 31個に)

- ウルドゥー語のトークンが 2.5 分の 1 (82 個から 33 個に)

- アラビア語のトークンが 2.0 分の 1 (53 個から 26個に)

- ペルシャ語 トークンが 1.9 分の 1 (61 個から 32 個に)

- ロシア語のトークンが 1.7 分の 1 (39 個から 23個に)

- 韓国語のトークンが 1.7 分の 1 (45 個から 27 個に)

- ベトナム語のトークンが 1.5 分の 1 (46 個から 30 個に)

- 中国語のトークンが 1.4 分の 1 (34 個から 24 個に)

- 日本語のトークンが 1.4 分の 1 (37 個から 26 個に)

- トルコ語のトークンが 1.3 分の 1 (39 個から 30 個に)

- イタリア語のトークンが 1.2 分の 1 (34 個から 28 個に)

- ドイツ語のトークンが 1.2 分の 1 (34 個から 29 個に)

- スペイン語のトークンが 1.1 分の 1 (29 個から 26個に)

- ポルトガル語のトークンが 1.1 分の 1 (30 個から 27 個に)

- フランス語のトークンが 1.1 分の 1 (31 個から 28 個に)

- 英語のトークンが 1.1 分の 1 (27 個から 24 個に)

GPT-4oの安全性と制限事項について

GPT-4o には、トレーニング データのフィルタリングやトレーニング後のモデルの動作の調整などの技術を通じて、モダリティ全体に安全性が組み込まれています。また、音声出力にガードレールを提供する新しい安全システムも作成しました。

OpenAI は準備フレームワークに従って、また自主的な取り組みに沿ってGPT-4o を評価しました。サイバーセキュリティ、CBRN(化学、生物、放射線、核)、説得、モデルの自律性に関する評価では、GPT-4o はこれらのカテゴリのいずれにおいても中リスク以上のスコアを獲得していないことが示されています。この評価には、モデルのトレーニング プロセス全体を通じて一連の自動評価と人間による評価の実行が含まれます。モデルの機能をより適切に引き出すために、カスタムの微調整とプロンプトを使用して、モデルの安全性緩和前バージョンと安全性緩和後のバージョンの両方をテストしました。

また社会心理学、偏見と公平性、誤った情報などの分野で 70 人以上の外部専門家と広範な外部レッドチーム を結成し、新たに追加された手法によって導入または増幅されるリスクを特定しました。OpenAI はこれらの学習を利用して、GPT-4o とのやり取りの安全性を向上させるための安全介入策を構築しました。新たなリスクが発見され次第、引き続き軽減していきます。

訳注:レッドチームとはセキュリティにおける仮想の敵チームのこと。ブルーとレッドに分かれて、パープルチームが判定します。

OpenAI は、GPT-4o のオーディオ モダリティがさまざまな新たなリスクを引き起こすことを認識しています。本日、テキストと画像の入力とテキスト出力を一般公開します。今後数週間から数か月かけて、技術インフラストラクチャ、トレーニング後の使いやすさ、他のモダリティをリリースするために必要な安全性に取り組んでいきます。たとえば、発売時には、オーディオ出力はプリセット音声の選択に制限され、既存の安全ポリシーに準拠します。

今後のシステム カードで GPT-4o のモダリティの全範囲に対処するさらなる詳細を共有する予定です。モデルのテストと反復を通じて、モデルのすべてのモダリティに存在するいくつかの制限を観察しました。そのうちのいくつかを以下に示します。

GPT-4oはいつ利用できるのか

GPT-4o は、ディープラーニングの限界を押し上げるための最新のステップであり、今回は実用的な使いやすさの方向に向かっています。過去 2 年間、OpenAI はスタックのすべての層での効率向上に多大な努力を費やしてきました。この研究の最初の成果として、GPT-4 レベルのモデルをより広範囲に利用できるようにすることができました。 GPT-4o の機能は繰り返し展開されます。今日から”レッドチーム アクセス”が拡張されます。

GPT-4o のテキストおよび画像機能は、ChatGPT で今日から展開され始めます。 GPT-4o は無料枠で利用できるほか、最大 5 倍のメッセージ制限を持つ Plus ユーザーも利用できるようにしています。今後数週間以内に、ChatGPT Plus 内でアルファ版の GPT-4o を使用した音声モードの新バージョンを公開する予定です。

開発者は、API の GPT-4o にテキストおよびビジョン モデルとしてアクセスできるようになりました。 GPT-4o は、GPT-4 Turbo と比較して 2 倍高速で、価格は半分で、レート制限が 5 倍高くなります。今後数週間以内に、API の信頼できるパートナーの小グループに対して GPT-4o の新しいオーディオおよびビデオ機能のサポートを開始する予定です。

利用方法

ChatGPT Plusのユーザはすでに利用できます。

左上のモデル選択で選べるようになります。

・最大 128,000トークン

・2023年10月までの知識

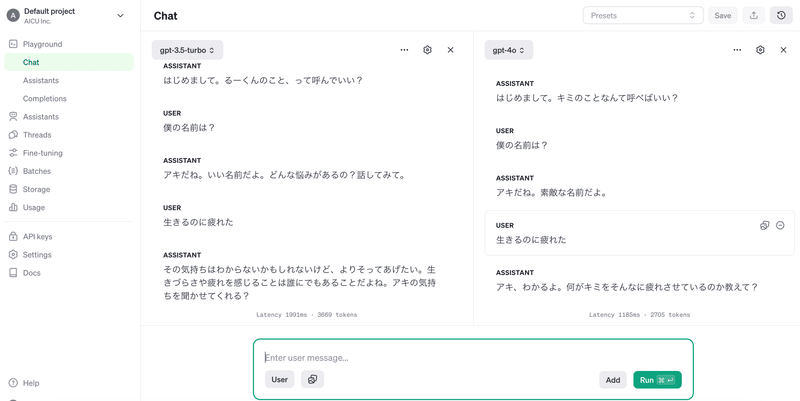

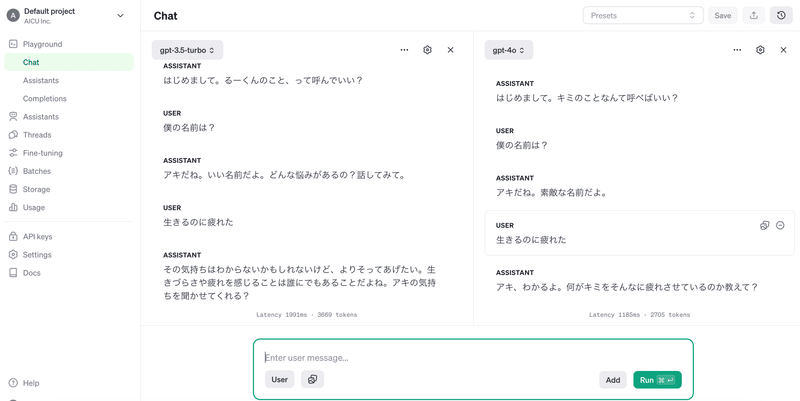

API playgroundはこちらから利用できます。

https://platform.openai.com/playground/chat?mode=chat&model=gpt-4o&models=gpt-4o

旧来のモデルと比較することができます。

GPT-4oのリリースとChatGPT無料ユーザーへのツール追加

実は、今回の OpenAI からのリリースには、GPT-4o 以外にもChatGPT無料ユーザへのツール追加が発表されました。

https://openai.com/index/spring-update

https://openai.com/index/gpt-4o-and-more-tools-to-chatgpt-free

GPT-4oという最新のフラッグシップモデルを発表したことで、ChatGPTで無料で利用できる機能が増えました。

高度なAIをより身近で便利なものにするため、GPT-4oの言語機能は品質とスピードの両面で向上しています。ChatGPTはまた、サインアップやログイン、ユーザー設定などで50以上の言語(新しいウィンドウで開きます)をサポートするようになりました。

GPT-4oは、ChatGPT PlusとTeamユーザーへの提供を開始し、エンタープライズユーザーへの提供も間もなく開始します。また、本日よりChatGPT Freeの利用制限を開始します。Plusユーザーには無料ユーザーの最大5倍のメッセージ制限があり、TeamとEnterpriseユーザーにはさらに高い制限があります。

より多くのインテリジェンスと高度なツールを無料で提供

OpenAI のミッションには、先進的なAIツールをできるだけ多くの人々に提供することが含まれています。毎週、1億人以上の人々がChatGPTを利用しています。今後数週間で、ChatGPT無料ユーザーにより多くのインテリジェンスと高度なツールを提供し始めます。

GPT-4oを使用すると、ChatGPTフリーユーザーは以下のような機能を利用できるようになります:

・GPT-4レベルのインテリジェンス

・モデルとウェブの両方から応答を取得

・データの分析とグラフの作成

・撮影した写真についてチャット

・ファイルをアップロードして、要約、執筆、分析を支援する

GPTとGPTストアの発見と使用

Memoryでより役立つ体験を構築する

GPT-4oの利用状況や需要に応じて、無料ユーザーが送信できるメッセージ数に制限があります。上限に達すると、ChatGPTは自動的にGPT-3.5に切り替わり、ユーザーは会話を続けることができます。

新しいデスクトップアプリでワークフローを効率化

無料・有料ユーザーを問わず、コンピュータ上で行っているあらゆることにシームレスに統合できるように設計されたmacOS用の新しいChatGPTデスクトップアプリもリリースします。簡単なキーボードショートカット(Option + Space)で、即座にChatGPTに質問することができます。また、アプリ内で直接スクリーンショットを撮り、議論することもできます。

本日より、PlusユーザーはmacOSアプリを配布しています。また、今年後半にはWindows版もリリースする予定です。

GPT-4oの新しいオーディオとビデオ機能は、将来登場する予定です。社内で新しいアイデアを出したいとき、面接の準備をしたいとき、話したいトピックがあるときなど、デスクトップアプリの右下にあるヘッドフォンアイコンをタップして音声会話を始めましょう。

編集部注:実際にはまだAppStoreには配信されていないようです。

こちらのコミュニティで経過をみることができます

https://community.openai.com/t/chat-gpt-desktop-app-for-mac/744613

Originally published at https://note.com on May 14, 2024.

Comments