2024年12月3〜6日に東京国際フォーラムで開催されたSIGGRAPH Asia 2024 Tokyo。コンピュータ・グラフィックス(CG)に関わるあらゆる最新の研究発表や制作事例など盛りだくさんな内容でした。

中でもカンファレンスのラストを飾るReal-Time Live! は、最先端のリアルタイム技術を駆使してステージ上でライブパフォーマンスをするとてもユニークなプレゼンテーションです。制限時間は6分間なのですが、なにしろ生ですからプレゼンターには物凄いプレッシャーがかかりますし、突発的なトラブルが発生することもあるので見ているオーディエンスも上手くいくのかハラハラドキドキしながら見守ることになります。SIGGRAPH Asiaの本質は学会なのですが、こういった遊び心があるセッションもあるのです。

オープニングからびっくり!

"シェボちゃん"登場

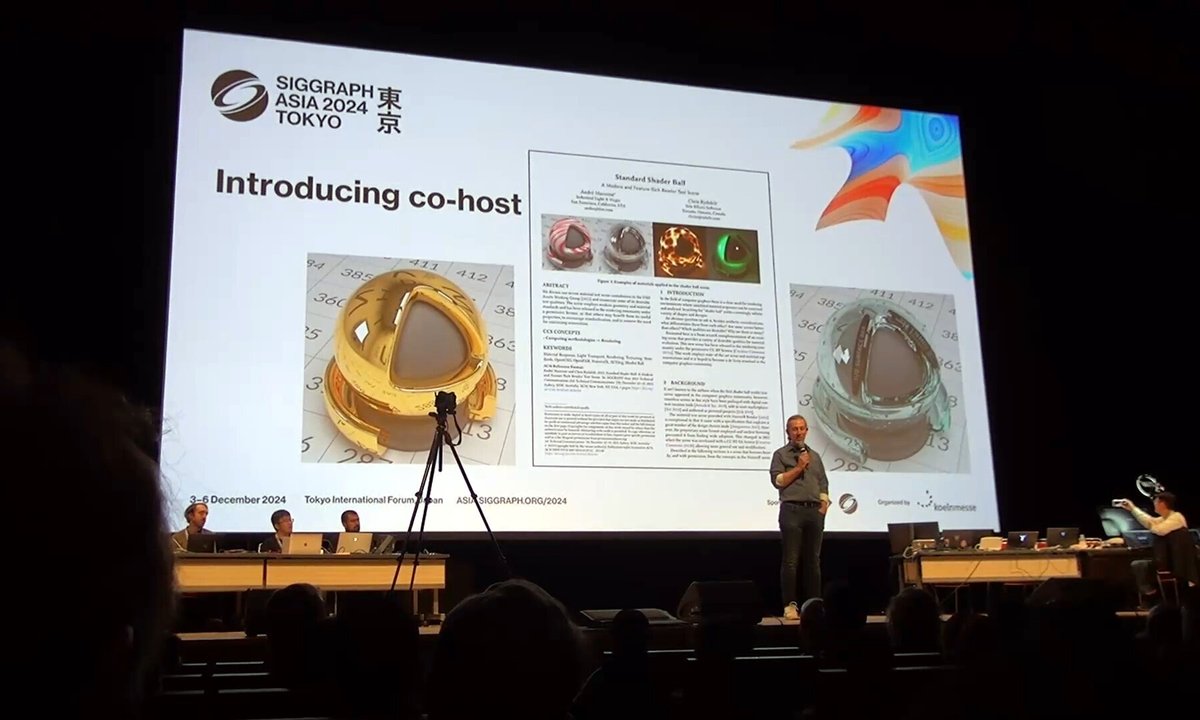

まず、オープニングに登場したのは Industrial Light & Magic (ILM) のAndré Mazzoneさん(中央右)。昨年のSIGGRAPH Asia 2023 SydneyにおいてHoudiniを開発する SideFX のChris Rydalchと共同で背後のスクリーンに映し出されている”Standard Shader Ball A Modern and Feature-Rich Render Test Scene”という論文を発表したんだそうです。簡単に説明すると、3DCGにおいて色や光沢を決める際にその質感が把握し易くなる様な基準となるサンプルと環境の提案、といったところでしょうか。MazzoneさんはこのStandard Shader Ballがどれだけ普及していくのか楽しみにしていたそうなのですが、東京に来て驚いたそうです。

その原因が今回の Real-Time Live! のアシスタントに任命された金色に輝くシェボちゃん(右端)!コンピュータの中の存在だった無機質なStandard Shader Ballが現実世界に飛び出してきて動き回ったりお喋りしたりするので、Mazzoneさんは「日本人らしい発想だなあ」と一本取られた感じになったみたいです。ちなみに口癖は「シェボボボボボ〜!」。このあまりに唐突な展開にオーディエンスもちょっと戸惑い気味です。

<セッションチェアである手島孝仁さん (ポリフォニー・デジタル株式会社)

最後にはみんなに愛されていました>

なんか来た🤣ずーっとフワフワした動きしてます!中の人がんばれ!!!#SIGGRAPHAsia2024 pic.twitter.com/IHgewlJXdP

— 山本ゆうか (@ymmox) December 6, 2024

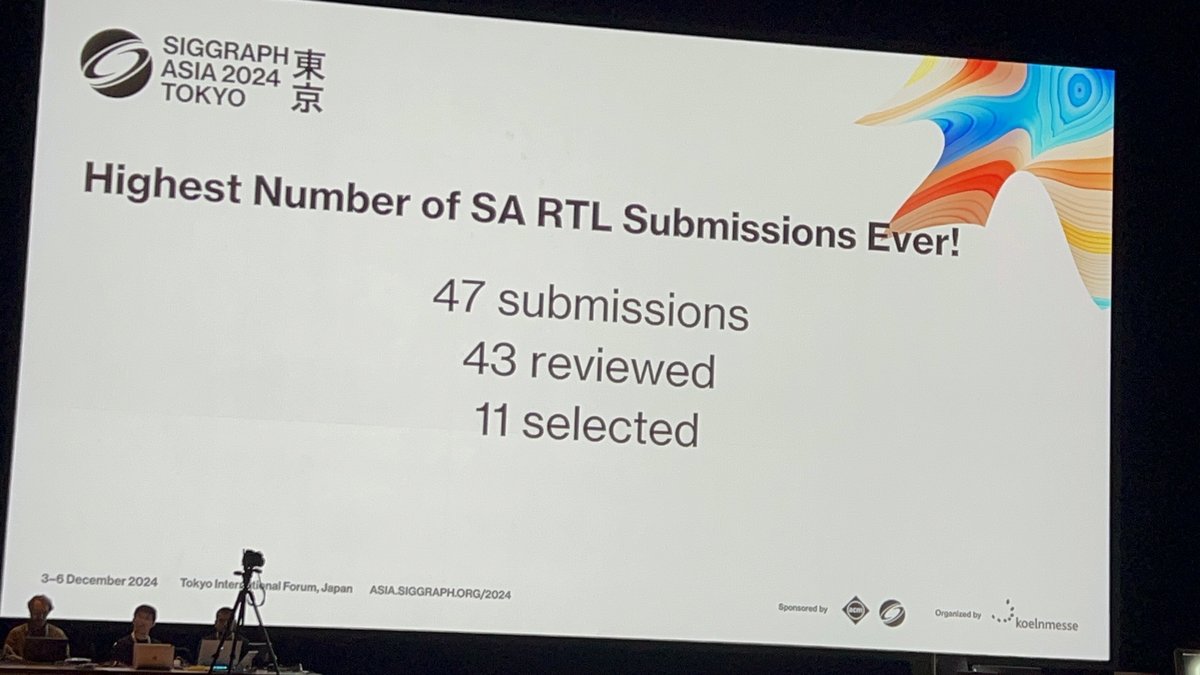

<47投稿11選出、という高難度なセッションでもあります>

どよめきと興奮がうずめく会場にむけ、今回の審査員賞(Jury’s Choice)と最優秀賞(Best of Show)について説明がありました。審査員賞はその名の通り審査員が選ぶ賞で、最優秀賞は会場のオーディエンスがスクリーンのQRコードをスマホなどで読み取って専用ページから直接投票する形式です。単に技術的な部分だけでは決まらずプレゼンテーションの出来も加味されるので、いかに観客を沸かせるかが勝敗の分かれ目になります。果たして、全11プレゼンターションの中でSIGGRAPH Asia 2024のテーマである”Curious Minds”に最も相応しいパフォーマンスを見せてくれるのはどのチームになるのでしょうか?なお、最優秀賞を受賞したチームにはStandard Shader Ballをかたどった優勝トロフィーが授与されます。ホントに今回のReal-Time Live!のStandard Shader Ball推しは徹底してますね。

多彩なテーマの革新的なデモが勢揃い!

前振りが長くなりましたが、それでは今回の11のプレゼンテーションについて解説していきたいと思います。

まずは、公式トレーラーからどうぞ。

https://www.youtube.com/watch?v=V2GWDSqFAAM

今年のReal-Time Live!では、インタラクティブな音楽プレイグラウンドから最先端医療画像、生成AI、高速ロボットデザインまで、幅広い分野の革新的な技術が採択されました。

-

Beam: Interactive Music Effects Playground: インタラクティブな音楽エフェクト・プレイグラウンド

-

Authentic Self XR: A live dancer interacting with 3D volumetric captures in XR: ライブダンサーとXRにおける3Dボリュメトリックキャプチャのインタラクション

-

Digital Salon: An AI and Physics-Driven Tool for 3D Hair Grooming and Simulation: AIと物理学に基づく3Dヘアグルーミングおよびシミュレーションツール

-

Viewtify: Next-Generation Medical Image Viewer with Stereoscopic Display: 次世代医療画像ビューア(立体視ディスプレイ対応)

-

RobotSketch: A Real-Time Live Showcase of Superfast Design of Legged Robots: 脚式ロボットの超高速設計のリアルタイム・ライブショーケース

-

Real-Time Virtual Try-On Using Generative AI: 生成AIを用いたリアルタイムバーチャルトライオン

-

What’s New in Pixar’s Presto: ML Posing, Invertible Rigs, and Interactive Motion Blur: ピクサーのPrestoの新機能:MLポージング、反転可能リグ、インタラクティブモーションブラー

-

Online Chat with Living Neuronal Cultures: 生きた神経細胞培養とのオンラインチャット

-

Tripo Doodle: The Next-Gen AI 3D Creative Tool: 次世代AI 3Dクリエイティブツール

-

Debate Generation System in Japanese Rap Battle Format: 日本語ラップバトル形式のディベート生成システム

-

Prototyping Game Character Animations with AI in Unity: UnityでのAIを用いたゲームキャラクターアニメーションのプロトタイピング

そして、時間に余裕のある方は、公開されたばかりの公式アーカイブ(1時間37分21秒)の方も再生しながら読んでいただけると現場の興奮が共有できると思います。10万円以上のチケットクラスでないとアクセスできない価値あるライブステージです!

https://www.youtube.com/watch?v=PsbuACCnQFI

Beam: Interactive Music Effects Playground

(インタラクティブな音楽エフェクト・プレイグラウンド)

米国のロサンゼルスに拠点を置く音楽ソフトウェア会社の Lunacy Inc が開発したデスクトップオーディオワークステーション用のリアルタイム オーディオ エフェクト プラグインである BEAM のプレゼンテーション。その特徴は幻想的で美しいデザインのUIにあります。プレゼンターのピクサー・アニメーション・スタジオでリードテクニカルディレクターも兼務している3DCGの開発者兼デザイナーのBrandon Montellさんとプリンストン大学で音楽とコンピューター サイエンスを学んだ後にバークリー音楽大学で映画作曲の修士号を取得したCasey Kolbさんは、視覚的に魅力的でより音とのつながりが強く感じられるUIを目指してBEAMを開発したそうです。簡単に操作の仕方を説明すると、録音された音は左から右に流れるStreamで表され、そこにSpace(リバーブ)、Grain(グラニュラ)、Filter(フィルター)、Time(タイム)などのエフェクトノードをを配置して音を加工していきます。またStreamは分岐させることも可能なのでエフェクトを並列にかけることもできます。今までは複雑に入り組んだルーティングや各エフェクトの状態を把握するのはとても大変だったのですが、BEAMはそれを視覚的に容易にしているという点で画期的です。プレゼンテーションも流れる様な操作でリアルタイムに音が変化していくサウンドメイキングがとても印象的でした。

Authentic Self XR: A live dancer interacting with 3D volumetric captures in XR

(ライブダンサーとXRにおける3Dボリュメトリックキャプチャのインタラクション)

オーストラリアのニューサウスウェールズ大学の 3DXLab によるこのパフォーマンスは、予めボリュメトリックビデオとして収録済みの自分自身の複数のパフォーマンスとステージ上で共演するというエクステンデッド・リアリティ(XR)のコンテンツです。ステージ上のダンサーはXRヘッドセットを通して自分の周りで繰り広げられる過去の自分のパフォーマンスを見ることができ、それらに対峙しながら即興でパフォーマンスを作り上げて行きます。これはある意味、真の自分というものを探求する作業に他なりません。そして、ダンサーは過去の自分を一人一人消し去って最終的に自分自身を確立します。オーディエンスはステージ上のダンサーとスクリーンに映し出されている拡張現実の世界にいるダンサーの両方を同時に見ることによってパフォーマンスの真の意味を知ることが出来るのです。以上がアート面ですが、テクニカル面では、かなりダイナミックに動いているのにも関わらず、トラッキング用のマーカー無しでエフェクトの追従や過去の自分とコンタクトに大きなズレが生じていないことに驚きました。ステージを見る限り、カメラはスクリーン用の1台しか見当たらなかったので、もしこのカメラの映像のみでリアルタイムトラッキングをしているのなら結構凄いです。余談ですが、カメラとケーブルの接触に問題があったのか、パフォーマンス中ずっとスタッフの方が端子がまっすぐに刺さる様に手でケーブルを保持し続けるという涙ぐましい努力をされていました。ノートラブルで終えられたのはこの方のおかげですね。

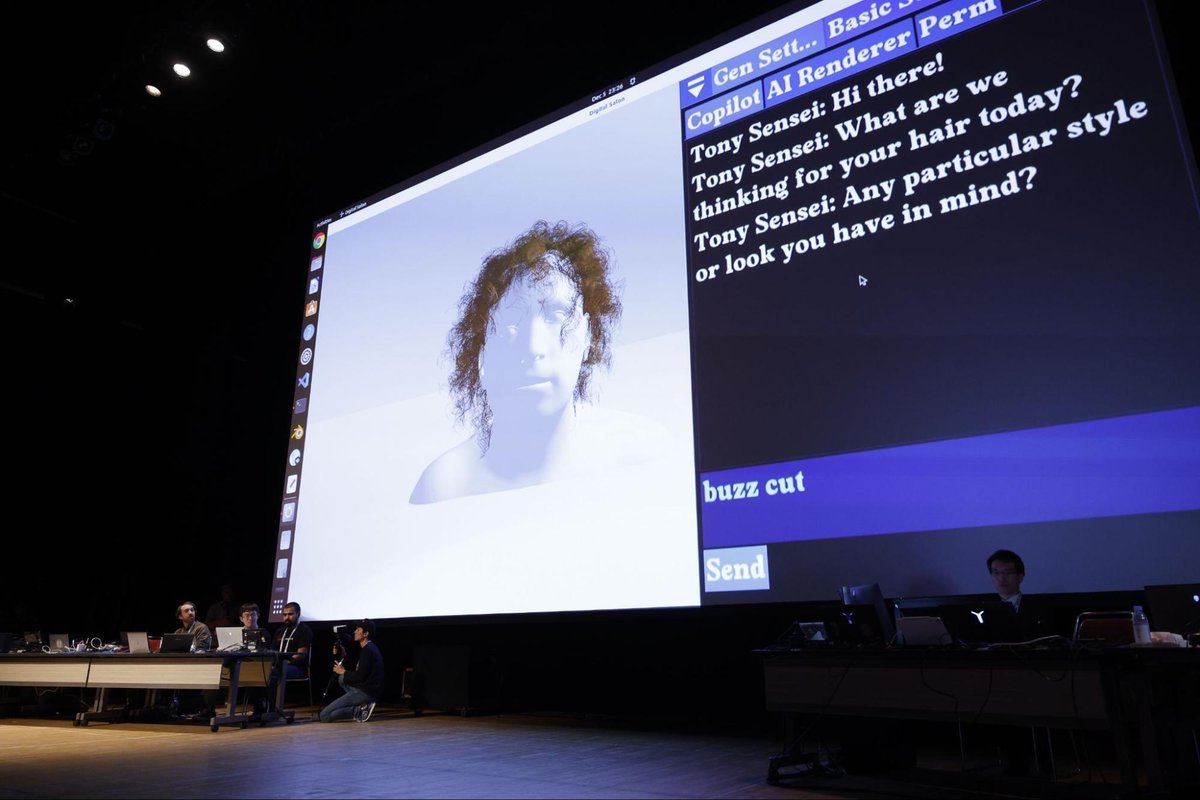

Digital Salon: An AI and Physics-Driven Tool for 3D Hair Grooming and Simulation

(AIと物理学に基づく3Dヘアグルーミングおよびシミュレーションツール)

Digital Salon は、AIと物理ベースのアルゴリズムを使用して、髪の毛のモデリング、アニメーション、レンダリングの各作業を簡素化した3Dヘアグルーミングとシミュレーションのための革新的なツールで、クリエイティブ・デザイン・ツールのアドビと多くの大学・研究機関(イェール大学、 アブドラ国王科学技術大学(KAUST)、 マックスプランク知能システム研究所、 スイス連邦工科大学チューリッヒ校(ETH)、 キール大学、 南京理工大学)の研究者によって開発されました。プレゼンレーションはイェール大学のChengan Heさんとアブドラ国王科学技術大学のJorge Alejandro Amador Herreraさんのコントの様な掛け合いで進みます。 坊主頭のAmadorさんは、「髪を切ったんだけど新年に向けて次のヘアスタイルの準備がしたいんだ。」とHeさんに相談すると「良いものがあるよ!」とDigital Salonを試してみることを勧めます。このツールは、テキストベースのヘア生成、インタラクティブな編集、高品質のAIレンダリングが統合されていて、それぞれをシームレスに組み合わせることが出来ることに加え、最大80,000本の毛束のリアルタイムアニメーションが可能となっています。 まずは、Digital Salonの中のTony先生にオーダーして現在のAmadorさんの髪型を再現し、さらにHeさんが髭を描き足すところから始めたのですが、Amadorさんは「クレージーなことに挑戦したい!ツインテール(Double Tails)はどうかな?」と言い出しました。Heさんによると、これは台本になかったAmadorさんのアドリブだったそうですが、慌てることなく”Double Tails”と入力してTony先生にお願いするとあっという間にツインテールが完成しました。もちろん、頭のモデルを動かすとそれに合わせてツインテールも揺れます。その後もAmadorさんが注文を付けてはHeさんがTony先生にお願いするのを繰り返し、最終的にロングヘアが気に入ったAmadorさんは「これのハイクオリティな画像も見たいなあ。」と言ってきました。それに対してHeさんは性別やアングルなどのレンダリング設定をテキストでDigital Salonに入力してリアルな画像が出力されるのを待ちます。そしてスクリーンにリアルなレンダリング結果が表示されると突然Heさんが「現実になったよ!新年にピッタリだね!」と言いました。何ごと?と思っていたらサブモニターには長髪になったAmadorさんのアップが!坊主頭だったのはこの落ちを強調するためものだった様で、Amadorさん、カツラまで用意するなんて本当にこのプレゼンテーションに賭けてたんですね。さて、一連の流れを見てお分かりの様にDigital Salonは数値の入力やパラメータの調整などは一切する必要はなく、実際のヘアサロンで美容師さんとやり取りするのと同じ様に言葉だけで髪型を作ることが出来ます。3DCGにおいて髪の表現は処理負荷が高いものの一つで、中々思う様に動いてくれず調整に時間がかかるものでしたが、このツールによって敷居がグッと下がって誰でも思い通りの髪型が作れる未来が見えました。

Viewtify: Next-Generation Medical Image Viewer with Stereoscopic Display

(立体視ディスプレイ対応 次世代医療画像ビューア)

日本のサイアメント社が開発した Viewtify®という、医療用のビューアーのデモンストレーションです。発表者の瀬尾拡史(せお ひろふみ)さんは、かつてデジタルハリウッドでCGを学ばれ、東大で医学を学び、ロサンゼルスで開催された SIGGRAPH2015 Computer Animation Festival で「BEST VISUALIZATION AND SIMULATION」を獲得した経験がある伝説の日本人CG研究者です。Viewtifyは4D-CT画像や 4D-MRI画像から動いている臓器の3DCGアニメーションをリアルタイムに表示することに加え、3Dディスプレイに接続すればそれを立体視することが可能です。システムとしては、ゲームエンジンである Unreal Engine でリアルタイムレンダリングを行い、メッシュ生成は CUDA で独自開発したものを使用していて、両者のGPU リソースを共有することでCUDAで合成した3DデータをUnreal Engineで直接読み込むことで高速な描画を実現しています。実際のオペレーションは、データの入っているフォルダを選択するだけで3DCGが生成され、様々な角度でその断面を見ることが出来ます。注目すべきは断面の画像データはモノトーンなのに3DCGでは骨や内臓などの各組織がカラフルに色分けされていることです。これはピクセル単位で周囲のデータとの値を比較するアルゴリズムを使用してそのピクセルが何の組織であるか判定してそれをメッシュに反映させることで実現しているとのことでした。また、メジャーツールやプリントモードなどのサポート機能も備えています。このとても有用なViewtify®は、既に日本の40くらいの病院に導入されていて、2023年は1本、2024年は8本の症例報告のレポートがあがっているとのことです。プレゼンターの瀬尾拡史さんは、「医者として、また、ソフトウェアエンジニアとして、リアルタイム3DCGを使用して医療の改善と発展に貢献したいです。」という言葉でプレゼンテーションを締めました。本当に素晴らしい取り組みだと思います。

https://www.sciement.com/jp/works/prerender/UTHeart.html

RobotSketch: A Real-Time Live Showcase of Superfast Design of Legged Robots

(ロボットスケッチ:脚式ロボットの超高速設計)

バーチャル空間でロボットを設計できる RobotSketch のプレゼンテーションを行ったのは韓国科学技術院(KAIST)のSketchLabチームでプレゼンターはDRB-KAIST SketchTheFuture 研究センターのJoon Hyub Lee教授です。まず、デザイナーはVRヘッドセットを装着した上で液晶タブレットにドローイングすることでロボットをデザインしていきます。この時点でとてもユニークですよね。恐らくデザイナーの視界ではタブレットが浮いていて大スクリーンに映し出されている様なバーチャル空間が広がっているはずです。今までは3D空間に直接ドローイングしていく手法をよく見かけましたが、これはトラディショナルな手法の拡張と言うべきものです。また、この手法の利点として、タブレットにコンタクトしていることにより腕が疲れにくい、実物大のスケールでデザインできる、そして、VRヘッドセットが無くてもデザインできる、の3点があるとのことです。そうこうしているうちに4脚のスパイダー型ロボットのデザインが出来上がりました。次はパーツの切り分けとリギングになるのですが、一般的な3DCGソフトの様なボーンを介したリギングではなく、タブレット上から直接各パーツに設定出来る様になっています。そして、驚いたのがこのロボットを動かした時で、ちゃんとバランスを取りながら違和感の無い動作を見せます。これはロボット工学の研究者に協力を受けて実現した物理シミュレーションと強化学習のハイブリッドメソッドによるものだそうで、4脚に限らず、ロボットのデザインに合わせた歩行パターンが生成できるとのことでした。これを証明するためにパーツの形状とつながりはそのままで2足歩行タイプにシルエットを変えて動作テストを行ったところ、ちゃんと2足で歩きだしました。これは、搭載されているAIがロボットの形状を認識して自動的に各部の動きを作り出していることに他なりません。Lee教授は近い将来にロボット版のカンブリア爆発が起こると想像しているそうで、ロボットデザインするためのツールが必ず必要になると考えてRobotSketchを開発したとのことでした。

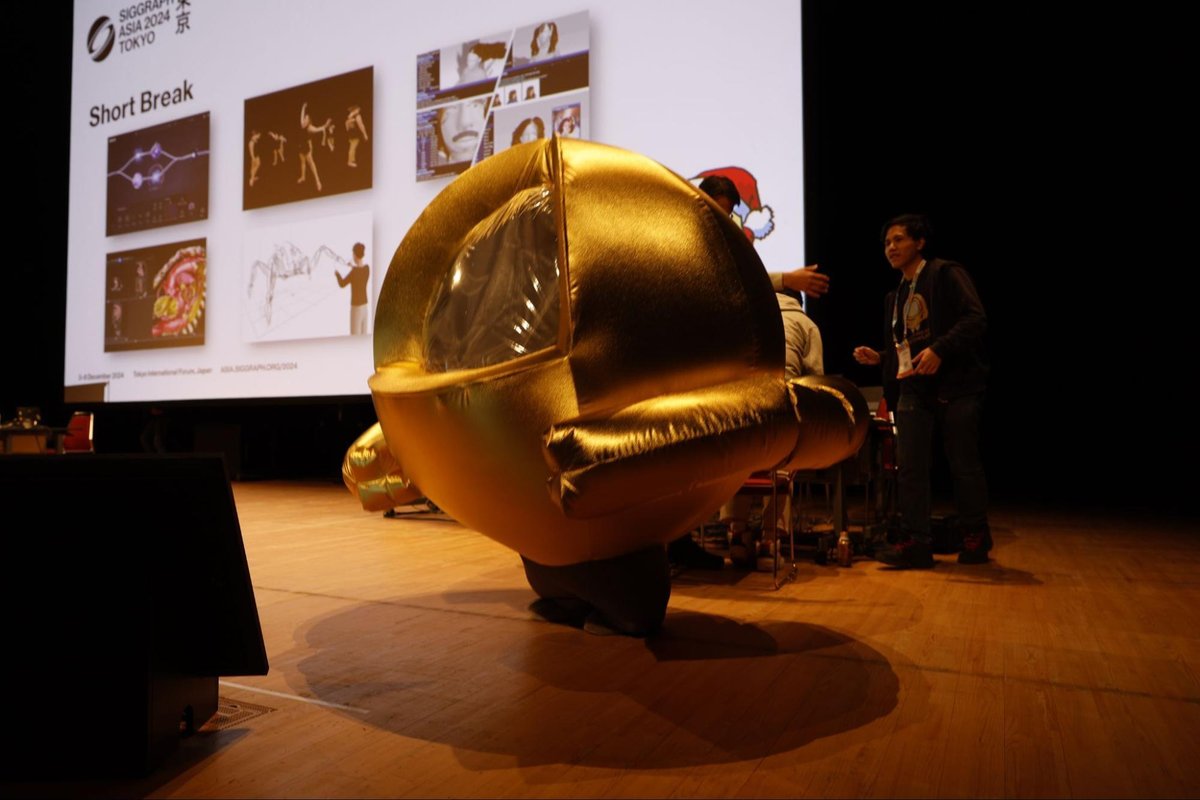

ここで小休止。

後半のプレゼンテーションの準備が行われます。そして、シェボちゃんが再び登場!司会を務めるReal-Time Live!のチェアマンに前半の感想を求められると、どれにもShader Ballに絡めて答えて、最後は「シェボボボボボ〜!」で締めてきます。ホントに徹底していますね。そうこうしているうちに準備が整った様で、後半がスタートします。

詳細レポートはメンバーシップ先行公開!

次号の AICU Magazine Vol.8 にて収録予定です。

https://corp.aicu.ai/ja/tag/aicu-magazine

この記事の続きはこちらから https://aicu.jp/n/n102e84c071b0

Originally published at https://aicu.jp on Jan 6, 2025.

Comments