ComfyUIで無料で使える動画生成モデル「Wan2.2」。AICUが中国経由で入手した「プロンプト秘伝の書」のような公式ファイル、そのあまりの分量の多さに、全数回に分けて詳細をお届けしています。

第1回の「スタイル(Style)」、第2回の「モーション&感情(Motion & Emotion)」に続き、第3回となる今回は、生成される動画のクオリティとストーリー性を劇的に向上させる「カメラ動作(Camera Movement)」について解説します。

Wan2.2を極めるプロンプト集(1)スタイル

https://www.aicu.jp/post/wan2-20250804

Wan2.2を極めるプロンプト集(2)モーション&感情

https://www.aicu.jp/post/wan-20251108

どんなに美しいスタイルやキャラクターでも、カメラワークが単調では映像の魅力は半減してしまいます。Wan2.2が理解するカメラ指示をマスターして、映画のような演出を目指しましょう。

最新のComfyUIの基本テンプレートから学ぶ

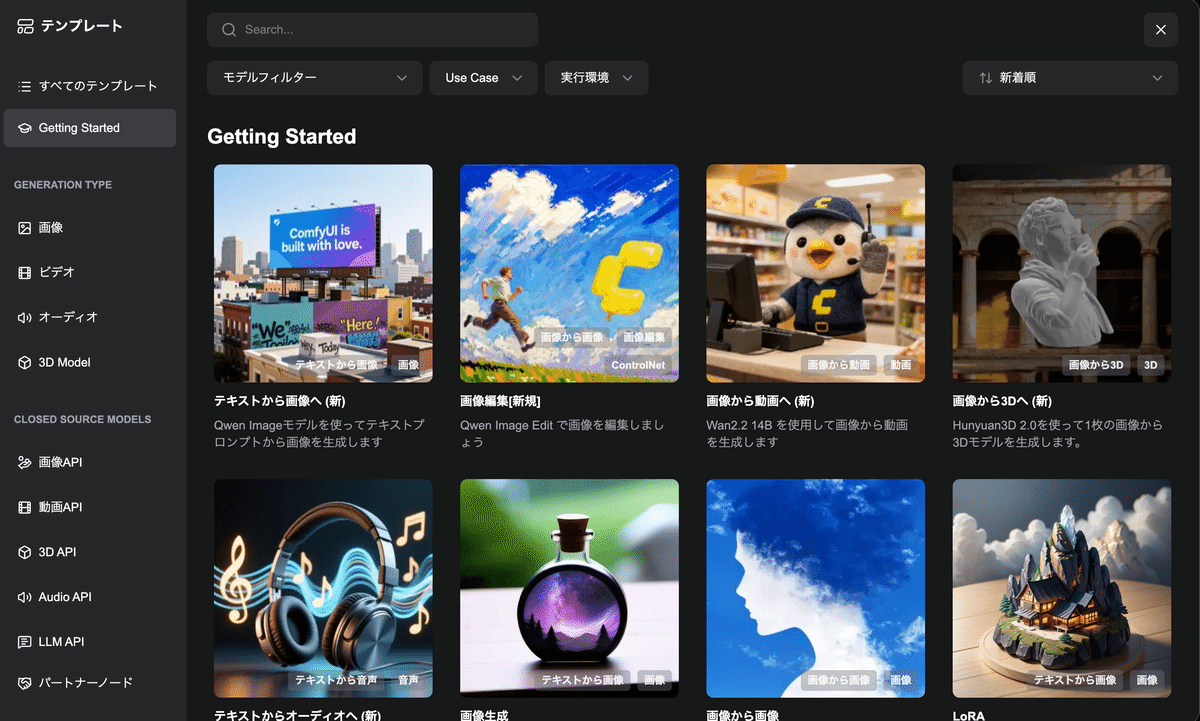

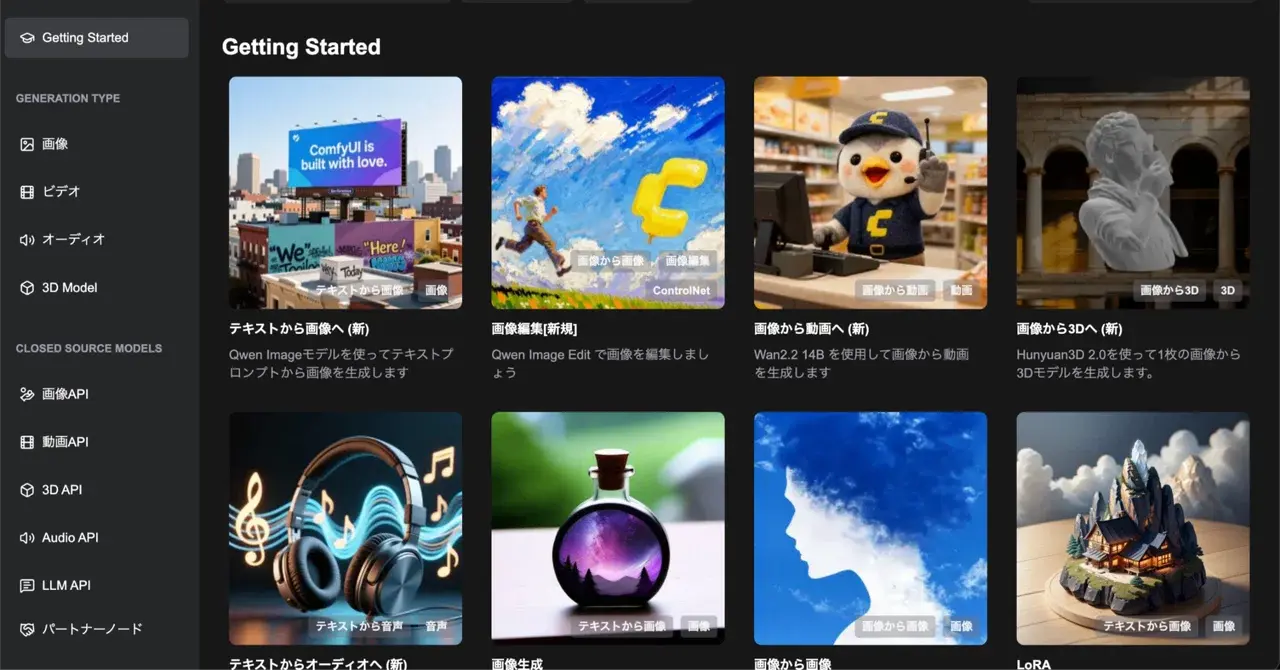

今回の解説は最新のComfyUI (0.3.76)、テンプレートの「Getting Started」にある「画像から動画へ(新)」を使用します。

ComfyUI紫本からの更新として、動画生成関係は大きくアップデートされています。

https://j.aicu.ai/comfysb

Wan2.2 ビデオ生成 ComfyUI 公式ネイティブワークフロー

Wan 2.2 は、WAN AI が発表した新世代のマルチモーダル生成モデルです。このモデルは、高ノイズと低ノイズのエキスパートモデルで構成される革新的な MoE (Mixture of Experts) アーキテクチャを採用しています。ノイズ除去のタイムステップに応じてエキスパートモデルを分割することで、より高品質なビデオコンテンツを生成できます。

Wan 2.2には、3つのコア機能があります。映画レベルの美的制御は、プロの映画業界の美的基準を深く統合し、照明、色、構図などの多次元的な視覚制御をサポートします。大規模で複雑なモーションは、様々な複雑なモーションを容易に復元し、モーションの滑らかさと制御性を向上させます。正確なセマンティックコンプライアンスは、複雑なシーンや複数オブジェクトの生成に優れており、ユーザーの創造的意図をよりよく復元します。

このモデルは、テキストからビデオへの変換や画像からビデオへの変換など、複数の生成モードをサポートしており、コンテンツ作成、芸術的創作、教育・トレーニングなどのさまざまなアプリケーションシナリオに適しています。

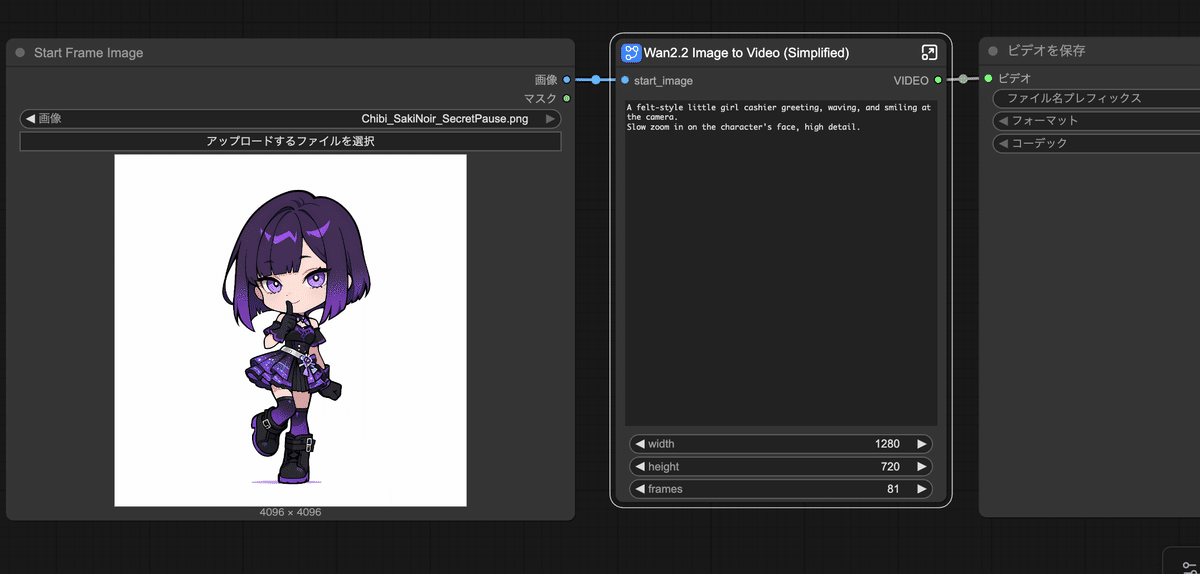

このチュートリアルではGoogle Colabを使用した Wan2.2の環境とカメラワークについて学びます。またWan2.2 Image to Video(Subgraph) ノードは、Wan2.2 イメージからビデオへのワークフローから変換された「サブグラフ」について学ぶことができます。

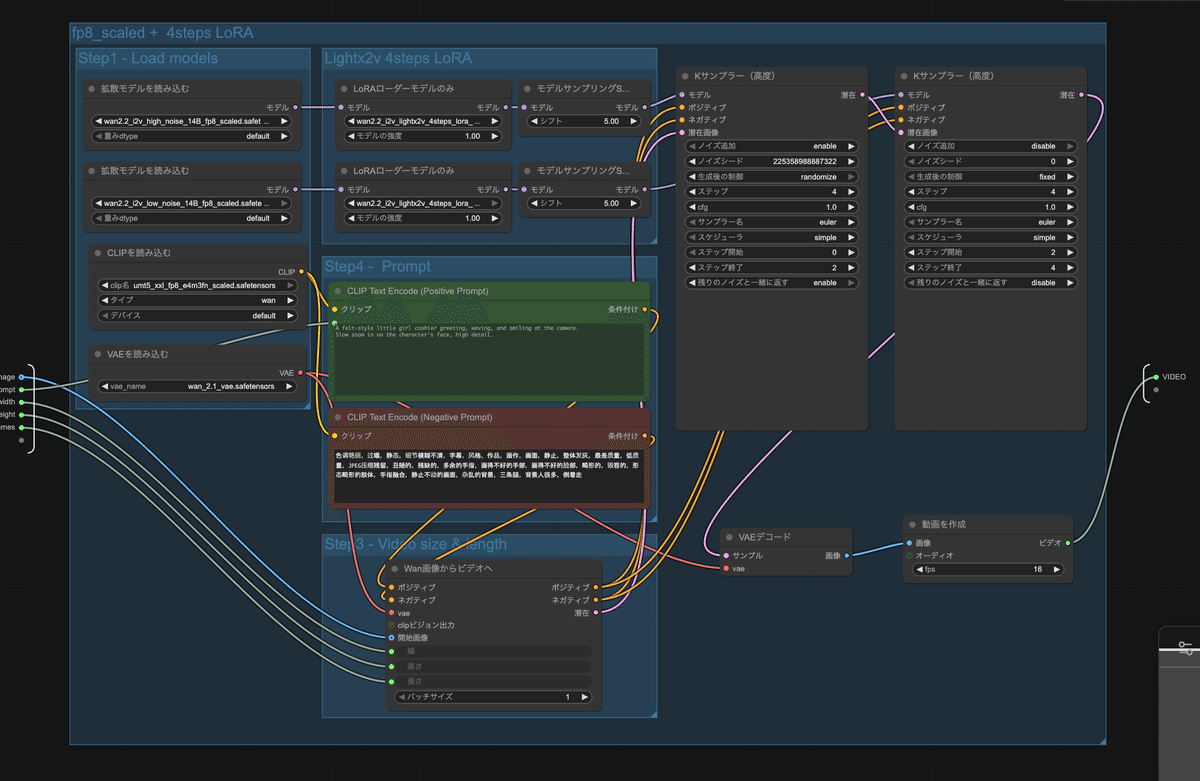

サブグラフを使うと、こんな巨大なワークフローが

こんなサイズで表現できます。

またWan2.2関係のワークフローは大容量の VRAM(20GB 以上)を必要とします。このワークフローをローカルで実行する場合は、十分な VRAM があることを確認してください。AICUではいくつかのソリューションを提供しています。

[おしらせ] AICU Lab+では、こうした生成AIの最新情報や検証結果を継続的に発信しています。また、基礎から学びたい方向けの書籍『画像・動画生成AI ComfyUI マスターガイド』公式勉強会や ComfyJapan勉強会 も展開しています。

---

この記事の続きはこちらから https://www.aicu.jp/post/wan-20251206

Originally published at note.com/aicu on Dec 6, 2025.

Comments