NVIDIAがCOMPUTEXで発表したNVIDIA「DGX Spark」と「DGX Station」(旧称「Project DIGITS」)は2025年5月19日にAcer、GIGABYTE、MSI、NTTPCなどのディストリビューターから7月出荷予定としてリリースされました。

AICUではDGX Sparkをはじめとするパソコン、ならぬ「パーソナルAIスーパーコンピューター」、「パソコン/PC」ならぬ"PAI(S)C"はAI開発やクリエイティブAIのあり方を根本から変える可能性を秘めた"新ハードウェア"であるとして調査研究を行っています。

Project DIGITS改め「DGX」とは何か

Project DIGITS改め「DGX」はデスクトップ型AIスーパーコンピュータとして、業界に大きな衝撃を与えるプロダクトとして開発されました。特にDGX Sparkは、「世界最小のAIスーパーコンピュータ」と謳われ、その驚くほどコンパクトな筐体はMac Miniサイズ、最新のNVIDIA Grace Blackwellプラットフォームの強力な演算能力を凝縮した「GB10 Superchip」を搭載しています。

AI技術が急速に進化し、私たちの生活や仕事のあらゆる側面に浸透しつつある現代において、このような革新的なハードウェアの登場は、開発者や研究者、そしてクリエイターにとって大きな関心事です。しかし、新しい技術に対する期待が高まる一方で、その実力や真の価値を見極めることは容易ではありません。このブログでは、NVIDIAから提供されたデータシート情報を基に、このDGX Sparkが一体どのような製品であり、どのようなユーザーのために設計され、特に画像生成AIの愛好家やクリエイターにとってどのような意味を持つのかを、過度な期待を煽ることなく、AICUとしては、Appleや他のプレイヤーと比較しつつ冷静かつ客観的に分析していきます。

「パーソナルAIスーパーコンピュータ」という新カテゴリー

NVIDIAの創業者兼CEOであるジェンスン・フアン氏は、「AIネイティブな開発者とAIネイティブなアプリケーションのために設計された、新しいクラスのコンピュータが登場するのは当然の流れだ」と述べています。

https://nvidianews.nvidia.com/news/nvidia-launches-ai-first-dgx-personal-computing-systems-with-global-computer-makers

DGX Sparkは、まさにこのビジョンを具現化する製品として位置付けられています。これは単に高性能なワークステーションというだけでなく、AIモデル開発の全サイクル、すなわちプロトタイピングからファインチューニング、そして推論に至るまで、そのすべてを開発者のデスクトップ上で完結させることを目指した、全く新しいカテゴリーのコンピュータと言えるでしょう 。

これまでデータセンターでしか利用できなかったような最先端のAIアーキテクチャを、個人の手の届く範囲にまで引き下げるというNVIDIAの戦略は注目に値します。これは単にハードウェアを販売するというだけでなく、Grace Blackwellプラットフォームを中心とした広範なエコシステムを、開発者のデスクトップレベルから育成しようという意図の表れと考えられます。DGXシステムは従来、データセンターAI市場で圧倒的な存在感を示してきました。その最新かつ最も強力なアーキテクチャであるBlackwellをデスクトップという「パーソナル」な形態で提供することにより、開発者や研究者がこの新アーキテクチャに触れるための障壁は大きく下がります。

つまり、開発者はローカル環境でGrace Blackwell向けの開発や最適化を行い、その後シームレスにNVIDIA DGX Cloudや大規模なオンプレミスシステムへとスケールアップすることが可能になる。つまり、DGX SparkはNVIDIAの次世代AIエコシステムへの重要な導入ツールとして機能し、草の根レベルからの習熟と採用を促進する役割を担っているのです。

これは、既存のスパコンやデーターセンター、クラウドGPUのようなプレイヤーにとってグラウンドを揺さぶる戦略と言えなくもないです。なお興奮気味のインフルエンサーならここで"ゲームチェンジャー"と言ってしまいそうですが、AICUはそこまで気軽にゲームチェンジを口にしません。きちんと他のプレイヤーの動向もチェックしていきましょう。

DGX Sparkの心臓部:Grace Blackwell Superchipと注目のスペック

DGX Sparkの驚異的な性能は、その心臓部に搭載された革新的なテクノロジーによって実現されています。ここでは、その主要なコンポーネントとスペックを詳しく見ていきましょう。

NVIDIA GB10 Grace Blackwell Superchip:CPUとGPUの融合

DGX Sparkの頭脳となるのは、NVIDIA GB10 Grace Blackwell Superchipです。このスーパーチップは、ARMベースの高性能なNVIDIA Grace CPU(20コア構成:10コアのCortex-X925と10コアのCortex-A725)と、最新のNVIDIA Blackwellアーキテクチャを採用したGPUを、NVIDIA NVLink-C2Cという高速インターコネクト技術で接続しています。特筆すべきは、これによりCPUとGPUがメモリ空間を共有する「コヒーレントなメモリモデル」、つまりGPUとGPUでのメモリ一貫性が実現されている点です。

搭載されるBlackwell GPUは、スペック上では6144基のBlackwell世代CUDAコア、第5世代Tensorコア、そして第4世代RTコアを備え、FP4(4ビット浮動小数点)演算において最大1000 TOPS(Tera Operations Per Second)という圧倒的なAI処理性能を有しています。

このユニファイドメモリアーキテクチャ、つまりCPUとGPUがNVLink-C2Cを介して単一のメモリプールを共有する仕組み)は、従来のPCアーキテクチャからの大きな飛躍と言えます。従来のシステムでは、データはシステムRAMとGPU VRAM間をPCIe経由でコピーする必要があり、これがAIワークロードにおけるボトルネックとなることがありました。これはWindows以前のPCやPlayStation2の頃からVGI、ビデオグラフィックスインターフェイスとして、補助演算装置だったグラフィックスプロセッサがずっと抱えてきたアーキテクチャーです。GPUとCPUにはそれぞれ得意な演算がありますが、その行き来のために、わざわざメモリバスを止めたり、キャッシュを止めたり、メモリの交通整理をしなければならなかったのです。

DGX Sparkでは、このデータ移動のオーバーヘッドが最小限に抑えられるはずです。例えば、画像生成やAI推論におけるプロンプトのフォーマット、トークン処理、ビデオなどのマルチモーダルなデータパイプラインといった"メモリに載っていて欲しい"メモリ集約型のタスクは、完全にこの共有メモリ空間内で実行できるとされており、CPUとGPU間で頻繁なデータ交換が発生するAIワークロード(データ前処理や複雑なパイプラインステージなど)において、レイテンシの大幅な削減と効率の向上が期待できます。

画像生成AIにおいては動画生成のために複数のモデルをVRAMに載せたり、フレーム一貫性のための前後の動きを予測したり、もしくはリアルタイムにカメラや動画の内部にある対象物を認識させたり反応させたり・・・といった別次元のエクスペリエンスをこの手のひらサイズの小型のスーパーコンピューターで作り出すことができる可能性があります。

128GBのユニファイドメモリ:大容量とアクセス性

DGX Sparkは、128GBという大容量のLPDDR5Xユニファイドシステムメモリを搭載しています。この広大なメモリ空間により、ローカル環境でありながら、最大2000億パラメータを持つような超巨大AIモデルの推論処理や、最大700億パラメータのモデルのファインチューニングが可能になります。これは、従来のデスクトップ環境では考えられなかったスケールのAI開発を現実のものとします。

ちなみに700億パラメータというとLLMだとイライザの2024年に公開されたサイズがそれぐらいです。

https://elyza.ai/lp/elyza-llm-for-jp

メモリ帯域幅については、273 GB/sとされています。この128GBという容量は確かに目を見張るものがあり、非常に大きなモデルをローカルで扱えるようになる点は大きなメリットです。しかし、特に画像生成のようなパフォーマンス重視のタスクにおいては、メモリ帯域幅が重要な要素となります。この273 GB/sという数値は、例えばNVIDIA GeForce RTX 4090(約1008 GB/s)のようなハイエンドディスクリートGPUと比較すると、かなり低い値です。画像生成の速度(例:1秒あたりのイテレーション数やトークン数)は、GPUがどれだけ速くモデルの重みや中間データをメモリから読み書きできるかに大きく左右されます。RTX 4090のようなハイエンドコンシューマGPUはGDDR6Xという高速な専用グラフィックスメモリを使用しており、次世代のRTX 5090ではさらに高速なGDDR7が採用されています。DGX Sparkが採用するLPDDR5Xは、電力効率に優れ、大容量のユニファイドシステムを実現できる一方で、専用グラフィックスメモリと比較すると帯域幅で劣ります。したがって、DGX Sparkはより大きなモデルを「搭載」できる一方で、メモリ帯域幅に大きく依存するタスクの「処理速度」においては、専用の広帯域VRAMを持つシステムに比べて遅くなる可能性があるという、容量と速度のトレードオフが存在することを理解しておく必要があります。

https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

FP4 AI性能と第2世代Transformer Engine

NVIDIA Blackwellアーキテクチャのもう一つの重要な特徴は、新しいFP4(4ビット浮動小数点)データフォーマットをサポートする第2世代Transformer Engineを搭載している点です。この新しいエンジンは、推論およびトレーニング処理の性能と効率を大幅に向上させ、特に大規模なMoE(Mixture-of-Experts:混合エキスパート)モデルの処理を高速化するように設計されています。

FP4は、BF16(16ビット浮動小数点)やFP8(8ビット浮動小数点)といった既存の低精度フォーマットと比較して、メモリ消費のさらなる削減、メモリ帯域幅消費の低減、そしてスループットの向上といった多くの利点をもたらします。NVIDIAは、FP4の導入により、精度を維持しつつ、モデルサイズとスループットを実質的に倍増させることができると主張しています。

FP4のサポートは、Blackwellアーキテクチャにおける重要な進歩であり、DGX Sparkはその恩恵を開発者がいち早く享受できるプラットフォームの一つとなります。画像生成の分野においては、もしモデルを品質の大きな低下なしにFP4へ効果的に量子化できれば(NVIDIAはQAT(Quantization Aware Training)のような技術でこれが可能であると示唆しています。

より高速な推論や、128GBのメモリ内でさらに大規模または複雑なモデルを実行できるようになる可能性があります。生成AIモデル、特に画像生成モデルはますます大規模化・複雑化しています。FP8、そして今回のFP4のような低精度フォーマットは、これらのモデルをより少ないメモリで、かつ潜在的に高速に実行することを可能にします。

Blackwellの第5世代Tensorコアと第2世代Transformer Engineは、まさにこのFP4を活用するために設計されています。NVIDIAの研究によれば、FP4は大幅な高速化に貢献します。例えば、Black Forest LabsのFLUX Transformerモデルの全結合層においてFP8比で最大3.1倍を実現し、実効的なモデルサイズ容量を倍増させることができるとされています。したがって、DGX Sparkのユーザー、特にFLUXのような最先端の画像モデルを扱う開発者は、FP4を活用して性能と能力を向上させる最前線に立つことになるかもしれません。ただし、これはソフトウェアエコシステム(TensorRTやモデルフレームワーク)がFP4を完全にサポートし、かつ画質が維持されることが前提となります。

https://developer.nvidia.com/blog/nvidia-tensorrt-unlocks-fp4-image-generation-for-nvidia-blackwell-geforce-rtx-50-series-gpus/

現在でもTensorRT Diffusionなどは公開されています。demoDiffusion は NVIDIA H100, A100, L40, T4, and RTX4090 GPU以降で試されて、オープンソースとしてたくさんのスターやフォークがついていますが、普及にはまだまだ時間がかるでしょう。

実際、どんなハードウェアになるの?

DGX Sparkは、その名が示す通り、デスクトップに馴染むコンパクトなサイズで提供されることが確実になりました。この「パーソナルAIスーパーコンピュータ」は、Acer、ASUS、Dell Technologies、GIGABYTE、HP、Lenovo、MSI、NTTPCといった世界各国のシステムメーカーから提供されることが2025年5月18日に発表されました。今後、幅広いユーザー層への普及が期待されます。

ストレージとしては、1TBまたは4TBのNVMe M.2 SSDが搭載され、高速なデータアクセスを実現します。ネットワーク機能も充実しており、標準的な10GbEの有線LANポートに加え、特筆すべきはNVIDIA ConnectX-7 SmartNIC (200GbE) の搭載です。これにより、2台のDGX Sparkを直接接続してクラスタリングし、さらに大規模なAIモデルの処理に対応することが可能になります。その他、最新のWi-Fi 7、Bluetooth 5.3、そして最大40Gb/sの転送速度を誇るUSB4 Type-Cポートなどもサポートされ、現代的な開発環境に必要な接続性を網羅しています。

1台のDGX Sparkで最大2000億パラメータのモデルを扱えますが、一部の最先端モデルはこのサイズを超える可能性があります。ここでConnectX-7 NICが活きてきます。2台のDGX Sparkを連携させることで、利用可能なメモリと計算能力を実質的に倍増させ、最大4050億パラメータのモデルに対応できるようになる可能性があります。このような小規模ながらもスケーラブルなクラスタリング能力は、DGX Sparkを単なる高性能コンシューマハードウェアとは一線を画す存在とし、プロフェッショナルなAI開発ニーズに応えるものとしています。このクラスタリング機能は、全ての個人ユーザーが必要とするものではないかもしれませんが、デスクトップ上でモデルサイズの限界を押し広げようとする開発者にとっては重要な特徴と言えるでしょう。

他のコンペチターは?

この分野で、NVIDIAにとっての最大のコンペチターはAppleでしょうか。

例えばAppleからは M4 MacBook Pro(128GB)、M3/M4 Mac Studio(512GB)といったハードウェアが先行してリリースされています。OSやアプリケーション環境についての情報も整理してみましょう。

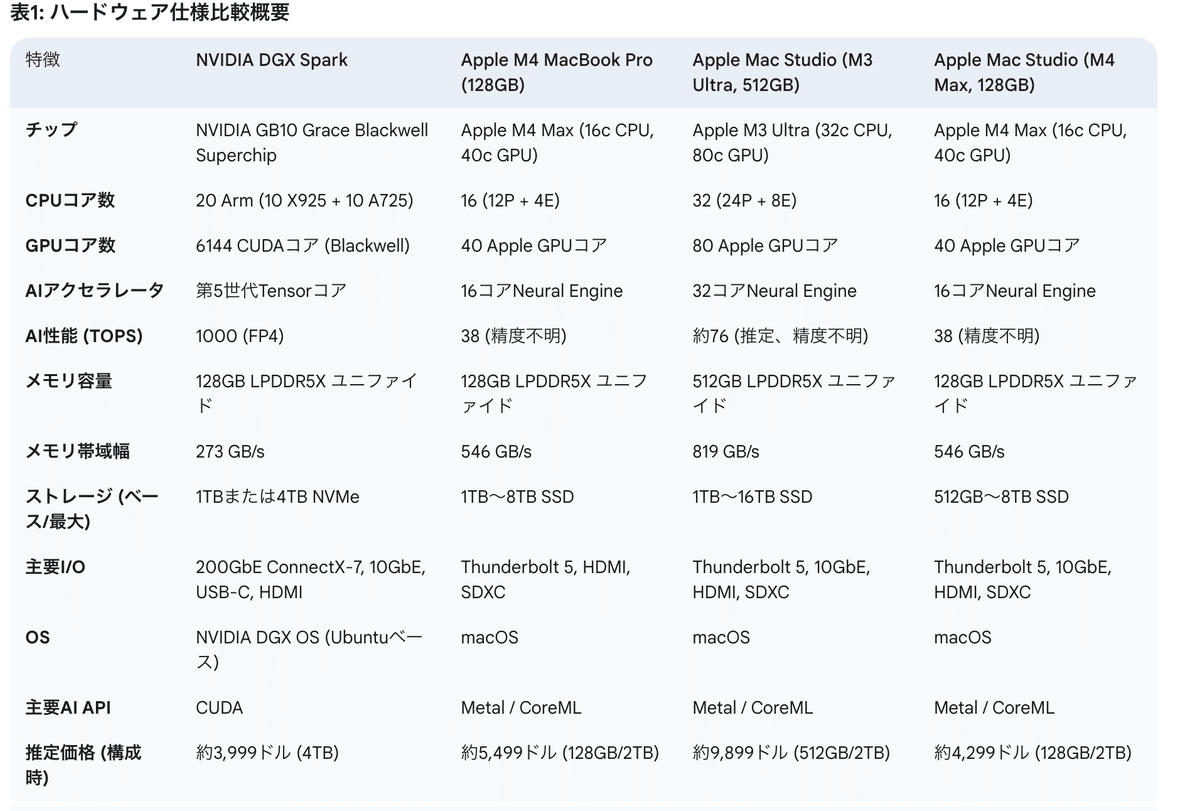

この表は、各システムの基本的なハードウェアおよびソフトウェア特性を直接的かつ一覧で比較したものです。計算能力、メモリ、価格設定における主要な違いで、AICUの読者が期待する画像生成AIの潜在能力を理解するためのベースとなります。AI性能指標(TOPS)、メモリ帯域幅、主要AI APIを含めています。

DGX Sparkは価格において最強です。価格価値はハイエンドになるにつれて「ドルあたりの速度」から「ドルあたりの能力」へとシフトすることが予想されます。DGX SparkとM4 Max Studioについては、一般的な画像生成タスクにおける従来の「ドルあたりの速度」比較が適切でしょう。旧来のDGX Station A100 では160GBで$99,000、320Gが $149,000という価格レンジでした。512GB RAMを搭載したM3 Ultra Mac Studioの場合、その主な価値は既存のタスクをより速く実行することだけではなく、他のシステムではメモリ制限のために処理できない巨大なモデルや極めて複雑なワークフローをローカルで実行するという、全く新しい「能力」を実現することに価値が求められるでしょう 。例えば、400GBの動画生成モデルやAITuberを会話スクリプトから音声合成までをローカルで実行する必要がある動画スタジオやAITuber開発者などのユーザーにとって、これらのシステムの中ではM3 Ultra Studio以外に選択肢はないでしょう。このシナリオでは、小規模なSDXLモデルに対する「ドルあたりの速度」は安価なNVIDIA GPUに劣るかもしれませんが、その「ドルあたりの能力」は高いと言えます。DGX Sparkの価値は、現在の価格帯におけるAI特化アーキテクチャとエコシステムアクセスに結びついている一方で、このMac Studioや特殊用途のPC-GWS、スパコンのみが許された分野を揺さぶりにかかっていると言えます。

以上、リアルタイムグラフィックス業界で30年の経験を持つAIDX Labのリサーチャー白井博士 X@o_ob がお送りしました。

この話題、機会があればまた扱いたいと思います。

いいね、シェア、X@AICUaiのフォローをよろしくお願いいたします!

https://note.com/o_ob/n/n442cf50ada59

Originally published at note.com/aicu on May 19, 2025.

Comments