画像生成AI・動画生成AIのオープンスタンダード「ComfyUI」が使える環境を さくらインターネットのサーバーで構築してみよう

さくらインターネットの H100のおかげで

— AICU - つくる人をつくる (@AICUai) September 19, 2025

めちゃ速い ComfyUIができたよ〜#さくらインターネット #高火力VRT #H100 pic.twitter.com/1LZ3hg28TJ

さくらインターネットの高火力VRT(=GPUを使えるVM)を使って、世界の画像生成・動画生成でのオープンなスタンダードになりつつあるGUIツール「ComfyUI」で動画生成ができる環境を構築してみました。GPUはさくらの高火力VRTで利用できるV100、そしてH100。メモリ56GBそしてVRAMが32GBといったサーバー環境で、オープンなAIモデル「Wan2.2」での動画生成を中心に構築してみます。本稿ではSSH接続からドライバ、PyTorch、ComfyUIの導入までの手順をまとめます。ComfyUIのセットアップや操作についてはAICUのほか記事をご参照ください。

https://j.aicu.ai/comfysb

検証に使用した環境

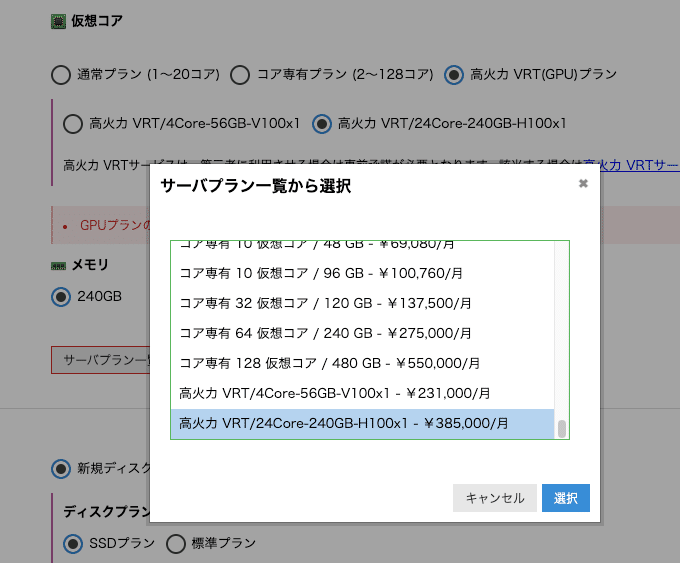

さくらの高火力VRT V100

-

CPU: 4コア

-

RAM: 56GB

-

GPU: NVIDIA Tesla V100 (32GB)

-

Disk: 250GB

-

OS: Ubuntu 24.04LTS

さくらの高火力VRT H100

-

CPU: 24コア

-

RAM: 240 GB

-

GPU: NVIDIA H100 SXM 80GB x1

-

Disk: 500GB

-

OS: Ubuntu 24.04LTS

https://www.sakura.ad.jp/corporate/information/newsreleases/2025/07/31/1968220368/

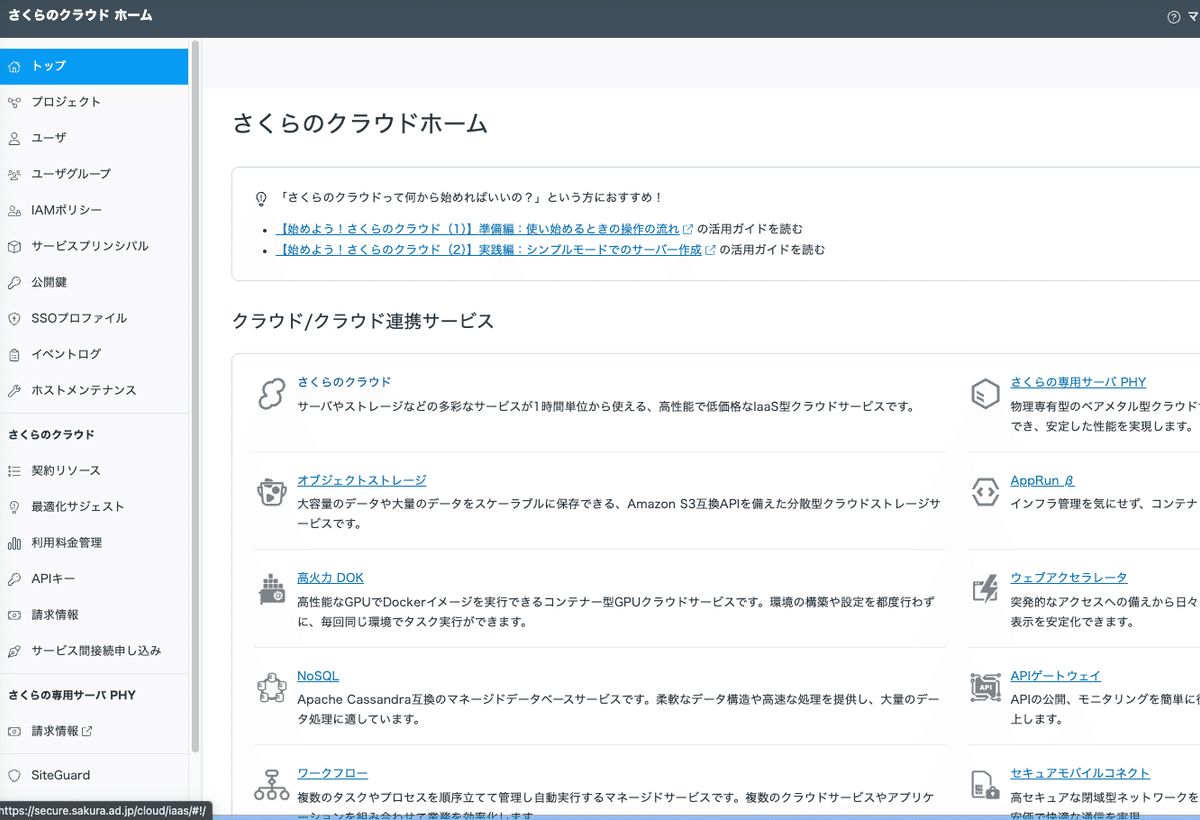

1. 「さくらのクラウド」ホームからの設定

IDを作成したら、プロジェクトを作成します。課金単位は「プロジェクト」ごとになり、GPUインスタンスは各プロジェクトで1件になります。

まずは「さくらのクラウド」を選びます。これは意外と忘れやすい。

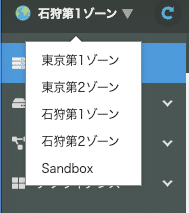

ゾーンは「石狩第1」を選びます。

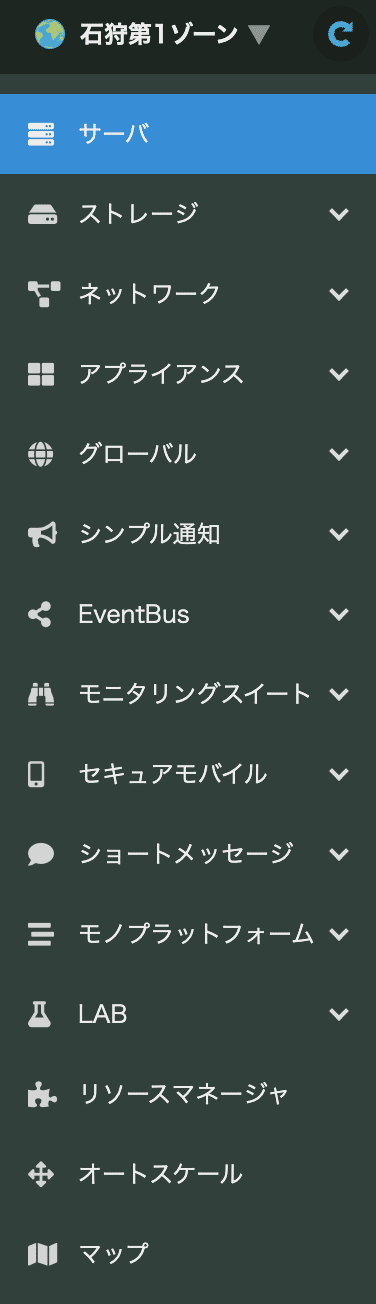

左側メニューはこんな感じなります。

「サーバー」の右上で「追加」

サーバープランが選べます。下の方に行くと、V100かH100のいずれかが選べます。

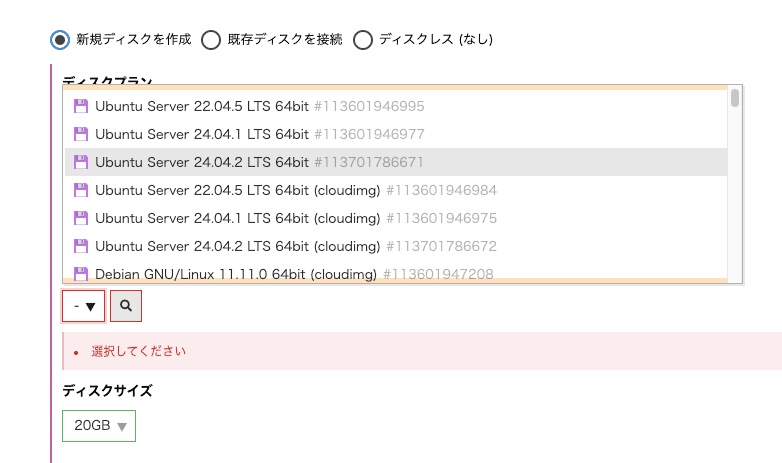

Ubuntu Server 24.04.2 LTSを選びます。

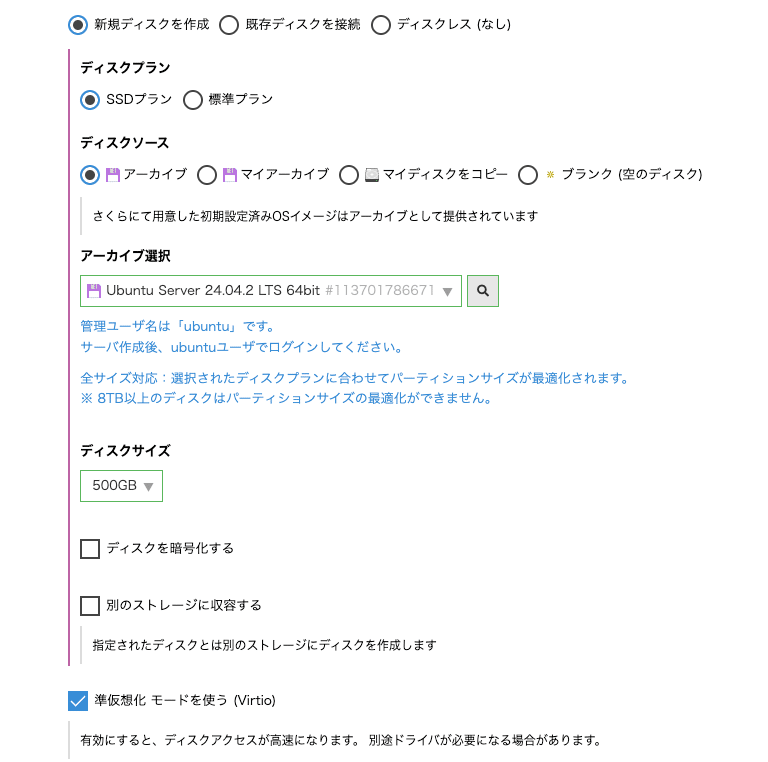

ディスクサイズは静止画なら200GB以上、動画生成なら500GB以上は確保したいところですが、ご予算次第です。

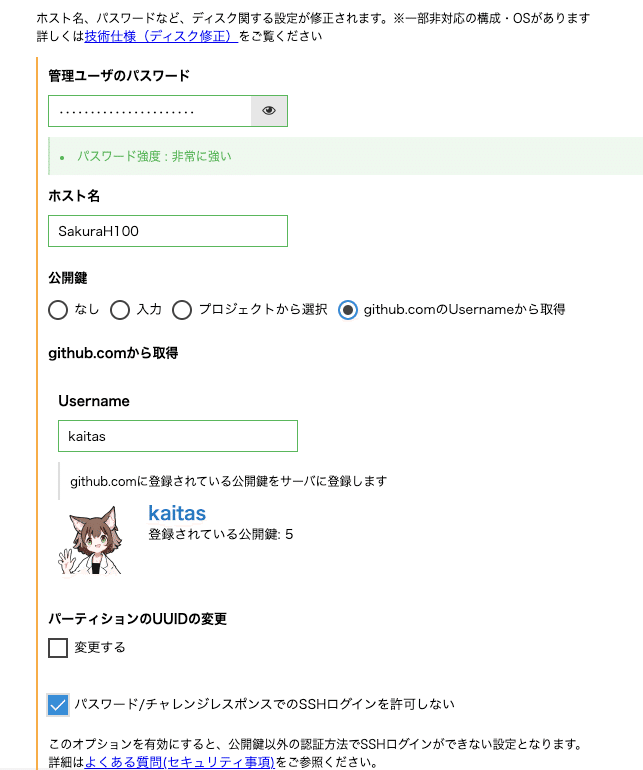

続いて管理ユーザーのパスワードです。パスワードはSSHでログインしつつもsudoで使用しますので、高難度にしすぎると後で大変です。ここではenpassを使って生成しました。

公開鍵をGitHubから取得します。管理者のユーザー名を使って取得できます。

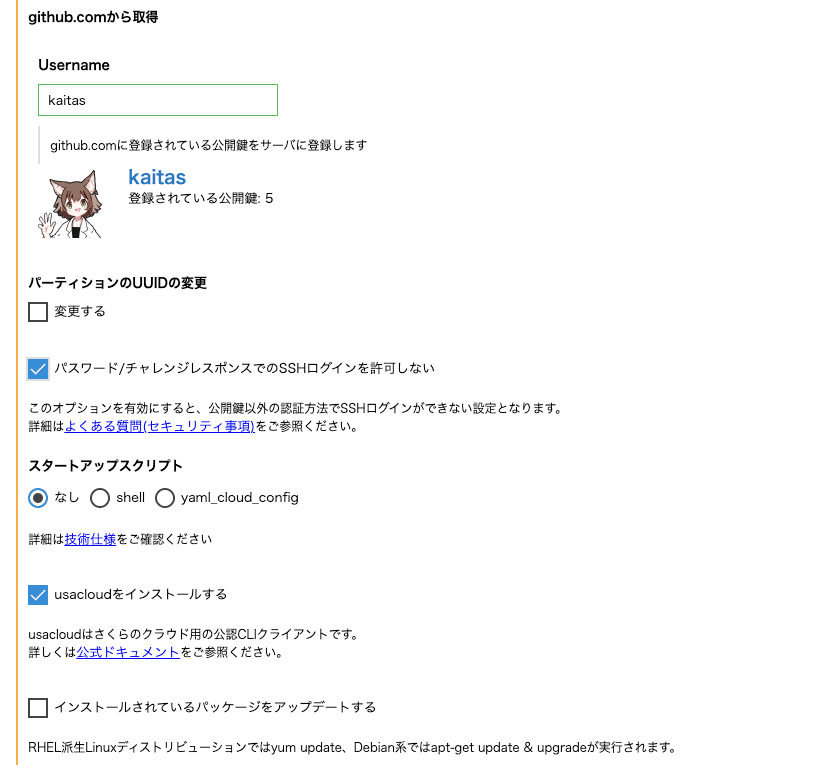

「パスワード/チャレンジレスポンスでのSSHログインを許可しない」は自信がない時はOFF、つまり「許可する」にしておいてもいいです。これを失敗すると、SSHで入れなくなると、サーバーを作り直すことになります。

usacloudについては別の機会に紹介します。

さくらインターネットをコマンドライン(CLI)で利用するツールです。

https://docs.usacloud.jp/usacloud/

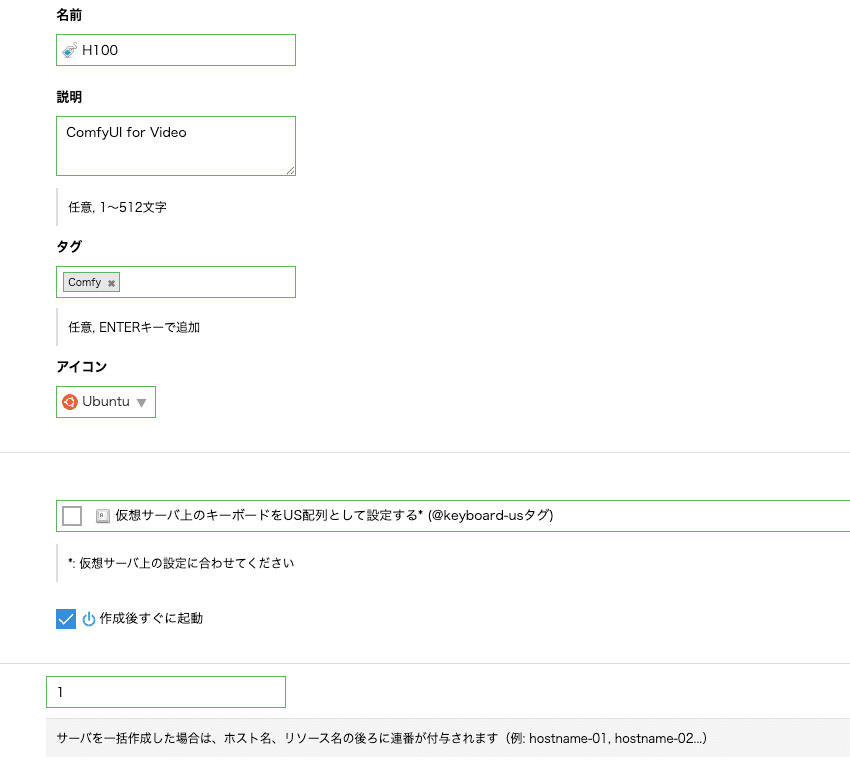

サーバー名、タグについては簡単で。

キーボードはUSキーボードを使っている場合はチェックONしておきましょう。

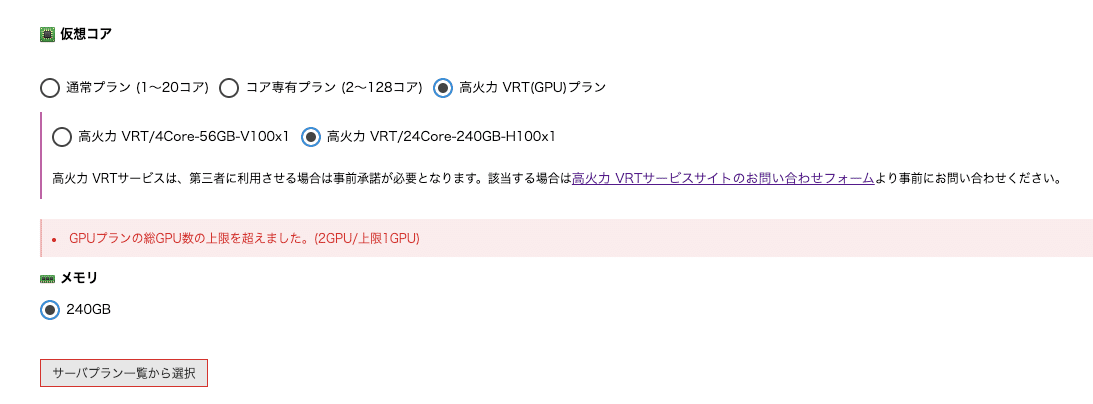

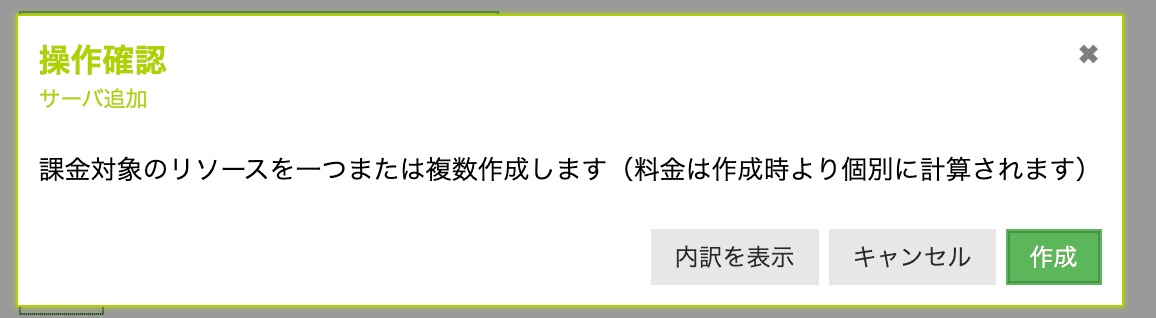

いざここで作成!なのですが、

「GPUプランの上限を超えました」というエラーが出ることがあります。

リソース上限変更依頼が必要です。前もってメールを送りましょう。

宛先 support@sakura.ad.jp

件名 さくらのクラウド リソース上限変更依頼

本文・会員ID:

・会員名(法人・契約者名):

・プロジェクト名: 会員IDに続いて

・利用ゾーン:石狩第1

・項目:GPU

※ディスク数上限の引き上げをご希望の場合は、標準プラン/SSDプラン/大容量プラン(2TB以上のディスク)

それぞれのご利用見込み容量もご記入ください。

例: 標準プラン 10TB, SSDプラン 5TB, 大容量プラン 0

・変更後の値:(100・200などご希望の上限値)

・利用用途:(背景/用途)

・消費ペース:(○ヶ月で△くらい使用する見込み)※6ヶ月以内での消費ペースをご記入ください

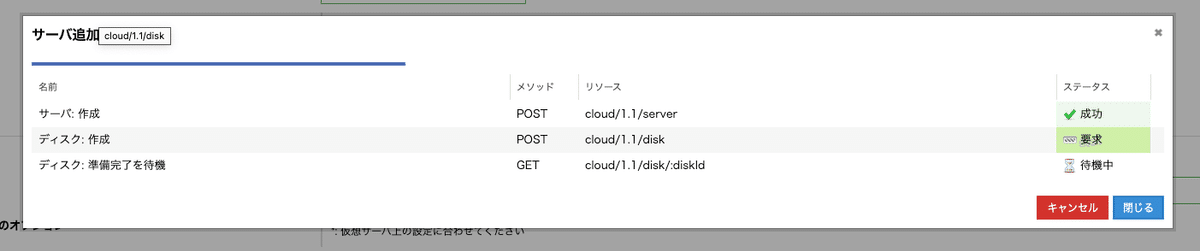

無事にサーバー構築が始まるとこんな感じになります。

できあがったらお手持ちのSSHからログインしてみます。

サーバーにログイン

ssh ubuntu@IPアドレスです。設定が終わっていれば、ED25519 key fingerprintが表示され、

Are you sure you wan to continue connecting (yes/no/[fingerprint])?と表示されます。

これでEnterキーを押すと「fingerprint」で入ろうとしますが、GitHubに鍵が登録されている場合、つまり鍵を作成されている人は [yes]で入ります。

公開鍵をGitHubに登録していない人は登録しましょう。

以下のコマンドを叩き公開鍵の中身を表示して全文コピーします。

cat ~/.ssh/id_rsa.pub

GitHubの「Settings > SSH and GPG keys」で追加します。

「New SSH key」と進み、先ほどコピーした公開鍵を登録します。

Titleはわかりやすい名前であればなんでも大丈夫です。

.sshディレクトリのパーミッションを変更しておきます。

chmod 700 ~/.ssh/

chmod 600 ~/.ssh/id_rsa

「入力」公開鍵を選んで、現在使っているshellの「.ssh/id_rsa.pub」の中身を貼り付けます。

詳しくはさくらインターネットの公式サポート情報をどうぞ!

https://help.sakura.ad.jp/rs/2247/

https://docs.github.com/ja/authentication/connecting-to-github-with-ssh/testing-your-ssh-connection

~/.ssh/config を作成して簡略化ログイン

SSHを使ってログインできる環境ができると、ログインも簡単になります。

~/.ssh/config というファイルにこんなふうに書いてあげてください。

Host github.com

HostName github.com

IdentityFile ~/.ssh/id_rsa

User gitさらにAICU AIDX Labの場合は、2台管理しているさくらインターネットのGPUサーバーを以下のように登録していきます。

# ~/.ssh/config

Host v100

HostName XXX.XXX.XXX.XXX

User ubuntu

IdentifyFile ~/.ssh/id_rsa

Host h100

HostName XXX.XXX.XXX.XXX

User ubuntu

IdentifyFile ~/.ssh/id_rsa

これで ssh h100 とすればログインできるようになります。パスワードは不要です!

2. NVIDIAドライバ導入

次にGPUドライバのインストールを行っていきます。

その前に、sudoでのパスワードを打つのが大変なので、

sudo vi /etc/sudoers.d/ubuntu

に

ubuntu ALL=NOPASSWD: ALL

と書くと、ユーザー「ubuntu」がパスワードなしでsudoできるようになります。

まずはドライバー選択

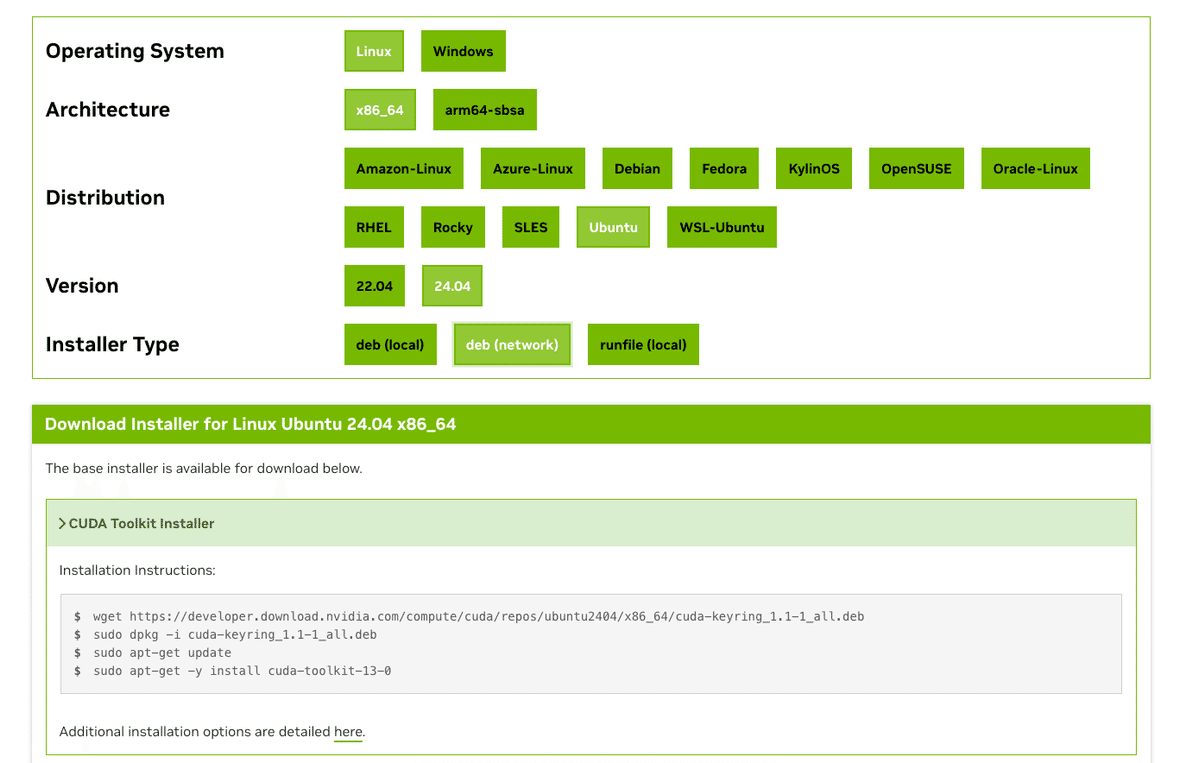

https://developer.nvidia.com に行ってLinux, x86_64, Ubuntu, 24_04, debを選びましょう。

https://developer.nvidia.com/cuda-downloads?target_os=Linux&target_arch=x86_64

下の方に「CUDA Toolkit Installer」の手順が表示されますので従っていきます。

https://developer.nvidia.com/cuda-downloads?target_os=Linux&target_arch=x86_64&Distribution=Ubuntu&target_version=24.04&target_type=deb_network

ダウンロードして、管理者権限で、キーリングをインストールして、apt-getで cuda-toolkit-13.0をインストールしています。

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2404/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install cuda-toolkit-13-0続いてドライバー本体をインストールします。

実はここに2つの選択肢があります。

sudo apt-get install -y nvidia-open

sudo apt-get install -y cuda-drivers

上がオープンソース版のドライバー、下が旧来のプロプライエタリー版、つまりNVIDIAが製品として管理してきたバージョンがあります。いろいろなトラブルも多いのですが、せっかくLinux版ですのでここはオープン版を選びます。

Ubuntu 22.04 の場合はこんな感じです。いろいろやってみたのですが、古いUbuntuにはそれなりに手間もあるので、今であればUbuntu 24.04LTSを使うでいいかなと思いました。

sudo apt update && sudo apt install -y gcc gnupg

sudo dpkg -i nvidia-driver-local-repo-ubuntu2204-515.48.07_1.0-1_amd64.deb

sudo cp /var/nvidia-driver-local-repo-*/nvidia-driver-local-*-keyring.gpg /usr/share/keyrings/

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.0-1_all.deb

sudo dpkg -i cuda-keyring_1.0-1_all.deb

sudo apt update

sudo apt install -y nvidia-driver-515

sudo rebootドライバーの確認です。

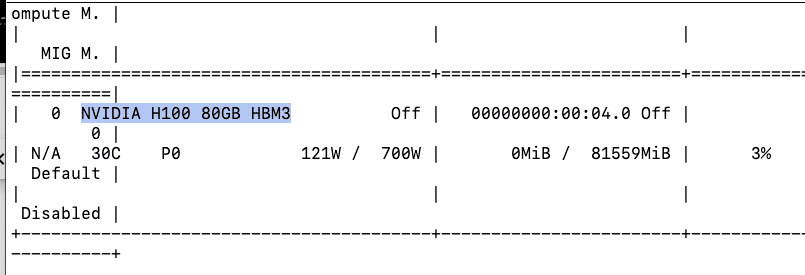

nvidia-smi

やったぜ!H100, VRAM 80GBです。HBM3とは High Bandwidth Memory 3、メモリチップを縦方向に積層する3D設計を採用した次世代メモリ規格で、特にAI、ハイパフォーマンスコンピューティング(HPC)、データセンター向けに設計されています。従来のDRAM技術と比較して帯域幅と容量が大幅に向上しており、1ピンあたりの速度、総帯域幅、消費電力効率を向上させています。

3. Python環境とPyTorch

仮想環境を作成し、PyTorchをGPU対応でインストールしていきます。

sudo apt install -y python3-venv python3-full

python3 -m venv ~/venv-comfyui

source ~/venv-comfyui/bin/activate

pip install --upgrade pip

pip install "numpy<2.0.0"

pip install torch==2.2.2+cu118 torchvision==0.17.2+cu118 torchaudio==2.2.2 \

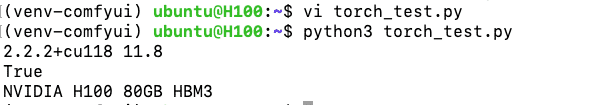

--extra-index-url https://download.pytorch.org/whl/cu118動作確認として、torchのコードで確認です。torch_test.py を作ってみます。

import torch

print(torch.__version__, torch.version.cuda)

print(torch.cuda.is_available())

print(torch.cuda.get_device_name(0))

python3で NVIDIA H100 80GB HBM3が使えることが確認できました!

4. ComfyUI導入

さていよいよComfyUIを導入していきます。ComfyUIのインストールはソースから入れます。

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

pip install -r requirements.txtモデルは動作確認なので SD1.5とVAEのみインストールします。

mkdir -p models/checkpoints models/vae

wget -c https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned-emaonly.ckpt -P ./models/checkpoints/

wget -c https://huggingface.co/stabilityai/sd-vae-ft-mse-original/resolve/main/vae-ft-mse-840000-ema-pruned.safetensors -P ./models/vae/5. 動作確認

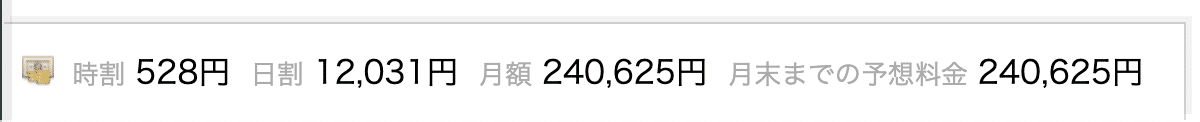

ここから先は、インターネットへの公開になります。非常に注意が必要なので知識や責任、予算がない方が迂闊に公開することは後悔することになるのでお勧め致しません。本来は認証、ファイヤーウォールの設定などを行うべきですが、ここは動作試験のみを行います。もし設定を間違えた場合の費用規模感としてはこんな感じでかかりますので覚悟しましょう。

ネットワークの設定は不安…ちょっと遊んでみたいな、という人はぜひ、AICUのサービス「AICU Lab+」でお試しください(宣伝)。

業務的なサーバー構築の案件も歓迎です。

UFW(Uncomplicated Firewall)の設定

ufwはUbuntu標準の簡易ファイアウォールです。内部ではiptables/nftablesを使いますが、コマンドがシンプルなので動作確認に向いています。

sudo ufw allow 22/tcp

sudo ufw allow 8188/tcp

sudo ufw enable

既存プロセス停止

pkill -f "python3 main.py" || true

0.0.0.0 で起動(外部から受ける)

source ~/venv-comfyui/bin/activate

cd ~/ComfyUI

nohup python3 main.py --listen 0.0.0.0 --port 8188 --multi-user --dont-print-server \

> ~/comfyui.log 2>&1 &サーバ内から疎通確認

curl -sI http://127.0.0.1:8188 | head -n1 # 200 OK想定

curl -sI http://133.242.17.83:8188 | head -n1 # これも 200 OK なら外部公開OK

sudo ufw status verbose

これで http://(IP address):8188 に入れるはずです。

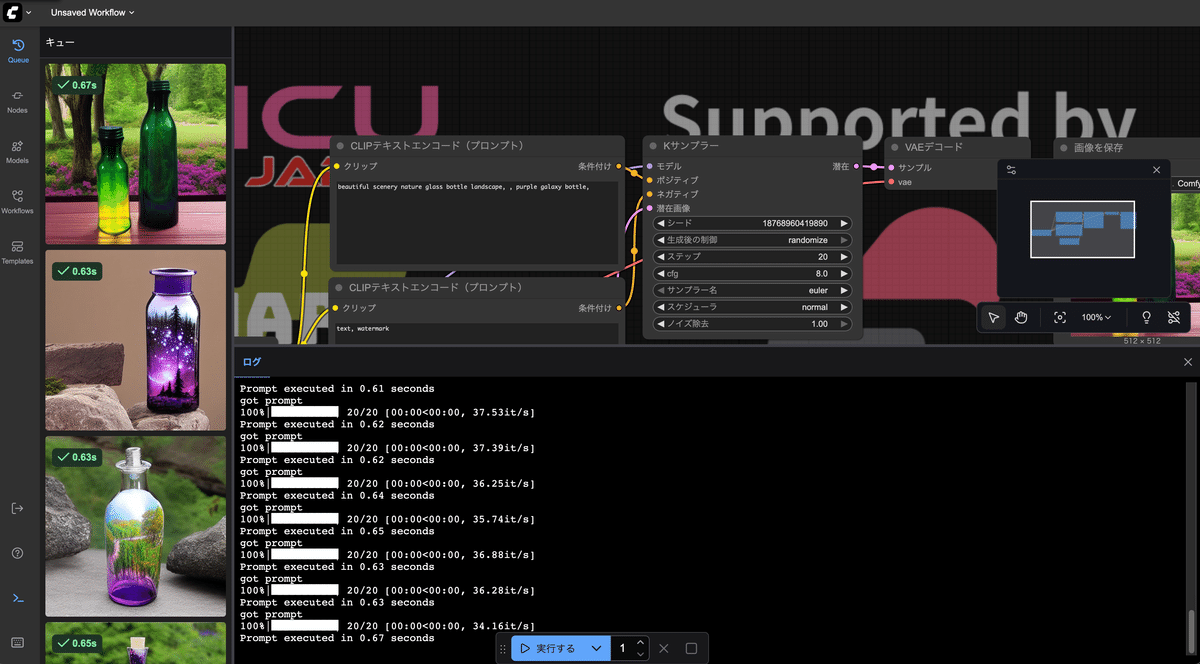

秒速 37イテレーション、プロンプトあたりの実行速度が 0.63秒という速度です。これは速い!!

TryCloudflareでの実験

次にGoogle Colabと同様にCloudFlareのVPNを使って動作測定をしてみました。

# 1) ComfyUI をローカル束縛で起動(マルチユーザーONの例)

source ~/venv-comfyui/bin/activate

cd ~/ComfyUI

nohup python3 main.py --listen 127.0.0.1 --port 8188 --multi-user --dont-print-server \

> ~/comfyui.log 2>&1 &

# 2) ローカルで本当に立ってるか確認(ここがOKならトンネルに乗る)

until nc -z 127.0.0.1 8188; do sleep 0.5; done

curl -sI http://127.0.0.1:8188 | head -n1 # HTTP/1.1 200 OK 等が返る想定

# 3) 一時URLで外部公開(trycloudflare)

cloudflared tunnel --url http://127.0.0.1:8188

# → 出力に *.trycloudflare.com のURLが出る

こちらも秒速 37イテレーション、プロンプトあたりの実行速度が 0.63秒!

https://x.com/AICUai/status/1969081244991230166

さくらインターネットの H100のおかげで

— AICU - つくる人をつくる (@AICUai) September 19, 2025

めちゃ速い ComfyUIができたよ〜#さくらインターネット #高火力VRT #H100 pic.twitter.com/1LZ3hg28TJ

特にVPNを設定しても速度低下につながるというわけではなさそうなので、直接IPアドレスを公開する形のアクセスはやめた方がいいでしょう。

おつかれさまでした!この手順で、GPUサーバーが爆速のComfyUIクラウドサービスになります。

まとめ

-

さくらの高火力VRTなら、GPU (V100/H100) を使ってComfyUIを高速動作させられる

この手順で、安定したComfyUI環境を簡単に再現できます。

今回の記事では動作確認に留めましたが、実際には映画産業向けのComfyUIサーバーとして、Slack通知、systemd常駐化、VPN化、認証や運用向けを行っています。

本記事は さくらインターネットのご協力でお送りしています!

おしらせ

現在、2026年度のAICU mediaパートナープログラムを募集しています。

—

この記事の続きはこちらから https://note.com/aicu/n/n2e1ee0c65fab

Originally published at note.com/aicu on Sep 19, 2025.

Comments